Страница 1: Тест и обзор: NVIDIA GeForce GTX Titan в 3-way SLI (обновление: тесты Crysis 3)

Титаны - боги второго поколения в древнегреческой мифологии. Их часто описывают как гигантов в теле человека, которые правили на протяжении легендарного золотого века. NVIDIA выбрала "Titan" в качестве названия новейшего поколения настольных видеокарт. GeForce GTX Titan должны взойти на вершину современных GPU, NVIDIA разрабатывала новый чип без каких-либо компромиссов по цене и производительности. В греческой мифологии Титаны проиграли свою битву Олимпийцам, после чего их навеки сослали в подземный мир. В нашей статье мы попытаемся оценить, разделит ли GeForce GTX Titan судьбу с Титанами.

Титаны - боги второго поколения в древнегреческой мифологии. Их часто описывают как гигантов в теле человека, которые правили на протяжении легендарного золотого века. NVIDIA выбрала "Titan" в качестве названия новейшего поколения настольных видеокарт. GeForce GTX Titan должны взойти на вершину современных GPU, NVIDIA разрабатывала новый чип без каких-либо компромиссов по цене и производительности. В греческой мифологии Титаны проиграли свою битву Олимпийцам, после чего их навеки сослали в подземный мир. В нашей статье мы попытаемся оценить, разделит ли GeForce GTX Titan судьбу с Титанами.

Нам вновь пришлось разделить тест на две части, так как сегодня нам разрешено поделиться только технической информацией и фотографиями. Но уже сегодня мы можем обсудить все архитектурные детали. А публикацию результатов всех тестов нам придётся немного отложить. Но прежде чем мы перейдём к рассмотрению новинки, позвольте высказаться автору.

В середине мая минувшего года на конференции GTC 2012 NVIDIA впервые упомянула о разделении архитектуры "Kepler" на две области: настольные компьютеры (GK10x) и вычисления на GPU (GK11x). Слухи о втором, более крупном чипе появились ещё тогда, но первая информация поступила напрямую от CEO NVIDIA Джен-Хсун Хуанга, который назвал 7,1 млрд. транзисторов, 13 или 14 кластером SMX, 384-битный интерфейс памяти и 3x прирост производительности вычислений с двойной точностью по сравнению с "Fermi". Уже тогда NVIDIA говорила о положительной вероятности появления GK110 через несколько месяцев в виде продуктов GeForce. Но на весь процесс потребовалось явно больше времени, это касается и вычислительных карт Tesla.

Всё изменилось в ноябре 2012 года, когда вычислительные карты Tesla K20 и K20X были официально объявлены. Их технические спецификации позволили представить, какими нам ждать настольные видеокарты GeForce. Конечно, оставались вопросы насчёт реальной производительности GPU в играх, поскольку на основе вычислительных тестов GPU её оценить всё же сложно. Но уже тогда стало понятно, что в грядущих GeForce мы получим 2688 потоковых процессоров CUDA и 6144 Мбайт видеопамяти, подключенной по 384-битному интерфейсу. Но по тактовым частотам выводы было делать рано, слишком уж разные сферы использования у Tesla и видеокарт GeForce.

Сегодня мы уже можем приоткрыть завесу тайны над видеокартой GeForce GTX Titan на основе GPU GK110.

Базовая информация об архитектуре

Сначала позвольте рассмотреть GPU GK110:

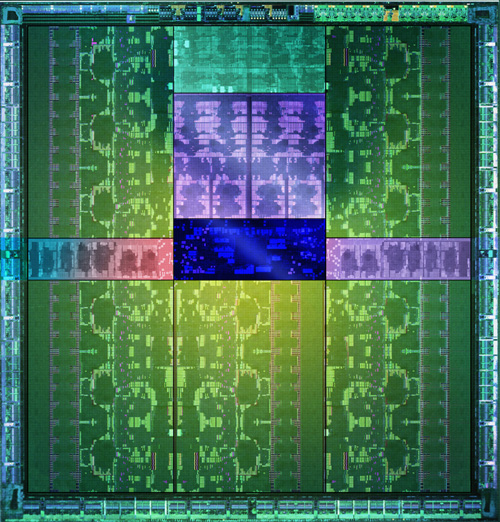

NVIDIA GK110 можно назвать одним из самых сложных и крупных чипов, производимых сегодня. В нём используется 7,1 млрд. транзисторов, даже при современном 28-нм производстве площадь кристалла составляет около 521 мм². Для сравнения, площадь кристалла IBM zEC12 составляет 597 мм² (32 нм), Intel Itanium "Poulson" - 544 мм² (32 нм). Впрочем, у чипа GT200 из семейства GeForce 200 площадь составляла 576 мм², что ещё больше, хотя тогда GPU изготавливался по 55-нм техпроцессу.

Число транзисторов у GPU GK110 побило прежний рекорд 5 миллиардов (62-ядерный Intel Xeon Phi). Впрочем, число транзисторов ещё не гарантирует соответствующей производительности. Из чего же состоит столь большой и сложный GPU?

Как и в случае любых GPU на основе архитектуры "Kepler", мы получаем несколько кластеров SMX, каждый из которых состоит из 192 потоковых процессоров CUDA. GPU видеокарты GeForce GTX Titan опирается на 14 кластеров SMX, которые вместе обеспечивают 2688 ядер CUDA. На внешних областях диаграммы GK110 можно заметить интерфейс PCI Express 3.0 и шесть контроллеров памяти, которые все вместе и составляют ширину шины памяти 384 бита. 14 кластеров SMX сгруппированы в пять групп - так называемых Graphics Processing Clusters. На диаграмме приведена полная версия GK110 с 15 кластерами SMX. Но у видеокарты GeForce GTX Titan, как и у GPU Tesla K20X, используется только 14 кластеров SMX.

Обе модели вычислительных карт Tesla на основе NVIDIA GK110 получили существенный прирост производительности вычислений с двойной точностью по сравнению с GK104, увеличение же производительности с одинарной точностью оказалось не таким большим, что можно объяснить смещением акцента с FP32 на FP64. Процессор NVIDIA GK110 впервые был полностью ориентирован на профессиональный рынок и высокопроизводительные вычисления HPC (High Performance Computing). Первое поколение "Kepler" в виде GPU GK104 на видеокартах GeForce GTX 680 как раз нацеливалось на роль настольного GPU GeForce, где решающее значение для рендеринга играет производительность с одинарной точностью. И соотношение производительности с двойной точностью к одинарной точности было снижено с 1/2 до 1/24. Наконец, у GK104 технологией ECC защищена только видеопамять, но не кэш. В любом случае, NVIDIA планирует с помощью GK110 утвердиться не только на профессиональном рынке, но и среди настольных игровых видеокарт с обновлённой линейкой GeForce.

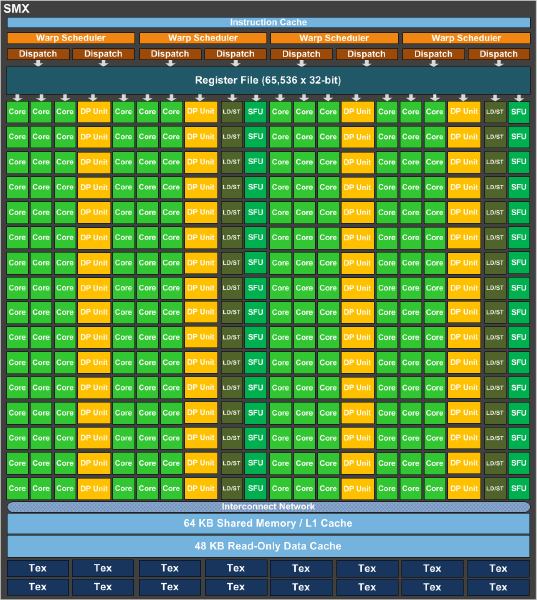

Для увеличения производительности вычислений с двойной точностью, NVIDIA установила 64 ядра с плавающей запятой на кластер SMX. У GK104 мы получали только восемь таких ядер на кластер. Вместе с увеличением числа кластеров, мы получили серьёзный прирост по производительности вычислений с двойной точностью. NVIDIA осталась приверженной своей скалярной архитектуре "Superscalar Dispatch Method", которая впервые появилась в GF104, в результате чего вычисления более устойчивы к ошибкам. К ней относятся параллелизм на уровне потоков Thread Level Parallelism (TLP) и на уровне инструкций Instruction Level Parallelism (ILP), а также целочисленная линейная оптимизация.

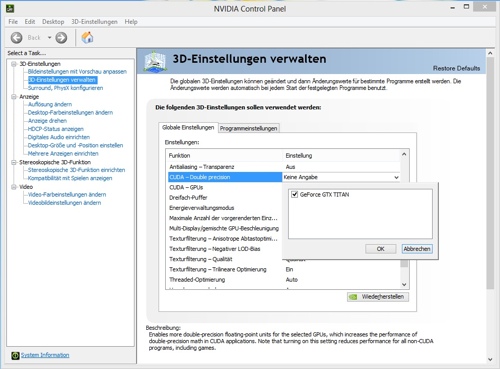

По умолчанию ядра CUDA с двойной точностью работают всего на 1/8 частоты. В панели управления NVIDIA в 3D-настройках есть пункт меню "CUDA - Double Precision". Если его активировать, то ядра CUDA с двойной точностью будут работать на более высокой тактовой частоте, но и тогда они всё равно не достигнут полной частоты 3D. Впрочем, данный пункт будет интересен только для тех пользователей, кто планирует запускать какие-либо научные приложения для расчёта на GPU, где требуется высокая производительность с двойной точностью. Геймерам на эту опцию вряд ли стоит обращать внимание, так как она снижает базовую частоту 3D.

Каждый кластер SMX также оснащён 64 кбайт кэша L1 и 48 кбайт кэша данных только для чтения. По сравнению с GK104, кэш L1 не был затронут, но кластеры GK110 получили 48 кбайт кэш только для чтения. На каждый кластер SMX остались 16 текстурных блоков, в результате чего GK110 предлагает максимум 240 текстурных блоков. Производительность вычислений с двойной точностью была увеличена и благодаря изменениям в регистрах. Число регистров на кластер SMX осталось идентичным - 65 536 по сравнению с GK104, но теперь поток может получать доступ к 255 регистрам в GK110 - против всего 63 в GK104.

Последствия подобных изменений на чистой вычислительной производительности видны хорошо. У GeForce GTX 680 мы получили производительность с одинарной точностью 3,09 TFLOPs. Производительность с двойной точностью была значительно ниже - 128 GFLOPs. У GeForce GTX Titan производительность с одинарной точностью возросла до 4,5 TFLOPs. Производительность с двойной точностью составляет 1,5 TFLOPs.

| NVIDIA GeForce GTX Titan | |

|---|---|

| Розничная цена | Н/Д |

| Сайт производителя | NVIDIA |

| Технические спецификации | |

| GPU | GK110 |

| Техпроцесс | 28 нм |

| Число транзисторов | 7,1 млрд. |

| Тактовая частота GPU (базовая частота) | 837 МГц |

| Тактовая частоат GPU (частота Boost) | 876 МГц |

| Частота памяти | 1502 МГц |

| Тип памяти | GDDR5 |

| Объём памяти | 6144 Мбайт |

| Ширина шины памяти | 384 бит |

| Пропускная способность памяти | 288,4 Гбайт/с |

| Версия DirectX | 11.0 |

| Потоковые процессоры | 2688 (1D) |

| Текстурные блоки | 224 |

| Конвейеры растровых операций (ROP) | 48 |

| Пиксельная скорость заполнения | 40,2 Гпиксль/с |

| SLI/CrossFire | SLI |

| TDP | 250 Вт |

GPU GK110 на видеокарте GeForce GTX Titan работает с базовой частотой 837 МГц для всех 2688 ядер CUDA. Технология GPU Boost, знакомая нам по GPU GK104, используется и у GeForce GTX Titan. Тактовая частота в режиме Boost составляет всего 876 МГц, так что NVIDIA подошла к частотам довольно консервативно. Всё же для GPU возможны частоты 1000 МГц и даже выше.

Память работает на привычной частоте 1502 МГц, но благодаря 384-битному интерфейсу пропускная способность составляет 288,4 Гбайт/с. В общей сложности мы получаем 6144 Мбайт памяти GDDR5. В данном случае NVIDIA закрывает "узкое место" видеокарты по сравнению с конкурентами AMD, которые часто оснащались большим объёмом памяти по сравнению с видеокартами NVIDIA.

Titan имеет TDP в 250 Ватт, повышенное высокое тепловыделение, в сравнении с GeForce GTX 680 (195 Вт), объясняется более сложной архитектурой GPU.