Титаны - боги второго поколения в древнегреческой мифологии. Их часто описывают как гигантов в теле человека, которые правили на протяжении легендарного золотого века. NVIDIA выбрала "Titan" в качестве названия новейшего поколения настольных видеокарт. GeForce GTX Titan должны взойти на вершину современных GPU, NVIDIA разрабатывала новый чип без каких-либо компромиссов по цене и производительности. В греческой мифологии Титаны проиграли свою битву Олимпийцам, после чего их навеки сослали в подземный мир. В нашей статье мы попытаемся оценить, разделит ли GeForce GTX Titan судьбу с Титанами.

Титаны - боги второго поколения в древнегреческой мифологии. Их часто описывают как гигантов в теле человека, которые правили на протяжении легендарного золотого века. NVIDIA выбрала "Titan" в качестве названия новейшего поколения настольных видеокарт. GeForce GTX Titan должны взойти на вершину современных GPU, NVIDIA разрабатывала новый чип без каких-либо компромиссов по цене и производительности. В греческой мифологии Титаны проиграли свою битву Олимпийцам, после чего их навеки сослали в подземный мир. В нашей статье мы попытаемся оценить, разделит ли GeForce GTX Titan судьбу с Титанами.

Нам вновь пришлось разделить тест на две части, так как сегодня нам разрешено поделиться только технической информацией и фотографиями. Но уже сегодня мы можем обсудить все архитектурные детали. А публикацию результатов всех тестов нам придётся немного отложить. Но прежде чем мы перейдём к рассмотрению новинки, позвольте высказаться автору.

В середине мая минувшего года на конференции GTC 2012 NVIDIA впервые упомянула о разделении архитектуры "Kepler" на две области: настольные компьютеры (GK10x) и вычисления на GPU (GK11x). Слухи о втором, более крупном чипе появились ещё тогда, но первая информация поступила напрямую от CEO NVIDIA Джен-Хсун Хуанга, который назвал 7,1 млрд. транзисторов, 13 или 14 кластером SMX, 384-битный интерфейс памяти и 3x прирост производительности вычислений с двойной точностью по сравнению с "Fermi". Уже тогда NVIDIA говорила о положительной вероятности появления GK110 через несколько месяцев в виде продуктов GeForce. Но на весь процесс потребовалось явно больше времени, это касается и вычислительных карт Tesla.

Всё изменилось в ноябре 2012 года, когда вычислительные карты Tesla K20 и K20X были официально объявлены. Их технические спецификации позволили представить, какими нам ждать настольные видеокарты GeForce. Конечно, оставались вопросы насчёт реальной производительности GPU в играх, поскольку на основе вычислительных тестов GPU её оценить всё же сложно. Но уже тогда стало понятно, что в грядущих GeForce мы получим 2688 потоковых процессоров CUDA и 6144 Мбайт видеопамяти, подключенной по 384-битному интерфейсу. Но по тактовым частотам выводы было делать рано, слишком уж разные сферы использования у Tesla и видеокарт GeForce.

Сегодня мы уже можем приоткрыть завесу тайны над видеокартой GeForce GTX Titan на основе GPU GK110.

Базовая информация об архитектуре

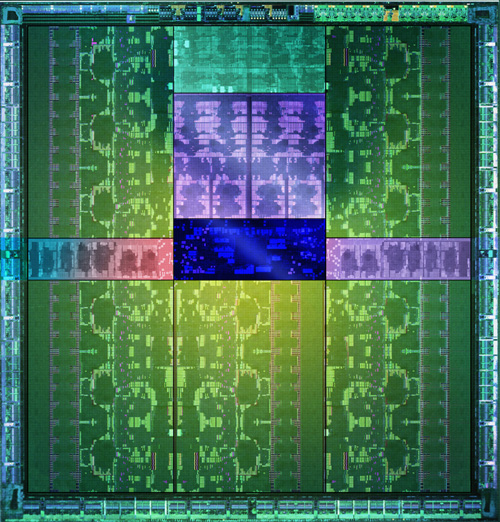

Сначала позвольте рассмотреть GPU GK110:

NVIDIA GK110 можно назвать одним из самых сложных и крупных чипов, производимых сегодня. В нём используется 7,1 млрд. транзисторов, даже при современном 28-нм производстве площадь кристалла составляет около 521 мм². Для сравнения, площадь кристалла IBM zEC12 составляет 597 мм² (32 нм), Intel Itanium "Poulson" - 544 мм² (32 нм). Впрочем, у чипа GT200 из семейства GeForce 200 площадь составляла 576 мм², что ещё больше, хотя тогда GPU изготавливался по 55-нм техпроцессу.

Число транзисторов у GPU GK110 побило прежний рекорд 5 миллиардов (62-ядерный Intel Xeon Phi). Впрочем, число транзисторов ещё не гарантирует соответствующей производительности. Из чего же состоит столь большой и сложный GPU?

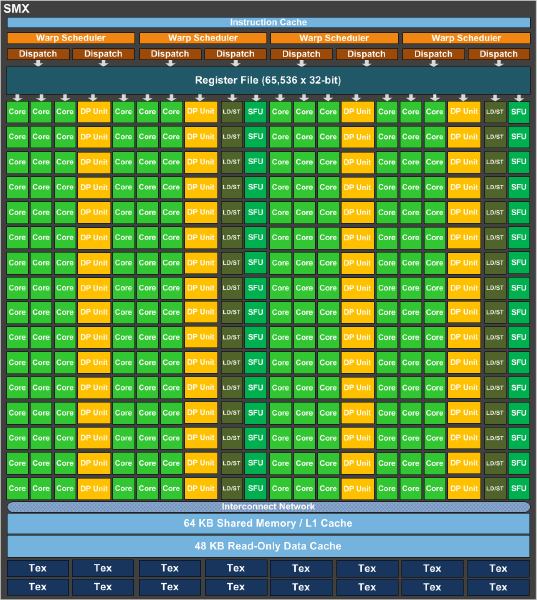

Как и в случае любых GPU на основе архитектуры "Kepler", мы получаем несколько кластеров SMX, каждый из которых состоит из 192 потоковых процессоров CUDA. GPU видеокарты GeForce GTX Titan опирается на 14 кластеров SMX, которые вместе обеспечивают 2688 ядер CUDA. На внешних областях диаграммы GK110 можно заметить интерфейс PCI Express 3.0 и шесть контроллеров памяти, которые все вместе и составляют ширину шины памяти 384 бита. 14 кластеров SMX сгруппированы в пять групп - так называемых Graphics Processing Clusters. На диаграмме приведена полная версия GK110 с 15 кластерами SMX. Но у видеокарты GeForce GTX Titan, как и у GPU Tesla K20X, используется только 14 кластеров SMX.

Обе модели вычислительных карт Tesla на основе NVIDIA GK110 получили существенный прирост производительности вычислений с двойной точностью по сравнению с GK104, увеличение же производительности с одинарной точностью оказалось не таким большим, что можно объяснить смещением акцента с FP32 на FP64. Процессор NVIDIA GK110 впервые был полностью ориентирован на профессиональный рынок и высокопроизводительные вычисления HPC (High Performance Computing). Первое поколение "Kepler" в виде GPU GK104 на видеокартах GeForce GTX 680 как раз нацеливалось на роль настольного GPU GeForce, где решающее значение для рендеринга играет производительность с одинарной точностью. И соотношение производительности с двойной точностью к одинарной точности было снижено с 1/2 до 1/24. Наконец, у GK104 технологией ECC защищена только видеопамять, но не кэш. В любом случае, NVIDIA планирует с помощью GK110 утвердиться не только на профессиональном рынке, но и среди настольных игровых видеокарт с обновлённой линейкой GeForce.

Для увеличения производительности вычислений с двойной точностью, NVIDIA установила 64 ядра с плавающей запятой на кластер SMX. У GK104 мы получали только восемь таких ядер на кластер. Вместе с увеличением числа кластеров, мы получили серьёзный прирост по производительности вычислений с двойной точностью. NVIDIA осталась приверженной своей скалярной архитектуре "Superscalar Dispatch Method", которая впервые появилась в GF104, в результате чего вычисления более устойчивы к ошибкам. К ней относятся параллелизм на уровне потоков Thread Level Parallelism (TLP) и на уровне инструкций Instruction Level Parallelism (ILP), а также целочисленная линейная оптимизация.

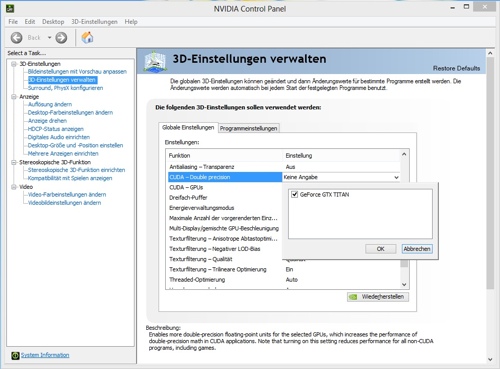

По умолчанию ядра CUDA с двойной точностью работают всего на 1/8 частоты. В панели управления NVIDIA в 3D-настройках есть пункт меню "CUDA - Double Precision". Если его активировать, то ядра CUDA с двойной точностью будут работать на более высокой тактовой частоте, но и тогда они всё равно не достигнут полной частоты 3D. Впрочем, данный пункт будет интересен только для тех пользователей, кто планирует запускать какие-либо научные приложения для расчёта на GPU, где требуется высокая производительность с двойной точностью. Геймерам на эту опцию вряд ли стоит обращать внимание, так как она снижает базовую частоту 3D.

Каждый кластер SMX также оснащён 64 кбайт кэша L1 и 48 кбайт кэша данных только для чтения. По сравнению с GK104, кэш L1 не был затронут, но кластеры GK110 получили 48 кбайт кэш только для чтения. На каждый кластер SMX остались 16 текстурных блоков, в результате чего GK110 предлагает максимум 240 текстурных блоков. Производительность вычислений с двойной точностью была увеличена и благодаря изменениям в регистрах. Число регистров на кластер SMX осталось идентичным - 65 536 по сравнению с GK104, но теперь поток может получать доступ к 255 регистрам в GK110 - против всего 63 в GK104.

Последствия подобных изменений на чистой вычислительной производительности видны хорошо. У GeForce GTX 680 мы получили производительность с одинарной точностью 3,09 TFLOPs. Производительность с двойной точностью была значительно ниже - 128 GFLOPs. У GeForce GTX Titan производительность с одинарной точностью возросла до 4,5 TFLOPs. Производительность с двойной точностью составляет 1,5 TFLOPs.

| NVIDIA GeForce GTX Titan | |

|---|---|

| Розничная цена | Н/Д |

| Сайт производителя | NVIDIA |

| Технические спецификации | |

| GPU | GK110 |

| Техпроцесс | 28 нм |

| Число транзисторов | 7,1 млрд. |

| Тактовая частота GPU (базовая частота) | 837 МГц |

| Тактовая частоат GPU (частота Boost) | 876 МГц |

| Частота памяти | 1502 МГц |

| Тип памяти | GDDR5 |

| Объём памяти | 6144 Мбайт |

| Ширина шины памяти | 384 бит |

| Пропускная способность памяти | 288,4 Гбайт/с |

| Версия DirectX | 11.0 |

| Потоковые процессоры | 2688 (1D) |

| Текстурные блоки | 224 |

| Конвейеры растровых операций (ROP) | 48 |

| Пиксельная скорость заполнения | 40,2 Гпиксль/с |

| SLI/CrossFire | SLI |

| TDP | 250 Вт |

GPU GK110 на видеокарте GeForce GTX Titan работает с базовой частотой 837 МГц для всех 2688 ядер CUDA. Технология GPU Boost, знакомая нам по GPU GK104, используется и у GeForce GTX Titan. Тактовая частота в режиме Boost составляет всего 876 МГц, так что NVIDIA подошла к частотам довольно консервативно. Всё же для GPU возможны частоты 1000 МГц и даже выше.

Память работает на привычной частоте 1502 МГц, но благодаря 384-битному интерфейсу пропускная способность составляет 288,4 Гбайт/с. В общей сложности мы получаем 6144 Мбайт памяти GDDR5. В данном случае NVIDIA закрывает "узкое место" видеокарты по сравнению с конкурентами AMD, которые часто оснащались большим объёмом памяти по сравнению с видеокартами NVIDIA.

Titan имеет TDP в 250 Ватт, повышенное высокое тепловыделение, в сравнении с GeForce GTX 680 (195 Вт), объясняется более сложной архитектурой GPU.

Позвольте перейти к обзору новой видеокарты, где мы сравним её с конкурентами.

Мы уже упоминали выше основные технические характеристики: 2688 ядер CUDA, производительность 4,5 TFLOPs с одинарной точностью и пропускную способность памяти 288,4 Гбайт/с. Но не только.

Прирост производительности должен быть связан с использованием GPU GK110, 6 Гбайт видеопамяти и возможностью установки нескольких видеокарт GeForce GTX Titan в конфигурацию SLI.

Конечно, высокую производительность должно сопровождать и эффективное охлаждение. По дизайну и выбору материалов мы получаем кулер, очень близкий к GeForce GTX 690. Он основывается на испарительной камере (Vapor Chamber) которая контактирует напрямую с GPU. Тепло от графического процессора передаётся тонким алюминиевым рёбрам и рассеивается в окружающую среду. Вентилятор кулера должен установить новые стандарты по эффективному управлению температурой, чему будет способствовать соответствующий профиль работы вентилятора.

Конечно, у покупателей по-прежнему будут альтернативы GeForce GTX Titan, пусть даже видеокарта выступает в отдельной категории. Поэтому мы решили провести сравнение с предыдущими лидерами и GeForce GTX Titan.

Скриншот GPU-Z подтверждает уже имеющуюся у нас информацию. В следующей таблице мы сравним конкурентов с GeForce GTX Titan.

Сравнение с эталонными видеокартами

| Сравнение NVIDIA GeForce GTX Titan с конкурентами | |||

|---|---|---|---|

| Модель | AMD Radeon HD 7970 GHz Edition | NVIDIA GeForce GTX 680 | NVIDIA GeForce GTX Titan |

| Розничная цена | от 360 евро в Европе от 12,7 тыс. рублей в России |

от 400 евро в Европе от 14,6 тыс. рублей в России |

|

| Сайт производителя | AMD | NVIDIA | NVIDIA |

| Технические спецификации | |||

| GPU | Tahiti XT2 | GK104 | GK110 |

| Техпроцесс | 28 нм | 28 нм | 28 нм |

| Число транзисторов | 4,3 млрд. | 3,54 млрд. | 7,1 млрд. |

| Тактовая частота GPU (базовая частота) | 1000 МГц | 1006 МГц | 837 МГц |

| Тактовая частотаGPU (Boost) | 1050 МГц | 1058 МГц | 876 МГц |

| Частота памяти | 1500 МГц | 1502 МГц | 1502 МГц |

| Тип памяти | GDDR5 | GDDR5 | GDDR5 |

| Объём памяти | 3072 Мбайт | 2048 Мбайт | 6144 Мбайт |

| Интерфейс памяти | 384 бит | 256 бит | 384 бит |

| Пропускная способность памяти | 288 Гбайт/с | 192,3 Гбайт/с | 288,4 Гбайт/с |

| Версия DirectX | 11.1 | 11.0 | 11.0 |

| Потоковые процессоры | 2048 (1D) | 1536 (1D) | 2688 (1D) |

| Текстурные блоки | 128 | 128 | 224 |

| ROPs | 32 | 32 | 48 |

| TDP | 250 Вт | 195 Вт | 250 Вт |

В данной таблице мы сравнивали новинку с видеокартами, оснащёнными одним GPU. Конечно, на рынке есть видеокарты GeForce GTX 690 (тест и обзор Hardwareluxx) и Radeon HD 7990 [в виде ASUS ARES II (тест и обзор) и PowerColor HD7990 Devil 13 (тест и обзор)]. По соответствующим ссылкам вы можете получить информацию об их производительности, что позволит сравнить их с GeForce GTX Titan. Но в нашей статье мы сфокусируемся на сравнении с AMD Radeon HD 7970 GHz Edition (тест и обзор) и NVIDIA GeForce GTX 680 (тест и обзор).

Даже по сравнению количества транзисторов можно видеть, какой потенциал скрыт в GeForce GTX Titan. Но 7,1 млрд. транзисторов должны быть задействованы максимально эффективно. Сможет ли архитектура "Kepler" хорошо масштабироваться по сравнению с GK104? Об этом мы поговорим в наших тестах. Тактовая частота GPU NVIDIA была выбрана весьма консервативно - 837 МГц. Для сравнения, у GeForce GTX 680 мы получаем частоту 1006 МГц, которая радует больше. Впрочем, всё же следует учитывать намного более сложную структуру нового GPU. Под нагрузкой тактовая частота увеличивается, как минимум, до 876 МГц благодаря функции Boost, но NVIDIA указывает, что практически все видеокарты смогут увеличивать частоту, как минимум, до 1000 МГц под нагрузкой. Что касается нашего тестового образца, то в большинстве 3D-приложений он действительно увеличивал тактовую частоту до 1006 МГц.

По частоте памяти новинка оказалась ничуть не хуже конкурентов. Всё же 1500 МГц для видеопамяти сегодня является стандартом де-факто. Разница по объёму памяти уже более существенная. Хотя мы тестировали видеокарты Radeon HD 7970 c 6 Гбайт памяти, а GeForce GTX 680 - с 4 Гбайт, эталонные дизайны AMD и NVIDIA обладают в два раза меньшим объёмом. NVIDIA поняла, что объём памяти сегодня играет важную роль, и GeForce GTX 680 иногда упирается в свои 2 Гбайт. Кроме того, по пропускной способности памяти NVIDIA не хотела уступать AMD, поэтому у новинки ширина шины памяти составляет 384 бита, пропускная способность - 288,4 Гбайт/с.

Интересны и измерения энергопотребления. AMD указывает 250 Вт для Radeon HD 7970 GHz Edition, и наши тесты показали, что AMD с более высоким напряжением и тактовыми частотами действительно подобралась к данной планке. У NVIDIA GeForce GTX 680 поначалу всё шло в правильном направлении. Но GeForce GTX Titan - продукт уже новой категории. Поэтому NVIDIA было никуда не деться от теплового пакета 250 Вт TDP.

Сегодня NVIDIA позволяет говорить только о спецификациях и демонстрировать фотографии. Впрочем, никто не мешает нам публиковать собственные результаты тестов и измерений NVIDIA.

На примере пяти игр NVIDIA решила продемонстрировать производительность конфигурации GeForce GTX Titan в режиме 3-Way SLI, сравнив её с двумя GeForce GTX 690 в SLI. В играх Battlefield 3 и Batman: Arkham City прирост ограничивается считанными процентами, но мы получаем удвоение производительности в Max Payne 3, Crysis 3 и FarCry 3 на новых видеокартах.

Как уже упоминалось, NVIDIA уделила особое внимание охлаждению и уровню шума новой видеокарты. На слайде приведено сравнение с системой CrossFire из трёх видеокарт Radeon HD 7970 и конфигурацией 3-Way SLI из трёх GeForce GTX 680. Две этих конфигурации шумят значительно сильнее сборки 3-Way SLI на трёх GeForce GTX Titan. Что ж, в наших тестах мы посмотрим, насколько данная информация соответствует действительности - по крайней мере, с одной видеокартой.

Видеокарта в деталях

Мы уже обсудили основные спецификации GeForce GTX Titan, позвольте поговорить о некоторых деталях.

| Тестовый образец в деталях | ||

|---|---|---|

| Тактовая частота (3D/2D) | Чип | 324 МГц/837 МГц |

| Память | 162 МГц/ 1502 МГц | |

| Turbo | 876 МГц | |

| Видеопамять | Объём | 6144 Мбайт |

| Производитель, тип | Samsung, GDDR5 | |

| Интерфейс памяти | 384 бит | |

| Раскладка | Длина (со слотовым креплением) | 26,5 см |

| Длина (с кулером) | 26,5 см | |

| Ширина (с кулером) | 11 см | |

| Высота (с кулером) | 3,6 см (два слота) | |

| Дополнительное питание | 1x 8-конт. 1x 6-конт. |

|

| Подсистема питания | 6+2-фазная | |

| Кулер | Размер | Два слота |

| Радиатор | Испарительная камера (Vapor Chamber) Никелированные алюминиевые рёбра |

|

| Вентилятор | 65-мм радиальный | |

| Интерфейсы | 2x DL-DVI 1x DisplayPort 1x HDMI |

|

| Комплект поставки | - | |

Мы уже указывали базовую тактовую частоту 837 МГц и частоту Boost 876 МГц. В режиме бездействия частота составляет 324 МГц, что тоже новостью не является - P-состояния хорошо известны по другим чипам "Kepler". Память в режиме бездействия работает на 162 МГц вместо 1502 МГц, что тоже встречалось на других картах "Kepler". В большинстве 3D-приложений наш GPU разгонялся до 1006 МГц, что соответствует 20,1% приросту по сравнению с базовой частотой и 14,8% по сравнению с частотой Boost. По умолчанию частота чипа NVIDIA составляет 837 МГц, в режиме Boost она увеличивается до 876 МГц. Но последнее значение является минимально гарантированным.

Напряжение GPU составляет в режиме бездействия 875 мВ, под нагрузкой оно увеличивается до 1,162 В. Пользователь может вручную увеличивать напряжение до 1,2 В.

| Зависимость напряжения ядра от частоты GeForce GTX Titan | |

|---|---|

| 875 mV | 324 MHz |

| 887 mV | 327 MHz |

| 1000 mV | 836 MHz |

| 1162 mV | 1005 MHz |

Печатная плата GeForce GTX Titan составляет по длине 26,5 см, по высоте - 11 см, толщина карты с кулером - 3,6 см. То есть мы получаем типичный двухслотовый дизайн. NVIDIA четко соответствует спецификациям ATX и собственным тепловым стандартам.

После всех технических спецификаций позвольте перейти к рассмотрению непосредственно самой видеокарты GeForce GTX Titan.

На следующих страницах мы внимательно рассмотрим новинку GeForce GTX Titan.

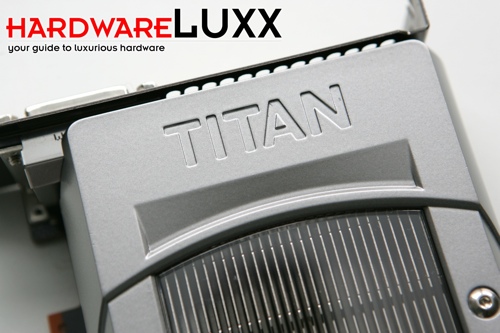

Если сравнивать новинку с дизайном семейства GeForce GTX 600, то по цвету корпуса кулера ошибиться сложно. Сходство с GeForce GTX 690 сразу же бросается в глаза. NVIDIA вновь использовала корпус из магниевого сплава, который обеспечивает лучшую теплопроводность, меньший вес и, соответственно, уровень шума. Отдельные детали кулера мы обсудим ниже, приведя фотографии.

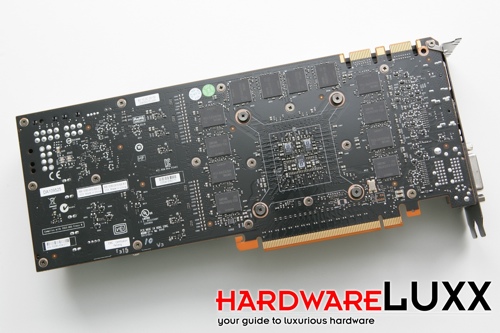

Сзади NVIDIA отказалась от пластины, поэтому печатная плата GeForce GTX Titan видна во всей красе. На плате можно выделить разные области: GPU с памятью справа, а подсистему питания со стабилизаторами напряжения - слева. Вокруг GPU располагаются по 12 чипов памяти GDDR5 на одной стороне, всего их 24.

На лицевой стороне видеокарты рядом со слотовой заглушкой красуется надпись "Titan". Она выдавлена в магниевом корпусе, так что видеокарту вы вряд ли спутаете с другими моделями.

Радиальный вентилятор диаметром 65 мм отличается низким уровнем шума. Сравнимая видеокарта NVIDIA GTX 690 использует осевой вентилятор с намного большим диаметром, у лопастей которого выбран специальный угол атаки. NVIDIA также добавила хромированные вставки, которые придают элегантный внешний вид.

Для управления вентилятором используется интеллектуальная система, которая динамически изменяет скорость вращения в зависимости от температуры. Но более детально мы поговорим о ней в разделе, посвящённом GPU Boost 2.0.

На верхней кромке ближе к заднему краю (если считать от слотовой заглушки) располагаются гнёзда для подключения дополнительного питания. Видеокарта GeForce GTX Titan опирается на 6-контактное и 8-контактное гнёзда питания в дополнение к слоту PCI Express. Все вместе они способны обеспечивать до 300 Вт энергии. Учитывая тепловой пакет 250 Вт, такой мощности должно быть достаточно.

По видеокарте GeForce GTX 690 нам уже знакома подсветка названия "GTX". Приятный ход для компьютеров, оснащённых боковым окном. В полностью закрытых корпусах эта функция, конечно, уже не так актуальна. Если вам надоест подсветка, соответствующий разъём можно просто отключить от печатной платы.

Благодаря двум разъемам SLI вы можете объединять от двух до четырёх видеокарт GeForce GTX Titan. Тесты конфигураций SLI и 3-Way SLI будут опубликованы в четверг.

На фотографии можно рассмотреть печатную плату в деталях сзади. Четыре винта с пружинами обеспечивают давление испарительной камеры на GPU. С трёх сторон из четырёх GPU окружён 12 чипами памяти производства Samsung из 24.

Если быть более точным, на видеокарту установлены чипы памяти K4G20325FD-FC03. Они имеют ёмкость 2 Гбит или 256 Мбайт, тактовая частота по спецификациям составляет 1500 МГц (0,33 нс). Рабочее напряжение заявлено от 1,455 до 1,545 В - в данном случае чипы памяти работают от напряжения 1,5 В.

На слотовой заглушке видеокарта GeForce GTX Titan оснащена двумя двухканальными выходами DVI (DVI-D и DVI-I), по одному HDMI 1.3a и DisplayPort 1.4.

По видеокарте GeForce GTX 690 нам хорошо знакома пластина из оргстекла, накрывающая никелированные алюминиевые рёбра кулера. Они передают накапливающееся тепло воздуху, который продувается с помощью вентилятора-центрифуги через кулер.

Сняв кулер с видеокарты, можно рассмотреть GPU и остальные компоненты печатной платы. Для производительности, обещанной NVIDIA, видеокарта выглядит не очень примечательно, дизайн близок к GeForce GTX 680.

Как и сзади, на лицевой стороне печатной платы вокруг GPU располагаются 12 чипов памяти. Также хорошо заметны и дорожки, проложенные от чипов памяти к GPU. Если вспомнить диаграмму GPU в начале статьи, дорожки хорошо согласуются с подключениями к контроллерам памяти.

На GPU можно отчетливо видеть подпись GK110-400-A1. GK110 многие называют дизайном "Big Kepler". Число за названием указывает на стадию разработки чипа. Возможно, в данной версии предусмотрено 14 кластеров SMX, хотя архитектура изначально нацеливалась на 15 кластеров SMX. A1 указывает на версию кристалла.

По соседству с GPU и чипами памяти располагаются компоненты подсистемы питания. Как можно видеть, она состоит из 6+2 фаз. NVIDIA пока что четко определяет дизайн печатной платы для GeForce GTX Titan. Вероятно, партнёры компании представят видеокарты с собственными системами охлаждения, но все они будут основываться на эталонном дизайне печатной платы. Пока неизвестно, будет ли NVIDIA открывать дизайн, позволяя производителям самостоятельно разрабатывать плату и подсистему питания.

Собственный дизайн NVIDIA также предусматривает и наличие модуля, знакомого нам по видеокарте GeForce GTX 680. На маленькой дополнительной плате установлен чип управления технологией GPU Boost 2.0. Теоретически возможно использовать данный модуль и для старых видеокарт, но мы не знаем, будут ли они выигрывать от технологии GPU Boost 2.0.

Кулер видеокарты GeForce GTX Titan не имеет ничего примечательного. Слева от основного радиатора можно видеть радиальный вентилятор. Справа - нижнюю пластину испарительной камеры Vapor Chamber, которая контактирует напрямую с GPU. Для контакта с чипами памяти и некоторыми другими компонентами подсистемы питания предусмотрены теплопроводящие прокладки.

Предлагаем увеличенную фотографию испарительной камеры и её нижней пластины. Благодаря четырём винам с пружинами она прижимается к GPU и обеспечивает должное давление. Об этом говорят и следы термопасты в правильном количестве.

NVIDIA представила нам не одну видеокарту GeForce GTX Titan, а целых три. Так что перед тем, как мы перейдём к теоретическому рассмотрению GPU Boost 2.0, позвольте привести фотогалерею нашей конфигурации 3-Way SLI:

{jphoto image=33725}

Некоторые характеристики:

- В общей сложности 8064 ядер CUDA

- В общей сложности 21,3 млрд. транзисторов

- В общей сложности 18 Гбайт видеопамяти

- Тепловой пакет 750 Вт TDP

В наших тестах мы также приведем производительность конфигураций SLI и 3-Way SLI.

GPU Boost 2.0

С видеокартой NVIDIA GeForce GTX 680 мы получили важную новую функцию: GPU Boost. И новая NVIDIA GeForce GTX Titan пошла ещё на шаг дальше, расширив эту функцию до версии GPU Boost 2.0. Первый вариант GPU Boost 1.0 ориентировался на максимальное энергопотребление, достигаемое в наиболее требовательных современных играх. При этом температура GPU не играла особой роли, разве что если она вплотную подходила к критическому порогу. Максимальная тактовая частота определялась на основе относительного напряжения. Недостаток был вполне очевиден: GPU Boost 1.0 не могла предотвратить ситуации, когда даже при некритическом напряжении температура чрезмерно увеличивалась.

У GeForce GTX Titan оцениваются уже два параметра: напряжение и температура. То есть относительное напряжение (Vref) определяется уже на основе двух данных параметров. Конечно, зависимость от отдельных экземпляров GPU сохранится, поскольку разброс при производстве чипов существует, поэтому каждая видеокарта будет отличаться от любой другой. Но NVIDIA указывает, что технически добавка температуры позволила дать в среднем на 3-7 процентов более высокий разгон Boost. Технология GPU Boost 2.0 теоретически может быть перенесена на старые видеокарты, но вряд ли это случится.

Позвольте рассмотреть GPU Boost 2.0 более подробно. Утилиты, подобные EVGA Precision Tool или MSI Afterburner, уже поддерживают GPU Boost 2.0. Мы использовали утилиту EVGA Precision Tool в версии 4.0.

GPU Boost 2.0 учитывает температуру, и при низких температурах технология может более существенно увеличивать производительность. Целевая температура (Ttarget) по умолчанию выставлена на уровень 80 °C.

Технология GPU Boost 2.0 содержит все функции, знакомые нам по первому поколению технологии, но при этом дополнительно даёт возможность выставления более высокого напряжения, следовательно, и более высоких тактовых частот. Для оверклокеров существует возможность изменить настройки. Можно включить GPU Overvoltage, но при этом следует помнить о потенциальном снижении срока службы видеокарты.

Оверклокеры могут поднимать Vref и Vmax (OverVoltaging). Этого хотели многие пользователи на GK104, но NVIDIA не доверила подобную возможность ни пользователям, ни производителям. И протестированная нами видеокарта EVGA GTX 680 Classified (тест и обзор) как раз является отличным примером. У этой видеокарты специальный модуль EVGA Evbot обеспечивал пользователям контроль над напряжениями. Но NVIDIA срочно потребовала, чтобы EVGA убрала дополнительное оборудование у своих видеокарт. В случае GPU Boost 2.0 и OverVoltaging NVIDIA сама сделала шаг в данном направлении. Так что производители видеокарт могут выпускать несколько моделей GeForce GTX Titan, например, стандартные версии и варианты с заводским разгоном. Активация OverVoltaging выполняется через переключатель VBIOS (то есть явным образом для пользователя, чтобы он осознавал возможные последствия).

На следующей странице мы рассмотрим GPU Boost 2.0 в работе и оценим, как эта функция влияет на напряжения, температуры и тактовые частоты.

У GPU Boost 1.0 мы получали базовую частоту, частоту Boost и частоту Max Boost, которая определялась относительным напряжением. В свою очередь, напряжение Vref устанавливалось так, чтобы не повредить GPU.

Технология GPU Boost, учитывающая напряжение/энергопотребление и температуру, позволяет получить намного более высокое относительное напряжение, следовательно, и более высокую тактовую частоту.

Через OverVoltaging пользователь может при необходимости выбирать и более высокое напряжение. Но оно должно быть разблокировано производителем, и пользователь должен осознанно пойти на такой шаг, поскольку он потенциально снижает срок службы видеокарты.

На графике выше показано, как долго и насколько часто GPU оказывается в той или иной области частот. Площадь под кривой (от базовой частоты до максимальной частоты) соответствует 100% набору частот, в которых GPU находится определенное время (определенное количество тактов). Если сравнить области частот GPU Boost при переходе от версии 1.0 на 2.0, то теоретическое преимущество GPU Boost 2.0 сразу же становится заметным. В случае OverVoltaging мы получаем продление кривой до более высоких тактовых частот.

Изменения напряжений GPU также влияют и на температуры видеокарты. Тонкая линия на графике соответствует поведению технологии GPU Boost 1.0. Толстая жёлтая линия - GPU Boost 2.0. Как можно видеть, в новой версии GPU Boost плата пытается как можно ближе придерживаться целевой температуре.

Пользователь может указать смещение температуры, которое приведёт к соответствующему перемещению кривой. Но при более высокой целевой температуре видеокарта может быстрее достичь предельного порога 105 °C.

Более высокая целевая температура, конечно же, даёт более высокий потенциал по тактовым частотам. NVIDIA с помощью включения температуры в элементы уравнения хотела достичь именно этого. Собственно, добавка температуры сильнее всего различает GPU Boost 1.0 и 2.0.

NVIDIA также уделяет особое внимание контролеру вентиляторов. При настройках по умолчанию мы получаем график, приведенный выше.

Если мы изменим целевую температуру, то вентилятор слишком рано начнет работать на повышенных скоростях, что приведёт к значительному повышению уровня шума.

Этому можно противодействовать, сместив кривую вентилятора. Эта функция также доступна в программном обеспечении, совместимом с GPU Boost 2.0.

В дополнение к теоретическим сведениям мы предлагаем ознакомиться с видеороликом, демонстрирующим практическую работу GPU Boost 2.0.

Для разных режимов SLI и конфигураций дисплеев вам необходимо придерживаться чёткой схемы подключения мониторов.

Разгон дисплея

В дополнение к GPU Boost 2.0 новинка предлагает ещё одну любопытную функцию под названием "разгон дисплея" (Display Overclocking). В данном случае NVIDIA подразумевает проблему, когда видеокарта высчитывает, например, 90 кадров в секунду, но отображает только 60 кадров в секунду, так как дисплей поддерживает только 60 Гц.

В программах, подобных EVGA Precision Tool 4.0, NVIDIA предлагает возможность активировать Vsync для выставления частоты дисплея больше 60 Гц, определяемых производителем. Вместо 60 Гц частота может быть, например, 80 Гц, и вычитываемые видеокартой 90 кадров в секунду теперь будут превращаться уже не в 60, а в 80 fps. Аппаратное обеспечение в дисплеях часто может справиться с подобными повышенными частотами, и с совместимыми мониторами видеокарта NVIDIA сможет выставлять более высокие тактовые частоты.

Для проведения тестирования мы обновили нашу тестовую систему, а также и поколение драйверов. Процессор Intel Core i7-3960X был разогнан со штатной частоты 3,2 ГГц до 4,2 ГГц, чтобы максимально устранить "узкое место" по производительности CPU. Мы использовали следующие компоненты:

| Тестовая конфигурация | |

|---|---|

| Процессор | Intel Core i7-3960X 3,3 ГГц, разгон до 4,2 ГГц |

| Материнская плата | ASUS P9X79 |

| Оперативная память | ADATA XPG Gaming Series Low Voltage 4x 2 Гбайт PC3-12800U CL 9-9-9-24 |

| Накопитель | ADATA S510 SSD 60 Гбайт |

| Блок питания | Seasonic Platinum Series 1000 Вт |

| Операционная система | Windows 8 Pro 64 Bit |

| Видеокарты | |

| NVIDIA | NVIDIA GeForce GTX Titan (837/1502 MHz, 6144 MB) |

| NVIDIA GeForce GTX 690 (915/1502 MHz, 4096 MB) | |

| NVIDIA GeForce GTX 680 (1006/1502 MHz, 2048 MB) | |

| NVIDIA GeForce GTX 670 (915/1502 MHz, 2048 MB) | |

| NVIDIA GeForce GTX 660 Ti (915/1502 MHz, 2048 MB) | |

| NVIDIA GeForce GTX 660 (1058/1250 MHz, 2048 MB) | |

| NVIDIA GeForce GTX 650 Ti (925/1350 MHz 2048 MB) | |

| NVIDIA GeForce GTX 650 (1058/1250 MHz, 1024/2048 MB) | |

| NVIDIA GeForce GTX 590 (608/1215/854 MHz, 3072 MB - 1536 MB эффект.) | |

| NVIDIA GeForce GTX 580 (772/1544/1000 MHz, 1536 MB) | |

| NVIDIA GeForce GTX 570 (732/1464/950 MHz, 1280MB) | |

| NVIDIA GeForce GTX 560 Ti 448 Cores (732/1464/950 MHz, 1280 MB) | |

| NVIDIA GeForce GTX 560 Ti (820/1640/1000 MHz, 1024 MB) | |

| NVIDIA GeForce GTX 560 (810/1620/1002 MHz, 1024 MB) | |

| NVIDIA GeForce GTX 550 Ti (900/1800/1026 MHz, 1024 MB) | |

| AMD | AMD Radeon HD 7970 GHz Edition (1050/1050/1500 MHz, 3072 MB) |

| AMD Radeon HD 7970 (925/925/1375 MHz, 3072 MB) | |

| AMD Radeon HD 7950 (800/800/1250 MHz, 3072 MB) | |

| AMD Radeon HD 7870 (1000/1000/1200 MHz, 2048 MB) | |

| AMD Radeon HD 7850 (860/860/1200 MHz, 2048 MB) | |

| AMD Radeon HD 7770 (1000/1000/1125 MHz, 1024 MB) | |

| AMD Radeon HD 7750 (800/800/1125 MHz, 1024 MB) | |

| AMD Radeon HD 6990 (830/830/1250 MHz, 4096 MB - 2048 MB эффектив.) | |

| AMD Radeon HD 6970 (880/880/1375 MHz, 2048 MB) | |

| AMD Radeon HD 6950 (800/800/1200 MHz, 2048 MB) | |

| AMD Radeon HD 6870 (900/900/1050 MHz, 1024 MB) | |

| AMD Radeon HD 6850 (775/775/1000 MHz, 1024 MB) | |

| AMD Radeon HD 6790 (840/840/1050 MHz, 1024 MB) | |

| AMD Radeon HD 6770 (850/850/1200 MHz, 1024 MB) | |

| Драйверы | |

| NVIDIA | GeForce 314.09 Beta |

| AMD | Catalyst 13.2 Beta 5 |

Мы выражаем благодарность ASUS, Intel, ADATA, Thermaltake и Seasonic за предоставленные компоненты.

Настройки драйверов NVIDIA:

- Текстурная фильтрация: Качество

- Сглаживание- гамма-коррекция: Да

- Текстурная фильтрация - оптимизация анизотропии: Нет

- Текстурная фильтрация - отрицательный LOD Bias: Заблокировано

Текстурные настройки AMD:

- Текстурная фильтрация: Качество

- Catalyst AI: Выключен/ Качество

Ниже приведены настройки тестов, использованных нами:

Futuremark 3DMark 11 (DX11):

- Entry

- Performance

- Extreme

Futuremark 3DMark (DX11):

- Ice Storm

- Cloud Gate

- Fire Strike

- Fire Strike Extreme

- Sala

Compute Mark (Complex):

- Fluid 3D

- Fluid 2D

- Mandel Vektor

- Mandel Skalar

- RayTracing

Unigine Valley (DX11):

- 1680x1050 1xAA/AF

- 1680x1050 8xAA/16xAF

- 1920x1080 1xAA/AF

- 1920x1080 8xAA/16xAF

- 2560x1600 1xAA/AF

- 2560x1600 8xAA/16xAF

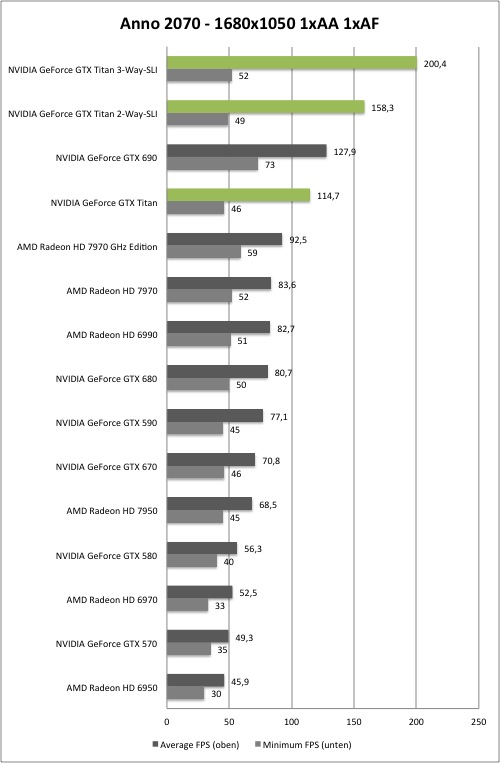

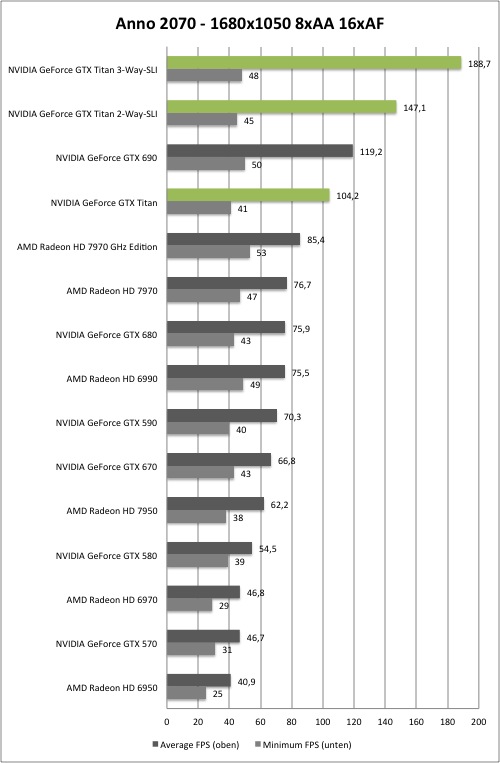

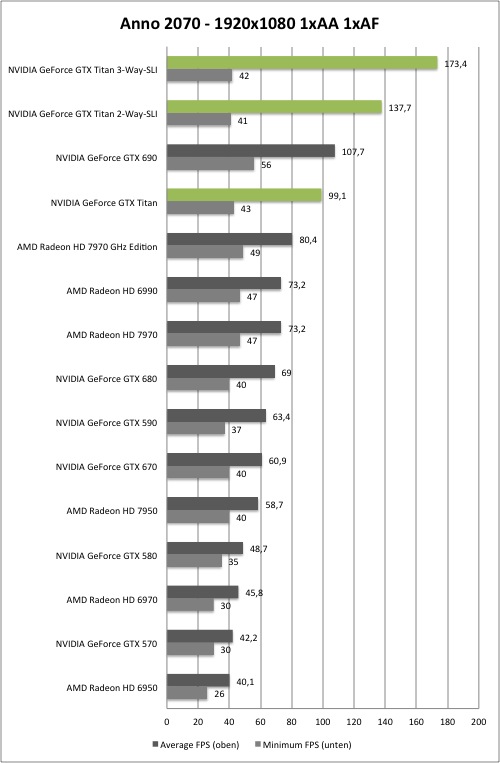

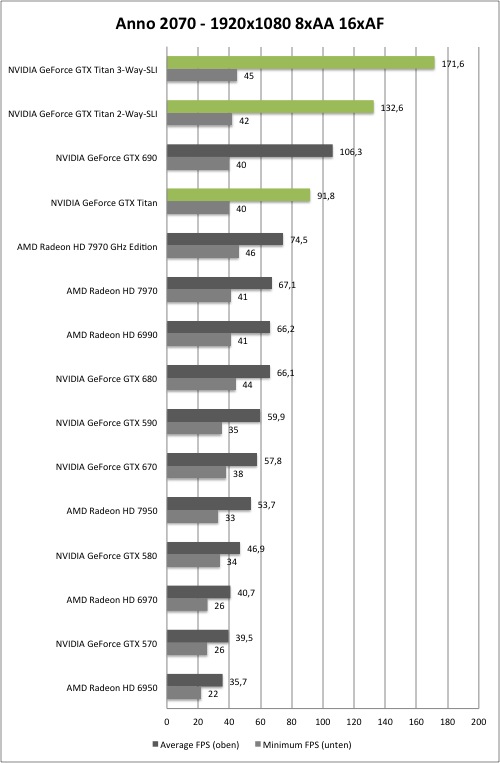

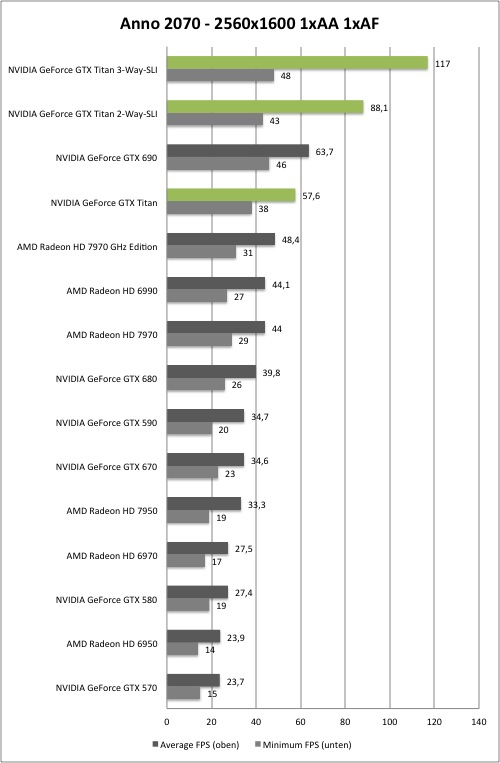

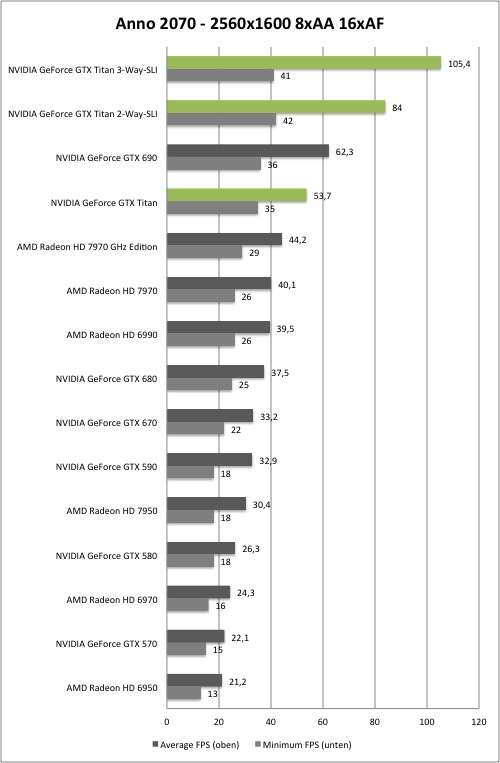

Anno 2070 (DX11):

- 1680x1050 1xAA/AF

- 1680x1050 MLAA 16xAF

- 1920x1080 1xAA/AF

- 1920x1080 MLAA 16xAF

- 2560x1600 1xAA/AF

- 2560x1600 MLAA 16xAF

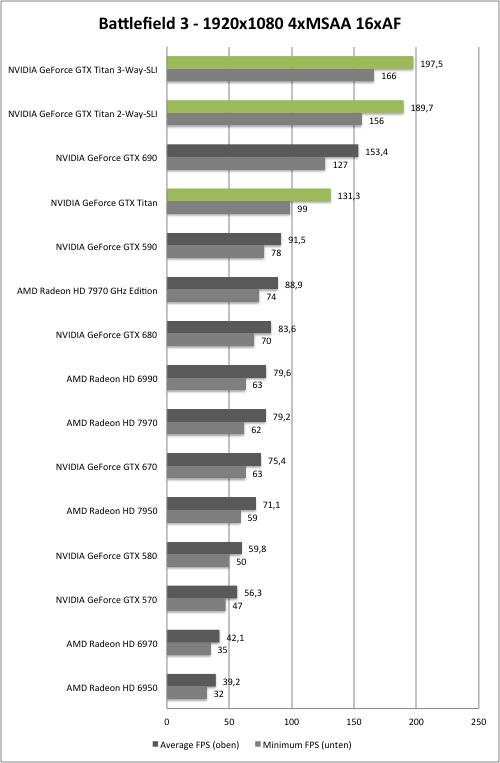

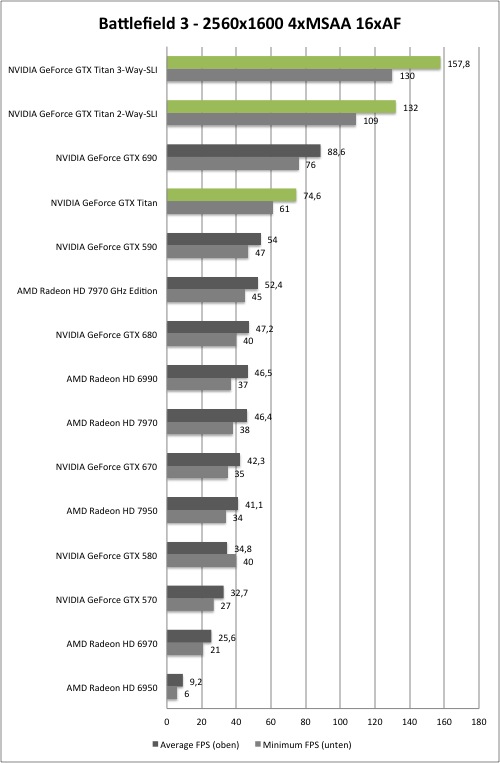

Battlefield 3 (DX11):

- 1680x1050 1xAA/AF

- 1680x1050 4xMSAA 16xAF

- 1920x1080 1xAA/AF

- 1920x1080 4xMSAA 16XAF

- 2560x1600 1xAA/AF

- 2560x1600 4xMSAA 16xAF

Call of Duty: Black Ops II (DX11):

- 1680x1050 1xAA/AF

- 1680x1050 8xMSAA+FXAA 16xAF

- 1920x1080 1xAA/AF

- 1920x1080 8xMSAA+FXAA 16XAF

- 2560x1600 1xAA/AF

- 2560x1600 8xMSAA+FXAA 16xA

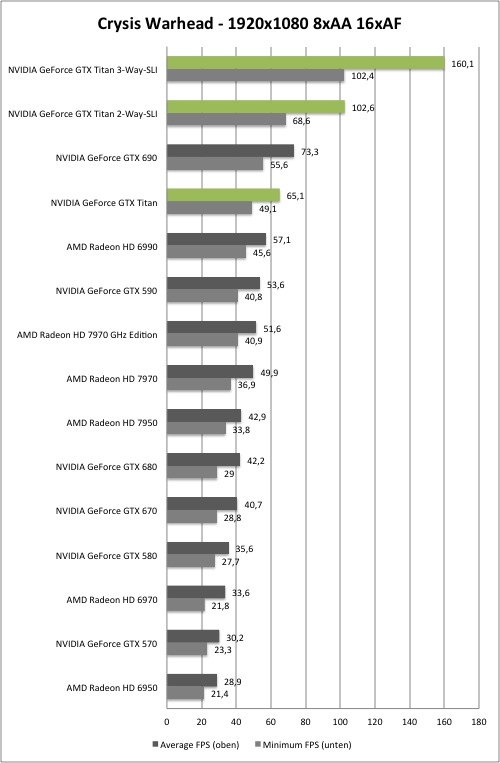

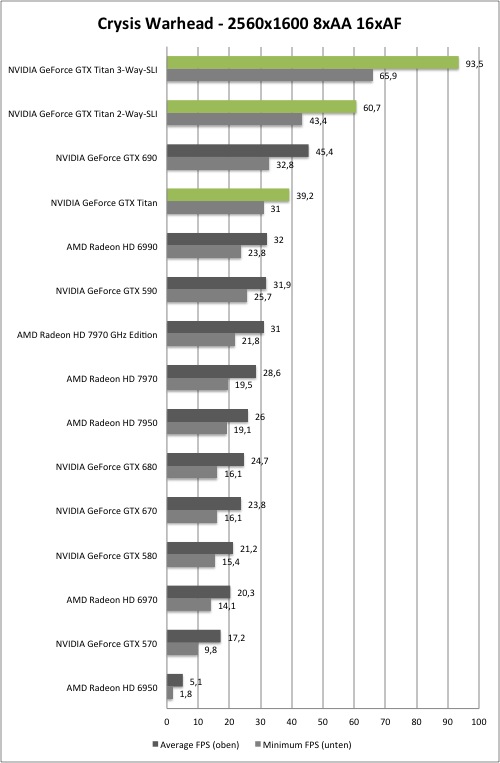

Crysis Warhead (DX10):

- 1680x1050 1xAA/AF

- 1680x1050 8xMSAA 16xAF

- 1920x1080 1xAA/xAF

- 1920x1080 8xMSAA 16xAF

- 2560x1600 1xAA/AF

- 2560x1600 8xMSAA 16xAF

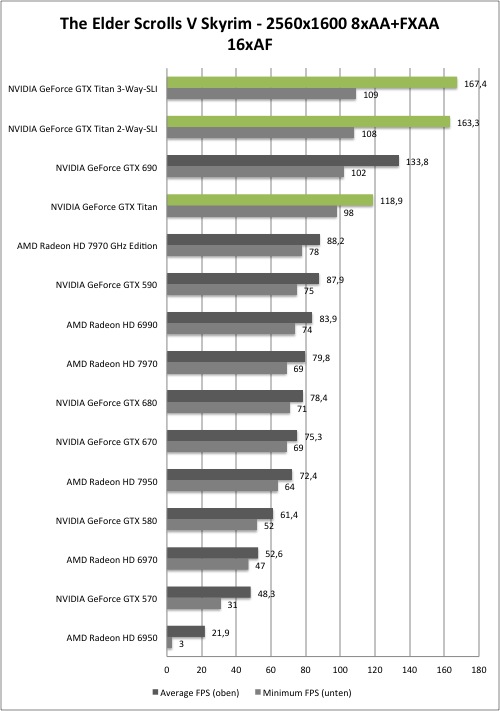

The Elder Scrolls V: Skyrim (DX9):

- 1680x1050 1xAA/AF

- 1680x1050 8xAA+FXAA 16xAF

- 1920x1080 1xAA/AF

- 1920x1080 8xAA+FXAA 16xAF

- 2560x1600 1xAA/AF

- 2560x1600 8xAA+FXAA 16xAF

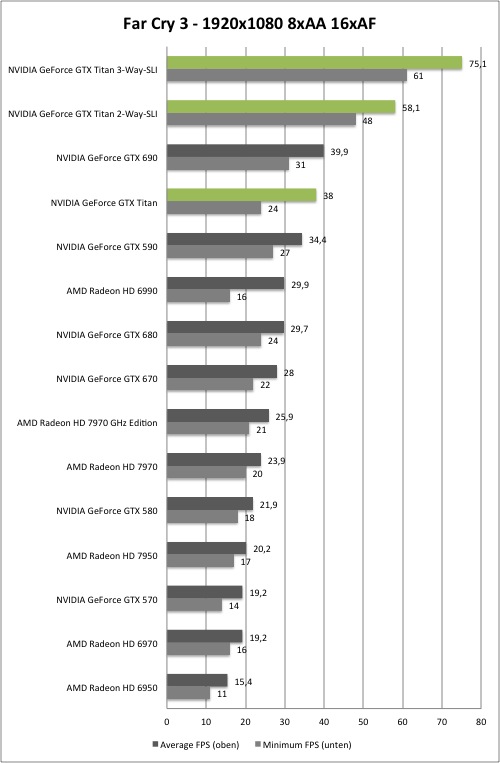

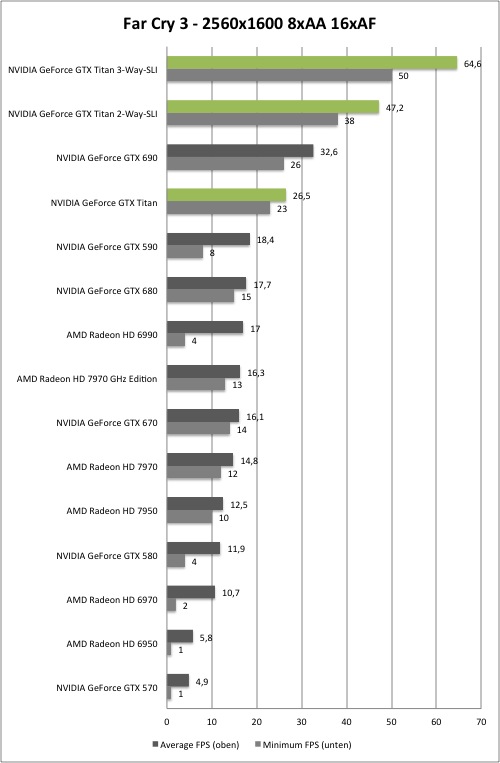

Far Cry 3 (DX11):

- 1680x1050 8xAAx16xAF

- 1920x1080 8xAA/16xAF

- 2560x1600 8xAA/16xAF

Hitman: Absolution (DX11):

- 1680x1050 8xMSAA/16xAF

- 1920x1080 8xMSAA/16xAF

- 2560x1600 8xMSAA/16xAF

В последнюю секунду мы узнали, что можем опубликовать первые результаты тестов.

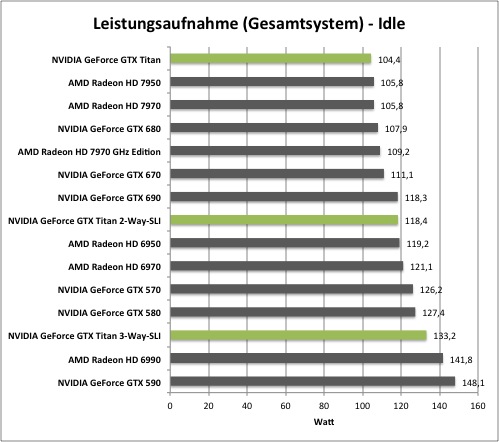

Энергопотребление всей системы в режиме бездействия, Вт.

У видеокарт NVIDIA GeForce GTX Titan в режиме бездействия энергопотребление оказалось довольно низким - мы получили всего 104,4 Вт для всей системы. Так что энергопотребление для одного GPU вполне приемлемое. Если добавить в систему вторую видеокарту GeForce GTX Titan, то энергопотребление увеличивается на 14 Вт до 118,4 Вт. NVIDIA указывает энергопотребление в режиме бездействия на уровне около 15 Вт, и по результатам наших тестов мы можем это подтвердить. Третья видеокарта добавила в систему те же самые 15 Вт, так что мы получили общее энергопотребление 133,2 Вт, которое осталось ниже уровня Radeon HD 6990 или GeForce GTX 590. Как видим, за последние годы произошли позитивные сдвиги, энергопотребление видеокарт в режиме бездействия значительно снизилось.

Несколько мониторов: когда мы подключали более одного монитора к GeForce GTX Titan, энергопотребление увеличивалось до 116,7 Вт.

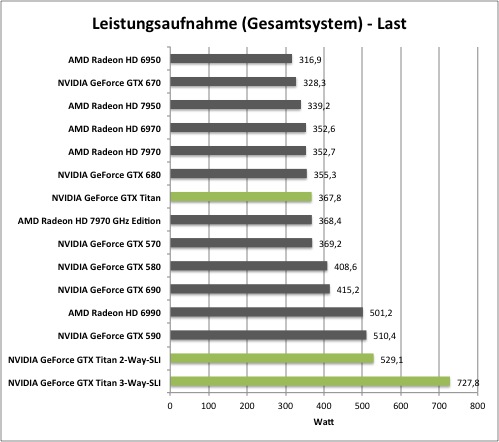

Энергопотребление всей системы под нагрузкой, Вт.

Под нагрузкой энергопотребление GeForce GTX Titan оказалось примерно на 12 Вт больше, чем у GeForce GTX 680. Разница вполне ожидаемая, поскольку, в зависимости от теста и сценария нагрузки, тестовая видеокарта нагружается больше или меньше. Мы проводили результаты измерений, используя специальные утилиты для увеличения энергопотребления, подобные Furmark или OCCT. Под нагрузкой заметен прогресс по сравнению с предыдущим поколением видеокарт NVIDIA.

Система SLI, состоящая из двух видеокарт GeForce GTX Titan, оказалась чуть "прожорливее" GeForce GTX 590, она потребляла около 530 Вт, то есть на 160 Вт больше одиночной видеокарты. Третья GeForce GTX Titan обеспечила рост энергопотребления на 200 Вт. Для нашей системы в целом мы получили энергопотребление 727 Вт от розетки, что немало. Впрочем, если вы готовы отдать больше 100 тыс. рублей за три видеокарты, то вряд ли будете задумываться о счёте за электроэнергию.

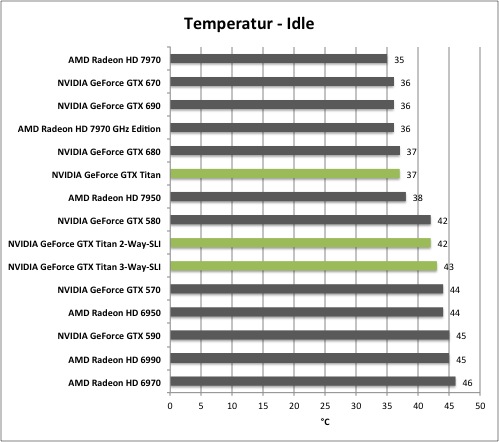

Температура в режиме бездействия, градусы Цельсия.

NVIDIA обещала эффективное охлаждение благодаря использованию высококачественных компонентов. В принципе, режим бездействия ещё ничего не говорит об эффективности системы охлаждения, хотя некоторые прогнозы сделать позволяет. Температура 37 °C у видеокарты GeForce GTX Titan не очень высокая.

Видеокарты в конфигурациях SLI и 3-Way SLI взаимно понижают эффективность охлаждения, поэтому они нагреваются даже в режиме бездействия. Впрочем, температуры 42 и 43 °C нельзя назвать серьёзными.

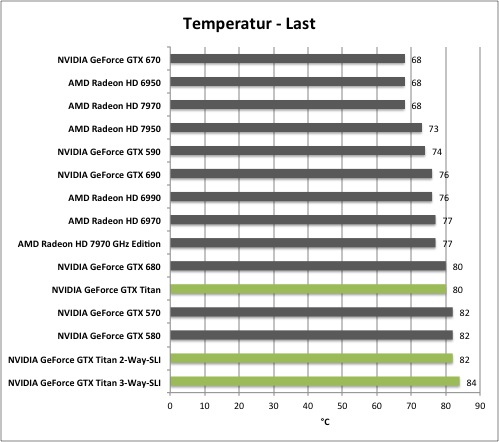

Температура под нагрузкой, градусы Цельсия.

Под нагрузкой видеокарты GeForce GTX Titan нагревались сильнее ожидаемого уровня. Поэтому у нас возникли сложности с порогом температуры на уровне 80 °C. Для конфигураций SLI и 3-Way SLI нам пришлось поднять его, чтобы GPU не снижали напряжение и тактовые частоты. В принципе, температуры 82 или 84 °C никаких проблем для видеокарт не составляют, но если вы опасаетесь, то можете выставить целевую температуру обратно на 80 °C. NVIDIA указывает, что критическая температура выключения составляет 105 °C.

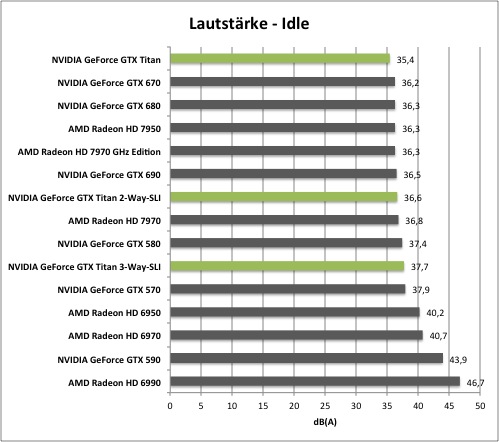

Уровень шума в режиме бездействия, дБ(А).

Помимо производительности немалое значение имеет уровень шума. NVIDIA, похоже, сдержала свое обещание, видеокарта GeForce GTX Titan в режиме бездействия работает с уровнем шума всего 35,4 дБ(A). По сравнению с конкурентами мы получили минимальное значение. Даже в режимах SLI и 3-Way SLI видеокарты работают намного тише, чем многие модели с одним GPU.

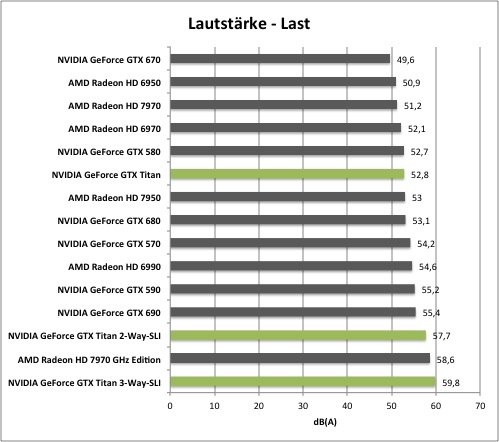

Уровень шума под нагрузкой, дБ(А).

Конечно, под нагрузкой ситуация намного интереснее. Видеокарта GeForce GTX Titan явно не относится к классу тихих моделей, уровень шума составляет 52,8 дБ(A), то есть он находится по соседству с GeForce GTX 680 или Radeon HD 7950. В конфигурациях SLI и 3-Way SLI уровень шума возрастает, видеокарты обходят Radeon HD 7970 GHz Edition - что, кстати, говорит не в пользу самой быстрой видеокарты от AMD с одним GPU.

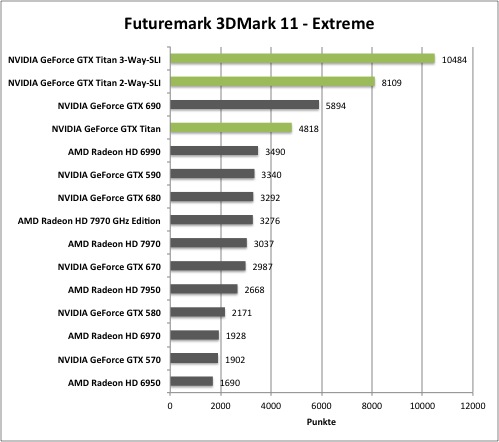

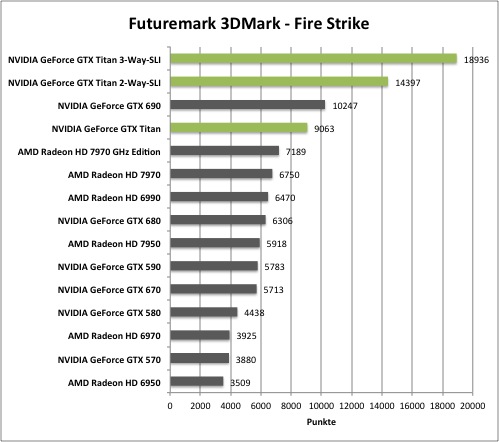

Мы добавили в наши тесты последнее поколение 3DMark. 3DMark 11 является первым тестом, полностью ориентированным на DirectX 11, от разработчика Futuremark. Именно по этой причине тест интенсивно использует тесселяцию, глубину поля резкости, объёмное освещение и DirectCompute. Вполне логичным кажется требование по наличию многоядерного процессора с количеством ядер не меньше четырёх. Скачать тест можно в соответствующем разделе нашего сайта.

Новый тест Futuremark 3DMark позволяет сравнивать разные устройства, от смартфонов до high-end ПК. В тесте предоставляются три пресета, которые охватывают все сферы производительности благодаря изменяемым настройкам. Конечно, в тесте используются такие технологии, как тесселяция, глубина поля резкости, объемное освещение и DirectCompute. Тестовый прогон Firestrike Extreme должен поставить даже high-end видеокарты "на колени". Скачать тест Futuremark 3DMark можно в соответствующем разделе сайта.

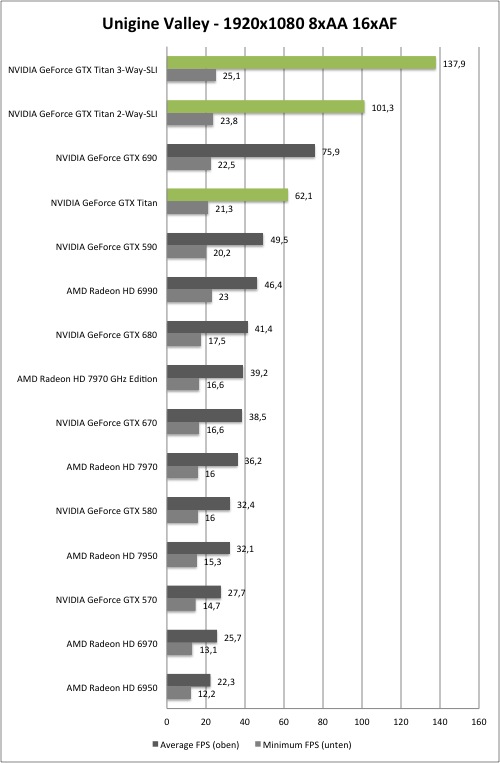

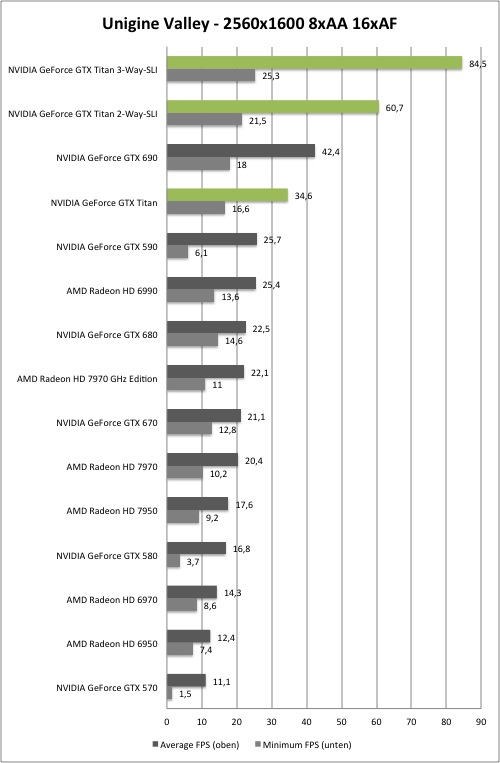

Тест Unigine Heaven неплохо показал себя в будущем в качестве платформы для сравнения производительности, недавно он был улучшен в виде версии Valley. Тест создаёт ландшафт площадью 64 млн. квадратных метров, который накладывает высокую нагрузку на современные GPU, в том числе, благодаря богатой растительности и динамически изменяемой погоде. Встроенный тест оценивает производительность в различных окружениях, что позволяет составить полную общую картину производительности. Скачать Unigine Valley можно на сайте разработчика.

AMD и NVIDIA всегда подчёркивают вычислительную производительность своих GPU. И в дополнение к многочисленным движкам с поддержкой OpenCL, мы также решили оценить вычислительную производительность отдельно. Мы взяли тест LuxMark 2.0, тестовую сцену "Sala" с использованием RayTracing, результат теста выводится в сэмплах в секунду. Скачать LuxMark 2.0 можно по следующей ссылке.

С помощью теста ComputeMark мы пытались более точно оценить вычислительную производительность GPU. Тест основан на автоматическом выполнении нескольких вычислительных сценариев, которые накладывают различные требования к "железу". Вычислительная мощность тесту предоставляется через API DirectX 11 Compute. Среди всего прочего тест включает сценарий отслеживания лучей (RayTracing). Скачать ComputeMark можно на сайте разработчика.

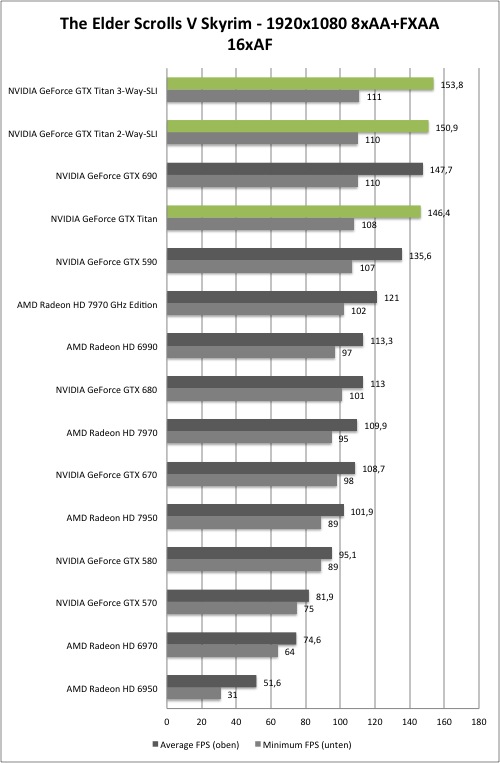

Действие пятой игры в семействе The Elder Scrolls разворачивается в провинции Skyrim. Сюжет игры построен вокруг возвращения драконов, что было предсказано в древних свитках ("Elder Scrolls"). Геймер играет роль "довакина", то есть персонажа с телом человека и душой дракона. В игре вам предстоит сражаться не только с обычными тварями, но и с драконами. Добавим к этому реалистичные улицы и захватывающие дух пейзажи, уходящие в горизонт. Благодаря отличной детализации растительности и значительной дальности видимости Skyrim может нагрузить любую видеокарту.

Разработчиков Crysis можно поблагодарить за то, что их игра стала тестом де-факто графических возможностей ПК. Движок Cry Engine всегда отличался тем, что мог "поставить на колени" даже новейшие high-end системы. Именно по этой причине для наших тестов мы взяли дополнение Crysis Warhead. Мы запускали Crysis в режиме DirectX 10 с максимальным уровнем детализации.

Black Ops 2 - последняя часть в игровой линейке "Call of Duty", при этом новое дополнение опирается на различные улучшения движка. Мир находится в состоянии холодной войны между Китаем и США за драгоценные редкоземельные металлы. Запрет экспорта привёл к кибератаке, парализовавшей китайский фондовый рынок. Конфликт разворачивается между двумя сторонами, которые, тем не менее, избегают открытого противостояния.

Игра Anno 2070 отличается от предшествующих игр серии тем, что действие происходит не в прошлом, а через 60 лет в будущем. Геймплей во многом похож, то есть вам нужно исследовать и открывать острова, колонизировать их, создавать циклы производства продукции и развития поселений, чтобы удовлетворять потребности общества, а также выстраивать дипломатические отношения с соседями. В игру были введены три фракции: Эко/Eco нацеливаются на развитие возобновляемых источников энергии и сохранение природы, Магнаты/Tycoons не стесняются загрязнять окружающую среду ради прибыльной работы тяжелой промышленности. Третья фракция Техи/Techs развивают новые технологии и осваивают морские глубины. Большие острова, живая флора и фауна, впечатляющие эффекты воды и растительности - всё это в изобилии имеется в игре благодаря движку Related Designs (DX11), и высокие настройки детализации накладывают немалую нагрузку на видеокарту.

Семейство Battlefield недавно получило уже третью итерацию, позволяющую геймерам сражаться друг с другом на масштабных аренах. В игре можно выбирать бойцов разной специализации, воевать с помощью реалистично смоделированного оружия и техники. Добавьте к этому мощный движок Frostbite 2 (DX11), обеспечивающий глубокое погружение в игру. Благодаря продвинутой системе совершенствований, достижений и роста персонажа интерес к игре не будет ослабевать в течение долгого времени, добавьте к этому возможность разблокирования оружия и гаджетов. Так что длительное наслаждение третьей игрой в семействе Battlefield гарантировано.

Самая новая игра в семействе Far Cry построена на движке Dunia Engine 2, разработчиком выступила Ubisoft. Геймер традиционно переносится на тропический остров, где он играет роль протагониста Джейсона Броди, попавшего на остров со своими друзьями. Главного героя со всей честной компанией захватывают в плен пираты, поэтому выбираться придётся в одиночку. А потом, с помощью местных жителей, геймеру придётся вызволять из плена друзей и расстреливать врагов. Far Cry 3, как и две предыдущие версии игры, радует впечатляющей графикой. В режиме DirectX 11 картинка значительно улучшается сглаживанием, технологией Ambient Occlusion и красивыми текстурами. Добавим к этому высокую плотность деталей, так что даже high-end видеокартам придётся нелегко.

Hitman: Absolution можно назвать наследницей предыдущей игры Hitman: Blood Money. Главный персонаж - агент 47, работающий профессиональным киллером. В Hitman: Absolution агенту 47 предстоит узнать, что бывшие друзья предали его и покинули. Так что придётся заняться обычным делом, чтобы распутать ситуацию. Игра Hitman: Absolution базируется на движке Glacier 2, который способен нагрузить даже high-end видеокарты.

Игра Crysis 3 вышла в самом конце зимы 2013, приковав к себе внимание многих геймеров. Новинка от Crytek поддерживает только видеокарты DirectX 11, так что намерения разработчиков понятны. Игра использует множество сложных и современных графических технологий, от тесселяции до сглаживания через пост-обработку, что нагружает даже high-end видеокарты.

Даже в разрешении 2560x1600 пикселей и соответствующих настройках сглаживания и анизотропной фильтрации, видеокарту GeForce GTX Titan нагрузить получается не всегда. Особенно если мы тестируем конфигурацию SLI или 3-Way SLI. Так что мы решили провести некоторые игровые тесты в режиме Surround, чтобы максимально нагрузить современные high-end видеокарты.

Производительность GeForce GTX Titan лучше всего заметна на высоких разрешениях и высоких настройках качества. Но разрешение 2560x1600 или 5760x1080 со сглаживанием 8xMSAA и 16xAF - далеко не предел. Видеокарту можно дополнительно нагрузить сглаживанием по методу суперсэмплинга, который даст ещё более высокое качество картинки. Мы провели тесты нескольких игр, которые поддерживают так называемое сглаживание "Sparse Grid Supersampling Anti-Aliasing" или SGSSAA.

Как и в случае предыдущих видеокарт "Kepler", функция GPU Boost 2.0 играет важную роль в разгоне GeForce GTX Titan. Для тестов разгона мы внесли следующие настройки:

- Power Target на +106 процентов, что с учётом TDP 250 Вт увеличивает максимальное энергопотребление до 265 Вт

- Temp Target на 95 °C

- Скорость вентилятора на 85 процентов

- OverVoltaging на 1,2 В/li>

Мы смогли достичь стабильной работы на прибавке частоты +150 МГц для GPU и памяти. Более высокие тактовые частоты с нашим образцом получить не удалось.

Разгон привел к следующим результатам тестов:

Конечно, повышение тактовых частот и напряжения привело к увеличению энергопотребления, температуры и уровня шума:

Энергопотребление всей системы под нагрузкой, Вт.

Температура под нагрузкой, градусы Цельсия.

Уровень шума под нагрузкой, дБ(А).

Мы также оценили влияние разгона памяти на производительность, является ли пропускная способность памяти "узким местом" в играх:

NVIDIA сделала шаг, который ждали многие: GPU GK100 сначала появился в двух вычислительных картах Tesla, теперь графический процессор был представлен и для настольных видеокарт. Но GeForce GTX Titan в ближайшие месяцы придётся занимать рынок в гордом одиночестве, так как NVIDIA не будет предлагать производные варианты видеокарт. Видеокарта нацелена на энтузиастов и позволяет им переждать до появления нового поколения - хотя новинка, конечно, получилась не дешёвой.

У GeForce GTX Titan можно выделить несколько ключевых особенностей:

- Самый сложный GPU на сегодня

- Самая быстрая видеокарта с одним GPU на сегодня

- Самая дорогая видеокарта с одним GPU на сегодня

Добавим к этим факторам стремление NVIDIA представить новый продукт без каких-либо компромиссов. Мы не знаем, какую часть в цене $1000 или 35 тыс. рублей в России занимает кулер. Но явно немалую - на то указывают выбор материалов и качество изготовления. С другой стороны, какой смысл использовать дорогие материалы, если видеокарта всё равно будет скрыта в корпусе ПК? С другой стороны, такой подход производителя позволяет достичь наибольшей эффективности охлаждения, а, следовательно, и производительности. Всё это хорошо видно по тем же видеокартам NVIDIA GeForce GTX 690.

По производительности одиночного GPU NVIDIA вновь может наслаждаться короной производительности. Как собственная GeForce GTX 680, так и AMD Radeon HD 7970 (GHz Edition) остались далеко позади. Новинка обгоняет на 40-50 процентов предыдущего лидера NVIDIA, примерно с таким же отрывом она оставляет позади и Radeon HD 7970 GHz Edition. Но достаточно ли этого, чтобы оправдать трату 35 тыс. рублей? Вопрос на самом деле не такой простой, достаточно посмотреть на результаты производительности GeForce GTX 690, особенно в разрешении 5760x1080 пикселей. Сравнение цены говорит в пользу видеокарты с двумя GPU - её сегодня можно приобрести по цене от 30,8 тыс. рублей. Впрочем, у GeForce GTX Titan и в этом случае есть свой козырь: видеокарта оснащена одним GPU, у которого не проявляется эффект микро-подёргиваний (пусть даже этот эффект был значительно снижен в последних продуктах NVIDIA). Но если бы цена NVIDIA GeForce GTX Titan начиналась с 30 тысяч рублей (или 800 евро), то поводов для критики было бы меньше. С другой стороны, мы не знаем затрат на разработку и прогнозируемых продаж high-end видеокарт, так что не можем говорить об экономической обоснованности такой цены. В любом случае, всё зависит от рынка - он может внести свои корректировки.

К счастью, нам удалось заполучить и протестировать три видеокарты NVIDIA GeForce GTX Titan, так что в нашем обзоре вы найдете большое количество результатов тестов с разным количеством GPU. Одно можно сказать точно: три GeForce GTX Titan создают проблему не только с точки зрения бюджета, но и технически, поскольку даже нашему Intel Core i7-3960X с разгоном до 4,2 ГГц не всегда удавалось успевать за видеокартами. Только при выставлении высоких настроек качества, которые серьёзно нагружают видеокарты, они смогли раскрыть свой потенциал. Не забывайте, что подобная конфигурация имеет смысл только для максимально возможных разрешений и "прожорливых" режимов сглаживания.

| NVIDIA GeForce GTX Titan | |

|---|---|

| Розничная цена | 35 тыс. рублей (рекомендуемая) |

| Сайт производителя | NVIDIA |

| Технические спецификации | |

| GPU | GK110 |

| Техпроцесс | 28 нм |

| Число транзисторов | 7,1 млрд. |

| Тактовая частота GPU (базовая частота) | 837 МГц |

| Тактовая частоат GPU (частота Boost) | 876 МГц |

| Частота памяти | 1502 МГц |

| Тип памяти | GDDR5 |

| Объём памяти | 6144 Мбайт |

| Ширина шины памяти | 384 бит |

| Пропускная способность памяти | 288,4 Гбайт/с |

| Версия DirectX | 11.0 |

| Потоковые процессоры | 2688 (1D) |

| Текстурные блоки | 224 |

| Конвейеры растровых операций (ROP) | 48 |

| Пиксельная скорость заполнения | 40,2 Гпиксль/с |

| SLI/CrossFire | SLI |

| Уровень шума | |

| В режиме бездействия | 35,4 дБ(A) |

| Под нагрузкой | 52,8 дБ(A) |

| Энергопотребление | |

| В режиме бездействия | 104,4 Вт |

| Под нагрузкой | 387,6 Вт |

| Температуры | |

| В режиме бездействия | 37 °C |

| Под нагрузкой | 80 °C |

NVIDIA неплохо поработала над кулером. Он работает не только тихо, но и эффективно, так что температура остаётся на низком уровне. Всё это немаловажно и для новой функции GeForce GTX Titan - GPU Boost 2.0. Выставляя целевую температуру и энергопотребление, вы можете значительно влиять на производительность GeForce GTX Titan. В принципе, вы можете просто купить видеокарту и установить ее в компьютер - никаких дополнительных настроек не потребуется. Но если вы хотите выжать из видеокарты чуть более высокую тактовую частоту и производительность, то можете поработать над характеристиками в свое удовольствие. Рано или поздно на рынок выйдут версии GTX Titan с водяным охлаждением, и для них изменение характеристик будет играть намного более важную роль. Выиграют от подобного подхода и экстремальные оверклокеры, которые могут получить высокие тактовые частоты благодаря охлаждению с жидким азотом. Но, тем не менее, нам хотелось бы получить ответы на следующие вопросы:

- Будет ли NVIDIA поставлять специальные OC-версии видеокарт производителям? Пока что, по имеющейся у нас информации, платы могут отличаться только более высокими возможностями разгона. NVIDIA поставляет видеокарты производителям с уже смонтированным кулером, после чего они могут вносить оптимизации и, возможно, устанавливать свой BIOS.

- Какие требования NVIDIA накладывает по напряжению? Наша эталонная видеокарта позволяла выставлять, максимум, 1,2 В. Это неплохо, но с учётом максимальной планки напряжения 1,162 в Boost не так и много. Мы не знаем, какой максимум будет у производителей видеокарт. Но по некоторым слухам в BIOS можно будет выставлять до 1,5 В. В любом случае, мы рекомендуем быть очень осторожным, так как семь с лишним миллиардов транзисторов можно быстро отправить в небытие.

{jphoto image=33725}

Титаны проиграли битву Олимпийцам, после чего были изгнаны в подземный мир. Какая судьба ждёт GeForce GTX Titan? Производительность вы можете легко оценить самостоятельно по приведенным в статье тестам. По крайней мере, сравнение с видеокартами с одним GPU будет однозначным. Но как насчёт видеокарты GeForce GTX 690 собственного производства? AMD до выхода не переставала подчеркивать, что GeForce GTX Titan не пошатнет короны производительности у видеокарт Radeon HD 7990 (что правда), но в данном случае AMD очень сильно зависит от своих партнёров, а также использует решение на двух GPU, со всеми преимуществами и недостатками.

Альтернативы? Покупать GeForce GTX Titan будут не из соображений здравого смысла, а просто исходя из возможностей своего бюджета. Всё же за 35 тыс. рублей можно собрать готовый игровой компьютер, на котором будут плавно идти даже последние игры. Поэтому мы не видим разумных альтернатив GeForce GTX Titan.

Личное мнение

Получить первым в свои руки полностью новый GPU - всегда радость для редактора. Пусть даже архитектура и не полностью новая, но по сравнению с "младшим Kepler" есть существенные отличия. Так что видеокарта GeForce GTX Titan радует в первую очередь техническими достижениями, а уже во вторую - производительностью. Слишком уж мало мы получаем достойных технологических новинок в последнее время.

Получить первым в свои руки полностью новый GPU - всегда радость для редактора. Пусть даже архитектура и не полностью новая, но по сравнению с "младшим Kepler" есть существенные отличия. Так что видеокарта GeForce GTX Titan радует в первую очередь техническими достижениями, а уже во вторую - производительностью. Слишком уж мало мы получаем достойных технологических новинок в последнее время.

В теории, соглашение о неразглашении (NDA) обязывает обе стороны не публиковать информацию до определенной даты. Такое соглашение часто подписывается, чтобы у автора было достаточно времени для написания статьи. Но выход GeForce GTX Titan стал ещё одним примером того, что времени было оставлено катастрофически мало. Первоначально карта должна была быть представлена вчера в понедельник, а тесты - сегодня. Но видеокарта Titan поступила в нашу лабораторию только в минувший четверг, однако до выходных NVIDIA не присылала драйвера. До вторника времени на тесты явно бы не хватило, что заставило NVIDIA перенести анонс GeForce GTX Titan на вторник, когда нам уже можно поделиться спецификациями и функциями. Результаты тестов мы сможем опубликовать только в четверг. Впрочем, в оправдание NVIDIA отметим, что не каждый день на рынок выходит пиксельный "монстр" с 7,1 млрд. транзисторов, поэтому задержки с отсылкой образцов и разработкой драйвера понятны. (Андрей Шиллинг)

Преимущества NVIDIA GeForce GTX Titan:

- Высокая производительность с одним GPU

- Плавная игра даже на высоких разрешениях и настройках качества

- Высокий потенциал разгона

- GPU Boost 2.0 с большим возможностями для пользователя

- Высокая вычислительная производительность

- Тихий и эффективный кулер

Недостатки NVIDIA GeForce GTX Titan:

- Высокая цена

- Не даёт ощутимого прироста производительности по сравнению с GeForce GTX 680/690 и Radeon HD 7970

- Высокое энергопотребление в конфигурациях SLI и 3-Way SLI

Видеокарта NVIDIA GeForce GTX показала великолепную производительность в режимах с одним GPU и SLI, высокую эффективность системы охлаждения, что позволяет присудить ей награду "Отличное железо".