И вот настал день, когда NVIDIA снимает завесу тайны с новой линейки GeForce RTX 20. К сожалению, не полностью. В данной статье мы поговорим об архитектуре Turing и всех улучшениях, которые она содержит. В том числе обсудим аппаратную поддержку трассировки лучей и RTX. Тесты GeForce RTX 2080 и GeForce RTX 2080 Ti мы сможем опубликовать лишь через несколько дней. А именно в среду вы узнаете подробности производительности GeForce RTX 2080 и GeForce RTX 2080 Ti.

И вот настал день, когда NVIDIA снимает завесу тайны с новой линейки GeForce RTX 20. К сожалению, не полностью. В данной статье мы поговорим об архитектуре Turing и всех улучшениях, которые она содержит. В том числе обсудим аппаратную поддержку трассировки лучей и RTX. Тесты GeForce RTX 2080 и GeForce RTX 2080 Ti мы сможем опубликовать лишь через несколько дней. А именно в среду вы узнаете подробности производительности GeForce RTX 2080 и GeForce RTX 2080 Ti.

Для NVIDIA выход архитектуры Turing является следующим крупным шагом на пути эволюции видеокарт, который можно сравнить с появлением первых потоковых процессоров. Впрочем, после публикации технических спецификаций первых трех видеокарт (GeForce RTX 2080 Ti, GeForce RTX 2080 и GeForce RTX 2070), демонстрации первых реализаций RTX и, самое главное, объявлении цен возникли вопросы о том, оправдывают ли преимущества технологии столь высокую цену?

NVIDIA с архитектурой Turing меняет подход к своим продуктам. Проблема "курицы и яйца" теперь решается просто - добавлением аппаратной поддержки, а также опорой на крупных игровых разработчиков. Основатель NVIDIA за минувшие недели не раз подчеркивал, что трассировка лучей является одним из самых важных шагов за последние годы. Она позволяет перенести технологию освещения на новый уровень. Напомним, что трассировка лучей симулирует прохождение как можно большего числа лучей света на сцене. Что позволяет реалистично вывести отражения, преломления, рассеивание света, тени, поглощение, полупрозрачные материалы и многое другое.

Но как работает трассировка лучей? В принципе, данную технологию нельзя назвать новой. Причем ускорители трассировки лучей тоже входили на рынок, например, R2500 и R2100 от Imagination Technologies в 2016 году. Компания до сих пор разрабатывает данную концепцию для своей архитектуры PowerVR, но также и для других сфер.

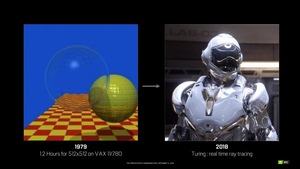

Но можно обратиться к еще более ранней истории, поскольку трассировка лучей на сцене выполнялась еще в 1980 году. Тогда компьютеру VAX 11/780 потребовалось больше часа на обработку картинки 512 x 512 пикселей. Но даже в 2018 году трассировка лучей в реальном времени по-прежнему невозможна. Из препятствий можно отметить не только универсальный дизайн и функциональность классического конвейера рендеринга. Сегодня для наложения трассировки лучей на полную сцену требуется производительность в несколько петафлопов. И с учетом нынешнего развития технологий до такого уровня уйдет еще лет десять.

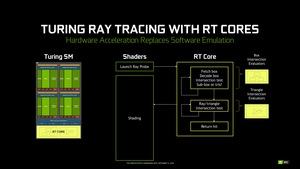

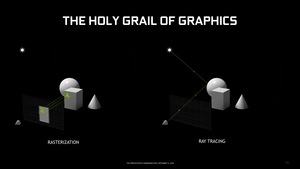

Поэтому NVIDIA с архитектурой Turing решила представить трассировку лучей с аппаратным ускорением, которая опирается на дополнительные ресурсы GPU. Сочетание новой архитектуры (Turing SM), знакомых ядер Tensor, новых ядер RT и новых технологий шейдинга позволяет добиться гибридного рендеринга. То есть основой остается классический рендеринг с растеризацией, но он поддерживает дополнительные технологии, в том числе трассировку лучей для расчета освещения, теней, отражений и других эффектов.

Новые видеокарты

Но перейдем к новым видеокартам GeForce RTX 2080 и GeForce RTX 2080 Ti. О младшей GeForce RTX 2070 мы детально поговорим в момент ее официального анонса. Пока что ограничимся двумя первыми моделями.

GeForce RTX 2080 Ti содержит 4.352 потоковых процессора, у GeForce RTX 2080 и GeForce RTX 2070 мы получаем уже меньше - 2.944 и 2.302, соответственно. Если ориентироваться на спецификации ядер Tensor и RT для полной версии GPU TU102, можно высчитать соответствующие показатели для GeForce RTX 2080 Ti, GeForce RTX 2080 и GeForce RTX 2070 - NVIDIA до сих пор не стала официально объявлять количество ядер Tensor и RT.

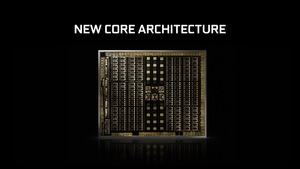

Соответственно, потоковые кластеры SM GPU состоят из 32, 64 или даже 128 потоковых процессоров. Блок SM (Streaming Multiprocessor) архитектуры Pascal содержал 128 потоковых процессоров, для архитектуры Volta NVIDIA изменила структуру на 64 потоковых процессора на кластер SM. Поскольку архитектура Turing наверняка базируется на Volta, а не на Pascal, можно ожидать 64 потоковых процессора на SM и в случае Turing. Что хорошо сочетается с числом ядер Tensor на SM. В архитектуре Volta мы получаем восемь ядер Tensor на кластер SM - как и в случае Turing.

| Модель | GeForce RTX 2080 Ti | GeForce RTX 2080 | GeForce RTX 2070 |

| Цена | 95.990 руб. 1.259 евро |

63.990 руб. 849 евро |

47.990 руб. 639 евро |

| Технические спецификации | |||

|---|---|---|---|

| Архитектура | Turing | Turing | Turing |

| GPU | TU102 | TU104 | TU106 |

| Техпроцесс | TSMC 12 нм | TSMC 12 нм | TSMC 12 нм |

| Число транзисторов | 18,6 млрд. | 13,6 млрд. | 10,8 млрд. |

| Площадь кристалла | 754 мм² | 545 мм² | 445 мм² |

| Потоковые процессоры | 4.352 | 2.944 | 2.304 |

| Тензорные ядра | 544 | 368 | 288 |

| Ядра RT | 68 | 46 | 36 |

| Текстурные блоки | 272 | 184 | 144 |

| Геометрические блоки | 34 | 23 | 18 |

| ROPs | 88 | 64 | 64 |

| Частота GPU (базовая) | 1.350 МГц | 1.515 МГц | 1.410 МГц |

| Частота GPU (Boost) | 1.635 МГц | 1.800 МГц | 1.710 МГц |

| RTX-OPS | 78 TRTX-OPS | 60 TRTX-OPS | 45 TRTX-OPS |

| Гигалучей/с | 10 Глуч/с | 8 Глуч/с | 6 Глуч/с |

| Частота памяти | 1.750 МГц | 1.750 МГц | 1.750 МГц |

| Тип памяти | GDDR6 | GDDR6 | GDDR6 |

| Объем памяти | 11 GB | 8 GB | 8 GB |

| Ширина шины памяти | 352 бит | 256 бит | 256 бит |

| Пропускная способность | 616 Гбайт/с | 448 Гбайт/с | 448 Гбайт/с |

| TDP | 260 Вт | 225 Вт | 185 Вт |

| Доп. питание | 2x 8-конт. | 1x 8-конт. + 1x 6-конт. | 1x 8-конт. |

| SLI/NVLink | 2x NVLink | 1x NVLink | - |

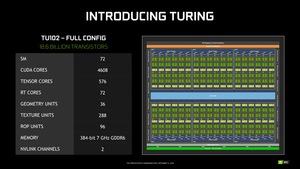

Теперь перейдем к ранее неизвестному элементу архитектуры Turing - ядрам RT. На 4.608 потоковых процессора указано 72 ядра RT, то есть можно сделать вывод об одном ядре RT на кластер SM (4.608 потоковых процессоров / 64 = 72 кластеров SM = 72 ядра RT). Кстати 72 кластера SM x 8 ядра Tensor = 576 ядра Tensor в полной конфигурации.

Также мы знаем и число текстурных блоков на кластер SM - четыре, как и в архитектуре Volta. Для интерфейса памяти расчет аналогичен архитектуре Pascal: интерфейс памяти разбит на 32-битные блоки. NVIDIA отключила один блок из 384 у полной версии GPU TU102, поэтому мы получаем 352-битный интерфейс GeForce RTX 2080 Ti. К каждому 32-битному блоку подключен свой чип памяти. 352/32 бита = 11 каналов или 11 чипов GDDR6. Для GeForce RTX 2080 и GeForce RTX 2070 мы получаем 256/32 бита = 8 каналов или 8 чипов GDDR6. К каждому 32-битному блоку подключены восемь растровых конвейеров ROP.

С потоковыми процессорами архитектуры Turing продолжается дальнейшее развитие архитектуры Volta. Напомним, что архитектура Volta была явно ориентирована на профессиональный рынок благодаря вычислительным блокам FP64. Также в Volta появились и ядра Tensor, но мы не предполагали, что они будут играть какую-либо роль на игровых видеокартах GeForce. Но NVIDIA внесла некоторые изменения, о которых мы поговорим подробнее. Мы были правы в том, что NVIDIA выбрала развитие GPU по двум направлениям: архитектура Volta нацелена на ускорители Tesla, а Turing - на видеокарты Quadro и GeForce.

Но что нового в Turing SM?

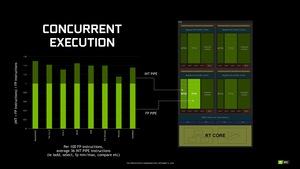

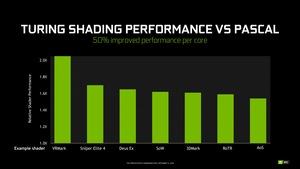

В конвейере теперь поддерживается одновременное выполнение целочисленных вычислений (INT) и расчетов с плавающей запятой (FP). Свой вклад вносят ядра Tensor и RT. Также NVIDIA изменила иерархию кэша, но архитектура Turing намного ближе к Volta по сравнению с Pascal.

В случае всех предыдущих архитектур NVIDIA одновременное выполнение целочисленных вычислений и расчетов с плавающей запятой не поддерживалось. NVIDIA проанализировала данные вычисления в конвейере рендеринга в десятках игр, обнаружив, что на каждые 100 расчетов FP выполняется примерно треть вычислений INT. Впрочем, значение среднее, на практике оно меняется от 20% до 50%. Конечно, если вычисления FP и INT будут выполняться одновременно, то конвейеру придется иногда "подтормаживать" в случае взаимных связей.

В любом случае, параллельная обработка FP и INT ускоряет рендеринг, поэтому NVIDIA как раз и добавила ее с архитектурой Turing. У Turing SM имеются 64 блока FP32 и 64 блока INT32 - не совсем типичное соотношение для конвейера рендеринга.

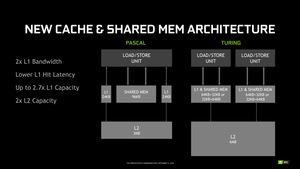

В иерархии кэша произошли изменения, NVIDIA в архитектуре Turing увеличила число блоков Load/Store. В архитектуре Volta NVIDIA использовала 32 блока Load/Store на SM. В случае архитектуры Pascal тоже использовалось 32 блока Load/Store на SM. Сейчас же в архитектуре Turing каждый потоковый мультипроцессор опирается на 64 блока Load/Store, которые выполняют адресацию памяти, кэш обрабатывает 16 потоков за такт. Но NVIDIA также внесла изменения в кэш L1 и общую память.

Кэш L2 был увеличен до 6 Мбайт еще в архитектуре Volta, такой же объем перешел и в Turing. Некоторые изменения с кэшем L1 знакомы по архитектуре Volta. В случае Pascal кэши L1 и общая память были разделены, теперь NVIDIA их объединила. Что наблюдалось и в Volta. Кэш L1 и общая память в случае Volta имели размер 128 кбайт. А объем общей памяти можно было изменять до 96 кбайт. С архитектурой Turing NVIDIA уменьшила объем до 96 кбайт в сумме, теперь он может разделяться на 64 кбайт (кэш L1) + 32 кбайт (общая память) или 32 кбайт (кэш L1) + 64 кбайт (общая память).

Данный шаг должен повысить производительность шейдинга до 50% на потоковый процессор. Посмотрим, какие результаты мы получим в тестах. Мы планируем провести специальные измерения.

Современные GPU упираются не только в вычислительную производительность, но и в пропускную способность памяти. Как раз High Bandwidth Memory была разработана, чтобы решить данную проблему. Но с ней возникли сложности с доступностью, ценой и технической реализацией, что не позволило достичь поставленных целей. Первой видеокартой с поддержкой HBM стала Radeon R9 Fury X от AMD. Но даже сегодня у памяти HBM остаются проблемы с емкостью, ценой и доступностью.

С видеокартами Radeon RX Vega 64 и Vega 56 AMD попыталась вывести данную технологию на массовый рынок, но себестоимость памяти и подложки с GPU и чипами памяти сказались на скромном успехе данного GPU от AMD. NVIDIA смогла более эффективно подойти к дизайну своих видеокарт, вместе с Micron компания разработала память GDDR5X для GeForce GTX 1080 Ti, которая была несколько быстрее GDDR5. NVIDIA так и не стала переходить на HBM в случае игровых видеокарт, ограничившись ускорителями Tesla и дорогими моделями для рабочих станций в линейке Quadro.

В некоторых решениях память HBM2 смогла заработать на частоте 1.000 МГц, как планировалось изначально, но в случае видеокарт успехи скромнее. Пропускная способность приблизилась к 900 Гбайт/с, но не достигла обещанного 1 Тбайт/с. В данном случае подразумевается ширина интерфейса памяти 4.096 бит, что на практике получить весьма сложно. Игровые видеокарты на архитектуре AMD Vega опираются лишь на ширину 2.048 бит, поэтому пропускная способность составляет всего 484 Гбайт/с.

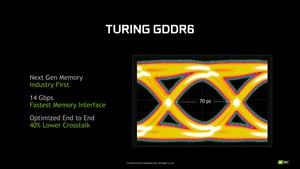

С памятью GDDR6 NVIDIA приблизилась к уровню пропускной способности, который ранее был возможен только для HBM. На данный момент Samsung остается эксклюзивным партнером NVIDIA, корейский производитель выпускает память GDDR6 с пропускной способностью 14 Гбит/с на контакт. В случае 352-битного интерфейса памяти GeForce RTX 2080 Ti мы получаем пропускную способность 616 Гбайт/с, в случае GeForce RTX 2080 и 256-битного интерфейса - 448 Гбайт/с.

Для лучшего понимания мы свели современные технологии памяти в таблицу.

| GDDR6 | GDDR5X | GDDR5 | HBM2 | |

| Пропускная способность на контакт | 14 Гбит/с | 11 Гбит/с | 4 Гбит/с | 1,7 Гбит/с |

| Емкость чипа | 1 GB | 1 GB | 512 MB | 4 GB |

| Пропускная способность на стек/чип | 56 Гбайт/с | 44 Гбайт/с | 28 Гбайт/с | 217,6 Гбайт/с |

| Напряжение | 1,35 В | 1,35 В | 1,5 В | 1,2 В |

| Ширина шины памяти | 352 бит | 352 бит | 384 бит | 4.096 бит |

| Пропускная способность памяти | 616 Гбайт/с | 484 Гбайт/с | 336,6 Гбайт/с | 900 Гбайт/с |

Чтобы лучше пояснить особенности технологий памяти, мы привели практические реализации GDDR6, GDDR5X, GDDR5 и HBM2 в паре с GPU. Хорошо видно, что у HBM2 имеются преимущества по пропускной способности памяти, но интерфейс очень широкий и дорогой в реализации. Вместе с тем у GDDR6 пропускная способность подходит к уровню HBM2 без чрезмерно дорогой себестоимости.

Нынешняя память GDDR6 - лишь первый шаг. Производители, в том числе Micron, SK Hynix и Samsung, планируют представить чипы с более высоким уровнем емкости и пропускной способности. В будущем можно рассчитывать до 20 Гбит/с на контакт. Что увеличит пропускную способность до почти 900 Гбайт/с при 352-битном интерфейсе.

При разработке скоростной памяти приходится решать проблему передачи сигналов на высоких тактовых частотах. Здесь неизбежно возникают перекрестные помехи. На иллюстрации как раз показан такой сигнал. При тактовой частоте 1.750 МГц изменения сигнала происходят каждые 70 пс. Для правильного декодирования сигнала участок по центру должен быть как можно более чистым. Иначе сигнал будет передан с ошибкой.

При разработке GDDR6 NVIDIA и Samsung удалось добиться очень чистого сигнала на частоте 1.750 МГц.

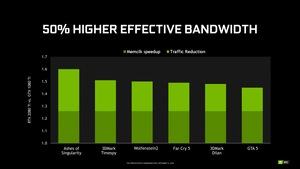

Технология сжатия памяти

Не менее важны и технологии сжатия памяти. AMD и NVIDIA в последних поколениях GPU опираются на цветовую дельта-компрессию (Delta Color Compression). NVIDIA сейчас поддерживает уже пятое поколение технологии. AMD начала использовать его с GPU Tonga на видеокартах R9 295. Важно понимать, что данный метод сжатия работает без потерь. Таким образом, цветовая информация не теряется, каких-либо дополнительных усилий со стороны разработчиков не требуется.

NVIDIA использовала для сжатия памяти цветовую дельта-компрессию (Delta Color Compression). Она основана на хранении полной цветовой информации только о базовом пикселе, для остальных пикселей сохраняется разница с базовым (дельта). Для этой цели используется матрица 8x8 пикселей. Поскольку близко расположенные пиксели обычно мало отличаются по цвету, хранение для них разницы оказывается по объёму информации выгоднее, чем полного значения цвета. Поэтому в случае дельта-компрессии информация о пикселях занимает меньше места в памяти, также достигается экономия пропускной способности памяти. В качестве примера работы технологии можно привести полностью черный и белый блоки, которые будут храниться в памяти как {1.0, 0.0, 0.0, 0.0} или {0.0, 1.0, 1.0, 1.0}. Здесь можно сэкономить ресурсы, сохраняя только 0.0 или 1.0 в качестве значения.

NVIDIA улучшила процедуру определения сжимаемого контента. Ранее известное соотношение 2:1 теперь может использоваться чаще, то есть применяться к большему массиву данных. Появились и соотношения сжатия 4:1 и 8:1.

Сжатие цветовой информации позволяет увеличить эффективную пропускную способность памяти, поскольку физически ей приходится передавать меньше информации. Что повышает эффективность работы интерфейса памяти.

По названию "трассировка лучей" сразу же можно понять принцип работы технологии. Лучи исходят от источника света, после чего попадают в глаз зрителя. Но на самом деле все ровно наоборот, в компьютерной графике используется обратный порядок трассировки лучей (Backward Ray Tracing).

Начнем с того, что трассировка лучей является способом проверки видимости объекта. Проходящий луч рассчитывается для каждого пикселя, который располагается на экране, начиная от глаза зрителя. В результате расчет затрагивает все видимые объекты (примитивы) в 3D-пространстве. В результате с помощью геометрии для каждого пикселя экрана можно определить видимые и невидимые объекты.

Кроме проверки видимости объектов, трассировка лучей позволяет добавить на сцену и другую информацию. В частности, освещение. Для этого используются свойства материала всех примитивов. Матовая поверхность или глянцевая? Какой угол отражения, степень прозрачности или рассевания света? Также используются и другие параметры, которые описывают поведение поверхности. Легко посчитать, что число лучей экспоненциально увеличивается по мере усложнения сцены. Видеокарты GeForce RTX 20 по-прежнему не могут рассчитывать трассировку лучей в реальном времени для полного кадра в разрешении UHD, если требуется учитывать несколько сотен или даже тысяч примитивов со своими свойствами отражения и рассеяния. Так что NVIDIA пришлось пойти на ряд хитростей для снижения вычислительной нагрузки. Среди них - модели локального освещения или описания источников света, упрощающие расчет.

На проверке видимости объектов и расчете освещения возможности трассировки лучей не ограничиваются. Лучи можно проложить не только в обратном порядке, от зрителя через экран к источнику света. Но и из любой точки пространства. Что как раз позволяет рассчитывать тени.

Тень создается в том случае, если между точкой поверхности и источником света имеется препятствие. Конечно, в реальности одним источником света дело не ограничивается. Отражения и рассеивания света приводят к появлению мягких и жестких теней, а также других эффектов, в зависимости от расстояния. В случае классического рендеринга могут использоваться заранее подготовленные карты теней (предварительно рассчитанные, что весьма сложно для крупных сцен и масштабных 3D-миров), либо определенные технологии, такие как Enhanced Horizon Based Ambient Occlusion (HBAO), Hybrid Frustum Traced Shadows (HFTS) и т.д. Но все они являются лишь приближением к реалистичному расчету теней.

Еще сложнее трассировка лучей становится в случае полупрозрачных, прозрачных и отражающих объектов. В точках пересечения сред появляются дополнительные лучи, поэтому расчетов становится больше. До сих пор те же отражения были возможными только при использовании определенных хитростей в процессе рендеринга, поскольку если отраженные объекты располагались за пределами видимого пространства, то они отсекались от процесса рендеринга раньше, поэтому и расчет не представлялся возможным.

В случае отражающих поверхностей следует учитывать отраженные лучи (угол падения равен углу отражения). Если же объект прозрачный, то необходимо опираться на законы преломления. Кроме того, прозрачные объекты отражают часть света, а не только преломляют. Эти дополнительные лучи увеличивают сложность сцены и необходимые вычисления.

Вторичные лучи тоже могут отражаться/преломляться, так что трассировка лучей используется рекурсивно для создания множественных отражений и преломлений. NVIDIA показала данную функцию в некоторых демонстрациях. Рекурсивная трассировка лучей была разработана еще в 1980-х годах, но только теперь она получила техническую реализацию NVIDIA. Причем рекурсивная трассировка лучей позволяет вывести не только множественные отражения и преломления света, но и тени. Игровые движки часто рассматривают источники света как точки. Но в реальности источники света имеют определенный размер, что приводит к размытию теней. Для расчета мягких теней вместо одного луча просчитываются несколько, после чего принимается среднее значение. Такой подход позволяет создавать основную тень и полутень. Недостатком можно назвать появление шума, если используется слишком мало лучей. Но NVIDIA придумала свое решение, на котором мы остановимся чуть ниже.

Последний момент - трассировка пути Path Tracing, расчеты лучей выполняются не только из глаза зрителя, но и от источников света. Сочетание разных способов позволяет максимально реалистично вывести сцену. Но трассировка пути требует значительных вычислительных ресурсов, сочетание разных технологий трассировки еще больше увеличивает нагрузку, так что возникают вопросы насчет того, как именно NVIDIA поддержала трассировку лучей и пути на видеокартах GeForce RTX 20.

NVIDIA RTX, OptiX и Microsoft DXR позволяют реализовать следующие технологии:

- Отражения и преломления

- Тени и Ambient Occlusion

- Global Illumination

- Instant и Off-Line Lightmap Baking

- Primary Rays для Foveated VR-Rendering

- Occlusion Culling

- Расчеты физики, определение коллизий, симуляция частиц

- Симуляция аудио (NVIDIA VRWorks Audio)

- In-Engine Path Tracing (не в реальном времени)

Полная трассировка лучей со всеми функциями, описанная выше, остается очень сложной задачей. Поэтому технология NVIDIA RTX выполняет трассировку лучей лишь частично. Цель заключается в оптимизации вычислительной нагрузки. Но технология RTX - это интерфейс разработчика. Поэтому расчет лучей в реальном времени через Direct Compute и Microsoft DXR будет работать и на других GPU. Microsoft с обновлением Windows 10 April 2018 Update (Redstone 4) представила соответствующую версию DirectX 12 с поддержкой DXR.

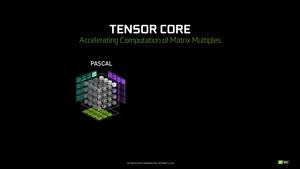

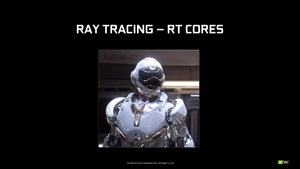

Примерно пять лет назад NVIDIA решила взять направление аппаратной трассировки лучей. Компания решила разработать аппаратные блоки, которые будут ускорять расчеты трассировки. И сегодня мы как раз их получаем в виде ядер RT.

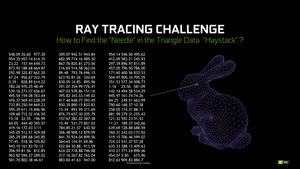

Для уменьшения вычислительной нагрузки трассировки лучей используются различные техники. Все они опираются на тот принцип, что удаленные от луча примитивы не могут с ним пересекаться. Поэтому и смысла их просчитывать нет. Экспоненциальное увеличение числа лучей приводит к тому, что на каждый луч следует обрабатывать как можно меньшее число примитивов, чтобы не увеличивать вычислительную нагрузку.

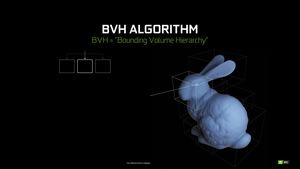

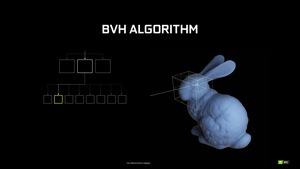

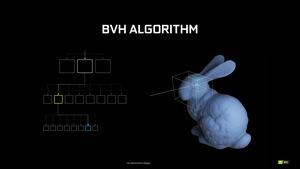

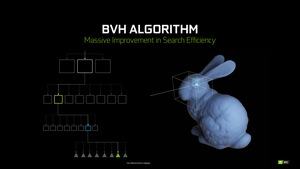

Один из способов выборки примитивов - Bounding Volume Hierarchy (BVH). В случае BVH сцена разбивается на все меньшие по размеру блоки, в которых присутствуют примитивы. Луч следует обрабатывать только с теми блоками, которые он проходит на пути к примитиву. Подход несколько напоминает воксели, которые NVIDIA использует для Voxel Global Illumination (VXGI). BVH представляет собой дерево, в котором можно видеть, какой именно блок и, в конечном итоге, примитив следует учитывать для расчета трассировки лучей.

BVH на классических архитектурах GPU может выполняться только программно. Таким образом, потоковым процессорам приходится на каждый луч выполнять несколько тысяч инструкций, в том числе многочисленные циклы для поиска блоков и, в конечном итоге, примитива. Только после нахождения примитива можно выполнять шейдинг луча.

Именно здесь на помощь приходят ядра RT. Они содержат специальные функциональные блоки SFU (Special Function Units), оптимизированные под поиск нужных блоков и примитива, с которым пересекается луч. Потоковый процессор принимает задачу, после чего передает ее ядру RT, которое возвращает результат потоковому процессору - и последний может выполнять рендеринг дальше по конвейеру.

Нормализованная производительность трассировки лучей

Вместе с трассировкой лучей NVIDIA представила новый способ расчета производительности, названный гигалучи в секунду. Который показывает количество рассчитанных лучей в единицу времени. Теперь вы знаете, что, в отличие от тех же TFLOPS, данное значение не фиксировано для GPU, а зависит от типа и сложности сцены.

Для сравнения NVIDIA использует видеокарту GeForce GTX 1080 Ti, которая обеспечивает вычислительную производительность 1,1 гигалуч/с. GeForce RTX 2080 Ti показывает не меньше 10 гигалучей/с, иногда даже более 12. Но как можно сравнить эти значения? Ответ прост: никак! Даже на идентичных сценах результат немного варьируется, поэтому можно говорить лишь о приближенном значении. NVIDIA также указывает, что трассировка лучей на архитектуре Pascal в описанном выше виде вообще невозможна.

Небольшой пример: на сцене Claybook, которая была рассчитана с помощью трассировки лучей, Radeon RX Vega 64 показывает производительность 4,88 гигалучей/с. Однако выполнялся только расчет Primary Ray Tracing, при добавлении теней (Shadow Rays) результат будет чуть ниже. Игра в случае Primary Ray Tracing в разрешении 4K шла плавно - 60 fps, но то же самое верно и для GeForce GTX 1080 Ti. Однако в данном случае результат 5 гигалучей/с не имеет смысла сравнивать со спецификациями NVIDIA. Добавьте еще лучи для расчета отражений и преломлений, которые тоже изменят производительность в гигалучах/с.

Гибридный конвейер рендеринга

С архитектурой Turing NVIDIA не стала представлять чистую трассировку лучей, выбрав гибридный конвейер рендеринга. Он предусматривает разные технологии для расчета прямых и непрямых теней, отражений, окружающего освещения, прозрачности и т.д.

Некоторые методики опираются на хорошо известный процесс растеризации, часть используют трассировку лучей или опираются на вычисления. Поэтому нагрузку уже нельзя полностью распределить по потоковым процессорам. NVIDIA приводит следующие результаты.

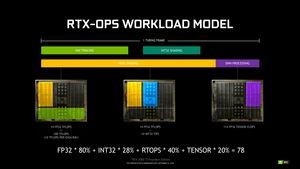

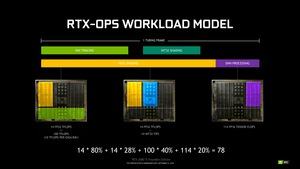

Процесс рендеринга сцены состоит из множества вычислений. Которые распределяются по блокам FP32, INT32, ядрам RT и Tensor. В среднем, задействуется примерно 80% ресурсов FP32, 28% ресурсов INT32, 40% ресурсов ядер RT и 20% ядер Tensor. В результате мы получаем 78 RTX OPS - если принять подобную меру производительности гибридного рендеринга.

Поддержка технологии RTX в Battlefield V является пилотной, она призвана показать, что нам можно ждать от грядущих игр. На Gamescom нам представилась возможность познакомиться с версией Battlefield V RTX Alpha и пообщаться с разработчиками DICE. Как мы узнали, технология NVIDIA RTX требует более высокой производительности CPU, чем игра без поддержки RTX. DICE планирует изменить системные требования соответствующим образом, подразумевается от восьми до 12 потоков. Только такой процессор сможет плавно выводить игру с поддержкой RTX. Через несколько дней мы опубликовали новость, в которой поделились впечатлениями от знакомства с Battlefield V RTX Alpha.

Трассировка лучей, которую сегодня так активно обсуждают, лишь одна из составляющих новых эффектов и технологий, ставших возможными с RTX. Как указывает DICE, игровой движок работает с интерфейсом Microsoft DXR, через который обеспечиваются эффекты RTX и трассировка лучей.

DICE на данный момент использует технологию NVIDIA RTX только для реализации Specular Reflections, то есть отражений в игре. Она позволяет просчитать прозрачные объекты, а также отражения на полупрозрачных поверхностях. Отражения рассчитываются не с помощью BVH, а через так называемые Boxprojected Cubemaps, которые также используются для рендеринга. В Battlefield V нет эффектов зеркало-в-зеркале, которые мы видели, например, в Atomic Heart.

Как указывает DICE, игра пока находится на этапе оптимизации. Разработчики получили финальные видеокарты Turing лишь после выставки Gamescom, до этого приходилось работать с видеокартами Volta. Поскольку у них отсутствовали ядра RT, то и влияние аппаратного ускорения было сложно оценить. Цель заключается в достижении 60 fps с эффектами RTX в разрешении UHD. Игра RTX Alpha, показанная на Gamescom, шла с достаточной производительностью в разрешении 1080p, хотя мы обратили внимание на выпадение кадров.

Чтобы получить плавный геймплей, без оптимизации производительности не обойтись. В распоряжении разработчиков имеются несколько средств. Например, разрешение для трассировки лучей может быть меньше, чем для растеризации - возможны промежуточные этапы. Ядра RT интегрируются в конвейер рендеринга асинхронно, что тоже можно оптимизировать. Сама DICE видит потенциал оптимизации 30% и выше. Но точно сказать пока затрудняется.

Во время проведения фазы Open Beta разработчики DICE продолжают работать над оптимизациями. Они заняты поиском объектов, которые вызывают наибольшие проблемы рендеринга, на которых снижается частота кадров. И разработчики могут их убрать при необходимости. Увидим ли мы игру Battlefield V в том виде, в каком она демонстрировалась со сцены NVIDIA - вопрос открытый.

На данный момент выход Battlefield V запланирован на 20 ноября. То есть видеокартам GeForce RTX придется два месяца обходиться без поддержки RTX в играх. Мы будем ждать новых игр с поддержкой RTX и, конечно, поделимся впечатлениями с нашими читателями.

Помимо Battlefield V, поддержка RTX будет в следующих играх:

- Assetto Corsa Competizione

- Atomic Heart

- Battlefield V

- Control

- Enlisted

- Justice

- JX3

- MechWarrior 5: Mercenaries

- Metro Exodus

- ProjectDH

- Shadow of the Tomb Raider

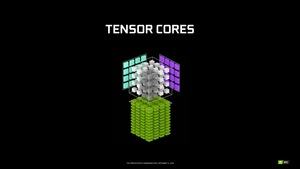

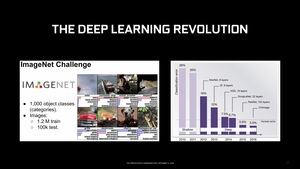

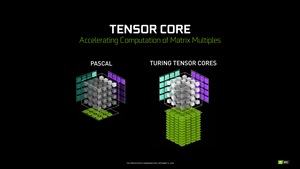

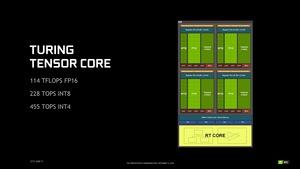

Для поддержки трассировки лучей и других функций в архитектуру Turing перешли ядра Tensor, знакомые по архитектуре Volta. В архитектуре Volta ядра Tensor ускоряли работу с сетями глубокого обучения. То же самое верно и для архитектуры Turing, но не только. Но сначала позвольте рассказать о ядрах Tensor и пояснить их принцип работы.

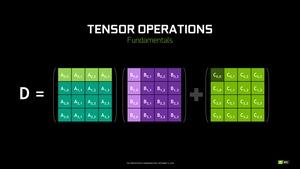

Ядра Tensor разрабатывались для выполнения матричного умножения. Напомним, что матричное умножение (BLAS GEMM) является весьма важным компонентом тренировки и инференса сетей глубокого обучения. Матричные операции подразумевают выборку значений матриц A и B (выполнение сложения и умножения), после чего результат будет записываться в матрицу C. Для матриц 4x4 данные операции выполняются для всех 16 полей. В архитектуре Pascal для выполнения упомянутых операций использовались блоки FP32. Отличия по выполнению показаны на следующем видеоролике.

В случае архитектуры Volta ядра Tensor ориентированы на тренировку сетей глубокого обучения и инференс, поэтому они могут выполнять вычисления FP16 и FP32. Что касается архитектуры Turing, то здесь фокус уже на инференсе, поэтому ядра Tensor также оптимизированы под операции FP16, INT8 и INT4.

У ядер Tensor имеются собственные пути прохождения данных в SM, их можно полностью выключать через стробирование частоты, когда они не нужны. Соответственно, если ядра Tensor в играх не задействованы, то и энергию они не потребляют.

NVIDIA в максимальном варианте GPU TU102 указывает 576 ядер Tensor, но у GeForce RTX 2080 мы получаем только 544 ядра Tensor. NVIDIA указывает вычислительную производительность 110 TFLOPS FP16 для игр и обработки изображений. Что касается вычислений INT8, соответствующая производительность составляет 220 TOPS, для вычислений INT4, применение которым пока не найдено, мы получаем 440 TOPS.

Для чего NVIDIA использует ядра Tensor?

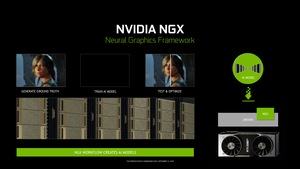

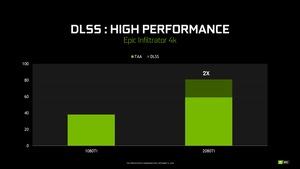

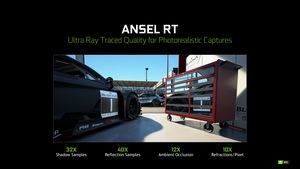

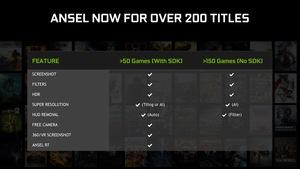

На данный момент ядра Tensor в архитектуре Turing используются NVIDIA для двух целей: подавление шумов и новый режим суперсемплинга под названием Deep Learning Super Sampling (DLSS).

Подавление шумов - неизбежная задача при выполнении трассировки лучей. Несмотря на все аппаратные ресурсы, которые выполняют трассировку, полностью рассчитать 3D-сцену методом трассировки лучей не представляется возможным. Поэтому речь пока идет только о частичной трассировке лучей. Что же тогда делать с областями, которые не будут рассчитаны с помощью трассировки лучей?

В таких случаях на помощь приходит шумоподавление. Оно необходимо для областей, которые не полностью охвачены трассировкой лучей, и с помощью шумоподавления к ним добавляется отсутствующая информация. За добавление информации отвечает натренированная сеть глубокого обучения. Как раз запросы в эту сеть (инференс) готовят ядра Tensor.

Для подавления шумов NVIDIA пришлось разработать новую систему, а именно Neural Graphics Framework (NGX), за взаимодействие с которой и отвечают ядра Tensor. Сеть NGX может использоваться не только для подавления шумов, но и для других сфер. Например, она может отвечать за искусственный интеллект в играх, а также распознавать читы геймера. Или озвучивать NPC. Пока что сфера Neural Graphics останется наиболее важным сценарием данной сети.

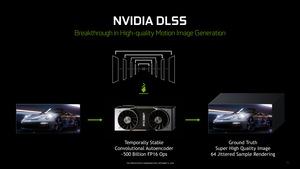

Deep Learning Super Sampling (DLSS)

Почти во всех играх полученный в процессе рендеринга кадр выводится не сразу, а проходит через ряд этапов пост-обработки, например, через временное сглаживание Temporal Anti-Aliasing (TAA). Данный алгоритм опирается на потоковые процессоры и сравнивает два последовательных кадра, используя векторы движения. TAA не всегда работает идеально, приводя к появлению артефактов. Без TAA этих артефактов не было, но в таком случае пришлось бы играть без сглаживания. Здесь как раз на помощь приходит Deep Learning Super Sampling.

Вскоре после представления линейки GeForce RTX 20, NVIDIA раскрыла дополнительную информацию о технологии Deep Learning Super Sampling. Чтобы протестировать DLSS, NVIDIA провела тренировку сети глубокого обучения на собственном суперкомпьютере SATURN V. Движок Temporal Stable Convolutional Autoencoder выполняет 500 млрд. операций FP16 в секунду, он создает 64 семпла для идеального сглаживания картинки. Каждый семпл был рассчитан по алгоритму суперсемплинга 64x (64xAA). То есть вместо обработки каждого пикселя на потоковом процессоре один раз, приходилось выполнять операцию 64 раза, каждую с небольшим смещением. Все это требует приличных вычислительных ресурсов, поэтому и использовался SATURN V.

Затем эти идеальные результаты в определенном виде передаются системе с видеокартой GeForce RTX. Кадры видеокарты сравнивается с идеальными образцами, за инференс как раз отвечают ядра Tensor видеокарты Turing. В будущем поддержку DLSS планируется расширить до DLSS 2X с дополнительными улучшениями.

Судя по имеющейся информации, данные для DLSS отсылаются на игровой компьютер через утилиту GeForce Experience, они занимают всего несколько мегабайт. Конечно, предварительно придется установить утилиту GeForce Experience и зарегистрироваться.

Сеть NGX будет получать информацию от игрового движка, обрабатывать ее через инференс, после чего передавать информацию обратно игровому движку в оптимизированном виде.

Если верить NVIDIA, отличий между 64x Super Sampling и DLSS 2x по качеству картинки нет. Качество картинки DLSS 2x значительно лучше TAA. На мероприятии NVIDIA мы провели прямое сравнение и не обнаружили визуальных отличий.

Что касается производительности, NVIDIA указывает на двукратный прирост, сравнивая GeForce GTX 1080 Ti с TAA и GeForce RTX 2080 Ti с DLSS. Впрочем, GeForce RTX 2080 Ti с TAA тоже дает прирост производительности около 50%. Так что на самом деле преимущество DLSS по сравнению с TAA несколько ниже.

NVIDIA предлагает еще несколько скриншотов, которые позволяют сравнить качество картинки.

DLSS первое время будет поддерживаться следующими играми:

- Ark: Survival Evolved

- Atomic Heart

- Dauntless

- Final Fantasy XV

- Fractured Lands

- Hitman 2

- Islands of Nyne

- Justice

- JX3

- Mechwarrior 5: Mercenaries

- PlayerUnknown’s Battlegrounds

- Remnant: From the Ashes

- Serious Sam 4: Planet Badass

- Shadow of the Tomb Raider

- The Forge Arena

- We Happy Few

Но сеть NGX может использоваться и в других сценариях. Примером можно назвать AI Super Rez, когда картинка с низким разрешением будет выводиться в намного более высоком разрешении. Еще одна сфера применения - AI Slow-Mo. Сеть глубокого обучения будет преобразовывать видео с частотой кадров 30 fps в ролик Slow Motion на 240 FPS. Алгоритм сравнивает два последовательных кадра и рассчитывает движение объектов. Соответственно, через интерполяцию создаются промежуточные кадры. Не так давно мы как раз публиковали соответствующую новость.

Технология Mesh Shading в архитектуре Turing меняет подход к расчету геометрии. 3D-сцены с большим количеством объектов обычно упирались в ограничения расчета геометрии, что приводило и к чрезмерной нагрузке на процессор.

Уже давно для выбора уровня детализации объектов используется LOD (Level of Detail), зависящий от расстояния. Большинство игровых движков используют фиксированный LOD, иногда его можно менять. Но параметр не динамический, то есть он не зависит от сложности 3D-сцены.

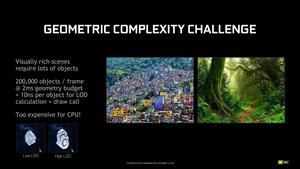

Для сцены с 200.000 объектами на расчет геометрии остается только 2 мс - если требуется получить 60 FPS. Что приводит к 10 нс на каждый объект, включая необходимые расчеты LOD и вызовы Draw Call. В результате современные 3D-движки могут оперировать 20.000-30.000 объектами на сцене, не больше. С адаптивным LOD и Mesh Shading геометрия сцены может включать 200.000 объектов.

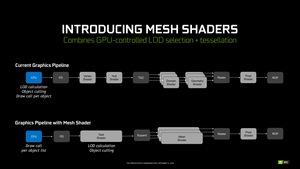

Mesh-шейдеры архитектуры Turing могут гибко определять LOD в зависимости от загрузки движка рендеринга. Теперь процессору уже не придется выполнять вычисления для фиксированного LOD и object culling (отсечение невидимых объектов) - ему достаточно лишь выполнить процедуры Draw Call. В данном случае шейдеры (Vertex и Hull) объединены в Task-шейдеры, которые и отвечают за выбор LOD и отсечение невидимых объектов. Шейдеры доменов и геометрии теперь объединены в Mesh-шейдеры.

NVIDIA показала работу новых Mesh-шейдеров на демонстрации.

На сцене присутствовало между 200.000 и 300.000 астероидов. В зависимости от LOD, на самом высоком уровне геометрии число полигонов достигает почти 4.000.000.000.000. Что вряд ли по силам современным аппаратным ресурсам.

Архитектура Turing теперь может определять, какие объекты следует рассчитывать, а какие - нет. Также динамически регулируется и LOD. NVIDIA показала используемые LOD через разные цвета. Синий, фиолетовый и синий соответствуют высокому LOD, зеленый и желтый - низкому LOD. Изменение LOD в зависимости от расстояния выполняется динамически, незаметно для геймера.

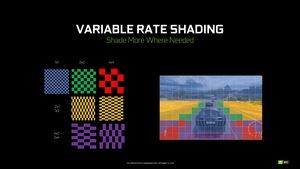

Variable Rate Shading

Variable Rate Shading - еще одна новая функция шейдеров, призванная повысить эффективность расчетов.

По сути, Variable Rate Shading является технологией сжатия на уровне затенения. Мы уже знакомы с технологиями сжатия музыки (MP3), изображений (JPG), да и архитектуры GPU опираются на сжатие памяти. Как правило, в процессе шейдинга каждый пиксель просчитывается каждый раз. Но подобная точность требуется далеко не всегда. Многие участки на протяжении нескольких кадров не меняются.

В случае Variable Rate Shading кадр разделяется на несколько блоков. В зависимости от контента кадра и скорости, с которой объект меняется на следующих кадрах, блоки можно выводить с разной детализацией шейдинга. Собственно, в этом и заключается принцип работы VRS.

Начнем с Content Adaptive Shading, здесь анализируется содержимое кадра. Motion Adaptive Shading оценивает движения и изменения, которые происходят при переходе от одного кадра к другому. В случае Foveated Rendering играет роль ракурс взгляда пользователя очков VR, поскольку только область в фокусе должна выводиться с полной детализацией. И здесь как раз работает Lens Optimized Rendering, оптимизирующий рендеринг под очки VR. Конечно, здесь отчетливо заметны следы Simultaneous Multi Projection архитектуры Pascal.

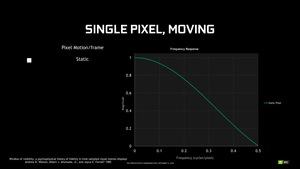

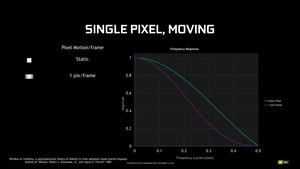

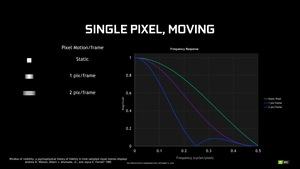

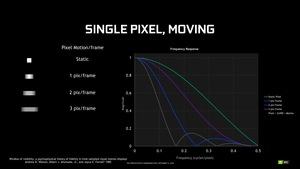

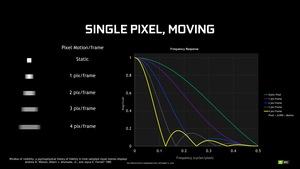

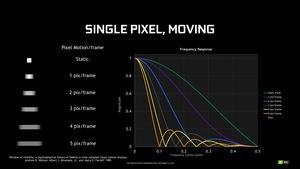

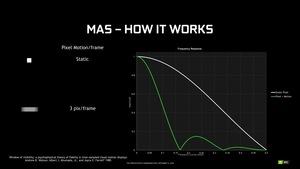

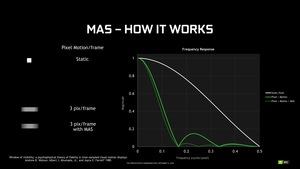

Motion Adaptive Shading опирается на то, что движущиеся объекты воспринимаются человеческим глазом с меньшим разрешением.

Реализация Motion Adaptive Shading хорошо показана на демонстрации Wolfenstein 2: The New Colossus.

Технология Motion Adaptive Shading призвана устранить визуальные отличия в качестве картинки. Первые секунды демонстрации геймер включает и выключает Motion Adaptive Shading. Какие-либо отличия по качеству картинки не видны.

Затем NVIDIA активирует оверлей для индикации областей, на которых технология Motion Adaptive Shading активна. Если оверлея нет, то и Motion Adaptive Shading на данном участке не работает. А цвет указывает на размер блока.

NVIDIA ожидает, что Motion Adaptive Shading обеспечит прирост производительности порядка 20 процентов в играх, которые работали на уровне 60 fps.

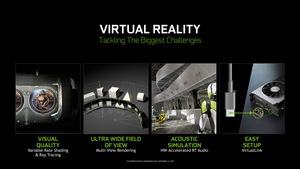

Variable Rate Shading даст разработчикам еще больше возможностей. Например, это коснется multi-view rendering, который не будет ограничиваться одним viewport. Также и Foveated Rendering выиграет от поддержки Variable Rate Shading.

В случае Foveated Rendering области в фокусе геймера будут просчитываться с более высокой детализацией, чем периферийные участки. Данный подход позволит сэкономить значительные ресурсы в приложениях виртуальной реальности.

Texture Space Shading

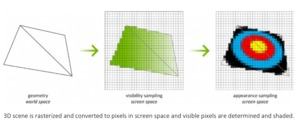

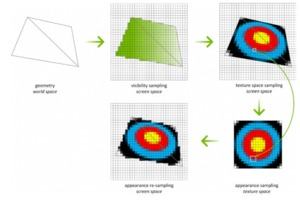

Технология Texture Space Shading (TSS) позволит повторно использовать результаты операций шейдинга. TSS сохраняет результаты шейдинга в процессе расчетов, и они могут повторно использоваться в качестве текселей в пространстве текстуры. Пиксели, на которые наложены текстуры, переносятся из пространства экрана в пространство текстуры. В случае TSS семплы в пространстве экрана и в пространстве текстуры обрабатываются независимо и остаются разделенными. В результате можно получить пространственную и временную избыточность для рендеринга.

Благодаря TSS две наиболее важные операции Visibility Sampling (растеризация и Z-тестирование) и Appearance Sampling (шейдинг) отделены друг от друга, что позволяет выполнять их на разных этапах и/или в разное время.

Процесс шейдинга больше не привязан к пространству пикселей экрана, он может выполняться в пространстве текстуры. Геометрия по-прежнему обрабатывается растеризатором и передается в пространство экрана в виде пикселей, здесь же выполняются операции Visibility Sampling. Но от шейдинга в пространстве экрана уже можно отказаться, поскольку достаточно перенести соответствующие тексели на пиксели экрана.

NVIDIA представила видеокарты Founders Editions в линейке GeForce RTX 20 с более высокими тактовыми частотами по сравнению с эталонными вариантами. Что в линейке Founders Edition встречается впервые, а также объясняет смену позиционирования собственных видеокарт NVIDIA.

| Модель | Частота Boost |

| GeForce RTX 2080 Ti Founders Edition | 1.635 МГц |

| GeForce RTX 2080 Ti - карты партнеров | 1.545 МГц |

| GeForce RTX 2080 Founders Edition | 1.800 МГц |

| GeForce RTX 2080 - карты партнеров | 1.710 МГц |

| GeForce RTX 2070 Founders Edition | 1.710 МГц |

| GeForce RTX 2070 - карты партнеров | 1.620 МГц |

NVDIA выставляет частоты Boost своих видеокарт Founders Edition на 90 МГц выше соответствующих частот видеокарт партнеров. Впрочем, для партнеров указана лишь минимальная планка. Наверняка они выставят более высокие тактовые частоты Boost.

С поколением Pascal видеокарты Founders Edition должны были стать "премиальными" продуктами с высококачественными компонентами. Но заводской разгон был оставлен на откуп партнерам. Сейчас все изменилось: видеокарты Founders Edition в линейке GeForce RTX 20 выделяются и премиальными компонентами, и высоким качеством изготовления, и повышенными тактовыми частотами. NVIDIA добавила к видеокартам заводской разгон.

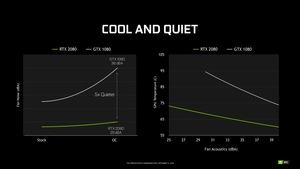

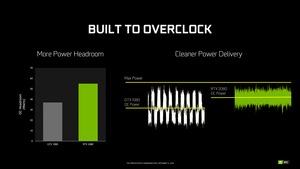

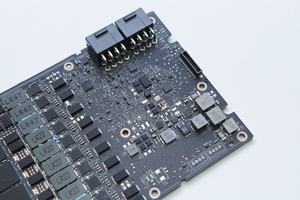

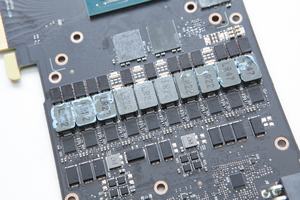

Также произошли изменения в подсистеме питания, в результате видеокарты должны разгоняться лучше.

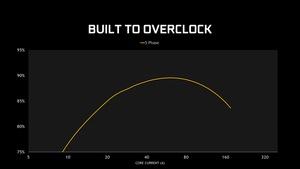

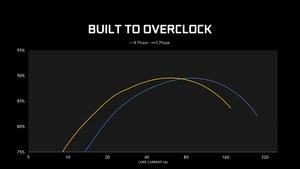

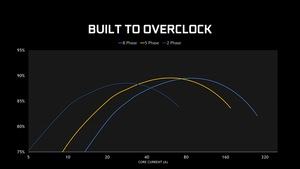

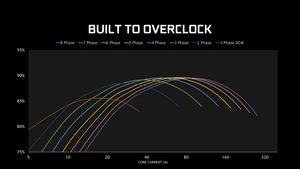

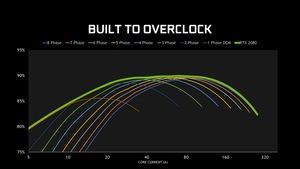

По сравнению с GeForce GTX 1080 NVIDIA увеличила запас мощности разгона с почти 40 до 55 Вт. Кроме того, заявлено о более качественном напряжении. NVIDIA привела графики эффективности в зависимости от числа фаз.

Чем больше фаз доступно, тем более эффективным будет питание при высоких токах. Но при этом пик эффективности сдвигается в сторону увеличения нагрузки, и при малой нагрузке эффективность будет ниже, чем в случае небольшого числа фаз.

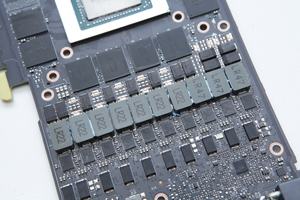

Поэтому NVIDIA разработала подсистему питания GeForce RTX 2080 и GeForce RTX 2080 Ti таким образом, чтобы она динамически включала и выключала фазы - в зависимости от требований по мощности. В результате мы получаем идеальную эффективность при любых нагрузках. В случае GeForce RTX 2080 подсистема питания опирается на 8 фаз, которые могут динамически включаться и выключаться. У GeForce RTX 2080 Ti мы получаем 13 фаз. Будет интересно посмотреть на результаты тестов энергопотребления.

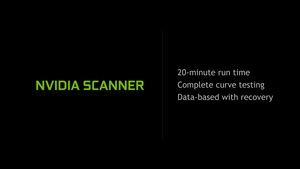

NVIDIA Scanner

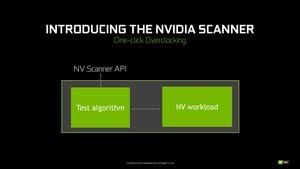

С новой линейкой видеокарт GeForce RTX 20 NVIDIA представила новый компонент интерфейса NV API, который используется такими программами, как EVGA Precision и MSI Afterburner для управления видеокартой и разгона.

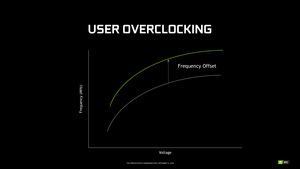

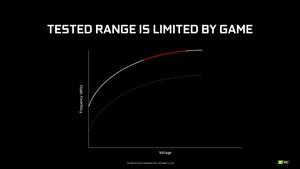

NV Scanner должен сократить время, которое уходит на разгон видеокарты. На мероприятии Turing Editors Day NVIDIA показала разгон GeForce RTX 2080 Ti Founders Edition до 2.113 МГц. Разгон был получен автоматически через функцию OC Scanner, которая напоминает поколение Pascal. Уже с видеокартами Pascal NVIDIA встроила в API GPU Boost алгоритмы, которые автоматически определяют максимальную частоту при разных уровнях напряжения, в результате получается кривая частот/напряжений.

Но в новом NV Scanner API появился собственный тест нагрузки, который призван значительно упростить разгон. Раньше стабильность проверяли на одной или нескольких играх. Но если игра A шла стабильно, с игрой B могли возникнуть проблемы. Тест нагрузки NV Scanner позволяет решить эту проблему. Причем нагрузка состоит из математических расчетов, а не вывода 3D. Тест проводится внутри видеокарты, в результате можно не опасаться за зависание компьютера или "вылет" драйвера. Конечно, подобный тест сокращает время поиска оптимальных результатов разгона.

NVIDIA Scanner требует порядка 20 минут на полный проход, после чего для каждого уровня напряжения будет выдана максимальная частота разгона. И без каких-либо "вылетов". Если верить NVIDIA, система будет работать стабильно в 99% игр. Впрочем, если пользователь хочет себя обезопасить, то можно выставить частоту на несколько мегагерц меньше. Смогут ли все видеокарты GeForce RTX 2080 Ti работать на 2.150 МГц - неизвестно. Как утверждает NVIDIA, NV Scanner в данном виде можно использовать и с видеокартами на GPU Pascal. Но эту функцию NVIDIA пока не реализовала. Однако технических препятствий нет. Что ж, будем ждать, когда новый NV Scanner начнет поддерживать поколение Pascal.

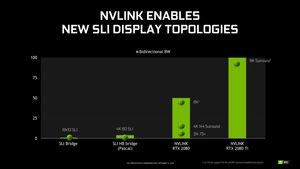

NVLink уже довольно давно утвердился на профессиональном сегменте. С помощью коммутатора NV можно соединить до 16 ускорителей Tesla V100 с пропускной способностью 100 Гбайт/с на каждый. Видеокарты Quadro тоже оснащаются интерфейсом NVLink, цель заключается в более быстром обменен данными.

В игровом сегменте конфигурации Multi-GPU несколько выпали из фокуса внимания разработчиков игр и GPU. Поэтому нас несколько удивило, что NVIDIA добавила к видеокартам GeForce RTX 2080 и GeForce RTX 2080 Ti подобную поддержку. Но вместо SLI здесь вновь используется NVLink. Однако видеокарте GeForce RTX 2070 придется обойтись без поддержки multi-GPU.

Классический способ SLI Alternate Frame Rendering (AFR) будет работать через NVLink - данные в кадровом буфере второй видеокарты будут передаваться на первую через NVLink. Теоретически подобная система получит в два раза больше памяти, чем с одной видеокартой. С двумя GeForce RTX 2080 Ti на 11 Гбайт общий объем составит 22 Гбайт. В случае двух GeForce RTX 2080 и 8 Гбайт - уже 16 Гбайт. Разработчики плагина V-Ray из Chaos Group как раз продемонстрировали удвоение видеопамяти.

Но важно понимать в данном отношении, что только часть памяти на видеокарте с тем же GPU подключается со скоростью 616 Гбайт/с, остальная память работает намного медленнее - 100 Гбайт/с, поскольку упирается в пропускную способность NVLink. Добавьте к этому еще и дополнительные задержки.

Впрочем, NVLink обеспечивает явное преимущество по сравнению с ранее использовавшимся SLI. Мостик SLI первого поколения работал на 1 Гбайт/с, последующие мостики SLI HB увеличили пропускную способность до 4 Гбайт/с, в результате стала возможной поддержка SLI в разрешении 4K с частотой выше 60 Гц. Интерфейс NVLink на видеокарте GeForce RTX 2080 работает на 50 Гбайт/с, в случае GeForce RTX 2080 Ti с двумя NVLink мы получаем 100 Гбайт/с, соответственно.

Но даже высокая пропускная способность NVLink не может устранить микроподергивания, характерные для конфигураций SLI и теперь NVLink. Если верить NVIDIA, единственным способом решения проблемы остается G-Sync. NVLink, унаследованный от видеокарт Quadro RTX, остается недогруженным. Для SLI пропускной способности более чем достаточно, поэтому NVIDIA говорит о новых сценариях использования NVLink на видеокартах GeForce. Но что именно здесь подразумевается - не разъясняется.

Мостики NVLink будут доступны с разными длинами - в зависимости от количества слотов между двумя видеокартами. Но цена в случае длины в три или четыре слота будет одинаковой - €84,99.

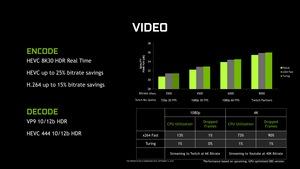

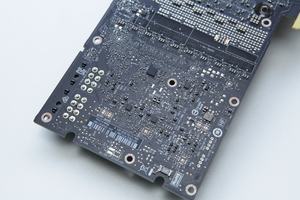

MС архитектурой Turing NVIDIA представила новый движок видео и дисплея. Он разработан с учетом отображения контента в разрешении до 8K (7.680 x 4.320 пикселей). Все видеокарты поддерживают DisplayPort 1.4a, что позволяет выводить 8K на 60 Гц. Стандарт также поддерживает VESA Display Stream Compression (DSC) 1.2.

Видеокарты на GPU Turing могут одновременно работать с двумя дисплеями 8K на 60 Гц. Также поддерживается VirtualLink. Новый движок дисплея имеет встроенную функцию Tone Mapping в конвейере HDR. Таким образом, дисплеи SDR и HDR всегда обеспечат идеальную цветопередачу. Данная спецификация рекомендована ITU-R в стандарте BT.2100.

Кодер NVENC поддерживает H.265 (HEVC) в разрешении 8K на 30 FPS. Кроме того, аппаратно поддерживаются HEVC YUV444 10/12b HDR на 30 FPS, H.264 8K и VP9 10/12b HDR. Поэтому для данных разрешений и часто программного кодирования/декодирования не требуется, ресурсы CPU не задействуются.

NVIDIA стала первым производителем видеокарт, реализовавшим поддержку VirtualLink. Благодаря VirtualLink шлемы VR можно подключать к ПК одним кабелем. И питание, и сигнал дисплея для шлема VR будут передаваться по единственному кабелю. Инициатива была разработана совместно NVIDIA, AMD, VALVE, Microsoft и Oculus. Компании представили стандарт для универсального подключения шлема VR. Физически был выбран порт USB Type C и соответствующий кабель, но используется другой протокол передачи. Конечно, весьма важен поток данных, который будет передаваться через VirtualLink. Дисплеи шлемов VR продолжают увеличивать разрешение, поэтому и пропускная способность продолжит расти. Также и для дополненной реальности и отслеживания положения используются камеры высокого разрешения. Другие сенсоры отслеживания здесь уже не принципиальны.

Консорциум VirtualLink разработал собственный стандарт передачи USB Type C Alternate Mode. Он опирается на шесть каналов передачи данных. Четыре выделены под DisplayPort HBR 3. А два оставшихся оставлены для USB 3.1 Gen 2. Кроме того, на шлем VR может подаваться питание мощностью до 27 Вт.

Пропускная способность составит в сумме 42,4 Гбит/с (10 Гбит/с на USB 3.1 Gen 2 + 32,4 Гбит/с на DisplayPort HBR 3) - она предназначена для передачи видео и данных. Добавьте к этому 27 Вт, которые должна гарантировать видеокарта. Поэтому NVIDIA пришлось увеличить тепловой пакет на соответствующее значение.

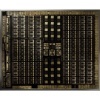

На разработку архитектуры Volta NVIDIA затратила больше $2 млрд. В случае архитектуры Turing затраты такие же или даже выше. NVIDIA утверждает, что на разработку архитектуры ушло пять лет. А первые наработки в сфере аппаратного ускорения были начаты еще 10 лет назад. Первые кристаллы были получены около года назад. Причем в течении 24 часов инженерные образцы уже работали на тестовых платах - довольно редкий случай, как утверждает NVIDIA.

GPU на архитектуре Turing оказались самыми крупными, когда-либо устанавливавшимися на игровые видеокарты. NVIDIA пока не перешла на 7-нм техпроцесс, поскольку он еще не готов. Но компания использовала наработки, полученные при производстве GPU Volta по 12-нм техпроцессу. GPU GV100, представленный в мае 2017, довольно крупный - 815 мм². Он содержит 21,1 млрд. транзисторов. GPU GP102 на GeForce GTX 1080 Ti заметно меньше по размеру - 471 мм² и 12 млрд. транзисторов.

Крупный GPU Turing (TU102) ненамного уступает. NVIDIA также производит чип по 12-нм техпроцессу на мощностях TSMC. Число транзисторов составляет 18,6 млрд. NVIDIA указывает размер GPU 754 мм². В случае Turing GPU TU104 среднего размера мы получаем 13,6 млрд. транзисторов на площади 545 мм². Младшая видеокарта GeForce RTX 270 опирается на TU106 GPU с 10,8 млрд. транзисторов площадью 445 мм².

Как обычно, NVIDIA не предоставляет информации о выходе годных кристаллов при производстве столь крупных чипов. Поскольку GPU Volta производится на конвейере уже больше года, NVIDIA вместе с TSMC наверняка накопила опыт.

| Модель | GeForce RTX 2080 Ti | GeForce RTX 2080 | GeForce RTX 2070 |

| GPU | TU102 | TU104 | TU106 |

| Технические спецификации | |||

|---|---|---|---|

| Архитектура | Turing | Turing | Turing |

| Техпроцесс | TSMC 12 нм | TSMC 12 нм | TSMC 12 нм |

| Число транзисторов | 18,6 млрд. | 13,6 млрд. | 10,8 млрд. |

| Площадь кристалла | 754 мм² | 545 мм² | 445 мм² |

| GPCs | 6 | 6 | 3 |

| TPCs | 34 | 23 | 18 |

| SMs | 68 | 46 | 36 |

| CUDA Cores / SM | 64 | 64 | 64 |

| CUDA Cores / GPU | 4.352 | 2.944 | 2.304 |

| Tensor Cores / SM | 8 | 8 | 8 |

| Tensor Cores / GPU | 544 | 368 | 288 |

| Ядра RT | 68 | 46 | 36 |

| Кэш L2 | 5.632 кбайт | 4.096 кбайт | 4.096 кбайт |

| Register File Size / SM | 256 кбайт | 256 кбайт | 256 кбайт |

| Register File Size / GPU | 17.408 кбайт | 11.776 кбайт | 9.216 кбайт |

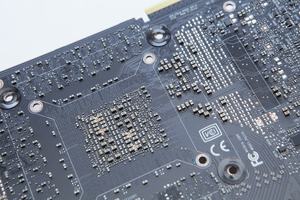

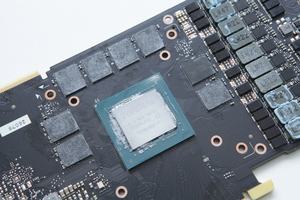

TU102 GPU опирается на шесть кластеров Graphics Processing Clusters (GPC), 36 кластеров Texture Processing Clusters (TPC) и 72 Streaming Multiprocessors (SM). Но чип в GeForce RTX 2080 Ti имеет только 34 активных TPC. Каждый GPC содержит растровый движок и шесть TPC, каждый TPC - два SM. Наконец, в каждом SM работают 64 текстурных блока, восемь ядер Tensor, имеются 256 кбайт регистров, четыре текстурных блока и 96 кбайт памяти L1/Shared.

TU104 GPU оснащен шестью GPC, но только 24 TPC и 48 SM. Один TPC на GeForce RTX 2080 выключен, поэтому мы получаем не 3.072 потоковых процессоров, а только 2.944.

Самый младший чип Turing на сегодня, а именно TU106, оснащен тремя GPC, 18 TPC и 36 SM в полной конфигурации. NVIDIA для видеокарты GeForce RTX 2070 использовала полную версию, в случае TU102 и TU104 GPU полная версия встречается только на видеокартах Quadro RTX.

Интересно сравнить размеры чипов с поколением Pascal.

| Чип | TU102 | GP100 | GP102 | TU104 | GP104 | TU106 | GP106 |

| Площадь кристалла | 754 мм² | 610 мм² | 471 мм² | 545 мм² | 314 мм² | 445 мм² | 200 мм² |

| Количество транзисторов | 18,6 млрд. | 15,3 млрд. | 12 млрд. | 13,6 млрд. | 7,2 млрд. | 10,8 млрд. | 4,4 млрд. |

Самый крупный GPU Pascal GP102 на видеокартах GeForce (GeForce GTX 1080 Ti и Titan Xp) имеет площадь 471 мм² и содержит 12 млрд. транзисторов. При этом он все равно уступает по размерам и числу транзисторов TU104 на GeForce RTX 2080, причем даже TU106 на GeForce RTX 2070 ненамного меньше. Что еще раз подчеркивает позиционирование новых видеокарт, GeForce RTX 2080 Ti не только по цене ближе к ранее выпущенным моделям Titan. TU104 GPU и видеокарта GeForce RTX 2080 примерно соответствует уровню GeForce GTX 1080 Ti. А "младший" Turing GPU TU106 уже нельзя назвать решением начального уровня, причем не только из-за цены.

Вычислительная производительность в числах

Разные варианты GPU приводят к разной вычислительной производительности. До сих пор мы упоминали гигалучи в секунду, а также 110 TFLOPS FP16, 220 TOPS INT8 и 440 TOPS INT4. Но GPU TU102 содержит 144 блока FP64 - по два на SM. Производительность FP64 по отношению к FP32 составляет 1/32, хотя у архитектуры Volta она равна 1/2. Впрочем, NVIDIA все равно добавила и в архитектуру Turing блоки FP64, чтобы поддержка вычислений была хотя бы на базовом уровне.

Ниже приведены результаты вычислительной производительности видеокарт GeForce RTX 20 Founders Edition.

| Модель | GeForce RTX 2080 Ti | Quadro RTX 6000 | GeForce RTX 2080 | Quadro RTX 5000 | GeForce RTX 2070 |

| GPU | TU102 | TU102 | TU104 | TU104 | TU106 |

| Вычислительная производительность | |||||

|---|---|---|---|---|---|

| FP32 TFLOPS | 14,2 | 16,3 | 10,6 | 11,2 | 7,9 |

| INT32 TIPS | 14,2 | 16,3 | 10,6 | 11,2 | 7,9 |

| FP64 TFLOPS | 0,445 | 0,510 | 0,331 | 0,348 | 0,246 |

| FP16 TFLOPS | 28,5 | 32,6 | 21,2 | 22,3 | 15,8 |

| FP16 Tensor TFLOPS с умножением FP16 | 113,8 | 130,5 | 84,8 | 89,2 | 63 |

| FP16 Tensor TFLOPS с умножением FP32 | 56,9 | 130,5 | 42,4 | 89,2 | 31,5 |

| INT8 Tensor TOPS | 227,7 | 261 | 169,6 | 178,4 | 126 |

| INT4 Tensor TOPS | 455,4 | 522 | 339,1 | 356,8 | 252,1 |

Quadro RTX 8000 опирается на тот же GPU TU102, но объем памяти GDDR6 составляет в два раза выше, поэтому мы не стали добавлять видеокарту в таблицу. Производительность зависит от тактовых частот и варианта расширения GPU. Видеокарты Quadro RTX могут выполнять больше операций умножения на ядрах Tensor, поэтому мы получаем в два раза более высокую производительность по сравнению с игровыми моделями GeForce.

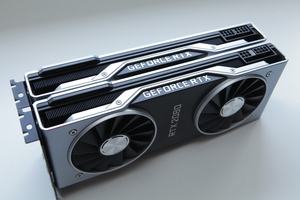

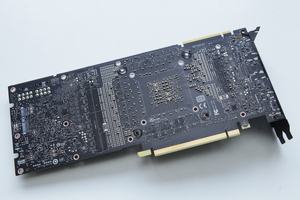

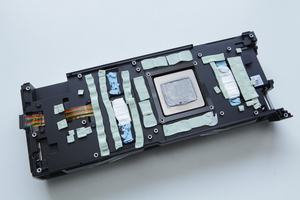

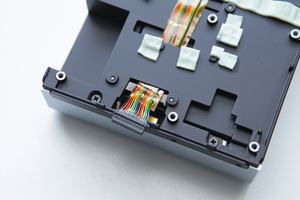

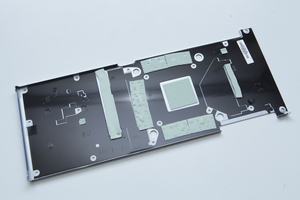

Перейдем к видеокартам. В нашу тестовую лабораторию поступила GeForce RTX 2080 Ti и "младшая" GeForce RTX 2080. Ниже приведены технические спецификации GeForce GTX 1080 Ti. Мы также добавили фотографий GeForce RTX 2080 Ti. Более подробно мы рассмотрим видеокарты при публикации полного теста.

| Модель | GeForce RTX 2080 Ti | GeForce GTX 1080 Ti |

| Цена | 95.990 руб. 1.259 евро |

от 50 тыс. рублей 639 евро |

| Технические спецификации | ||

|---|---|---|

| Архитектура | Turing | Pascal |

| GPU | TU102 | GP102 |

| Техпроцесс | TSMC 12 нм | TSMC 16 нм |

| Число транзисторов | 18,6 млрд. | 12 млрд. |

| Потоковые процессоры | 4.352 | 3.584 |

| Тензорные ядра | 544 | - |

| Ядра RT | 68 | - |

| Текстурные блоки | 272 | 224 |

| ROPs | 88 | 88 |

| Частота GPU (базовая) | 1.350 МГц | 1.480 МГц |

| Частота GPU (Boost) | 1.635 МГц | 1.582 МГц |

| RTX-OPS | 78 TRTX-OPS | - |

| Гигалучей/с | 10 Глуч/с | - |

| Частота памяти | 1.750 МГц | 1.375 МГц |

| Тип памяти | GDDR6 | GDDR5X |

| Объем памяти | 11 GB | 11 GB |

| Ширина шины памяти | 352 бит | 352 бит |

| Пропускная способность | 616 Гбайт/с | 484 Гбайт/с |

| TDP | 260 Вт | 250 Вт |

| Доп. питание | 2x 8-конт. | 1x 8-конт. + 1x 6-конт. |

| SLI/NVLink | 2x NVLink | SLI |

Видеокарта GeForce GTX 1080 Ti вышла через десять месяцев после GeForce GTX 1080. В случае же GeForce RTX 20, NVIDIA выбрала иной путь. GeForce RTX 2080 Ti доступна сразу же. Обратите внимание на сходство GeForce RTX 2080 Ti с ранее вышедшими моделями Titan.

Сравнение между GeForce GTX 1080 Ti и GeForce RTX 2080 Ti показывает преимущество первой по потоковым процессорам - их на 21% больше. Базовая частота GeForce RTX 2080 Ti существенно ниже GeForce GTX 1080 Ti. Но по частоте Boost обе видеокарты весьма близки. Переход с памяти GDDR5X на GDDR6 позволил увеличить пропускную способность на 27%. Интерфейс памяти и объем идентичны.

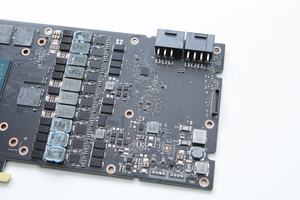

Тепловой пакет увеличился на 10 Вт, но 30 Вт можно отнести на поддержку VirtualLink. В любом случае, NVIDIA подает на видеокарту дополнительное питание по двум 8-контактным штекерам.

За GeForce RTX 2080 Ti следует и GeForce RTX 2080. Ниже приведены технические спецификации и фотогалерея. Подробности мы опубликуем на следующей неделе.

| Модель | GeForce RTX 2080 | GeForce GTX 1080 |

| Цена | 63.990 руб. 849 евро |

от 34 тыс. рублей 470 евро |

| Технические спецификации | ||

|---|---|---|

| Архитектура | Turing | Pascal |

| GPU | TU104 | GP104 |

| Техпроцесс | TSMC 12 нм | TSMC 16 нм |

| Число транзисторов | 13,6 млрд. | 7,2 млрд. |

| Потоковые процессоры | 2.944 | 2.560 |

| Тензорные ядра | 368 | - |

| Ядра RT | 46 | - |

| Текстурные блоки | 184 | 160 |

| ROPs | 64 | 64 |

| Частота GPU (базовая) | 1.515 МГц | 1.506 МГц |

| Частота GPU (Boost) | 1.800 МГц | 1.683 МГц |

| RTX-OPS | 60 TRTX-OPS | - |

| Гигалучей/с | 8 Глуч/с | - |

| Частота памяти | 1.750 МГц | 2.500 МГц |

| Тип памяти | GDDR6 | GDDR5X |

| Объем памяти | 8 GB | 8 GB |

| Ширина шины памяти | 256 бит | 256 бит |

| Пропускная способность | 448 Гбайт/с | 320 Гбайт/с |

| TDP | 225 Вт | 180 Вт |

| Доп. питание | 1x 8-конт. + 1x 6-конт. | 1x 8-конт. |

| SLI/NVLink | 1x NVLink | SLI |

Как можно видеть при сравнении GeForce RTX 2080 и GeForce GTX 1080, NVIDIA использует прежнее обозначение моделей xx80, но существенно расширяет архитектуру для прежних ступеней. Что видно по цене. За GeForce RTX 2080 Founders Edition NVIDIA просит €850. В случае GeForce GTX 1080 Founders Edition в момент анонса видеокарта стоила €789. Сегодня ее можно приобрести за €470, в России цены начинаются от 34 тыс. рублей.

GeForce RTX 2080 получила на 15% больше потоковых процессоров. Также отметим новые тензорные ядра и ядра RT. Базовые частоты почти идентичны, но у GeForce RTX 2080 частота Boost составляет не ниже 1.800 МГц. В случае GeForce GTX 1080 Founders Edition нижняя планка была заметно ниже - 1.683 МГц. Объем памяти идентичен - 8 Гбайт. Ширина интерфейса памяти - 256 бит. Благодаря переходу на GDDR6 вместо GDDR5X удалось увеличить пропускную способность памяти на 40%.

GeForce RTX 2080 потребляет чуть больше энергии. NVIDIA указывает 225 Вт, но 30 Вт здесь можно отнести на VirtualLink. Вместо одного 8-контактного разъема к видеокарте теперь подключаются по одному 8- и 6-контактному.

Конечно, вопрос высоких цен GeForce RTX 20 нельзя обойти стороной. На первый взгляд напрашивается сравнение GeForce GTX 1080 Ti и GeForce RTX 2080 Ti, ниже по уровню расположены GeForce RTX 2080 и GeForce RTX 2070, но не все так просто. Все же NVIDIA позиционирует GeForce RTX 2080 Ti на уровень видеокарт Titan.

В любом случае, ниже приведены цены линейки Founders Edition в евро по сравнению с предыдущим поколением на момент объявления:

| GeForce RTX 2080 Ti | GeForce GTX 1080 Ti | |

| Цена | 95.990 руб. 1.259 евро |

819 евро |

| GeForce RTX 2080 | GeForce GTX 1080 | |

| Цена | 63.990 руб. 849 евро |

789 евро |

| GeForce RTX 2070 | GeForce GTX 1070 | |

| Цена | 47.990 руб. 639 евро |

499 евро |

Как можно видеть, NVIDIA увеличила цены, в некоторых случаях весьма существенно. В линейке GeForce GTX 1080 Ti ценник дороже €1.000 получали лишь high-end видеокарты с альтернативным дизайном, сейчас NVIDIA позиционирует сюда все варианты GeForce RTX 2080 Ti. GeForce RTX 2080 и GeForce GTX 1080 по цене довольно близки. "Начальный" уровень в линейке GeForce RTX 20, а именно GeForce RTX 2070, будет стоить €639.

Но что получит покупатель за свои деньги, причем немалые?

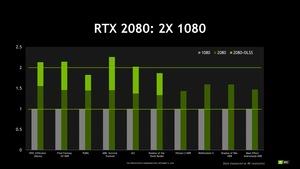

Пока что мы не можем говорить о результатах наших тестов. Поэтому будем оперировать информацией, предоставленной NVIDIA. Для GeForce RTX 2080 Ti NVIDIA заявляет прирост производительности 35-50% по сравнению с GeForce GTX 1080 Ti. Для GeForce RTX 2080 мы получим 30-50% по сравнению с GeForce GTX 1080. Данный прирост был получен на основе различных игр в разрешении UHD. И пока что мы не можем ни подтвердить, ни опровергнуть заявление NVIDIA.

Но NVIDIA к преимуществам новых видеокарт относит не только более высокую производительность потоковых процессоров. Не стоит забывать об интеграции дополнительных аппаратных блоков RT и Tensor. Память GDDR6 тоже работает быстрее. Конечно, более крупный кристалл GPU обходится NVIDIA дороже предыдущих моделей Pascal. Но оправдывает ли он цену €1.250 - уже другой вопрос.

Многое здесь зависит от того, будут ли задействованы дополнительные аппаратные блоки или RTX/DXR в ближайшие месяцы и в перспективе. NVIDIA объявила поддержку RTX в различных играх, но она пока не добавлена. Проблема "курицы и яйца" для разработчиков была решена с помощью видеокарт Volta и позднее Turing (линейка Quadro RTX), но для конечных пользователей все не так очевидно. Похоже, что геймерам придется довериться NVIDIA и заплатить за новые функции авансом.

Конечно, NVIDIA пытается получить прибыль, поэтому и цены компания выставляет соответствующие. Но, в конечном итоге, последнее слово остается за потребителем. Будут ли геймеры согласны со столь высокой ценой? Все же технология RTX пока не в том состоянии, чтобы отдавать за нее любые деньги. В любом случае, у NVIDIA остается группа энтузиастов, которые готовы платить самую высокую цену за новые технологии. Все же процессоры дороже €1.000 на рынке имеются, и их покупают.

У NVIDIA пока все идет хорошо, но вот будущее AMD внушает опасения. На данный момент AMD не может полноценно конкурировать с NVIDIA на high-end сегменте, разве что цену сбивать. С новой линейкой GeForce RTX 20 отставание AMD на high-end сегменте будет еще больше, а до выхода на этот рынок Intel остается еще пара лет. Вполне возможно, что NVIDIA на ближайшие годы будет единственным игроком на рынке high-end видеокарт.

Видеокарты готовились давно, но для тестов ситуация не самая благоприятная. NVIDIA всеми силами попыталась предотвратить утечки результатов. Видеокарты мы получили только вчера, да и партнеры NVIDIA до последнего момента не имели доступа к GPU. Также имеется проблема с драйверами, отсутствие которых не позволило провести осмысленные тесты ранее даже с инженерными образцами видеокарт.

Пока что дать оценку новым видеокартам сложно. Или она будет очень сильно зависеть от персонального отношения к трассировке лучей. NVIDIA выбрала весьма интересный путь, который зависит от успеха производства. GPU площадью почти 800 мм² производить очень сложно, себестоимость очень высокая даже на оптимизированном 16-нм техпроцессе (по сути, 12-нм техпроцесс, который упоминают NVIDIA и TSMC для GPU Turing, им и остается). Больше потоковых процессоров, шире архитектура, еще больше блоков - такой путь могла бы выбрать NVIDIA. Но где-то пять лет назад NVIDIA поняла, что он тупиковый. Специальные вычислительные блоки, такие как ядра Tensor, доказали свою значимость в вычислениях на GPU. В случае ядер RT мы получили аппаратное ускорение в определенных сценариях. Так что здесь NVIDIA просто следует неизбежности.

Конечно, столь сильная ориентация на трассировку лучей нравится далеко не всем, тем более что обходится она весьма дорого. Эффекты, которые дает трассировка лучей на данном этапе, нельзя назвать революционными. Но в будущем все может измениться. У первого поколения видеокарт производительности для полной трассировки лучей попросту недостаточно, да и игр пока нет. Так что делать выводы пока рано. Однако NVIDIA вряд ли пустит миллиардные инвестиции "на ветер", компания интенсивно работает со своими партнерами по разработке игр, чтобы трассировка лучей не оказалась пустым звуком.

Видеокарты GeForce RTX без RTX, ядер Tensor и RT попросту не имеют смысла. Если у вас уже есть видеокарта GeForce GTX 1080 Ti, то вряд ли имеет смысл переходить на GeForce RTX 2080 Ti, исходят только из прироста производительности потоковых процессоров. Все же о соотношении цена/производительность забывать не стоит.

В любом случае, стоит дождаться следующей недели, когда мы опубликуем собственные тесты. Пока что рекомендуем самостоятельно решить, насколько интересны вам новые функции RTX.