В прошлом году на своей конференции Google I/O компания представила первое поколение Tensor Processing Units или TPU для краткости. На вчерашнем пленарном докладе I/O 2017 было представлено уже второе поколение. Подобный прогресс наглядно иллюстрирует потребность в новом аппаратном обеспечении для ускорения расчетов глубокого обучения и искусственного интеллекта. Все же производительности нынешних процессоров и GPU для подобных задач уже давно не хватает. Поэтому многие производители разрабатывают собственные решения.

TPU является специализированным чипом ASIC (Application Specific Integrated Circuit), специально ориентированным на машинное обучение TensorFlow. Первое поколение TPU обеспечивало производительность 91,75 TOPS (тераопераций в секунду) на матрице из 256 × 256 блоков умножения/сложения MAC с частотой 700 МГц. TPU работают с 8-битными целыми числами, которые как раз используются при обработке запросов в сети глубокого обучения (inferencing).

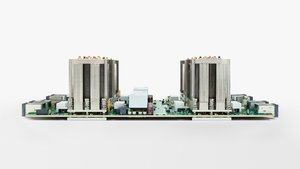

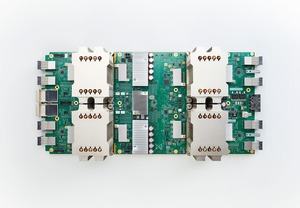

Напрямую сравнивать вычислительную производительность между первым и вторым поколением проблематично, поскольку новые TPU могут работать и с числами с плавающей запятой. В 16-битных вычислениях производительность составляет 180 TFLOPS. На фотографиях Google показана плата с четырьмя чипами. Пока не совсем понятно, заявлены 180 TFLOPS для каждого из процессоров или для всей платы.

Каждый TPU использует интерконнект, разработанный Google, но подробностей не приводится. Интерконнект работает с высокой пропускной способностью, что очень важно для тренировки сетей глубокого обучения. 64 TPU формируют TPU Pod с вычислительной производительностью 11,5 PFLOPS.

Для сравнения: у Intel Xeon E5-2699 v3 производительность составляет 2,6 TFLOPS, у NVIDIA Tesla K80 – 2,8 TFLOPS. Конечно, на GPU Technology Conference 2017 NVIDIA представила новые вычислительные модули Tesla V100 на GPU GV100, которые используют так называемые ядра Tensor. С помощью этих специальных ядер Tesla V100 достигает производительности 120 TFLOPS. Пока не совсем понятно, при каком энергопотреблении Google может получить заявленные 180 TFLOPS на втором поколении TPU.

Google также привела первые сравнения производительности. На тренировку сети глубокого обучения по машинному переводу уходит полный день на 32 самых быстрых GPU, но на восьми TPU нового поколения задача будет выполнена к полудню.

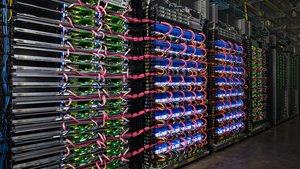

Google будет использовать новые TPU в своих облачных решениях. Тестеры смогут получить платный доступ к альфа-версии проекта. В виртуальных машинах TPU работают вместе с CPU Skylake и GPU NVIDIA, их можно выделять по мере необходимости для задач. В рамках проекта TensorFlow Research Cloud Google добавит 1.000 новых TPU бесплатно.