Конференция Hot Chips проходит каждый год в Купертино (Калифорния). В этом году в ней вновь участвовали различные компании, рассказавшие о своих разработках в сфере микропроцессоров. AMD рассказала об архитектуре Vega, Intel – о своих ускорителях Xeon Phi, Google – об использовании GDDR5 или HBM для своих TPU, а IBM – о процессорах z14 с крупным объемом кэша. Ниже мы привели краткий итог по каждой презентации. Некоторые детали мы обсудим в отдельных статьях.

AMD фокусируется на виртуализации и криптографии

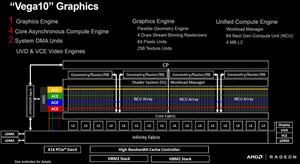

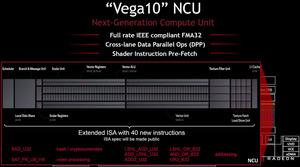

AMD на Hot Chips рассказала о своей архитектуре Vega. Мы уже опубликовали соответствующие подробности в нашем обзоре Radeon RX Vega 56 и Vega 64. Но на конференции AMD акцентировала две сферы использования - виртуализацию и криптографию.

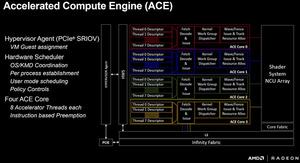

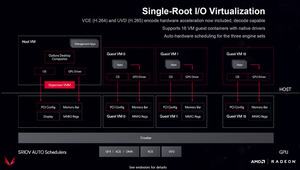

Архитектура Vega в случае GPU Vega 10 поддерживает до 16 виртуальных окружений через SR-IOV (Single Root I/O Virtualization). Вычислительные ресурсы и память GPU распределяет динамически. Кроме числа VM важную роль играет модель лицензирования. В отличие от NVIDIA, здесь нет дополнительных затрат, виртуализация доступна на любой профессиональной видеокарте с GPU Vega без доплаты. На Siggraph AMD показала Project 47, стойку из 20 Epyc 7601 и 80 Radeon Instinct MI25. 80 видеокарт поддерживают по 16 VM каждая, что позволяет увеличить число виртуальных машин до 1.280.

Кроме виртуализации на своей презентации AMD подчеркнула специальные инструкции Vega ISA. Опять же, AMD упомянула использование данных инструкций для вычислений хэшей в скриптах майнинга криптовалют. Многие геймеры отнеслись к этой новости критически, поскольку из-за майнеров цены на видеокарты увеличились. Здесь архитектура Vega ничего не меняет.

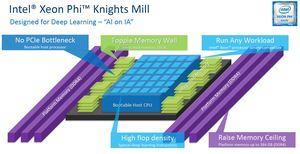

Intel ориентирует Xeon Phi Knights Mill на машинное обучение

Intel на данный момент работает над двумя направлениями вычислений. Ускорители Xeon Phi ориентированы на вычисления в целом, но Intel решила выделить глубокое или машинное обучение, разработав для них специальные FPGA.

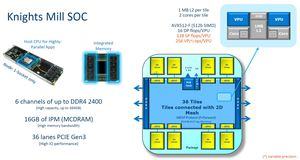

Но на Hot Chips Intel показала, что следующее поколение Xeon Phi сможет эффективно ускорять операции машинного обучения. Для этого было принято несколько мер. Во-первых, максимальный объем памяти был удвоен до 384 Гбайт. Память DDR4-2400 будет работать по шести каналам, также на чипе установлены дополнительные 16 Гбайт MCDRAM. Для подключения чипа доступны 36 линий PCI Express 3.0.

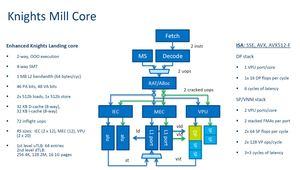

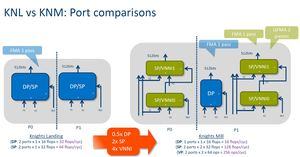

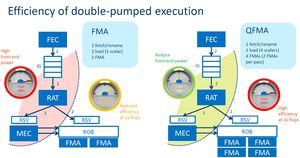

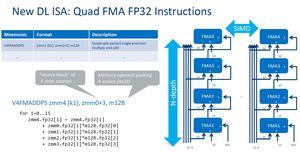

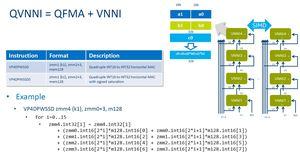

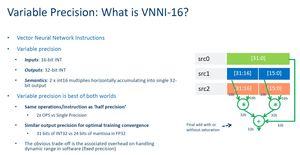

Knights Mill будет состоять из 36 плиток (тайлов), соединенных 2D-сеткой. На каждой плитке установлены два ядра, совместно использующие 1 Мбайт кэша L2. Каждое ядро может обрабатывать до четырех потоков. В результате мы получаем 72 ядра и 288 потоков. Intel добавила несколько инструкций, ускоряющий вычисления глубокого обучения. На презентации Intel обещает четырехкратный прирост.

Поставка первых ускорителей Knights Mill начнется в четвертом квартале. Ближе к этому времени мы должны узнать подробности.

Google TPU с HBM работают существенно быстрее

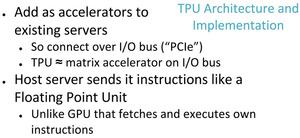

Подобно другим компаниям, активно работающим в сфере глубокого обучения, Google вкладывает немалые средства в разработку аппаратных компонентов. Первое поколение TPU (Tensor Processing Unit) уже показало существенный прирост вычислительной производительности, будучи ASIC. В этом году Google представляет второе поколение, которое тоже даст серьезный прирост производительности.

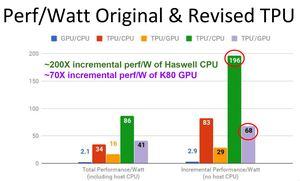

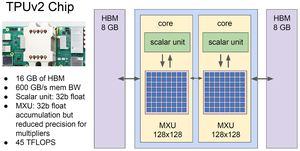

Если первое поколение опиралось на память DDR3, то для второго поколения Google выбирала между памятью GDDR5 и HBM. Учитывалась не только вычислительная производительность, но соотношение производительности на ватт. В итоге Google остановилась на HBM. Благодаря переходу на HBM обеспечивается увеличение производительности вместе с улучшением эффективности.

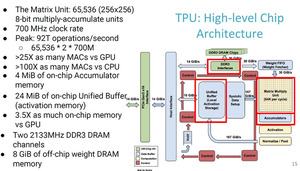

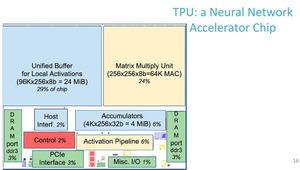

Новые TPU могут также выполнять и операции с плавающей запятой. В 16-битных вычислениях блоки TPU 2 обеспечивают производительность 180 TFLOPS. У первого поколения при использовании матрицы 256×256 MAC (multiplier/accumulator) на 700 МГц мы получали производительность 91,75 TOPS (Tera Operations per Second). Здесь подразумеваются 8-битные операции для обработки запросов (inferencing). Второе поколение также справляется и со сценариями тренировки сетей глубокого обучения.

IBM z14: десять ядер и много кэша

Еще в июле IBM объявила процессоры z14, содержащие 10 ядер и 30 Мбайт кэша на ядро. На конференции Hot Chips компания представила больше подробностей. Стойка будет состоять не из нескольких одинаковых процессоров, а из оптимизированных z14 под разные задачи. В частности, в подобной стойке будут использоваться шесть CP (central processor) и один SC (system controller). Четыре стойки формируют мейнфрейм.

Каждый процессор работает с тактовой частотой до 5,2 ГГц. Как упоминалось выше, IBM установила большое количество кэша. А именно 128-кбайт кэш инструкций и данных L1, 2- или 4-Мбайт кэш инструкций и данных L2. Также установлен и кэш L3 объемом 128 Мбайт. В зависимости от нагрузки, TDP процессора может составлять до 500 Вт. Так что без водяного охлаждения не обойтись. Каждый процессор может адресовать до 32 Тбайт памяти. Отметим и память IBM Virtual Flash емкостью от 1,5 до 6 Тбайт. Для подобной системы очень важны межсоединения, здесь тоже доступно несколько опций. Можно использовать современное поколение InfiniBand. Или сетевые соединения вплоть до 1000 BaseT на 1.000 Гбит/с.

Пару слов стоит сказать о производстве. IBM производит чипы по 14-нм техпроцессу (14HP-SOI) на заводах Global Foundries. z14 имеет площадь 696 мм² и содержит 6,1 или 9,7 млрд. транзисторов в зависимости от модели.

Для IBM z14 разработана операционная система z/OS V2.3. О цене подобных систем пока нет информации, конфигурации будут создаваться специально под заказчиков.