Переход на новый техпроцесс и новую архитектуру GPU всегда интересует ИТ-журналистов. AMD уже перешла на 28-нм техпроцесс вместе с новой архитектурой "Southern Islands", настала очередь и Nvidia. В Интернете уже несколько недель ходили слухи о следующем эволюционном шаге Nvidia. Часть этих слухов действительно оказалась правдой, но всё же слухи есть слухи, поэтому и сбылись не все предсказания. Сегодня, наконец, Nvidia представила первую видеокарту GeForce GTX 680 на новом поколении Kepler. В статье мы рассмотрим новую архитектуру и технологии, оценим результаты тестов, а также поговорим о том, сможет ли флагман Nvidia достойно конкурировать с Radeon HD 7970.

Переход на новый техпроцесс и новую архитектуру GPU всегда интересует ИТ-журналистов. AMD уже перешла на 28-нм техпроцесс вместе с новой архитектурой "Southern Islands", настала очередь и Nvidia. В Интернете уже несколько недель ходили слухи о следующем эволюционном шаге Nvidia. Часть этих слухов действительно оказалась правдой, но всё же слухи есть слухи, поэтому и сбылись не все предсказания. Сегодня, наконец, Nvidia представила первую видеокарту GeForce GTX 680 на новом поколении Kepler. В статье мы рассмотрим новую архитектуру и технологии, оценим результаты тестов, а также поговорим о том, сможет ли флагман Nvidia достойно конкурировать с Radeon HD 7970.

Nvidia выставила высокую планку с видеокартой GeForce GTX 680. А именно соотношение производительность на ватт должно улучшиться в два раза по сравнению с предшественником. Кроме того, производительность тесселяции тоже должна вырасти примерно в четыре раза. В качестве доказательства Nvidia прилагает собственные тесты, но мы всё же привыкли верить измерениям нашей тестовой лаборатории.

Команда разработчиков "Kepler" была сформирована ещё в 2007 году, с того момента началась работа над новыми технологиями. В нашей статье мы рассмотрим SMX, GPU Boost, FXAA, TXAA и адаптивную VSynch, а также и некоторые другие технологии новой архитектуры.

Но перед тем как мы погрузимся в различные технические детали, позвольте представить сравнительную таблицу с новинкой GeForce GTX 680, собственными видеокартами Nvidia предыдущего поколения и конкурирующими моделями от AMD.

| NVIDIA GeForce GTX 570 | NVIDIA GeForce GTX 580 | NVIDIA GeForce GTX 680 | AMD Radeon HD 7950 | AMD Radeon HD 7970 | |

|---|---|---|---|---|---|

| GPU | GF110 | GF110 | GK104 | Tahiti PRO | Tahiti XT |

| Техпроцесс | 40 нм | 40 нм | 28 нм | 28 нм | 28 нм |

| Число транзисторов | 3 млрд. | 3 млрд. | 3,54 млрд. | 4,3 млрд. | 4,3 млрд. |

| Площадь кристалла | 530 мм² | 530 мм² | 294мм² | 365 мм² | 365 мм² |

| Тактовая частота GPU | 732 МГц | 772 МГц | 1006 МГц (Тактовая частота Boost: 1058 МГц) | 800 МГц | 925 МГц |

| Тактовая частота памяти | 950 МГц | 1000 МГц | 1502 МГц | 1250 МГц | 1375 МГц |

| Тип памяти | GDDR5 | GDDR5 | GDDR5 | GDDR5 | GDDR5 |

| Объем памяти | 1280 Мбайт | 1536 Мбайт | 2048 Мбайт | 3072 Мбайт | 3072 Мбайт |

| Ширина шины памяти | 320 бит | 384 бит | 256 бит | 384 бит | 384 бит |

| Пропускная способность памяти | 152 Гбайт/с | 192 Гбайт/с | 192,3 Гбайт/с | 240 Гбайт/с | 264 Гбайт/с |

| Модель шейдеров | 5.0 | 5.0 | 5.0 | 5.0 | 5.0 |

| Интерфейс PCI Express | 2.0 | 2.0 | 3.0 | 3.0 | 3.0 |

| DirectX | 11 | 11 | 11.1 | 11.1 | 11.1 |

| Количество потоковых процессоров | 480 (1D) | 512 (1D) | 1536 (1D) | 1792 (1D) | 2048 (1D) |

| Тактовая частота потоковых процессоров | 1464 МГц | 1544 МГц | 1006 МГц | 800 МГц | 925 МГц |

| Текстурные блоки | 60 | 64 | 128 | 112 | 128 |

| Конвейеры растровых операций (ROP) | 40 | 48 | 32 | 32 | 32 |

| Максимальное энергопотребление | 219 Вт | 244 Вт | 195 Вт | 200 Вт | 250 Вт |

| Минимальное энергопотребление | - | 30-32 Вт | 15 Вт | 2,6 Вт | 2,6 Вт |

| CrossFire/SLI | SLI | SLI | SLI | CrossFireX | CrossFireX |

Кроме перехода на новый техпроцесс, Nvidia разработала и внедрила новую архитектуру, так что перед нами не простое сокращение размера транзистора. Количество вычислительных процессоров было утроено, частота памяти существенно возросла, да и частота GPU превысила магическую планку в 1000 МГц. Добавим к этому такие технологии, как Boost Mode, а также желание Nvidia снизить энергопотребление high-end видеокарт до 195 Вт. Но подробнее об их работе мы расскажем ниже.

Последняя версия GPU-Z корректно считывает все спецификации видеокарты GeForce GTX 680.

В архитектуру "Kepler" NVIDIA внесла многочисленные изменения, которые мы рассмотрим ниже.

В поколении "Fermi" Nvidia уже использовала термин "потоковые мультипроцессоры/streaming multiprocessors" (SM). Всего в каждом SM присутствует 32 ядра или потоковых процессора. У GeForce GTX 680 или GPU GK104 NVIDIA использует блоки SMX со 192 ядрами. Таким образом, в каждом блоке было не только увеличено количество потоковых процессоров, но изменено соотношение между логикой управления и числом ядер в пользу увеличения числа последних.

GeForce GTX 680 содержит восемь блоков SMX, то есть количество ядер (потоковых процессоров) составляет 8 x 192 = 1536.

Блочная диаграмма "Kepler" захватывает и внешние области в виде интерфейса PCI Express 3.0 и четырёх контроллеров памяти, которые дают в сумме ширину шины памяти в 256 битов. Расчеты игровой графики выполняются на четырёх кластерах GPC (graphics processing clusters), каждый из которых состоит из пары блоков SMX.

Кэш L2 у архитектуры "Fermi" имел довольно значительный объём 768 кбайт, он позволял кластерам GPC обмениваться данными между собой. Nvidia решила уменьшить размер кэша L2 в архитектуре "Kepler" до 512 кбайт, но при этому увеличила его пропускную способность с 384 байт на такт до 512 байт на такт. Внутри блока SMX по-прежнему используется 64-кбайт кэш L1 или общая память.

Блок (или кластер) SMX состоит из 192 ядер, 16 текстурных блоков и движка Polymorph 2.0. Каждый кластер SMX оснащен движком PolyMorph 2.0, в результате чего у GK104 мы получаем 8 движков (напомним, что у GeForce GTX 580 их было 16). Движок PolyMorph 2.0 во многом отвечает за функции выборки вершин (Vertex Fetch), тесселяции (Tessellation), настройки атрибутов (Attributes Setup), трансформацию видимой области (Viewport Transform) и потоковый вывод (Stream Output). После прохождения кластера SMX и движка PolyMorph 2.0 результаты вычислений направляются на движок растеризации. На втором шаге тесселятор выполняет вычисления расположения поверхности, и в соответствие с дальностью от зрителя выполняется выбор соответствующего уровня детализации. Скорректированные значения затем возвращаются в кластер SMX, где над ними работают шейдеры домена (Domain Shader) и геометрии (Geometry Shader). Шейдер домена вычисляет финальное положение каждого треугольника, учитывая данные шейдера каркаса (Hull Shader) и тесселяторов. На данном этапе выполняется наложение карт смещения. Затем шейдер геометрии сравнивает вычисленные данные с видимыми объектами на сцене и высылает результаты обратно на движок тесселяции для финального прохода. Затем финальный шаг выполняет движок PolyMorph 2.0 - в виде трансформации видимой области и коррекции перспективы. Затем функция потокового вывода записывает вычисленные данные в память, они могут использоваться для дальнейших расчетов.

Движок Polymorph 2.0 во многом идентичен архитектуре "Fermi", но Nvidia вновь попыталась оптимизировать производительности тесселяции. Собственно, после того, как AMD значительно улучшила свой движок тесселяции в поколении "Southern Islands", у Nvidia не было другого выхода. По информации NVIDIA, GeForce GTX 680 обеспечивает до четырёх раз более высокую производительность тесселяции по сравнению с Radeon HD 7970.

Движок PolyMorph 2.0 в GPU GK104 обеспечивает очень детальными вычисленными значениями четыре параллельных движка растеризации. Сами движки растеризации разделены на три ступени. Первая ступень настройки краев (Edge Setup) отвечает за определение видимых треугольников и отсечение невидимых поверхностей (Back Face Culling). Каждая ступень Edge Setup за такт может вычислять точку, линию или треугольник. Вторая ступень растеризатора (Rasterizer) отвечает за определение значений соответствующего алгоритма сглаживания. Каждый блок растеризтора может вычислять восемь пикселей за так, в результате чего GPU GK104 может вычислять 32 пикселя за такт. Наконец, последняя ступень - блок Z-Cull сравнивает вычисленные пиксели с уже существующими в кадровом буфере. Если вычисленный пиксель геометрически находится позади пикселей в кадровом буфере, то он отбрасывается.

В архитектуре "Kepler" по сравнению с "Fermi" было серьёзно пересмотрено количество конвейеров растровых операций (ROP). В GK104 на каждый блок SMX приходится четыре конвейера ROP, что даёт 32. Для сравнения, у Nvidia GF110 используется 48 конвейеров ROP. В нынешнем GPU восемь конвейеров ROP комбинируются в разделы ROP, которых, если посчитать, будет в GK104 четыре. Каждый конвейер ROP может выдавать 32-битный целочисленный пиксель за такт. Кроме того, возможна обработка пикселей FP16 за два такта или FP32 за четыре такта.

Количество текстурных блоков было удвоено по сравнению с предшествующим GPU. В каждом блоке SMX используется 16 текстурных блоков, в результате чего у GK104 или GeForce GTX 680 мы получаем 128 блоков.

Интерфейс памяти претерпел значительные изменения. Каждый раздел ROP подключен по 64-битному интерфейсу памяти. В случае четырех разделов ROP мы получаем 256-битный интерфейс памяти. У GF110 имелось шесть разделов ROP, которые вместе составляли 384-битный интерфейс памяти.

В случае "Kepler" Nvidia изменила соотношение между вычислительными ядрами и логикой управления, а также и частоту работы ядер. Напомним, что графический процессор "Fermi" производился по технологии 40 нм и содержал 3 млрд. транзисторов. Потоковые процессоры работали на удвоенной тактовой частоте по сравнению с остальной частью GPU, то есть выполняли две вычислительные операции на такт GPU. Только через подобный подход "Hotclocks" Nvidia смогла обеспечить необходимую вычислительную производительность.

В случае "Kepler" NVIDIA опиралась на новый техпроцесс, что несколько решило проблему с большой площадью кристалла (техпроцесс уменьшился, количество транзисторов возросло незначительно).

Теперь мы бы хотели подчеркнуть различия между архитектурами "Fermi" и "Kepler" чуть более детально.

NVIDIA в блоке SMX не только увеличила количество ядер, но и оптимизировала выполнение инструкций. И в "Fermi", и в "Kepler" используются схожие аппаратные элементы для распределения инструкций на выбранные вычислительные ядра. Но в "Fermi" некоторые элементы использовались для проверки зависимости инструкций.

В "Kepler" компилятор решает проблему зависимости на программном уровне, и Nvidia смогла немного сэкономить на сложных аппаратных блоках.

Мы уже упомянули отказ от повышения частоты потоковых процессоров (Hotclocks). Причина кроется в том, что подобное решение было признано малоэффективным. Путём удвоения тактовой частоты потоковых процессоров Nvidia экономила площадь чипа, но вместе с тем получала более высокое энергопотребление. В приведённом выше примере на примере простой арифметической операции (на самом деле, двух операций) это хорошо заметно. Архитектура "Fermi" выполняла в два раза больше операций по отношению к количеству ядер, но "Kepler" обеспечивает более высокую производительность путём значительного увеличения количества ядер.

Кроме более высокого энергопотребления немаловажна и задействованная логика. В архитектуре NVIDIA "Fermi" требовалось в два раза больше конвейеров, чтобы наполнять потоковые процессоры данными. Из-за перехода на меньший техпроцесс Nvidia смогла увеличить количество ядер без повышения площади кристалла.

В поколении "Fermi" шейдеры могли одновременно работать со 128 текстурами из-за ограничений API DirectX 11. В случае "Kepler" шейдеры теперь могут напрямую адресовать текстуры в памяти с помощью так называемых таблиц привязки ("Binding Tables"). Таким образом, шейдер может обращаться к более чем миллиону текстур, что даёт превосходную детализацию и разнообразие сцен.

NVIDIA GeForce GTX 680 стала первой видеокартой с памятью GDDR5 и пропускной способностью 6 Гбит/с. NVIDIA особо акцентировала значение интеграции и физического дизайна. На рисунке выше показан график целостности сигнала. Чем больше будут два окна на графике, тем выше является качество сигнала.

Ключевой функцией нового поколения GPU является GPU Boost.

С видеокартой GeForce GTX 680 NVIDIA объявляет новую функцию GPU Boost. Функция базируется на энергопотреблении наиболее требовательных игр. Максимальная тактовая частота GPU Boost для GeForce GTX 680 составляет 1058 МГц при базовой тактовой частоте 1006 МГц. Базовая частота выставляется через PLL и делители частоты, при этом каждая GeForce GTX 680 сможет обеспечивать определённый минимальный прирост тактовой частоты GPU. А именно, каждая GeForce GTX 680 с помощью GPU Boost может работать на частоте 1058 МГц. Но большинство видеокарт GeForce GTX 680 заработают и на более высоких частотах, чем 1058 МГц. Режим Boost Mode опирается на максимальное энергопотребление 195 Вт. Оно зависит от тактовой частоты, но GeForce GTX 680 будет потреблять меньше заявленных 195 Вт.

Видеокарта постоянно измеряет уровень энергопотребления в реальном времени, частота может регулироваться с промежутками в 100 мс. Среди факторов, влияющих на частоту, присутствуют температура GPU, нагрузка на GPU и память, а также множество других показателей. Отметим, что за измерения отвечает отдельный электронный блок GeForce GTX 680, и производители могут интегрировать в дизайн блоки собственной разработки, их изменение программным способом не допускается. Технология GPU Boost будет присутствовать во всех видеокартах Nvidia поколения Kepler. Как можно предсказать, каждый экземпляр GeForce GTX 680 будет вести себя по-разному. Да и одна и та же видеокарта в разных условиях (например, с закрытым корпусом или с открытым) может достигать разных тактовых частот.

Nvidia при высокой нагрузке гарантирует работу на 1058 МГц.

Но если бюджет видеокарты позволяет, то она может работать на более высоких тактовых частотах. Например, наша тестовая видеокарта смогла нормально работать на 1110 МГц. Увеличение тактовой частоты и напряжения проводилось с шагами 13 МГц и 12,5 мВ, соответственно. Другие параметры у видеокарт могут отличаться (из-за разницы в производстве отдельных чипов GPU, охлаждения и т.д.), но по приросту производительности все карты вполне сравнимы.

Если профиль TDP позволяет, то видеокарт разгоняется и до 1110 МГц.

GPU Boost работает в обоих направлениях. Если нагрузка на видеокарту GeForce GTX 680 неполная, то частота работы автоматически снижается, видеокарта начинает работать на той частоте, которая требуется для выполнения задачи. Вместе со снижением напряжения это даёт уменьшение энергопотребления.

NVIDIA также позволяет гибко настраивать режим работы GeForce GTX 680. Если вам требуется фиксированная частота кадров, то можно установить уровень целевой частоты кадров ("frame rate target"), и через API напряжение и тактовая частота будут снижаться, чтобы видеокарта смогла выдавать заданную частоту кадров.

Технология GPU Boost не должна влиять на потенциал разгона. Для видеокарт GeForce GTX 680 уровень 1,2 ГГц достижим довольно легко. Но в случае разгона пользователь уже не поднимает частоту до какого-либо фиксированного уровня, а выставляет базовое значение и желаемый уровень Boost. Второй способ разгона заключается в подъёме бюджета энергопотребления. Если у видеокарты поднят бюджет энергопотребления, то и тактовые частоты она может выставлять соответственно выше.

На скриншотах выше можно увидеть, как GeForce GTX 680 позволяет настраивать свои частоты. Кроме того, вы можете изменять и напряжения. Но в случае нашего образца Nvidia зафиксировала максимальный уровень напряжения на 1175 мВ. В режиме бездействия тактовая частота снижается до 324 МГц, а напряжение - до 987 мВ. Чуть ниже мы вновь вернёмся к настройкам разгона и подробнее поговорим о функциях "Power Target" и "GPU Boost Offset".

Все видеокарты GeForce GTX 680 с эталонной системой охлаждения должны работать с базовой тактовой частотой 1006 МГц и частотой Boost 1058 МГц. Производители видеокарт с альтернативными системами охлаждения, которые дают меньший уровень температур, могут определять максимальную базовую частоту и режим Boost в BIOS, а также выполнять заводской разгон через выставление смещения.

Если вы хотите проверить возможности своей видеокарты, то можете обратиться к P-состояниям с соответствующими уровнями напряжения. NVIDIA для этих целей предлагает программу "NVAPITest".

NVIDIA определяет для GeForce GTX 680 четыре P-состояния. Каждое P-состояние опирается на несколько частотных доменов, для которых выставляются частоты GPU, памяти других компонентов.

P0 является наиболее производительным режимом с полными тактовыми частотами и напряжениями для GPU и памяти. То есть вы получите, как минимум, 1006 МГц для GPU и 1504 МГц для памяти. Режим P2 нацелен на конфигурации с несколькими мониторами, но он тоже предусматривает работу на полных тактовых частотах. Какое при этом выставляется напряжение - не очень понятно. Режимы P5 и P8 снижают тактовые частоты и напряжения при снижении нагрузки. Так, P5 предусматривает работу GPU на 540 МГц, а памяти - на 405 МГц. В режиме бездействия активно состояние P8, когда GPU работает на 324 МГц, а память - на 162 МГц.

"NVAPITest" считывает уровни напряжения, и мы действительно видим их изменение с шагом 12,5 мВ, как и обещает функция GPU Boost. Диапазон напряжений, который хранится в BIOS видеокарты, составляет от 0,987 В до 1,175 В. Максимум, который мы смогли выставить с помощью утилиты EVGA Precision, составил 1,150 В. Но в данном случае при срабатывании функции GPU Boost напряжение увеличивается до 1,175 В.

Некоторое время назад NVIDIA разработала новый режим сглаживания FXAA, в котором картинка сравнима с 4x MSAA по качеству, но работает этот режим быстрее на 60 процентов. FXAA на данный момент поддерживается в немногих играх, но в будущем поддержка должна появиться во всех играх благодаря включению режима в драйвере.

С объявлением GeForce GTX 680 и соответствующего драйвера, Nvidia анонсировала новый режим сглаживания. А именно TXAA, чьё качество картинки должно быть выше MSAA. Режим 1x TXAA должен обеспечивать более качественное сглаживание, чем 8x MSAA, а его вычислительная нагрузка должна находиться на уровне 2x MSAA.

TXAA сочетает преимущества MSAA и FXAA. TXAA базируется на методе временного супер-сэмплинга, но у него нет высоких требований к используемой памяти, как у классического метода супер-сэмплинга. TXAA должен поддерживаться в таких движках, как CryEngine 3, Unreal Engine 4 и будущих играх.

Техническая демонстрация Nvidia показывает существенные различия между разными способами сглаживания.

Сегодня вы можете выставлять сглаживание FXAA во всех играх с помощью драйвера. Как уже упомянуто выше, поддержка TXAA появится позднее.

Мы попытались сравнить разные режимы сглаживания по качеству картинки и по производительности.

Без AA / 8xMLAA / 8xFXAA

В прямом сравнении разницу между разными режимами сглаживания можно назвать весьма существенной. Конечно, режим сглаживания сказывается на производительности.

NVIDIA обещает для FXAA более высокое качество картинки, а также и более высокую производительность. Мы провели тесты в Skyrim в разных режимах сглаживания, результат приведен выше.

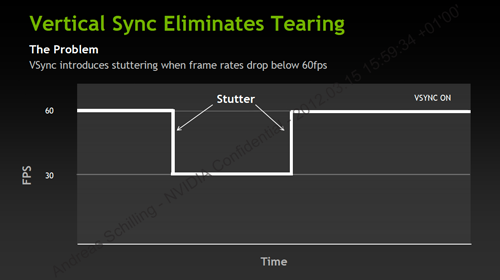

Под термином VSync скрывается технология, с которой всем приходится сталкиваться, иногда с проблемами.

В случае классической реализации VSync вы можете столкнуться с серьёзными подёргиваниями, если видеокарта не сможет поддерживать заданный уровень частоты кадров. Например, когда частота кадров падает с уровня 60 до 30 fps на 3D-сцене. Если подобные падения происходят часто и ниже "магического" порога, то сцена перестаёт выводиться плавно, наслаждение от игры оказывается уже не таким глубоким.

В случае адаптивной технологии VSync порог частоты кадров регулируется динамически, он не приводит к серьёзным падениям по качеству картинки. Кроме того, поддержка VSync выключается, если частота кадров падает ниже определённого ограничения. Вместе с тем полное выключение Vsync нежелательно, поскольку при этом на монитор может выводиться больше одного кадра одновременно, то есть кадры будут наслаиваться друг на друга, будет заметно размывание.

NVIDIA предлагает два режима адаптивной Vsync. С одной стороны, вы можете включить вертикальную синхронизацию и выставить её на уровень 60 fps. Если у монитора используется другая частота обновления, то вы можете выставить уровень на 30 fps.

С новыми GPU Nvidia "Kepler" к видеокарте можно подключать больше двух дисплеев. Конечно, к видеокартам "Fermi" тоже можно было подключать больше двух дисплеев, но Nvidia искусственно ограничивала подобную конфигурацию, поэтому производителям приходилось использовать специальные решения. Поэтому с новыми картами вы сможете использовать режим 3D Vision Surround. В случае GeForce GTX 680 мы получаем четыре выхода на мониторы, которые позволяют подключить подобную конфигурацию. Два двухканальных выхода DVI поддерживают максимальное разрешение 3840 x 2400 пикселей, как и выходы DisplayPort и HDMI в версии 1.4a.

Снимок слотовой заглушки видеокарт в нашей конфигурации с четырьмя подключенными дисплеями. Немногие пользователи смогут собрать подобную систему дома.

NVIDIA также поработала и над программным обеспечением. Панель задач Windows теперь ограничивается одним монитором, да и работа с окнами выполняется намного проще, чем раньше. Можно включить и функцию компенсации рамок дисплеев. Подобно AMD, Nvidia предлагает различные "специализированные" разрешения, которые предусматривают сочетание разных мониторов и коррекцию рамок.

В технических демонстрациях NVIDIA наглядно показывает новые функции.

У NVIDIA GeForce GTX 680 появился новый режим сглаживания. TXAA сочетает преимущества MSAA и FXAA. TXAA базируется на временном методе супер-сэмплинга, который менее требователен по памяти, чем классический метод супер-сэмплинга. Техническая демонстрация Nvidia позволяет сравнить разные режимы сглаживания (AA) друг с другом.

В технической демонстрации "Fracture" NVIDIA показывает алгоритм расчета случайных разрушений с помощью PhysX. Разработчикам теперь не нужно придумывать собственные схемы, достаточно обратиться к API. Разрушение каждого объекта отличается от других, поэтому и выглядит более реалистично.

Техническая демонстрация "Fur" от NVIDIA показывает эффекты меха и волос, вернее, насколько реалистично PhysX может их просчитывать в реальном времени. Все ворсинки просчитываются по отдельности и ведут себя независимо от других, а их на сцене насчитывается сотни тысяч. Раньше подобная сложность вычислений была невозможной, но вскоре она будет доступна игровым разработчикам.

Для Европы и России ролик не очень понятен, но дело в том, что в Азии очень популярна игра QQ Dance 2. В ней тоже присутствуют эффекты физики, поддерживаемые через API NVIDIA PhysX. На ролике показаны сцены, полученные на видеокарте GeForce GTX 680.

С демонстрацией "Dawn" Nvidia когда-то показывала потенциал производительности линейки NVIDIA GeForce FX. Напомним, что произошло это в 2003 году, и в то время Dawn была одной из самых реалистичных демонстраций. Как можно судить по приведенному выше ролику, в ближайшее время NVIDIA опубликует новую демонстрацию с главным персонажем "Dawn".

В первое время на рынке должны появиться видеокарты только с эталонным дизайном, о нём мы как раз и хотим поговорить подробнее.

NVIDIA решила установить новые стандарты эталонной системы охлаждения, уделив большое внимание её оптимизации по сравнению с предшествующим поколением. Базовый дизайн был оставлен прежним. То есть на дальнем крае видеокарты (ближний, когда видеокарта находится в корпусе) находится радиальный вентилятор, который забирает свежий воздух и продувает его через радиатор в сторону слотовой заглушки. Ниже мы подробнее остановимся на кулере.

Длина видеокарты составляет 25,5 см, то есть GeForce GTX 680 примерно на сантиметр короче GeForce GTX 580 и Radeon HD 7970.

Как можно видеть с обратной стороны видеокарты, NVIDIA отказалась от крепёжной пластины. Она оказалась избыточной, кулер уже достаточно прочно держится на видеокарте и контактирует с GPU. Впрочем, есть некоторые любопытные отличия, на которых хотелось бы остановиться подробнее.

Радиальный вентилятор-центрифуга имеет диаметр 65 нм и, как утверждает Nvidia, производится из специальных материалов, которые призваны уменьшать уровень шума непосредственно на источнике этого шума. Причём дело здесь не столько в уменьшении абсолютного уровня шума, сколько в переносе его на частоты, к которым человеческое ухо меньше восприимчиво.

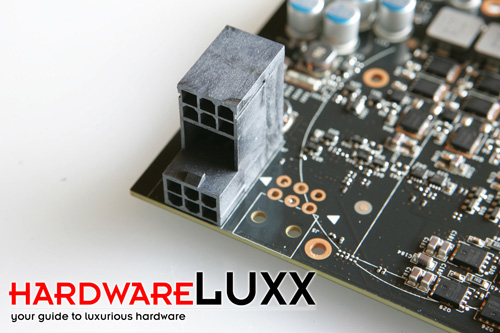

Довольно необычным оказалось и расположение двух 6-контактных гнёзд дополнительного питания. Как правило, у большинства видеокарт они установлены по соседству друг с другом, но NVIDIA в данном случае решила установить одно гнездо над другим.

Подобно предшественнику "Fermi", видеокарта GeForce GTX 680 может работать в режиме SLI с двумя или тремя видеокартами. Неофициально поддерживается и конфигурация 4-way SLI с совместимыми видеокартами, подобными GeForce GTX 580. Для совместной работы Nvidia разместила два разъёма SLI рядом со слотовой заглушкой.

Nvidia выбрала для дальнего конца (ближнего в корпусе) видеокарты полностью закрытый дизайн. Забираемый вентилятором воздух полностью выбрасывается через слотовую заглушку.

Как мы уже упоминали, к GeForce GTX 680 можно подключить четыре монитора, столько же могут работать одновременно. Вы получите два двухканальных выхода DVI, один HDMI 1.4a и один DisplayPort 1.2.

Как можно видеть, NVIDIA использовала все доступные участки на слотовой заглушке для вытяжки горячего воздуха наружу корпуса.

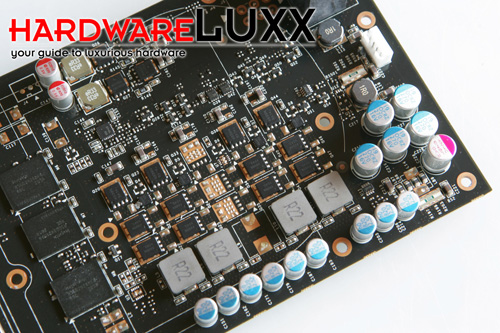

На фотографии показана электроника, отвечающая за работу функции GPU Boost. По сути, перед нами небольшая дополнительная плата с чипом, которую мы в том или ином виде получим на всех видеокартах GeForce GTX 680.

Следуя нашим традициям, мы сняли с видеокарты кулер.

Без кулера дизайн видеокарты GeForce GTX 680 можно назвать классическим. Вы можете легко распознать GPU и чипы памяти. Справа размещены другие компоненты, включая электронику системы питания.

На приближенной фотографии подсистемы питания мы не наблюдаем каких-либо специфических деталей. Хорошо видно, что GeForce GTX 680 использует 4-фазный дизайн системы питания. Будет интересно посмотреть, кто из производителей представит первую печатную плату на альтернативном дизайне.

Два 6-контактных разъема дополнительного питания "друг над другом" уже выделяются среди других решений. Справа можно видеть контактную площадку для размещения второго "традиционного" 6-контактного разъема питания. Почему было принято решение о подобном размещении гнёзд, мы так и не узнали.

GPU на видеокарте GeForce GTX 680 имеет кодовое название GK104. Если быть более конкретным, то GPU в данном случае промаркирован "GK104-400-A2". То есть графический процессор был изготовлен на третьей неделе 2012 года, перед нами вторая ревизия чипа.

NVIDIA установила на GeForce GTX 680 восемь чипов памяти производства Hynix. Они относятся к семейству "H5G02H245MFA". Мы хорошо знакомы с этой линейкой по другим видеокартам, включая Radeon HD 79xx, но там чипы работают даже на пониженной тактовой частоте. В случае же GeForce GTX 680 память работает на полной тактовой частоте 1500 МГц. Каждый чип имеет ёмкость 256 Мбайт.

Ниже мы подробно рассмотрим кулер GeForce GTX 680.

Кулер состоит из металлического каркаса, к которому крепится медный теплообменник и вентилятор. На металлическом каркасе можно заметить многочисленные прокладки из теплопроводящего материала, которые накрывают чипы памяти и некоторые компоненты стабилизатора напряжения.

NVIDIA выбрала вентилятор-центрифугу диаметром 65 мм. Он сочетает приличный объём продуваемого воздуха с низким уровнем шума. Как обещает Nvidia, для изготовления вентилятора были использованы специальные звукопоглощающие материалы, которые сдвигают диапазон частот шума или гасят их.

Чипы памяти и некоторые другие компоненты охлаждаются с помощью каркаса кулера, но с GPU напрямую контактирует медный теплообменник (вернее, медная пластина теплообменника). В теплообменнике присутствуют три тепловые трубки, призванные распределять тепло на весь радиатор.

NVIDIA оптимизировала воздушный поток, который продувается через радиатор, чтобы получить высокоэффективную систему отведения тепла. Среди улучшений можно отметить очень тонкие рёбра охлаждения, которые заточены на концах, чтобы максимально предотвратить появление турбулентности воздуха.

Для проведения тестирования мы обновили нашу тестовую систему, а также и поколение драйверов. Процессор Intel Core i7-3960X был разогнан со штатной частоты 3,2 ГГц до 4,2 ГГц, чтобы максимально устранить "узкое место" по производительности CPU. Мы использовали следующие компоненты:

| Тестовая конфигурация | |

| Процессор | Intel Core i7-3960X 3,3 ГГц, разгон до 4,2 ГГц |

| Материнская плата | ASUS P9X79 |

| Оперативная память | ADATA XPG Gaming Series Low Voltage 4x 2 Гбайт PC3-12800U CL 9-9-9-24 |

| Накопитель | ADATA S510 SSD 60 Гбайт |

| Блок питания | Seasonic Platinum Series 1000 Вт |

| Операционная система | Windows 7 64 Bit SP1 |

| Видеокарты | |

| NVIDIA | NVIDIA GeForce GTX 680 (1008/1008/1502 МГц, 2048 Мбайт) |

| NVIDIA GeForce GTX 590 (608/1215/854 МГц, 3072 Мбайт - 1536 Мбайт эффективное значение) | |

| NVIDIA GeForce GTX 580 (772/1544/1000 МГц, 1536 Мбайт) | |

| NVIDIA GeForce GTX 570 (732/1464/950 МГц, 1280 Мбайт) | |

| NVIDIA GeForce GTX 560 Ti 448 Cores (732/1464/950 МГц, 1280 Мбайт) | |

| NVIDIA GeForce GTX 560 Ti (820/1640/1000 МГц, 1024 Мбайт) | |

| NVIDIA GeForce GTS 550 Ti (900/1800/1026 МГц, 1024 Мбайт) | |

| NVIDIA GeForce GTX 480 (700/1401/924 МГц, 1536 Мбайт) | |

| NVIDIA GeForce GTX 470 (608/1215/838 МГц, 1280 Мбайт) | |

| NVIDIA GeForce GTX 465 (608/1215/802 МГц, 1024 Мбайт) | |

| NVIDIA GeForce GTX 460 (675/1350/900 МГц, 1024 Мбайт) | |

| NVIDIA GeForce GTS 450 (783/1566/902 МГц, 1024 Мбайт) | |

| AMD | AMD Radeon HD 7970 (925/925/1375 МГц, 3072 Мбайт) |

| AMD Radeon HD 7950 (800/800/1250 МГц, 3072 Мбайт) | |

| AMD Radeon HD 7870 (1000/1000/1200 МГц, 2048 Мбайт) | |

| AMD Radeon HD 7850 (860/860/1200 МГц, 2048 Мбайт) | |

| AMD Radeon HD 7770 (1000/1000/1125 МГц, 1024 Мбайт) | |

| AMD Radeon HD 7750 (800/800/1125 МГц, 1024 Мбайт) | |

| AMD Radeon HD 6990 (830/830/1250 МГц, 4096 Мбайт - 2048 Мбайт эффективное значение) | |

| AMD Radeon HD 6970 (880/880/1375 МГц, 2048 Мбайт) | |

| AMD Radeon HD 6950 (800/800/1200 МГц, 2048 Мбайт) | |

| AMD Radeon HD 6870 (900/900/1050 МГц, 1024 Мбайт) | |

| AMD Radeon HD 6850 (775/775/1000 МГц, 1024 Мбайт) | |

| AMD Radeon HD 5970 (725/725/1000 МГц, 2048 Мбайт - 1024 Мбайт эффективное значение) | |

| AMD Radeon HD 5870 (850/850/1200 МГц, 1024 Мбайт) | |

| AMD Radeon HD 5850 (725/725/1000 МГц, 1024 Мбайт) | |

| AMD Radeon HD 5830 (800/800/1000 МГц, 1024 Мбайт) | |

| Драйверы: | |

| NVIDIA |

GeForce 300.99 |

| AMD | AMD Catalyst 12.3 Preview |

Настройки драйверов NVIDIA:

- Текстурная фильтрация: Качество

- Сглаживание- гамма-коррекция: Да

- Текстурная фильтрация - оптимизация анизотропии: Нет

- Текстурная фильтрация - отрицательный LOD Bias: Заблокировано

Текстурные настройки AMD:

- Текстурная фильтрация: Качество

- Catalyst AI: Выключен/ Качество

Ниже приведены настройки тестов, использованных нами:

Futuremark 3DMark 11 (DX11):

- Entry

- Performance

- Extreme

- Sala

Anno 2070 (DX11):

- 1680x1050 AA без 16xAF

- 1680x1050 MLAA 16xAF

- 1920x1080 AA без 16xAF

- 1920x1080 MLAA 16xAF

- 2560x1600 AA без16xAF

- 2560x1600 MLAA 16xAF

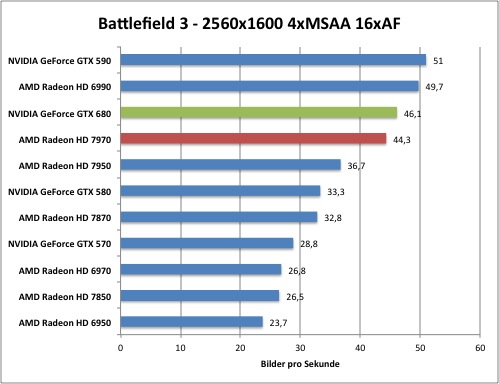

Battlefield 3 (DX11):

- 1680x1050 1xAA 16xAF

- 1680x1050 4xAA 16AF

- 1920x1080 1xAA 16xAF

- 1920x1080 4xAA 16XAF

- 2560x1600 1xAA 16xAF

- 2560x1600 4xAA 16xAF

Call of Duty: Modern Warfare 3 (DX9):

- 1680x1050 4xAA 16xAF

- 1920x1080 4xAA 16xAF

- 2560x1600 4xAA 16xAF

Crysis Warhead (DX10):

- 1680x1050 1xAA 16xAF

- 1680x1050 8xAA 16xAF

- 1920x1080 1xAA 16xAF

- 1920x1080 8xAA 16xAF

- 2560x1600 1xAA 16xAF

- 2560x1600 8xAA 16xAF

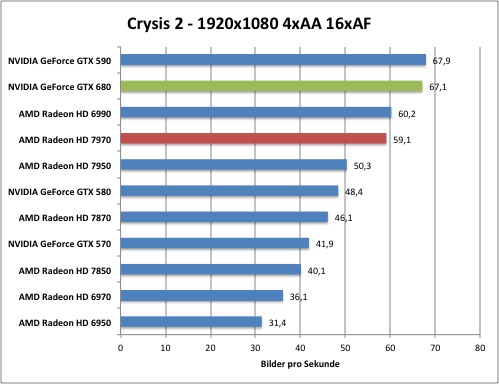

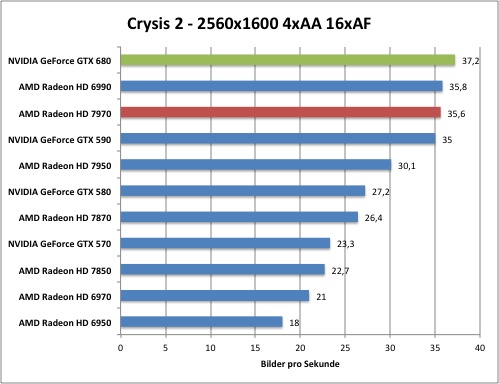

Crysis 2 (DX11):

- 1680x1050 1xAA 16xAF

- 1680x1050 4xAA 16xAF

- 1920x1080 1xAA 16xAF

- 1920x1080 4xAA 16xAF

- 2560x1600 1xAA 16xAF

- 2560x1600 4xAA 16xAF

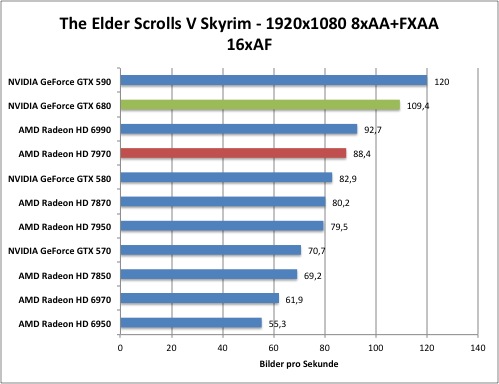

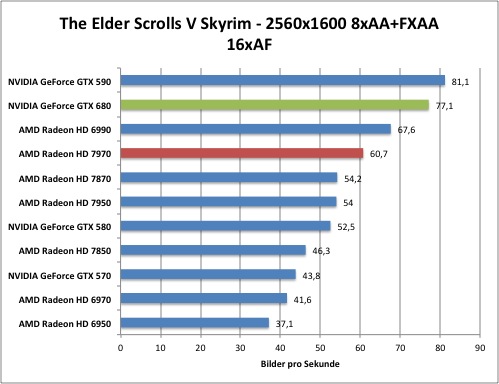

The Elder Scrolls V: Skyrim (DX9):

- 1680x1050 1xAA 16xAF

- 1680x1050 8xAA+FXAA 16xAF

- 1920x1080 1xAA 16xAF

- 1920x1080 8xAA+FXAA 16xAF

- 2560x1600 1xAA 16xAF

- 2560x1600 8xAA+FXAA 16xAF

The Witcher 2 (DX9):

- 1680x1050 AA без 16xAF

- 1680x1050 MLAA 16xAF

- 1920x1080 AA без 16xAF

- 1920x1080 MLAA 16xAF

- 2560x1600 AA без 16xAF

- 2560x1600 MLAA 16xAF

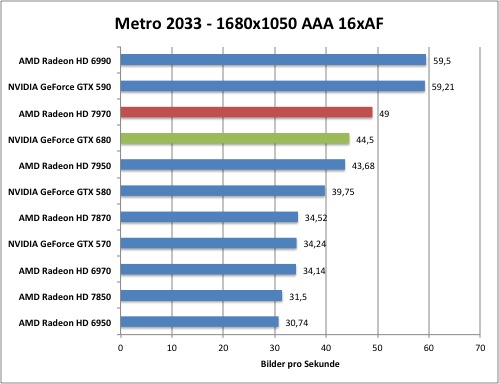

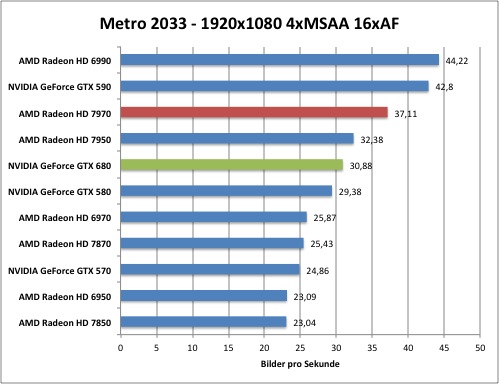

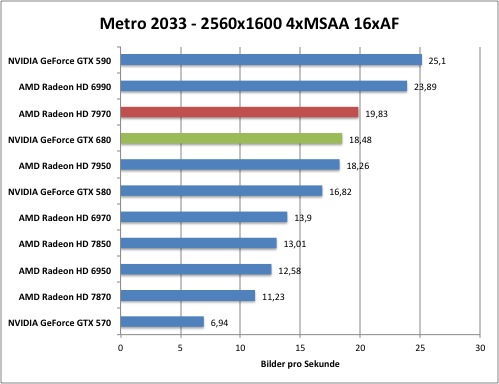

Metro 2033 (DX11):

- 1680x1050 AAA 16xAF

- 1680x1050 4xAA 16xAF

- 1920x1080 AAA 16xAF

- 1920x1080 AAA 16xAF

- 2560x1600 AAA 16xAF

- 2560x1600 4xAA 16xAF

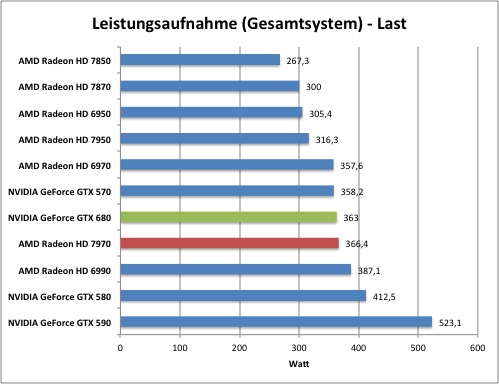

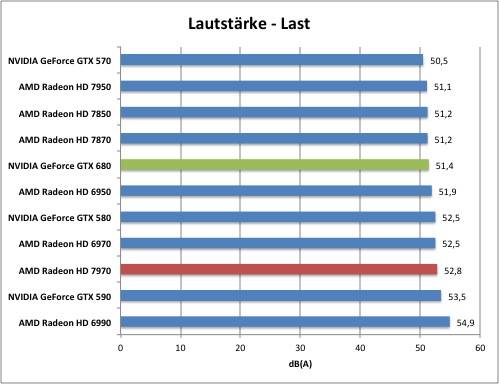

Начнём с результатов тестов. Для измерений энергопотребления и уровня шума под нагрузкой мы использовали игру Crysis 2. Мы измеряли уровень шума на расстоянии 30 см от видеокарты в открытом корпусе, используя шумометр, калиброванный от 30 до 70 дБ(A).

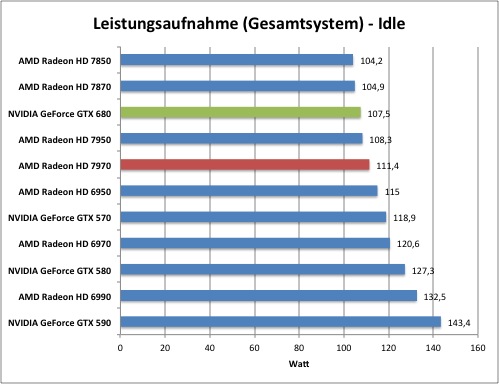

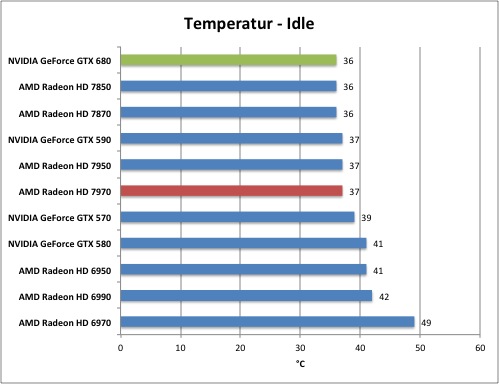

Мы уже положительно высказывались насчёт энергопотребления семейства Radeon HD 7000 в режиме бездействия, и в случае GeForce GTX 680 поводов для критики немного. Видеокарта смогла обойти Radeon HD 7970, обеспечив меньшее энергопотребление в режиме бездействия примерно на 4 Вт (энергопотребление измеряется для всей системы).

Схожую картину мы наблюдаем и по энергопотреблению под нагрузкой. Интересно будет посмотреть, как все это скажется на производительности. GeForce GTX 680 и Radeon HD 7970 показывают близкое энергопотребление, их разделяют считанные ватты.

NVIDIA акцентировала новую систему охлаждения, и действительно в режиме бездействия она охлаждает GPU до уровня 36 °C. Но разница между видеокартами здесь очень невелика, да и при оценке температуры необходимо учитывать и уровень шума.

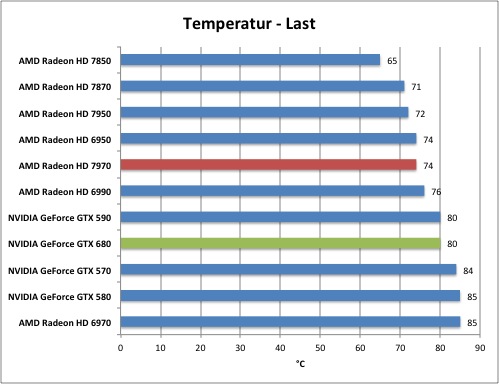

Уровень температуры под нагрузкой оказался ещё более интересным. NVIDIA GeForce GTX 680 нагрелась на 6 градусов сильнее Radeon HD 7970. В принципе, температуру 80 °C нельзя назвать значительной, она вполне соответствует предыдущим поколениям Nvidia, но, возможно, мы получим меньшую скорость работы вентилятора, а также и меньший уровень шума.

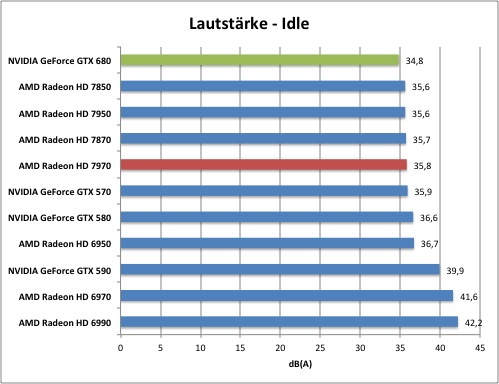

Новая видеокарта Nvidia в режиме бездействия действительно работает на 1 дБ(A) тише видеокарты Radeon HD 7970, так что одно из обещаний по поводу системы охлаждения Nvidia выполнила. Видеокарта GeForce GTX 680 оказалась тише всех видеокарт линейки Radeon HD 7800.

Не менее интересной оказывается и работа под нагрузкой, в данном отношении GeForce GTX 680 вновь оказывается тише Radeon HD 7970. Честно говоря, мы были приятно удивлены тому, насколько хорошо Nvidia справляется с уровнем шума. Интересно будет посмотреть, какую картину мы получим по производительности.

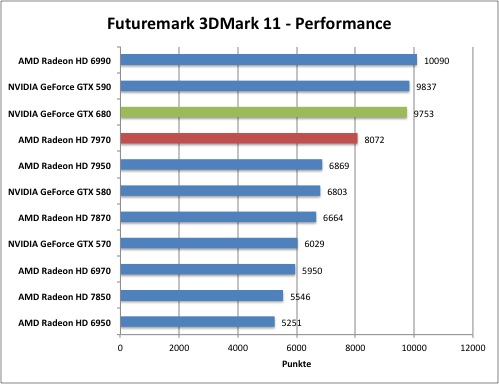

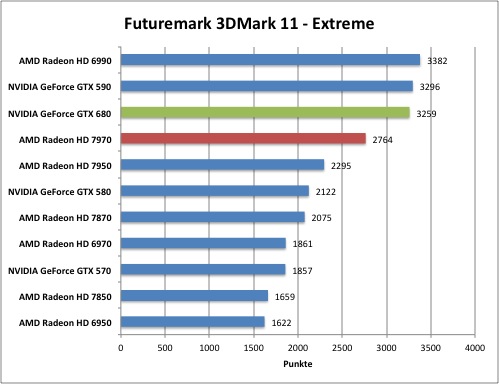

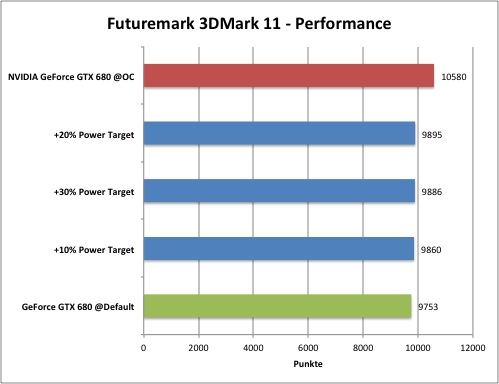

Мы добавили в наши тесты последнее поколение 3DMark. 3DMark 11 является первым тестом, полностью ориентированным на DirectX 11, от разработчика Futuremark. Именно по этой причине тест интенсивно использует тесселяцию, глубину поля резкости, объёмное освещение и DirectCompute. Вполне логичным кажется требование по наличию многоядерного процессора с количеством ядер не меньше четырёх. Скачать тест можно в unserer Download-Areaсоответствующем разделе нашего сайта.

Во второй части знаменитой ролевой саги "Ведьмак/The Witcher" Геральту из Ривии снова противостоят полчища тварей. С помощью меча и магии игроку предстоит пройти многочисленные локации фантастического игрового мира, радующего вниманием к деталям. Вторая часть игры под названием "Убийца королей/Assassins of Kings" стала успешным продолжением первой игры в развитии нелинейного сюжета, когда действия игрока влияют на ход игры. Игра вышла в 2010 году, и специально разработанный для неё Red Engine (DX9) смог поднять стандарты качества графики ролевых игр на новую планку. Геймеры и журналисты с одобрением встретили новую игру. И разработчики движка RED, компания CD Projekt, не зря назвали свой движок "лучшим в мире для ролевых игр".

Игра Call of Duty - Modern Warfare 3, вышедшая в конце 2011 года, стала восьмой в весьма успешном семействе. Шутер от первого лица позволяет насладиться активным геймплеем в реальном режиме времени, который перемежается с сюжетными вставками кинематографического качества. Геймер погружается в брутальную атмосферу игры благодаря богатым возможностям движка IW Engine 4.0 (DX9), оказываясь в гуще боевых событий. Если верить разработчикам, движок отличается от конкурирующих решений возможностью вертикального геймплея и проработанными детализованными текстурами.

Игра Anno 2070 отличается от предшествующих игр серии тем, что действие происходит не в прошлом, а через 60 лет в будущем. Геймплей во многом похож, то есть вам нужно исследовать и открывать острова, колонизировать их, создавать циклы производства продукции и развития поселений, чтобы удовлетворять потребности общества, а также выстраивать дипломатические отношения с соседями. В игру были введены три фракции: Эко/Eco нацеливаются на развитие возобновляемых источников энергии и сохранение природы, Магнаты/Tycoons не стесняются загрязнять окружающую среду ради прибыльной работы тяжелой промышленности. Третья фракция Техи/Techs развивают новые технологии и осваивают морские глубины. Большие острова, живая флора и фауна, впечатляющие эффекты воды и растительности - всё это в изобилии имеется в игре благодаря движку Related Designs (DX11), и высокие настройки детализации накладывают немалую нагрузку на видеокарту.

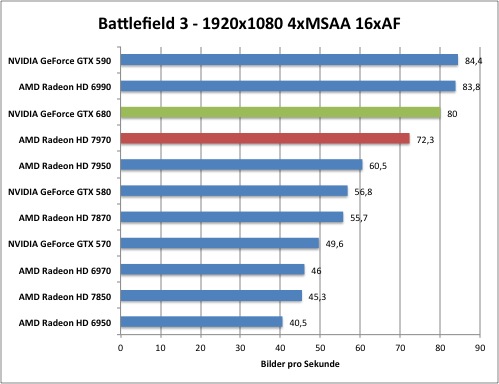

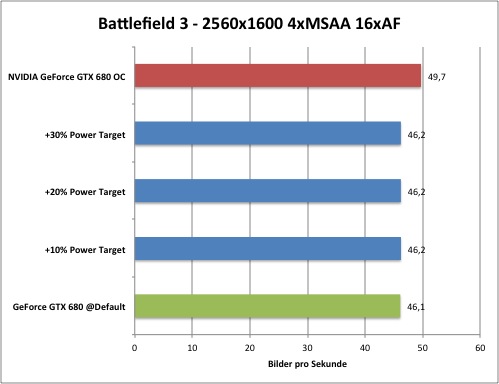

Семейство Battlefield недавно получило уже третью итерацию, позволяющую геймерам сражаться друг с другом на масштабных аренах. В игре можно выбирать бойцов разной специализации, воевать с помощью реалистично смоделированного оружия и техники. Добавьте к этому мощный движок Frostbite 2 (DX11), обеспечивающий глубокое погружение в игру. Благодаря продвинутой системе совершенствований, достижений и роста персонажа интерес к игре не будет ослабевать в течение долгого времени, добавьте к этому возможность разблокирования оружия и гаджетов. Так что длительное наслаждение третьей игрой в семействе Battlefield гарантировано.

Разработчиков Crysis можно поблагодарить за то, что их игра стала тестом де-факто графических возможностей ПК. Движок Cry Engine всегда отличался тем, что мог "поставить на колени" даже новейшие high-end системы. Именно по этой причине для наших тестов мы взяли дополнение Crysis Warhead. Мы запускали Crysis в режиме DirectX 10 с максимальным уровнем детализации.

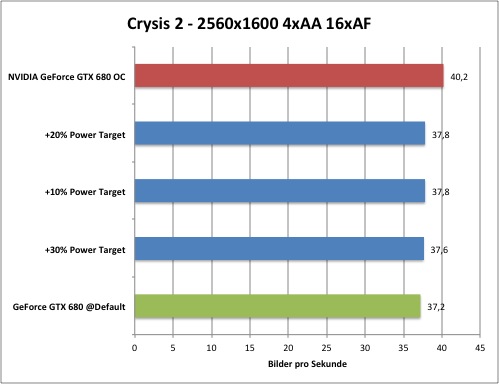

Игра Crysis 2 на основе CryEngine 3 (DX11) переносит игрока в пост апокалиптический Нью-Йорк. Раса чужих под названием "цефы", знакомая по первой части игры, во второй части вновь пытается уничтожить человечество. Главный персонаж с позывным Алькатрас вновь оказывается в гуще событий, ему придётся надеяться только на свой нанокостюм, обеспечивающий возможности супермена, а также на оружие. Игроку как и раньше противостоят превосходящие силы врага. В отличие от первой игры, владельцы "слабых" компьютеров тоже получат плавную игру благодаря опциональному режиму DirectX 9. Разработчики пошли на некоторый технический компромисс, что связано и с портированием игры под приставки. Так что для современного "железа" игра оказывается уже не такой "тяжелой".

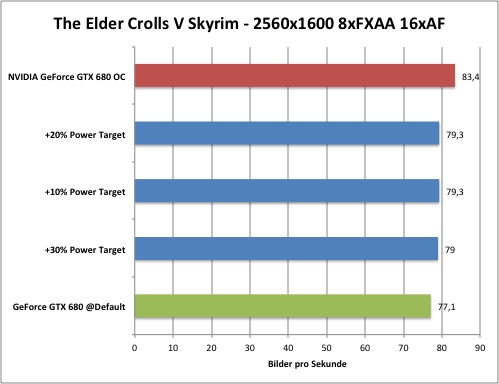

Действие пятой игры в семействе The Elder Scrolls разворачивается в провинции Skyrim. Сюжет игры построен вокруг возвращения драконов, что было предсказано в древних свитках ("Elder Scrolls"). Геймер играет роль "довакина", то есть персонажа с телом человека и душой дракона. В игре вам предстоит сражаться не только с обычными тварями, но и с драконами. Добавим к этому реалистичные улицы и захватывающие дух пейзажи, уходящие в горизонт. Благодаря отличной детализации растительности и значительной дальности видимости Skyrim может нагрузить любую видеокарту.

Враждебное окружение, радиация, мутанты и наёмники - все эти элементы бывший разработчик игры S.T.A.L.K.E.R. 4A Games Studios перенёс и во вселенную Metro 2033. В 2013 году человечество вновь погрязло в войне и почти что уничтожило всё живое ядерными бомбардировками. Небольшие группы выживших спустились в московское метро, чтобы укрыться. К сожалению, подземку заселили не только они, поэтому выжившим придётся сражаться с тварями, привыкшими к токсичным условиям. Причём цель этих тварей заключается в уничтожении оставшихся людей! В игре вы можете использовать как грубую силу, так и хитроумную тактику, но вам придётся нелегко. Как и в случае дебютной игры, разработчики смогли "поставить на колени" даже самые современные видеокарты движком A4 (DX11).

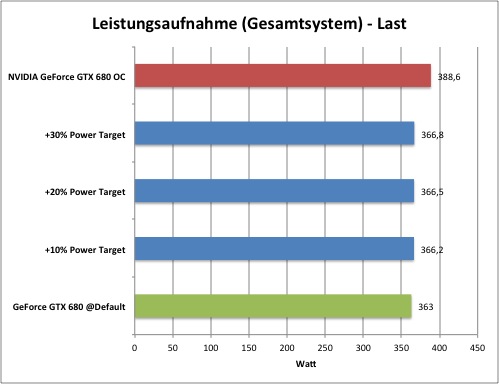

Выше мы уже обсуждали технологию GPU Boost. Возникает логичный вопрос: как разгонять GeForce GTX 680, учитывая динамическое переключение видеокарты между разными профилями? Для разгона NVIDIA позволяет выставлять параметры "Power Target" и "GPU Boost Offset".

При этом, конечно, придётся забыть о старом добром разгоне GeForce GTX 680 с фиксированными тактовыми частотами. Подобно AMD PowerTune, в данном случае планка "Power Target" указывает на предельное энергопотребление. 100 процентов соответствуют 195 Вт. Максимальные границы изменения "Power Target" составляют +30% и -30%, то есть вы можете менять планку от 136 до 253 Вт. То есть подъём планки "Power Target" можно назвать своего рода разгоном. Если приложение нагружает видеокарту до планки 195 Вт, что ограничивает частоту 1058 МГц, но при этом бюджет по температуре остаётся, то подъём планки "Power Target" позволяет выжать дополнительные тактовые частоты.

Но для разгона лучше использовать комбинацию "Power Target" и "GPU Clock Offset". Последняя опция увеличивает базовую тактовую частоту, как и частоту Boost. Если, например, сделать увеличение на 50 МГц, то базовая частота увеличивается до 1056 МГц, а частота Boost - до 1108 МГц. То же самое касается и памяти, которая получает прирост Boost. Для GPU максимальное смещение составляет +550 и -500 МГц, а для памяти - +1000 и -500 МГц.

Физическое повреждение видеокарты, как утверждает Nvidia, из-за разгона практически невозможно из-за расширенных функций мониторинга и других элементов защиты. Для наших тестов мы выставили планку "Power Target" на максимально допустимый уровень, после чего увеличивали смещение тактовых частот Offset.

С помощью утилиты EVGA Precision мы выставили напряжение на максимальный уровень 1,150 В.

Все это позволило нам достигнуть смещения по частоте GPU на +177 МГц ("GPU Clock Offset") и смещения по частоте памяти +274 МГц ("Mem Clock Offset"). Тактовая частота составила до 1280 МГц для GPU и до 1638 МГц для памяти.

Наш разгон привел к следующей производительности:

Конечно, повышение тактовых частот и напряжения влияет и на другие характеристики:

Переход на меньший техпроцесс для любого производителя чипов является серьёзным шагом. Особенно в том случае, если производство выполняется не на "домашних" заводах, а сторонним производителем чипов, у которого могут возникать свои проблемы. В частности, у TSMC наблюдались определённые трудности с первыми 28-нм чипами. Но двум производителям GPU, а именно AMD и NVIDIA, переход на меньший техпроцесс был жизненно необходим. NVIDIA надоело биться с чипами гигантской площади 530 мм² и 3 млрд. транзисторов. AMD в прошлом использовала более экономичный подход, причём не только по количеству транзисторов, но и по эффективности своих GPU. В случае нового поколения 28-нм GPU мы получили обратную картину. Теперь AMD конкурирует со своим транзисторным "монстром" из 4,3 млрд. транзисторов на площади 365 мм², а NVIDIA выпустила весьма экономичный чип на 3,53 млрд. транзисторов площадью всего 294 мм².

Всё это существенно сказывается и на цене. Nvidia сделала интересные комментарии, объявляя результаты квартала. Похоже, что выход годных кристаллов оказался намного ниже запланированного, и NVIDIA не может поставить достаточное количество чипов. TSMC, похоже, выставляет счёт производителям, таким как AMD и NVIDIA, не по количеству годных кристаллов, а по количеству подложек, независимо от того, сколько с неё получилось взять годных чипов. Большая площадь чипа приводит к меньшему количеству чипов с одной подложки, поэтому и себестоимость оказывается выше. Конечно, не менее важным фактором является и выход годных кристаллов, то есть доля работающих чипов из произведённых. Но в данном отношении ни один из производителей не может дать точный прогноз.

Мы подобрались к важной теме нашей статьи: GPU Nvidia GeForce GTX 680 перенес технологию Boost из области CPU в сферу GPU. Тот факт, что не все приложения и игры могут использовать видеокарту в полной мере, был хорошо известен и раньше, но пока что технической решения данной проблемы не было представлено. Технология GPU Boost идёт намного дальше подхода AMD Powertune. Вместе с тем Nvidia будет довольно сложно донести смысл технологии до среднего пользователя или геймера. Обратите внимание, что в нашей статье мы посвятили объяснению работы GPU Boost несколько параграфов и иллюстраций. Впрочем, время покажет.

У современных видеокарт есть несколько характеристик, позволяющих предугадать производительность в играх и приложениях: количество ядер/потоковых процессоров, частота GPU и памяти. Но на чем из этого списка следует поставить акцент? Конечно, базовая частота позволяет оценить производительность видеокарты, но, опять же, только базовую. Если вы захотите более высоких тактовых частот, то видеокарта без проблем их предоставит. Определённый прирост "Turbo" уже гарантирован в случае любой игры на видеокарте GeForce GTX 680, но максимальная тактовая частота будет меняться в зависимости от типа игры/приложения. Похоже, что на данный момент эта планка составляет около 1110 МГц. С другой стороны, все экземпляры видеокарт отличаются друг от друга, и что-то предсказать сложно. Когда Nvidia оптимизирует вместе с TSMC производство кристаллов, то на рынке должны появиться видеокарты с более высокими возможными частотами. Возможно, мы столкнемся с ситуацией, когда покупатели будут искать самые скоростные видеокарты, сдавать неудачные модели обратно в магазин, так далее по циклу.

Функции, подобные TXAA и адаптивной вертикальной синхронизации, конечно, интересны, но пока их актуальность и значимость оценить сложно. По крайней мере, это касается сглаживания TXAA, которое мы видели только по техническим демонстрациям. Какой выигрыш оно даст на практике? По крайней мере, адаптивная вертикальная синхронизация работает уже сегодня, и эффект она даёт вполне положительный.

NVIDIA обещает намного более высокую производительность на ватт по отношению с предыдущим поколением собственных видеокарт, а также и конкурирующих решений от AMD. И наши тесты показывают, что обещания Nvidia действительно сбываются. В режиме бездействия и под нагрузкой видеокарта GeForce GTX 680 потребляет меньше или, по крайней мере, столько же энергии, что и эталонная модель Radeon HD 7970. Если учесть результаты тестов, то Nvidia действительно даёт лучшее соотношение производительность на ватт. В синтетических тестах преимущество по производительности составляет 20 процентов, в реальных играх - от 5 до 30 процентов (в зависимости от разрешения и игры). В некоторых тестах новинка GeForce GTX 680 уступает Radeon HD 7970. В частности, можно привести примеры игр Crysis Warhead и Metro 2033. Но Nvidia явно не будет сидеть, сложа руки, и обновления драйверов исправят ситуацию с производительностью. Если учесть все результаты тестов, то GeForce GTX 680 по сравнению с Radeon HD 7970 даёт прирост 7,5 процентов. Но AMD также выигрывает от большего объёма памяти на своих high-end видеокартах, особенно в самых высоких разрешениях.

Нам понравилась эталонная система охлаждения Nvidia, которая раньше вызывала немало критики. В режиме бездействия мы получили уровень температуры GPU всего 36 °C, а под нагрузкой - 80 °C. Конечно, это больше, чем мы получаем у GPU конкурирующих видеокарт AMD. Но в случае Nvidia подобный шаг мы считаем приемлемым, поскольку за счет снижения скорости вращения вентилятора под нагрузкой мы получаем чуть меньший уровень шума. Обратите внимание, что под нагрузкой видеокарта шумит тише, чем модели из линейки Radeon HD 7800 и 7900 с эталонной системой охлаждения.

NVIDIA GeForce GTX 680 будет продаваться в Европе по цене около 500 евро. Самая дешёвая видеокарта Radeon HD 7970 сегодня обойдется примерно в 440 евро (17 100 руб. в России). Впрочем, говорить о ценах пока рано, поскольку первые видеокарты GeForce GTX 680 будут продаваться явно по завышенным ценам, особенно в России. Нужно будет подождать, пока цены не успокоятся.

В целом, мы весьма обрадованы эволюцией нового поколения NVIDIA "Kepler". Видеокарта GeForce GTX 680 - это только начало. На горизонте уже виднеется GeForce GTX 670 Ti, да и модели для массового рынка должны вскоре подтянуться. Нам также можно ждать нового вычислительного "монстра" для HPC. Но давайте запасемся терпением.

Преимущества NVIDIA GeForce GTX 680:

- Низкое энергопотребление в режиме бездействия

- Очень хорошее соотношение производительности на ватт под нагрузкой

- Низкий уровень шума в режиме бездействия

- Низкий уровень шума под нагрузкой

- DirectX 11.1

- PCI Express 3.0

Недостатки NVIDIA GeForce GTX 680:

- Высокая цена

- Система регулировки тактовых частот будет понятна не всем