Сегодня NVIDIA представляет видеокарты GeForce GTX 1080 и GeForce GTX 1070 на новой архитектуре Pascal, которая в нынешнем году распространится и на другие модели. Вскоре AMD тоже выпустит свои новинки. Десять дней назад NVIDIA пригласила журналистов в Остин (Техас), где компания анонсировала новые видеокарты. Сегодня мы можем дать больше информации о прошедшем мероприятии, а также приводим результаты тестов. Кроме информации об архитектуре мы рассмотрим эталонный дизайн в виде Founders Edition, опубликуем тесты, а также расскажем о новых технологиях.

Сегодня NVIDIA представляет видеокарты GeForce GTX 1080 и GeForce GTX 1070 на новой архитектуре Pascal, которая в нынешнем году распространится и на другие модели. Вскоре AMD тоже выпустит свои новинки. Десять дней назад NVIDIA пригласила журналистов в Остин (Техас), где компания анонсировала новые видеокарты. Сегодня мы можем дать больше информации о прошедшем мероприятии, а также приводим результаты тестов. Кроме информации об архитектуре мы рассмотрим эталонный дизайн в виде Founders Edition, опубликуем тесты, а также расскажем о новых технологиях.

В этом году NVIDIA решила использовать конференцию GPU Technology Conference для объявления новой архитектуры GPU. Удивив многих, NVIDIA в середине марта представила архитектуру Pascal, объявив вычислительные ускорители Tesla P100 с первыми GPU на новой архитектуре. Журналисты тоже были немало удивлены, поскольку ранее NVIDIA даже не намекала на подобное развитие событий. Идея архитектуры Pascal во многом строится на высокой вычислительной производительности. Как показал первый анализ архитектуры Pascal, у нее действительно имеется приличный потенциал вычислительной производительности.

Как сообщил CEO Дженсен Хуанг на пленарном докладе, NVIDIA использовала для GPU GP100 полную версию архитектуры. Чип использует 15,3 млрд. транзисторов, 16 Гбайт памяти HBM2, а площадь составляет 610 мм². GPU с памятью устанавливаются на подложку, так что NVIDIA пришлось преодолеть немало технических проблем. На разработку архитектуры ушло несколько лет, в общей сложности над ней работали тысячи инженеров. Бюджет на разработку архитектуры Pascal составил от 2 до 3 млрд. долларов. Никто не ожидал, что NVIDIA подготовит чипы с новой архитектурой уже в начале года. Впрочем, GPU GP100 ориентированы на вычисления, а не на геймеров. Цена ускорителей P100 составляет от 12 до 15 тыс. долларов – точной цены NVIDIA так и не назвала.

Видеокарты GeForce GTX 1080 и GTX 1070 можно назвать шагом назад. NVIDIA использовала другой дизайн чипа, который во многих областях существенно отличается от GPU GP100 в вычислительных ускорителях Tesla P100. Ниже мы рассмотрим сходства и различия. А также поговорим о новых технологиях, которые могут играть важную роль в будущем.

| Обзор технических спецификаций GeForce GTX 1080 | |||

|---|---|---|---|

| Модель | NVIDIA GeForce GTX 1080 | AMD Radeon R9 Fury X | NVIDIA GeForce GTX 980 Ti |

| Цена | 789 евро | от 45,2 тыс. рублей от 615 евро |

от 44,2 тыс. рублей от 620 евро |

| Сайт производителя | NVIDIA | AMD | NVIDIA |

| Техническая информация | |||

| GPU | GP104 | Fiji XT | GM200 |

| Техпроцесс | 16 нм | 28 нм | 28 нм |

| Число транзисторов | 7,2 млрд. | 8,9 млрд. | 8 млрд. |

| Тактовая частота GPU (базовая) | 1.607 МГц | - | 1.000 МГц |

| Тактовая частота GPU (Boost) | 1.733 МГц | 1.050 МГц | 1.075 МГц |

| Частота памяти | 2.500 МГц | 500 МГц | 1.750 МГц |

| Тип памяти | GDDR5X | HBM | GDDR5 |

| Объём памяти | 8 GB | 4 GB | 6 GB |

| Ширина шины памяти | 256 бит | 4.096 бит | 384 бит |

| Пропускная способность памяти | 320,0 Гбайт/с | 512,0 Гбайт/с | 336,6 Гбайт/с |

| Версия DirectX | 12 | 12 | 12 |

| Потоковые процессоры | 2.560 | 4.096 | 2.816 |

| Текстурные блоки | 160 | 256 | 176 |

| Конвейеры растровых операций (ROP) | 64 | 64 | 96 |

| Тепловой пакет | 180 Вт | 275 Вт | 250 Вт |

| SLI/CrossFire | SLI | CrossFire | SLI |

В рамках данной статьи мы будем называть GPU в видеокарте GeForce GTX 1080 модельным номером GP104. То же самое касается и видеокарты GeForce GTX 1070, хотя здесь архитектура подверглась некоторым сокращениям. NVIDIA пока не раскрыла техническое название чипов. Для ясности сравнения с GP100 в Tesla P100, мы будем использовать название GP104 для чипа в видеокартах GeForce GTX 1080 и GTX 1070. Производство GPU выполняется по 16-нм техпроцессу FinFET на заводах TSMC. NVIDIA указала число транзисторов 7,2 млрд. Площадь кристалла составляет 314 мм².

Архитектура Pascal

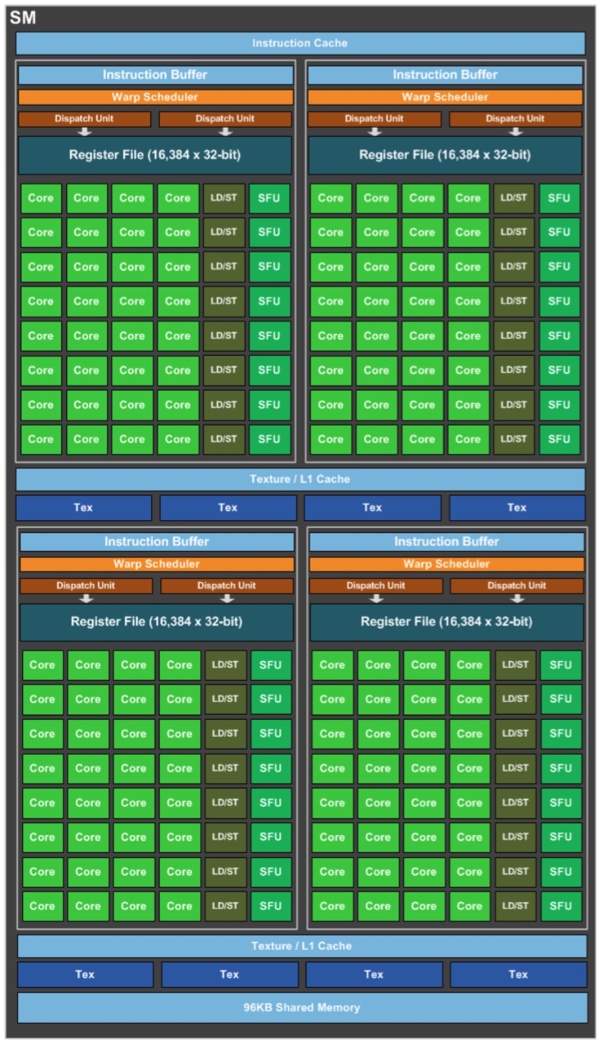

Центральным компонентом архитектуры по-прежнему являются потоковые мультипроцессоры Streaming Multiprocessors (SM). Графический процессор состоит из кластеров GPC (Graphics Processing Cluster, потоковых мультипроцессоров SM и контроллеров памяти. У GP104 на видеокарте GeForce GTX 1080 мы получаем четыре GPC, двадцать SM, каждый содержит по два блока с 64 потоковыми процессорами. В результате число потоковых процессоров составляет 2.560 (20x128). У каждого SM кроме 128 потоковых процессоров имеются восемь текстурных блоков, что дает 160 TMU в сумме. Интерфейс памяти 256-битный, NVIDIA использовала восемь 32-битных контроллеров. К каждому контроллеру подключено восемь конвейеров растровых операций, что дает 64 ROP у GeForce GTX 1080.

Движок PolyMorph Engine получил специальный аппаратный блок для функции Simultaneous Multi Projection. Комбинация SM с движком PolyMorph Engine названа Thread Processing Cluster (TPC). Каждый Streaming Multiprocessor оснащен 256-кбайт блоком File Register, 96-кбайт блоком Shared Register и 48-кбайт кэшем L1. Также имеется кэш L2 емкостью 2.048 кбайт.

Если сравнивать GPU GP104 GeForce GTX 1080 с GPU GP100 Tesla P100, то можно заметить некоторые изменения. У GPU GP100 каждый SM содержал 64 потоковых процессора, у GPU GP104 их число увеличилось до 128. Кроме того, изменились размеры блоков регистров и кэша. Таким образом, NVIDIA впервые в архитектуре изменила не только количество функциональных блоков, но и внесла более глубокие изменения, адаптируя архитектуру под потребности семейств Tesla или GeForce (изменяя число блоков FP64 и потоковых процессоров).

Подача питания

У чипа, изготавливаемого по 16-нм техпроцессу с несколькими миллиардами транзисторов, вопросы подачи питания выходят на передний план. К каждой области GPU необходимо подвести как можно более стабильное питание, именно по этой причине используются выделенные проводники. Чем больше будет инфраструктура питания на GPU, тем более стабильными будут напряжения. NVIDIA при разработке архитектуры Pascal и GPU GP104 провела тысячи симуляций, чтобы найти эффективное соотношение между напряжениями и частотами GPU – то же самое верно и для GPU GP100 в Tesla P100.

В начале разработки учитывалось порядка 1.300 линий подачи напряжения, что позволило увеличить частоту Boost до 1.325 МГц. Со временем количество линий подачи напряжения превысило 1.700, что позволило добиться частоты Boost, как минимум, 1.733 МГц у GeForce GTX 1080. Конечно, количество линий можно увеличивать и дальше, но отдача в виде тактовых частот будет уже непропорциональной.

Кроме самого GPU довольно высокие требования по питанию накладывают и другие компоненты. Поэтому важно гарантировать стабильную подачу питания на упаковку GPU. NVIDIA использовала специальный дизайн печатной платы (Board Channel Design), который описывает раскладку линий. Дизайн печатной платы дополняет архитектура питания самого GPU (GPU Circuit Architecture), описывающая подачу питания на компоненты, расположенные непосредственно на кристалле.

Новая подсистема питания

Высокие требования к печатной плате и упаковке BGA GPU накладываются и по передаче сигналов. Это касается интерфейса PCI Express и памяти GDDR5X. В данном случае память работает на довольно высоких частотах до 2.500 МГц. Длина волны сигналов сокращается, для симуляции уже недостаточно учитывать омическое сопротивление, перекрестные помехи, длину проводников. Необходимо, например, принимать во внимание емкость и индуктивность проводников.

Чтобы гарантировать целостность сигналов во всех участках цепи, модуляция и декодирование должны выполняться максимально точно. Чтобы сигналы проходили за примерно равное время, чипы памяти равномерно распределены вокруг GPU. Данная методика будет применяться и с будущими поколениями памяти, NVIDIA продолжит ее оптимизацию.

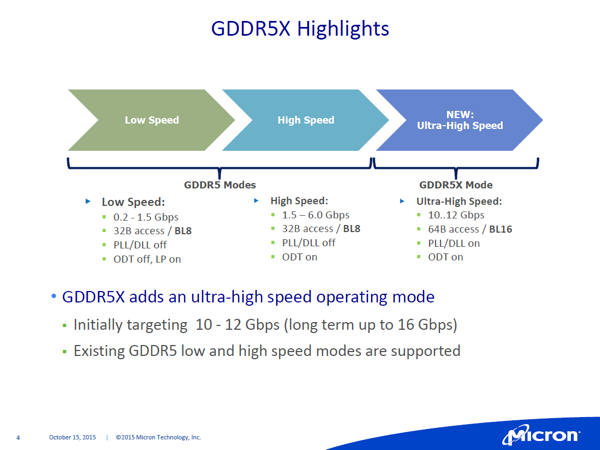

В конце 2015 года появилась финальная информация о памяти Micron GDDR5X. Micron видит память GDDR5X как переходную между GDDR5 и HBM или альтернативный вариант до массового перехода на HBM второго поколения. Для повышения производительности ширина prefetch была удвоена с 32 до 64 бит. Число слов данных на доступ тоже увеличилось в два раза, с 8 до 16. Пропускная способность данных на линию памяти у стандарта GDDR5 на 2.000 МГц составляет 8 Гбит/с. Micron у нынешней версии GDDR5X планирует увеличить пропускную способность до 10-12 Гбит/с, в будущем возможен рост до 16 Гбит/с. Как указывает Micron, небольшие отличия между GDDR5 и GDDR5X облегчают доработку контроллера памяти, что не составит особого труда для AMD и NVIDIA.

Если GPU работает с 256-битной шиной памяти, то переход на GDDR5X 12 Гбит/с позволит увеличить пропускную способность с 256 до 384 Гбайт/с. Скорость 16 Гбит/с позволит даже удвоить пропускную способность до 512 Гбайт/с, что соответствует нынешнему поколению HBM. Но следует помнить, что GDDR5X на 16 Гбит/с пока недоступна. NVIDIA использовала на видеокарте GeForce GTX 1080 память GDDR5X с частотой 2.500 МГц, что позволило достичь пропускной способности 320 Гбайт/с (10 Гбит/с на линию, кодирование QDR). В результате пропускная способность памяти оказалась на уровне прямого предшественника GeForce GTX 980 и меньше, чем у GeForce GTX 980 Ti. Но NVIDIA планирует компенсировать сей факт улучшенной цветовой дельта-компрессией.

Брифиг Micron, посвященный GDDR5X

Как и можно было ожидать, чипы памяти GDDR5 и GDDR5X выглядят очень похоже. Но есть и отличия. Чипы памяти GDDR5X используют 190 контактов в упаковке BGA вместо 170. Размеры чипов памяти тоже немного уменьшились до 14x10 мм. В любом случае, будущее остается за технологией High Bandwidth Memory. Второе поколение памяти HBM демонстрирует приличный потенциал, NVIDIA уже стала использовать такую память с ускорителями Tesla P100. Но HBM пока не планируется использовать во всем ассортименте видеокарт. NVIDIA показала это на примере GTX 1080, AMD с архитектурой Polaris тоже пока не планирует использовать HBM2. Так что GDDR5X остается весьма актуальным вариантом, тем более что интегрировать поддержку этой памяти в существующие контроллеры довольно просто (используются схожие задержки и частоты). Приятным побочным эффектом можно назвать снижение напряжения с 1,5 до 1,35 В.

Цветовая дельта-компрессия

256-битный интерфейс памяти выглядит скромно по сравнению с 512-битным интерфейсом GPU Hawaii или 4.096-битным у первых видеокарт с памятью HBM или HBM2 от AMD и NVIDIA. Но NVIDIA выбрала иной способ увеличения производительности памяти через новую технологию сжатия. Цветовая дельта-компрессия используется GPU AMD и NVIDIA на протяжении последних поколений. Сейчас NVIDIA представляет 4 поколение технологии сжатия. AMD использовала технологию цветового дельта-сжатия еще с GPU Tonga на видеокартах Radeon R9 295. Недавно AMD вновь подняла тему реализации цветовой дельта-компрессии в архитектуре GCN 1.2. Важно понимать, что технология опирается на сжатие без потерь. Поскольку потерь данных не происходит, разработчики могут смело опираться на данный способ без специальной адаптации.

NVIDIA использовала для сжатия памяти цветовую дельта-компрессию (Delta Color Compression). Она основана на хранении полной цветовой информации только о базовом пикселе, для остальных пикселей сохраняется только разница с базовым (дельта). Для этой цели используется матрица 8x8 пикселей. Поскольку близко расположенные пиксели обычно мало отличаются по цвету, хранение для них разницы оказывается по объёму информации выгоднее, чем полного значения цвета. Поэтому в случае дельта-компрессии информация о пикселях занимает меньше места в памяти, также достигается экономия пропускной способности памяти. В качестве примера работы технологии можно привести полностью черный и белый блоки, которые будут храниться в памяти как {1.0, 0.0, 0.0, 0.0} или {0.0, 1.0, 1.0, 1.0}. Здесь можно сэкономить ресурсы, сохраняя только 0.0 или 1.0 в качестве значения.

Цветовая дельта-компрессия архитектуры Pascal

NVIDIA улучшила процедуру определения сжимаемого контента. Ранее известное соотношение 2:1 теперь может использоваться чаще, то есть применяться к большему массиву данных. Появились и соотношения сжатия 4:1 и 8:1. NVIDIA использовала в качестве примера игру Project Cars, где компании удалось снизить требуемую пропускную способность в два раза. В среднем же для игр 320 Гбайт/с у GeForce GTX 1080 превращаются в эффективную пропускную способность памяти 384-480 Гбайт/с. Конечно, данные значения можно назвать чисто теоретическими, исходя из сжатия данных. Довольно сложно оценить влияние цветовой дельта-компрессии на практике, поскольку она выполняется аппаратно, выключить сжатие нельзя.

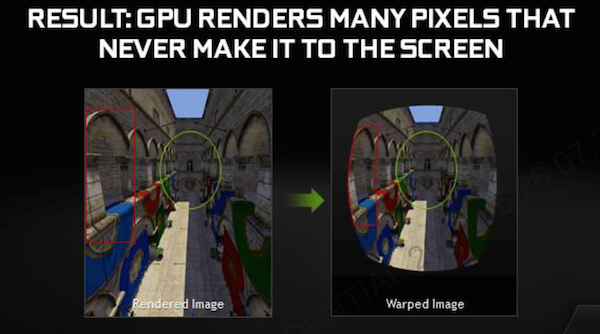

Одна из основных новых функций архитектуры Pascal – Simultaneous Multi Projection (SMP). Первый шаг в данном направлении NVIDIA сделала еще с архитектурой Maxwell в виде Multi-Resolution Shading (MRS). Технология MRS позволяет экономить вычислительную производительность GPU для очков виртуальной реальности, поскольку периферийные области можно выводить с намного меньшим разрешением, чем основные – глаз этого не заметит.

Что такое Multi-Resolution Shading?

Пользователь очков VR видит искаженную картинку с дисплея через систему линз, поэтому картинку имеет смысл оптимизировать в зависимости от дальности видимости и углов обзора. В результате картинка на дисплее получает искажения, похожие на «рыбий глаз», после системы линз пользователь воспринимает такое изображение как совершенно нормальную картинку без искажений. В прошлом GPU и процесс рендеринга под подобную технологию не были оптимизированы, производители добавляли необходимые искажения в виде пост-обработки. Конечно, пост-обработка требует вычислительных затрат, но что еще хуже, она вносит дополнительные задержки, а их для оптимального восприятия VR необходимо минимизировать.

NVIDIA GameWorks VR

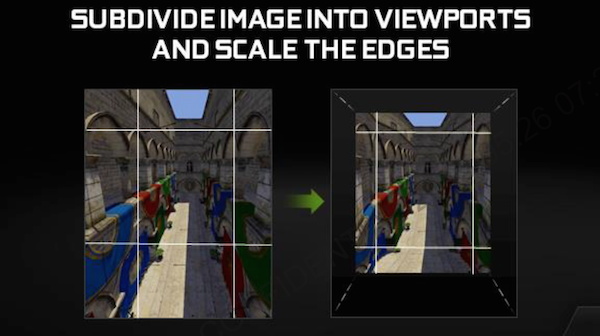

NVIDIA использует трюк, позволяющий снизить вычислительные расходы при рендеринге областей с ограниченной видимостью (или невидимых вообще). Изображение разделяется на девять зон. Так называемые зоны Viewports выделены так, чтобы быть как можно ближе к зонам привычной пост-обработки. Самая большая зона Viewport по центру просчитывается почти как в оригинале. Боковые области, а особенно четыре угла, подвергаются сжатию, у них изменяется разрешение в зависимости от желаемого результата.

Все девять зон одновременно рассчитываются на GPU, но отдельно друг от друга. И финальная картинка получается уже адаптированной для очков VR, пост-обработки не требуется. Вырезание невидимых областей, сжатие и оптимизация разрешения областей позволили NVIDIA увеличить производительность пиксельных шейдеров в 1,3-2 раза у архитектуры Maxwell. Поскольку Pascal поддерживает Viewports, технологию Multi-Resolution Shading можно использовать и здесь. Но NVIDIA расширила ее функциональность в архитектуре Pascal, теперь появились новые сценарии, когда имеет смысл использовать Viewports.

До 16 Viewports и Simultaneous Multi Projection

Кроме очков VR расчет 3D-сцены с разных углов обзора полезен, например, при использовании нескольких мониторов друг с другом или изогнутых панелей. Системы с несколькими мониторами распространены не так широко, но NVIDIA нацелилась решить проблему при использовании более одного монитора. Расчет 3D-сцены на 2D-пространство мониторов не учитывает углы расположения мониторов. NVIDIA использовала упомянутые Viewports еще с архитектуры Maxwell (там NVIDIA предусмотрела несколько Viewports для реализации Multi-Resolution Shading, как описано выше). Если у Maxwell поддерживаются 9 viewports, в архитектуре Pascal - уже 16 viewports. Технология Simultaneous Multi Projection позволяет выводить на каждый монитор свое изображение. Демонстрация на нескольких мониторах как раз приведена на видеоролике:

Технология интересна не только для конфигураций с несколькими мониторами, но и в приложениях VR. Здесь 16 viewports можно использовать для вычисления двух кадров для 3D-дисплея за один проход (Single Pass Stereo). Кроме того, технология Simultaneous Multi Projection позволяет заранее оптимизировать картинку под оптическую систему VR-оков. Здесь NVIDIA использует так называемую технологию Lens Matched Shading. Каждый кадр разделяется на четыре зоны, которые не планарные, а искривленные, непосредственно под оптику очков, чтобы не вычислять лишние пиксели. Архитектура Pascal поддерживает 16 Viewports, поэтому возможен расчет восьми зон на каждый глаз. В данном случае для поддержки Simultaneous Multi Projection NVIDIA предложит SDK, через который разработчики смогут задействовать технологию. Кроме конфигураций с несколькими мониторами и VR-очками будут поддерживаться и дисплеи с изогнутой панелью. В панели драйверов NVIDIA позволит задавать кривизну дисплея или углы расположения мониторов в соответствующих конфигурациях.

Simultaneous Multi Projection

Simultaneous Multi Projection является частью движка PolyMorph Engine 4.0. В конвейере рендеринга этап SMP выполняется до растеризации и расчета пиксельных шейдеров (Input Assembler —> Vertex/Tessellation/ Geometry Shader —> SMP —> Setup Raster —> Pixel Shader). В результате в приложениях VR видеокарта GeForce GTX 1080 может демонстрировать двукратный прирост производительности по сравнению с GeForce GTX Titan X при трехкратном увеличении эффективности. Сама технология Simultaneous Multi Projection обеспечивает прирост производительности от 50 до 60 процентов.

Прирост производительности можно оценить в цифрах. В случае очков Oculus Rift разрешение 4,2 мегапикселя консервативный режим NVIDIA позволяет снизить до 2,8 МП, что дает до 1,5x больше пиксельной пропускной способности. Данные геометрии необходимо рассчитывать только один раз, поэтому Single Pass Stereo дает двукратный прирост соответствующей пропускной способности. Если верить NVIDIA, технология Simultaneous Multi Projection работает чуть более эффективно, чем Multi-Resolution Shading, но MRS нельзя заменить SMP (и наоборот), поскольку технологии ориентированы на разные сферы применения, хотя обе призваны экономить вычислительные ресурсы и повышать производительность.

Технология Simultaneous Multi Projection тоже может использоваться, с одной стороны, для рендеринга картинки для очков VR, с другой стороны она также поддерживает классические мониторы (полезно, например, для стриминга). И наоборот.

Наличие тысяч потоковых процессоров дает огромный потенциал производительности, но разработчикам программного и аппаратного обеспечения приходится нелегко, чтобы задействовать все имеющиеся потоковые процессоры. Проблем возникает еще больше, если требуется сочетать вычисления вместе с традиционными графическими расчетами. Не так-то легко свести разные типы вычислений вместе.

Асинхронные вычисления будут играть весьма существенную роль в будущем. AMD разработала выделенный аппаратный блок Asynchronous Shaders, который является частью архитектуры Graphics Core Next. В результате AMD выигрывает в некоторых играх DirectX 12, по крайней мере, если они используют Asynchronous Shaders. Хорошим примером можно назвать Ashes of the Singularity. NVIDIA с архитектурой Pascal представила новую технологию динамической балансировки нагрузки (Dynamic Load Balancing). Она призвана помочь, в частности, в ситуациях, когда задачи и вычисления необходимо стартовать одновременно, но их вычислительная сложность очень сильно различается. Предыдущие технологии статического распределения (Static Partitioning) в Maxwell давали намного меньшую эффективность по сравнению с динамической балансировкой нагрузки, то есть они хуже задействовали имеющиеся вычислительные блоки.

Вытеснение (Preemption)

Поскольку на графическом процессоре могут выполняться параллельно несколько задач, иногда имеет смысл остановить одну задачу, чтобы выполнить другую, более чувствительную к задержкам. А потом доделать остаток первой задачи. В таких ситуациях срабатывает механизм вытеснения (Preemption), который очень похож на вытесняющую многозадачность в мире операционных систем. Здесь любой процесс может прерываться в определенное время, независимо от того, завершил он задание или нет. Как правило, вычисления можно разделить на временные промежутки, в которые и выполняется вытеснение. Если процесс прерван, то его регистры и кэши переносятся из GPU в видеопамять. Как только процесс вернется на исполнительные ресурсы, он продолжится с прерванного места.

Чтобы подобный механизм был как можно более гибким, очень важна возможность прерывать вычисления в любой момент. То есть уменьшить размер временных промежутков до минимума. Раньше выполнялось на уровне треугольников (или вызовов Draw Call), то есть снять процесс можно было только по завершении обработки треугольника. Теперь выполнение вытеснения возможно на уровне пикселей. То есть процесс на графическом конвейере может остановиться на уровне ближайшего пикселя, после чего он будет восстановлен со следующего пикселя. Ранее такое тонкое разбиение не было возможным.

Вытеснение на архитектуре Pascal

Что касается вычислений, в архитектуре Maxwell присутствовал эквивалент попиксельного вытеснения на уровне потоков (thread). В Pascal он тоже имеется, но добавлено вытеснение на уровне инструкций в задачах CUDA. В драйверах NVIDIA подобная функция еще не задействована, но она будет реализована в будущем, как и попиксельное вытеснение. В результате NVIDIA удалось сократить временные промежутки с нескольких миллисекунд до уровня менее 100 мкс.

Вытеснение очень важно для приложений VR, в том числе для функции Asynchronous Timewarp. Если видеокарта не может выдавать кадры каждые 11 мс (90 кадров в секунду), ATW генерирует промежуточный кадр, используя последние данные конвейера рендеринга с коррекцией позиции головы. Такой кадр необходимо создать как можно быстрее, и здесь как раз новый механизм вытеснения должен себя показать с лучшей стороны.

Начиная с этого года важной темой становится высокий динамический диапазон (High Dynamic Range). AMD еще в прошлом году объявила, что будущие GPU компании будут поддерживать HDR. HDR описывает большие отличия в яркости между разными элементами картинки, то есть более широкий динамический диапазон по сравнению со стандартным динамическим диапазоном (SDR). В HDMI 2.0a, например, поддерживается передача потока с информацией HDR, сервис Amazon Prime Instant Video в США уже предлагает соответствующий контент, фильмы на новых 4K Blu-ray тоже должны поддерживать HDR. Наконец, сервис Netflix представил первый контент с поддержкой HDR с начала 2016 года.

Чтобы понимать отличия между HDR и SDR, следует учесть следующее. Как и в случае частоты обновления мониторов и телевизоров, производителям приходится наследовать технологии передачи картинки еще со времен ЭЛТ-мониторов. Данные технологии не предусматривают передачу дополнительной информации, такой как HDR, на мониторы. Если даже при съемке кино и телевизионных передач будет захватываться информация HDR, она будет теряться и урезаться при последующей передаче. Все это влияет на цветовое пространство, контрастность и яркость, которая обычно не превышает 100 кд/м². В результате черный цвет не получает глубину, а на ярких изображениях теряется информация.

При создании видео контент проходит через несколько этапов обработки. Сюда входит запись видео, обработка и монтаж, запись на носители и воспроизведение непосредственно на дисплее. Производители телевизоров и мониторов пытаются создавать собственные динамические профили и настройки, чтобы компенсировать потери, но все же потерянную информацию восстановить нельзя, можно разве что провести интерполяцию. Технически перед производителями дисплеев стоят серьезные проблемы, поскольку реализовать поддержку HDR напрямую пока сложно. Панели на жидких кристаллах просто не могут выдать нужную пиковую яркость, как и глубокий черный цвет, имеющийся у панелей OLED. Так что производителям еще предстоит улучшать подсветку, чтобы достичь большую динамику яркости. Приходится выставлять яркость отдельно для разных областей панели, что значительно сложнее распространенных сегодня технологий.

Для представления широкого динамического диапазона, подобно сфере аудио, разработан стандарт Dolby Vision. Он позволяет указывать максимальную яркость до 4.000 кд/м², что намного превышает современные возможности. У HDR в первой версии яркость ограничена 1.000 кд/м², а контрастность 10.000:1, цветовой охват должен составлять 75% от видимого спектра. Так что пройдут годы, прежде чем мы сможем наслаждаться подобным представлением в гостиных комнатах.

Со стороны кодеков подготовка уже началась. HEVC на сегодня является единственным «потребительским» кодеком, поддерживающим воспроизведение контента HDR. Кроме того, технология Dolby Vision позволяет использовать существующие кодеки, к которым добавляются данные. Однако такой поток могут распознавать только устройства Dolby Vision, необходимая пропускная способность увеличивается на четверть, что тоже может вызвать проблемы.

Технология HDR позволяет передавать и выводить не только большие отличия по яркости, но и больший цветовой диапазон. Сегодня распространены цветовые пространства sRGB и Adobe RGB. Но уже определены стандарты Rec. 2020 и Digital Cinema (DCI) HDR-10 UHD TV с расширенным цветовым пространством, которое приближается к возможностям восприятия человеческого глаза.

Тему HDR нельзя назвать новой для игр, как и для фильмов. В играх уже давно предпринимались попытки симулировать широкий динамический диапазон HDR, но только силами движка. Поскольку ни видеокарта, ни монитор, ни интерфейс передачи не могли передавать информацию HDR. И в играх под HDR часто понимались чересчур насыщенные эффекты освещения (с перенасыщением яркостью), которые, конечно, мало соответствуют реальному HDR. На мероприятии Editors Day NVIDIA представила вместе с разработчиками версию Rise of the Tomb Raider с поддержкой HDR. На презентации нам пришлось привыкать к тому, что яркие области буквально ослепляли. Но, возможно, за все годы глаз привык к стандартному динамическому диапазону, поэтому ему сложно перестраиваться на более реалистичное отображение игры.

NVIDIA в архитектуре Pascal поддерживает 10-битное кодирование и декодирование с поддержкой HDCP. Декодирование HEVC возможно в режиме 4K на 60 fps с 10/12 битами. Кодирование HEVC ограничено 4K на 60 fps с 10 битами (например, запись стриминга или просто сигнала видео).

В рамках новой архитектуры Pascal NVIDIA пересмотрела видеовыходы GeForce GTX 1080 и GTX 1070. Обе карты оснащены выходами HDMI 2.0b и DisplayPort 1.3/1.4. В случае DisplayPort 1.3 подразумевается уже принятый стандарт, насчет DisplayPort 1.4 NVIDIA указывает готовность к его поддержке, так как VESA еще не приняла финальные спецификации. Но, как ожидается, NVIDIA будет полностью поддерживать стандарт во всех деталях. Впрочем, это касается только обязательных компонентов DisplayPort. Вряд ли от NVIDIA можно будет ожидать поддержку опциональных компонентов, таких как Adaptive Sync.

Первые мониторы с поддержкой HDR, как надеется NVIDIA, выйдут в начале 2017. Поэтому пройдет некоторое время, прежде чем геймеры смогут насладиться HDR. Если же вы хотите собрать домашний кинотеатр с поддержкой HDR, то придется потратиться. Чтобы можно было вести стриминг с игрового ПК, оснащенного видеокартой Pascal, на телевизор в гостиной комнате с поддержкой HDR, NVIDIA добавит поддержку GameStream HDR. Приставки Shield на Android TV тоже смогут принимать 10-битный поток HVEC. NVIDIA планирует добавить данную функцию летом 2016.

AMD приводит следующую таблицу совместимости с функциями HDR:

| Разрешение | 1080p на 120 Гц 10bpc |

1440p на 60 Гц 10bpc |

2160p на 30 Гц 10bpc |

2160p на 60 Гц 10bpc |

|---|---|---|---|---|

| Линейки GPU: | Radeon R9 300 | Radeon R9 300 | Radeon R9 300 | Radeon R9 300 |

| Видеовыходы: | HDMI 1.4b DisplayPort 1.2 |

HDMI 1.4b DisplayPort 1.2 |

HDMI 1.4b DisplayPort 1.2 |

HDMI 1.4b DisplayPort 1.2 |

| Контент: | Игры Фото |

Игры Фото |

Игры Фото |

Игры Фото Фильмы |

Если же вы приобрели видеокарту NVIDIA на GPU Maxwell, вам наверняка будет интересно, какие изменения произошли с архитектурой Pascal. NVIDIA тоже представила таблицу, в которой сравнила GeForce GTX 980 с GTX 1080.

| Видеокарта | GeForce GTX 980 | GeForce GTX 1080 |

|---|---|---|

| H.264 Encode | Да | Да (2x 4K@60 Гц) |

| HEVC Encode | Да | Да (2x 4K@60 Гц) |

| 10 Bit HEVC Encode | Нет | Да |

| H.264 Decode | Да | Да (4K@120 Гц до 240 Мбит/с) |

| HVEC Decode | Нет | Да (4K@120 Гц/ 8K@30 Гц до 320 Мбит/с) |

| VP9 Decode | Нет | Да (4K@120 Гц до 320 Мбит/с) |

| MPEG2 Decode | Да | Да |

| 10 Bit HEVC Decode | Нет | Да |

| 12 Bit HEVC Decode | Нет | Да |

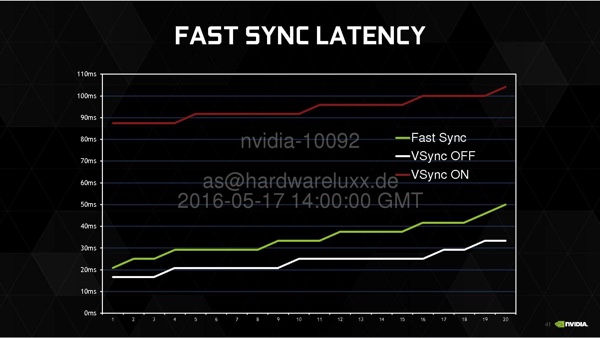

Проблему отсутствия синхронизации между видеовыходом видеокарты и панелью дисплея производители решили уже давно: AMD с технологией FreeSync, а NVIDIA – с G-Sync. Несмотря на технологии синхронизации, V-Sync продолжает оставаться популярной. Особенно это касается игр с очень высоким уровнем fps, таких как Counter-Strike, Dota 2 и других, где современные high-end видеокарты способны выдавать сотни fps.

Fast Sync на GeForce GTX 1080

Пользователь может выбирать, активировать V-Sync или нет. Оба варианта имеют свои преимущества и недостатки. При активации V-Sync предотвращается эффект разрыва кадра (наложение двух последовательных кадров со смещением), но при этом увеличивается игровая задержка ввода из-за удержания кадров. Отключение V-Sync снижает задержки ввода, но может привести к заметным эффектам разрыва кадра. NVIDIA разработала метод, при котором буфер рендеринга отделяется от буфера дисплея. NVIDIA называет его разделением рендера и дисплея. Буфер разделяется на три зоны: Front Buffer, Back Buffer и Load Rendered Buffer. Все три буфера используются для хранения кадров, но на дисплей отправляется только самый свежий готовый кадр.

В случае Fast Sync кадры больше не удерживаются, поэтому и задержка уменьшается. По задержкам технология Fast Sync приближается к уровню с выключенной V-Sync. При этом разрыв кадра с Fast Sync по-прежнему невозможен. Интересно, что технология Fast Sync будет предложена не только на последних видеокартах с GPU Pascal, но и на старых архитектурах. Например, все GPU Maxwell будут поддерживать Fast Sync. Про более старые архитектуры пока нет информации.

Fast Sync в деталях

Ниже мы рассмотрим механизм работы Fast Sync в деталях. Игровой движок выдает кадр DirectX API и драйверу. Через драйвер на GPU передаются AnimationTimeline и Draw Calls, после чего готовый кадр передается в кадровый буфер. Затем этот кадр будет выведен на дисплей при очередном обновлении.

В случае активной технологии V Sync игровому движку указывается просчитывать столько кадров, сколько можно вывести на дисплее (60 fps, 90 fps, 120 fps, 144 fps и т.д.). В результате ввод пользователя (движение мыши или нажатие клавиши на клавиатуре) может обрабатываться с задержкой. С выключенной технологией V-Sync выводится столько кадров, сколько успевает просчитывать видеокарта, задержки минимальны, но могут появиться артефакты разрыва кадров.

NVIDIA теперь разделяет вывод кадров рендера и вывод на дисплей. Отсюда и название технологии Decoupled Render and Display. На этапе рендеринга кадр проходит полный конвейер рендеринга, то есть от игрового движка через GPU, после чего поступает во временный кадровый буфер. Этап дисплея отделен и работает автономно. Для игрового движка все выглядит так, как будто технология V-Sync выключена. То есть движок может просчитывать столько кадров, сколько возможно, соответственно, и ввод пользователя на этих кадрах будет учитываться. Технология Fast Sync будет отслеживать кадровый буфер и решать, какой из кадров подходит для синхронизации на экране дисплея, соответствующий кадр и будет подан.

Для реализации технологии NVIDIA разделила кадровый буфер на три части. Front Buffer и Back Buffer работают так, как и в случае технологии V-Sync с двойной буферизацией. В Front Buffer кадр сканируется для вывода на дисплей, в Back Buffer сохраняется создаваемый кадр из конвейера рендеринга. При использовании V-Sync между буферами происходит обмен кадров. В новом буфере Last Rendered Buffer сохраняются все кадры, выданные Back Buffer, в том числе и наиболее свежий кадр после рендеринга для Fast Sync. То есть, по сути, происходит копирование кадров из Back Buffer в Last Rendered Buffer.

Когда Front Buffer отдаст свой кадр на дисплей, следующий кадр будет взят из Last Rendered Buffer, процесс начнется снова. Подобный механизм копирования буферов вносил бы задержку, но на самом деле буферы не копируются, а просто динамически переименовываются. В играх с высокой частотой кадров LRB и BB меняются со скоростью рендеринга кадров приложения, когда из FB будет завершен вывод кадра на монитор, нынешний LRB будет переименован в BB, чтобы выдать свежий кадр. В архитектуре Pascal за весь процесс отвечает новая логика (NVIDIA называет ее Flip Logic), но технология будет доступна и на предыдущих архитектурах.

SLI HD

В системах SLI происходит передача готовых кадров на основную видеокарту через соответствующие мостики SLI. Теоретически возможна передача через интерфейс PCI Express, но здесь пропускная способность ограничена, а задержки обычно выше, чем допускается требованиями SLI. NVIDIA обычно опирается на использование одного или двух мостиков SLI на своих видеокартах. У high-end моделей имеются два порта SLI, у карт среднего сегмента – один разъем, а видеокарты начального уровня их лишены. В ноутбуках возможна связь SLI через PCI Express, но там частота кадров и разрешение обычно ниже, поэтому особых проблем не возникает.

С появлением дисплеев высокого разрешения и частот обновления 144 Гц и выше требования к мостикам SLI возросли. Каналы мостиков SLI обычно работают на 400 МГц, то есть на той же частоте, что и схема управление видеовыходами. В прошлом такие производители, как ASUS, EVGA и MSI представляли особые мостики SLI, которые работали не на 400 МГц, а на 540 МГц. Соответствующее увеличение пропускной способности позволяло подключать мониторы с частотой обновления выше 144 Гц или разрешением 4К. Но все же эти мостики выходили за спецификации NVIDIA.

Если вы пожелаете собрать конфигурацию из нескольких мониторов с очень высоким разрешением, к которой подключить систему SLI из двух GeForce GTX 1080 или GTX 1070, то обычные мостики SLI могут и не справиться со своей задачей – пропускной способности может оказаться недостаточно. В таких случаях придется покупать новые мостики SLI HD, которые NVIDIA собирается предлагать. Мостики будут доступны в разных длинах. То есть вы можете выбирать нужный мостик, в зависимости от расстояния между видеокартами в слотах. Если вы переходите на другую материнскую плату с другим расстоянием, то придется покупать новый мостик. NVIDIA не планирует предлагать гибкие мостики, поскольку их нельзя сделать достаточно качественными. Цены NVIDIA пока тоже не называет.

NVIDIA рекомендует использовать старые мостики для разрешений до 2.560 x 1.440 пикселей с частотой обновления до 60 Гц. Если вы планируете играть в разрешении выше 2.560 x 1.440 пикселей с частотой обновления 120 Гц и выше, то следует использовать новые мостики.

| Разрешение | 1.920 x 1.080 пикселей | 2.560 x 1.440 пикселей до 60 Гц |

2.560 x 1.440 пикселей до 120 Гц |

4K | 5K | Surround |

|---|---|---|---|---|---|---|

| Стандартный мостик | Ok | Ok | - | - | - | - |

| LED-мостик | Ok | Ok | Ok | Ok | - | - |

| Новый мостик | Ok | Ok | Ok | Ok | Ok | Ok |

В галерее выше представлена комбинация SLI из двух видеокарт GeForce GTX 1080 с мостиками двух размеров. NVIDIA подтверждает пользу от новы мостиков SLI HD результатами тестов. Ниже приведены измерения времени вывода кадров, полученные с помощью FCAT в системе SLI:

Черная линия демонстрирует довольно широкий разброс времени вывода кадров со старым мостиком SLI, синяя линия оказалась намного более плавной. Для тестов использовалась игра NVIDIA Middle-earth: Shadow of Mordor в разрешении 11.520 x 2.160 пикселей.

В новом интерфейсе DirectX 12 произошли некоторые изменения, касающиеся работы систем multi-GPU. Конфигурации Implicit SLI ограничены двумя GPU, но NVIDIA позволяет использовать и больше GPU (например, для Competitive Benchmarking). Ниже мы рассмотрим некоторые особенности.

С DirectX 12 Microsoft добавила три режима совместного использования видеокарт. Самый простой случай предусматривает поочередный рендеринг кадров (AFR) на одинаковых видеокартах, что известно по существующим режимам AMD и NVIDIA. Данный режим ограничивает возможности разработчиков, но вместе с тем и предотвращает потенциальные ошибки из-за более глубокого доступа к аппаратным ресурсам. Кроме того, большая часть работы здесь выполняется на уровне драйвера, а не DirectX 12.

Презентация EMA в DirectX 12

DirectX 12 обеспечивает более глубокий доступ к «железу» даже в системах multi-GPU. Для этого Microsoft представила режим Explicit Multi-Adapter (EMA). В нем игровые разработчики явно задают параметры поддержки multi-GPU. Для каждого одиночного GPU определяется доступ к памяти, описывается взаимодействие GPU между собой – и вся эта поддержка должна быть запрограммирована заранее. Ответственность за работу связки видеокарт теперь полностью лежит в руках разработчиков, что привносит определенные риски. Дополнительные усилия разработчиков не стоит недооценивать, а ошибки должен будет исправлять разработчик, а не Microsoft, AMD или NVIDIA.

В EMA возможны два разных режима: Linked Mode и Unlinked Mode. В режиме Unlinked Mode обеспечивается базовая функциональность EMA, в режиме Linked Mode функциональность расширяется, но ограничения по используемому в комбинации «железу» становятся более строгими. Данный режим очень похож на традиционные SLI и CrossFire, только под DirectX 12. В режиме Unlinked Mode вы можете комбинировать разные видеокарты, в том числе и от разных производителей. Возможна комбинация дискретного и интегрированного GPU.

В режиме Unlinked Mode каждый графический процессор считается самостоятельной аппаратной единицей, со своей памятью, командным процессором и т.д. EMA под DirectX 12 позволяет обмениваться данными между аппаратными единицами, причем на глубоком уровне, а не просто готовыми кадрами. Можно обмениваться частично просчитанными кадрами или данными в буферах, что позволяет выйти на новые уровни совместного рендеринга на нескольких GPU. На первый взгляд все звучит просто, стал возможен обмен данными, что открывает доступ к алгоритмам, ранее недоступным. Но на практике все сложнее.

Данные придется передавать по интерфейсу PCI Express, что намного медленнее связи между GPU и локальной видеопамятью, да и задержки довольно большие. Так что разработчикам следует определить, какие данные имеет смысл передавать между GPU, чтобы интерфейс PCI Express не стал «узким местом». Также следует определиться, в каком виде передавать данные. У разных производителей и даже разных поколений GPU зачастую используются разные форматы данных, которые не всегда просто перевести из одного в другой. Придется прилагать дополнительные усилия, необходимые для реализации EMA в Unlinked Mode. Впрочем, фокусом Unlinked Mode в EMA является все же совместная работа дискретных и интегрированных GPU, но и здесь могут использоваться GPU разных производителей.

Режим Linked Mode можно рассматривать как форму SLI или Crossfire под DirectX 12, аппаратные ресурсы в Linked Mode комбинируются в своего рода «видеокарту». Пользователь и игровой движок «видят» только один GPU и память. Аппаратные ресурсы здесь будут использоваться более тесно и глубоко, что открывает больше возможностей, но при этом накладываются дополнительные ограничения на «железо».

Самый большой потенциал производительности можно будет раскрыть через Linked Mode, а самый большой уровень гибкости – через Unlinked Mode. Если разработчики хотят приложить минимальные усилия, и им достаточно базовой функциональности системы multi-GPU, то достаточно поддержать простой вариант EMA, доверившись квалификации разработчиков драйверов AMD и NVIDIA. Но поскольку только разработчики игры в полной мере владеют всеми нюансами своего продукта, то поддержка Linked и Unlinked Mode тоже весьма желательна.

С архитектурой Pascal NVIDIA расширила VRWORKS API компонентом аудио. Пока что основное внимание разработчиков было уделено визуальной составляющей VR. Но для глубокого погружения звук играет не менее важную роль. Технология VRWorks Audio базируется на IRAY – но вместо виртуальных лучей света симулируются и просчитываются волны звука, что дает максимальный реализм. NVIDIA называет данную технологию Path Tracing Audio. Для этого поверхности объектов или текстуры получают контекст аудио, который описывает, насколько хорошо поверхность поглощает или отражает звуковые волны, либо каким-то образом их изменяет.

Для реалистичного объемного звука 3D необходимо учитывать расположение источников в пространстве, в том числе разницу по времени прохождения и уровню громкости между правым и левым каналами. Также следует учитывать отражения от плеч, которые оцениваются ушами и мозгом человека для определения высоты источника звука. Так что игре придется заниматься симуляцией не только визуальной составляющей, но и звука.

Нынешние GPU от NVIDIA способны просчитывать тысячи путей прохождения звука – очень похоже на метод трассировки лучей. Конечно, немалую роль здесь играет высокая вычислительная производительность GPU. NVIDIA указывает возможность работы с двенадцатью источниками эхо для, максимум, 16.000 путей прохождения звука. NVIDIA называет VRWORKS Audio первой технологией расчета 3D-аудио в реальном времени, та же TrueAudio от AMD больше ориентирована на статику. Впрочем, у Sony PlayStation VR тоже имеется дополнительный аппаратный блок, который отвечает за расчет аудио в реальном времени.

В будущем NVIDIA планирует задействовать другие методы расчета 3D-звука. К тем же технологиям затенения Voxel Accelerated Ambient Occlusion (VXAO) и освещения Voxel Global Illumination (VXGI) может добавиться контекст аудио, описывающий прохождение звуковых волн через 3D-пространство.

NVIDIA серьезно подошла к VRWORKS Audio, вскоре компания планирует выложить в Steam VR-демо под названием VR Funhouse.

С архитектурой Pascal NVIDIA обновила механизм GPU Boost. GPU Boost 3.0 отличается от предшественника GPU Boost 2.0, главным образом, следующим. У GPU Boost 2.0 использовалось фиксированное смещение частоты, в результате чего напряжение/частота изменялись линейно (см. график). У GPU Boost 3.0 можно задавать смещения частот для точек напряжения. То есть частота для каждой точки напряжения может быть выше, чем раньше, если она не упирается в предел по температуре. У GPU GP104 на GeForce GTX 1080 используются 30 таких точек. В результате частота ближе адаптируется к теоретической максимальной частоте, кривая частоты ближе к максимальным возможностям.

Сравнение между GPU Boost 2.0 и 3.0

Из-за перехода на GPU Boost 3.0 NVIDIA пришлось изменить API, который используется разработчиками таких утилит, как EVGA Precision или MSI Afterburner. Также поддерживается и сканер разгона (например, OC Scanner в утилите EVGA). Он позволяет последовательно протестировать точки напряжений, для которых определяется максимальная частота. Подобная калибровка дает очень точный анализ, на ее выполнение уходит несколько часов.

GPU Boost 3.0 в утилите EVGA Precision XOC доступна в трех режимах: в базовом режиме частота выставляется смещением. Здесь для пользователя разница с GPU Boost 2.0 невелика. В линейном режиме выставляются начальная и конечная точка кривой, а значения между ними будут интерполированы. Третий режим – ручной. В нем каждая точка напряжения выставляется вручную.

GPU Boost 3.0 в деталях

Рассмотрим работу GPU Boost 3.0 более детально. Поскольку в тексте и изображениях разобраться не так легко, мы добавили в конце страницы видеоролик (на немецком).

Отметим, что утилита EVGA Precision с поддержкой GPU Boost 3.0 очень похожа на предшественника. Кроме обзора данных с наиболее важных сенсоров и текущей частоты GPU и памяти, можно видеть напряжение и температуру GPU. Здесь же можно устанавливать и смещение, знакомое нам по архитектуре Maxwell. Максимальные уровни энергопотребления и температуры выставляются в процентах, но в случае температуры здесь налицо ошибка, так как она регулируется не в процентах, а в градусах Цельсия.

Планка Power Target регулируется от 50 до 120%, что эквивалентно энергопотреблению видеокарты от 90 до 216 Вт. Целевую температуру можно регулировать в диапазоне 60-91 °C. Пользователи могут регулировать приоритет ограничения по энергопотреблению или температуре. Или сразу по двум значениям – но все это уже нам хорошо известно.

Смещение частот GPU и памяти можно выставить в диапазоне от -200 до +1.200 МГц или от -502 до +1.000 МГц. Конечно, максимальные значения без альтернативных способов охлаждения вряд ли достижимы.

Если нажать на правую желтую стрелку рядом с надписью "Precision XOC", вы перейдете к новым возможностям GPU Boost 3.0. Здесь можно выставить три режима работы. В базовом режиме разгон выполняется так же, как и на видеокартах архитектуры Maxwell. То есть вручную выставляется смещение частоты, которое можно указать для любой точки напряжения – оно распространится на все 30. Пользователю следует только указать частоту для любой точки, остальную кривую построит утилита.

В линейном режиме указывается начальная и конечная точка для функции частоты и напряжения. Затем утилита определяет линейную кривую для напряжений от 0,862 до 1,162 В. Ничего больше делать не придется. В информационной панели под графиком можно посмотреть, какая частота смещения была задана для каждой точки напряжения.

Но самым интересным является ручной режим GPU Boost 3.0. Здесь пользователь может указать частоту для каждой точки напряжения. То есть вам следует пройти все точки и указать соответствующую частоту. Конечно, следует убедиться, что настройки будут рабочими.

В API GPU Boost 3.0 встроен автоматический процесс, позволяющий определить максимальные частоты для напряжений. Достаточно выбрать точку напряжения, после чего нажать "RUN" для запуска плагина Furmark, который проверит стабильность работы видеокарты. В тесте не должно появляться артефактов. Пользователь может настраивать продолжительность теста, начальное и конечное смещение частоты, а также шаг повышения частоты. Чем меньше будет шаг, тем дольше будет проводиться тест. Если вы выставите смещение на слишком высоком уровне, то система может «вылететь», поэтому с максимальными значениями следует быть осторожным.

NVIDIA планирует добавить в API, что будет поддержано в той же утилите EVGA, полностью автоматический режим, в котором программа будет автоматически определять максимальные настройки. В данной версии утилиты такого режима нет, он появится позднее.

Диапазон напряжение GPU тоже можно задавать вручную, от минимума 0,862 В до максимума 1,162 В. От уровня 90% утилита будет предупреждать пользователя, поскольку при продолжительной работе GPU может получить повреждения, также может сократиться срок службы. В любом случае, NVIDIA дает пользователям такую возможность.

Кто бы мог подумать, но из простого снятия скриншотов в играх развилось целое направление компьютерного искусства: Game Photography. Художники используют все более сложные движки, оптимизируют их настройки (например, добавляют вручную фильтры или выкручивают такие параметры, как уровень детализации и т.д.). После чего выставляют скриншоты в Интернет.

Конечно, подобные настройки чаще всего выходят за рамки официальной поддержки и являются своего рода хаком. Неплохо было бы вооружить художников инструментом, которая обеспечивала бы соответствующую поддержку и обилие различных опций для настройки игровых движков. Такую утилиту как раз представила NVIDIA под названием ANSEL. ANSEL – это не сокращение, утилита названа в честь американского фотографа Энселя Адамса, который специализировался на съемке пейзажей и природы. Собственно, на эту же сферу нацелена и Game Photography.

NVIDIA ANSEL

С утилитой ANSEL можно в любой момент остановить игровое время. Затем можно произвольно менять угол обзора сцены. Конечно, в пределах допустимого в самой игре – за ее возможности ANSEL выйти не может. Что связано, кроме всего прочего, и с предотвращением читов, используя ANSEL. Также ANSEL может накладывать различные фильтры постобработки. ANSEL позволяет получать скриншоты в разрешении до 61.440 x 34.560 пикселей. В теории возможно и более высокое разрешение, но файлы уже занимают объем в несколько гигабайт. На GPU GeForce GTX подобные скриншоты создаются за считанные секунды.

Кроме разрешения важно и то, что на скриншотах может сохраняться информация HDR. То есть более высокая контрастность, яркость и расширенный цветовой охват. NVIDIA предлагает и несколько префильтров. Например, зернистость для эффекта фильма или сепия. При желании можно создавать панорамы на 360°, которые можно будет просматривать на смартфоне или очках VR.

ANSEL будет работать на многих видеокартах NVIDIA, не только на GPU Pascal. NVIDIA опубликовала детальный список. Поддержка ANSEL должна обеспечиваться и со стороны игрового движка. Здесь NVIDIA говорит о сотрудничестве с разработчиками The Division, The Witness, Law Breakers, The Witcher: Wild Hunt, Paragon, No Man's Sky и Unreal Tournament. Поддержка других игр тоже ожидается в будущем. На интеграцию ANSEL в той же игре The Witness потребовалось меньше 40 строчек кода.

Теперь, когда мы детально рассмотрели технологии GeForce GTX 1080 и архитектуру, позвольте перейти к практическому использованию GeForce GTX 1080.

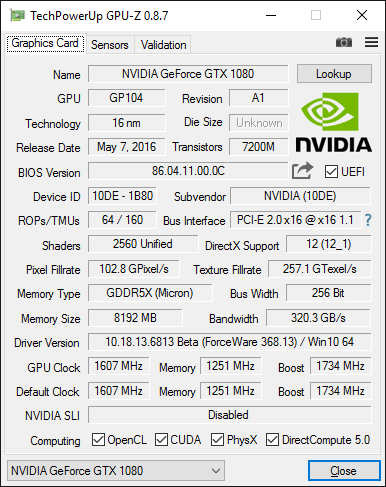

На скриншоте GPU-Z подтверждаются спецификации GeForce GTX 1080. Базовая частота составляет указанные 1.607 МГц, частота Boost – 1.734 МГц. 8 Гбайт памяти GDDR5X работают на частоте 2.500 МГц. Остальные спецификации GPU-Z распознает корректно. Среди них – пропускная способность памяти 320,3 Гбайт/с, количество потоковых процессоров (2.560), конвейеров растровых операций (64), текстурных блоков (160) и т.д.

| Сравнение температур и тактовых частот | ||

|---|---|---|

| Игра | Температура | Частота |

| The Witcher 3: Wild Hunt | 83 °C | 1.809 МГц |

| Battlefield: Hardline | 82 °C | 1.809 МГц |

| Grand Theft Auto IV | 83 °C | 1.809 МГц |

| Far Cry 4 | 83 °C | 1.825 МГц |

| Total War: Attila | 83 °C | 1.825 МГц |

| Metro: Last Light Redux | 83 °C | 1.809 МГц |

| Tomb Raider | 83 °C | 1.825 МГц |

| DiRT Rally | 83 °C | 1.825 МГц |

| Middle-Earth: Shadow of Mordor | 82 °C | 1.809 МГц |

Как мы уже описывали выше, NVIDIA доработала в архитектуре Pascal механизм GPU Boost, чтобы выжать максимум из нового техпроцесса и новой архитектуры. NVIDIA гарантирует достижимость минимальной планки Boost, если соблюдаются условия по температуре и напряжению. В том числе и с установленным эталонным кулером NVIDIA.

На практике мы получили частоты, приведенные в таблице выше: NVIDIA GeForce GTX 1080 достигает целевой температуры 84 °C. Технология GPU Boost 3.0 повышает напряжение и частоту GPU, пока не будет достигнута целевая температура. Как правило, на первом этапе ограничивающим фактором является напряжение. Если через несколько минут температура достигнет целевой, то ограничивающим фактором станет уже температура.

NVIDIA гарантирует минимальную частоту Boost 1.733 МГц. У нашего образца GeForce GTX 1080 частота на практике составляла 1.809 – 1.825 МГц. Когда видеокарта еще разогревалась, частота могла возрастать до 1.875 МГц. Температура GPU на протяжении наших тестов находилась в диапазоне 82-83 °C. Эталонный кулер справлялся с тем, чтобы сохранять частоту Boost на уровне выше минимального. Производительность приведена ниже в разделе тестов.

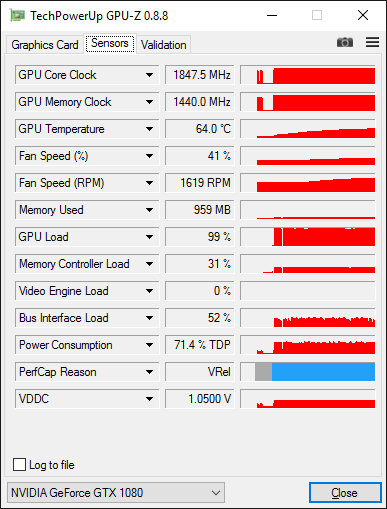

Скриншот выше хорошо описывает производительность GeForce GTX 1080. В частности, интересен нижний график, указывающий на ограничения. Синие полосы означают ограничение по напряжению. Позднее, когда видеокарта нагреется до целевой температуры, частота Boost ограничивается уже температурой (зеленые полосы). Так что в реальности наблюдается попеременное ограничение частоты Boost температурой или напряжением. К ограничениям по тепловому пакету 180 Вт мы ни разу не подошли.

| NVIDIA GeForce GTX 1080 Founders Edition | |

|---|---|

| Длина печатной платы | 266 мм |

| Длина с кулером | 266 мм |

| Толщина | 2 слота |

| Дополнительное питание | 1x 8-конт. |

| Вентиляторы | 1x 65 мм |

| Охлаждение | 1x испарительная камера |

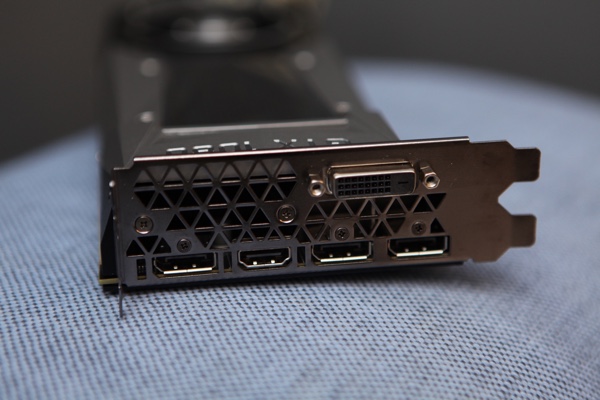

| Выходы на дисплей | 1x HDMI 2.0b 3x Displayport 1.3/1.4 1x Dual-Link-DVI |

| Пассивная работа вентиляторов в режиме бездействия | Нет |

В таблице приведены основные спецификации GeForce GTX 1080 Founders Edition. Ниже мы перейдем к рассмотрению непосредственно самой видеокарты.

После презентации GeForce GTX 1080 Интернет наводнили слухи, повествующие о двух эталонных версиях GeForce GTX 1080. Но эталонная версия только одна, а именно NVIDIA GeForce GTX 1080 Founders Edition. Именно эта видеокарта Founders Edition будет доступна от партнеров с 27 мая. Со временем партнеры представят видеокарты с альтернативными кулерами. Но в первые дни на рынке будет доступна только GeForce GTX 1080 Founders Edition. В данном случае совершенно не важно, покупаете ли вы видеокарту напрямую от NVIDIA или через партнеров.

Но важно следующее: видеокарта GeForce GTX 1080 Founders Edition будет продаваться по рекомендованной цене $699. А самые дешевые видеокарты от партнеров с альтернативными системами охлаждения появятся в продаже от $599. С видеокартой GeForce GTX 1070 ситуация схожая. Опять же, здесь будет Founders Edition по цене $449. Рекомендованные розничные цены GeForce GTX 1070 с альтернативной системой охлаждения составят $379.

Так что если вы решите приобщиться к GeForce GTX 1080 с первого дня, то будет доступен только один вариант, который мы как раз детально рассмотрим ниже.

NVIDIA GeForce GTX 1080

Дизайн и упаковка тщательно продуманы NVIDIA. Видеокарта GeForce GTX 1080 поставляется в надежной картонной коробке. Крышка довольно легко снимается, после чего открывается вид на саму карту в ложе. В отличие от многих партнеров, NVIDIA не стала расписывать функции видеокарты на коробке.

NVIDIA GeForce GTX 1080

Только после снятия крышки в глаза бросается лозунг "Inspired by gamers. Built by NVIDIA", который можно перевести как «Вдохновлена геймерами, создана NVIDIA». Также NVIDIA не стала прилагать какие-либо переходники для HDMI, DisplayPort или DVI. Нет и переходников питания PCI Express, руководства по быстрому старту или CD с драйверами – по крайней мере, у нашего образца.

NVIDIA сохранила дизайн GeForce GTX 1080 очень похожим на предыдущее поколение, но в деталях имеются различия. Видеокарта по-прежнему имеет черно-серебристую отделку, в качестве материалов используются алюминий, оргстекло и хромированный металл.

GeForce GTX 1080 имеет длину 266 мм, это касается и кулера, и печатной платы. Высота PCB и карты (без слота PCI Express) составляет 100 мм. NVIDIA сохранила габариты предыдущей карты, которую нельзя было назвать громоздкой. Толщина видеокарты тоже вполне разумная – два слота.

Сзади PCB защищена металлической пластиной. Она полностью накрывает печатную плату. NVIDIA сделала поверхность пластины цельной, хотя заметны выступающие линии, но они добавлены, скорее всего, для украшения. Можно заметить тисненый логотип NVIDIA и надпись "GeForce GTX 1080". Причем они правильно ориентированы после установки видеокарты в корпус – что наблюдается далеко не у всех партнеров NVIDIA.

Когда две GeForce GTX 1080 работают в SLI, они могут вплотную прилегать друг к другу (если слоты PCI Express так расположены). В таких ситуациях вентилятор верхней видеокарты не будет получать достаточно свежего воздуха. NVIDIA уже заметила подобную проблему с видеокартами GeForce GTX Titan X, у которых пользователь мог убрать часть задней пластины. В случае GeForce GTX 1080 снимается уже не малая часть пластины, а примерно половина. Такой шаг дает радиальному вентилятору зазор в несколько миллиметров, через который он может получать больше свежего воздуха.

Рядом со слотовой заглушкой на кожухе нанесена блестящая надпись GeForce GTX 1080, которая сразу же бросается в глаза. Можно отметить и новый дизайн кулера, который стал более угловатым. Заметны и дополнительные (фальшивые) вентиляционные отверстия сверху и снизу, которые приближают дизайн видеокарты к гоночным болидам.

За окном из оргстекла на лицевой панели можно видеть радиатор. Он оснащен тонкими ребрами охлаждения из алюминия, которые ориентированы вдоль видеокарты. Вентилятор продувает воздух через радиатор видеокарты в направлении слотовой заглушки, он забирает тепло от ребер радиатора и выбрасывается наружу.

Встроенный радиальный вентилятор NVIDIA располагается в задней части видеокарты, он имеет диаметр 65 мм. Вентилятор нагнетает свежий воздух внутрь кожуха видеокарты, после чего продувает его в сторону слотовой заглушки, как мы указали выше. В режиме бездействия вентилятор вращается на 1.100 об/мин, но полностью не останавливается. Под нагрузкой скорость вращения составляет 2.200 об/мин и выше.

Контур вентилятора подчеркнут хромированным ободком, то же самое касается сердечника. Подобные акценты придают видеокарте элегантный внешний вид. Также на алюминиевом корпусе можно заметить винты Torx.

Продолжим детальное рассмотрение GeForce GTX 1080:

Вид сбоку не выдает ничего особого. Толщина в два слота типична для high-end видеокарт. Только водоблоки СВО обычно оказываются тоньше.

Слотовая заглушка вроде бы кажется стандартной. Но NVIDIA обновила спецификации HDMI и DisplayPort до самых последних стандартов. А старый порт DVI лишился аналоговых контактов. Впрочем, вряд ли геймеры будут жалеть об исчезновении поддержки VGA. Видеокарта GeForce GTX 1080 предлагает 3x DisplayPort 1.3/1.4, 1x HDMI 2.0b и 1x двухканальный DVI-D.

Оставшееся пространство на слотовой заглушке заполнено треугольными отверстиями. NVIDIA добавила их, чтобы горячий воздух мог покидать пределы корпуса ПК, не нагревая другие компоненты внутри. Подобный дизайн системы охлаждения NVIDIA использует уже многие годы.

В передней части видеокарты NVIDIA оставила отверстие. Небольшая часть воздуха, забираемого радиальным вентилятором, может выбрасываться через это отверстия, оставаясь в корпусе ПК. Здесь, опять же, заметно сходство дизайна с итальянскими гоночными болидами.

На верхнем торце видеокарты можно видеть логотип GeForce GTX NVIDIA 1080, который подсвечивается зеленым во время работы. Так что если в корпусе вашего компьютера имеется боковое окно, вы сможете любоваться видеокартой с подсветкой.

Дополнительное питание на видеокарту подается через один 8-контактный разъем PCI Express. Он обеспечивает мощность до 150 Вт. Также 75 Вт могут подаваться через слот PCI Express, в результате чего видеокарта может потреблять до 225 Вт мощности. NVIDIA указывает тепловой пакет 180 Вт, так что имеется запас 45 Вт.

Впрочем, 8-контактный разъем PCI Express может выдерживать и намного больший ток, чем для заявленной мощности 150 Вт. Данный уровень производители блоков питания и видеокарт считают номинальным, но, как показывает опыт, иногда его превышают. В любом случае, для видеокарты GeForce GTX 1080 мы указываем номинальную мощность 225 Вт и тепловой пакет 180 Вт.

NVIDIA установила на GeForce GTX 1080 два разъема SLI. Но если вы будете использовать конфигурацию SLI в паре с несколькими мониторами и/или с высокой частотой обновления, то потребуются новые мостики SLI, которые мы рассмотрели чуть выше. Мостики SLI HD обеспечивают более высокую пропускную способность для передачи готовых кадров со вторичной видеокарты на основную. С помощью двух обычных мостиков SLI вы можете объединить три или четыре видеокарты GeForce GTX 1080.

Перед тем, как мы приступим к разборке видеокарты GeForce GTX 1080, позвольте сравнить новый дизайн кулера с предшественником Maxwell.

NVIDIA GeForce GTX 1080

По базовому дизайну особых изменений не произошло. NVIDIA продолжила использовать сочетание серебристых (алюминий), черных (лакированный алюминий) и хромированных (в области вентилятора) оттенков. Также NVIDIA сделала кожух более угловатым, в результате он получил более агрессивный внешний вид. Конечно, NVIDIA подчеркивает качественные материалы и высокое качество изготовление, хотя вряд ли они интересны большинству геймеров, кому требуется максимальная производительность в играх и эффективное охлаждение.

Мы начали разборку с задней части металлической пластины GeForce GTX 1080. Ее можно легко снять, чтобы вторая видеокарта в конфигурации SLI получала больше свежего воздуха. Но на такой шаг следует идти только в том случае, если две видеокарты располагаются в соседних слотах PCI Express (вернее, в слотах, расположенных через слот). Для снятия части задней пластины необходимо открутить восемь маленьких крестовых винтов. Другие крестовые винты удерживают вторую половину задней пластины, их тоже можно легко открутить.

Затем придется заняться винтами с шестигранной головкой, которые удерживают кулер видеокарты. Здесь используются винты размером M4.0, особых проблем с поиском отвертки возникнуть не должно. Выбор подобных винтов нам кажется оправданным, поскольку шанс свернуть головку здесь ниже.

NVIDIA GeForce GTX 1080

У кулера имеется большое количество контактных площадок для компонентов PCB. На них NVIDIA нанесла теплопроводящие прокладки. По прокладкам хорошо заметна раскладка чипов памяти, они отводят тепло и от компонентов подсистемы питания в задней части видеокарты. GPU контактирует с медным никелированным основанием испарительной камеры. В ней под действием тепла испаряется жидкость, которая передает тепло радиатору в верхней части камеры, конденсируясь. Затем за отведение тепла отвечает уже крупный радиатор.

Без кулера можно рассмотреть PCB во всех деталях. NVIDIA выбрала сравнительно простой дизайн печатной платы, партнеры компании обычно разрабатывают более сложные дизайны. На левой стороне PCB располагаются компоненты, отвечающие за различные видеовыходы. По центру установлен GPU, окруженный чипами памяти. Последняя треть платы справа выделена под компоненты подсистемы питания.

Сзади PCB мы не видим ничего особого. Здесь NVIDIA расположила несколько сотен резисторов, высота которых намного меньше, чтобы конфликтовать с задней пластиной. Здесь по резисторам можно догадаться, какие компоненты установлены с противоположной стороны печатной платы: GPU, память и т.д.

Восемь чипов памяти емкостью 1 Гбайт окружают GPU с трех сторон. Они находятся на одинаковом расстоянии от GPU, что обеспечивает почти одинаковое время передачи сигналов – важный параметр для корректной работы подсистемы памяти. Упаковка GPU после моделей с HBM кажется непримечательной. На зеленой подложке располагаются дополнительные транзисторы.

GPU на видеокарте GeForce GTX 1080 имеет маркировку GP104-400-A1. Так что перед нами чип с первым степпингом. Он был произведен на заводах TSMC в 14 неделю. У видеокарт GeForce GTX 1070 мы наверняка получим немного иную конфигурацию чипа, который может называться, например, GP104-300.

Чипы памяти GDDR5X емкостью 1 Гбайт тоже выглядят красиво. На фотографии заметны соединения чипов памяти с GPU. Чипы памяти маркированы MT58K256M32JA-100, напряжение составляет 1,35 В. Упаковка FBGA использует 190 контактов, рабочий диапазон заявлен от 0 до 95 °C.

Подсистема питания GPU и памяти у эталонной версии GeForce GTX 1080 опирается на шесть фаз. Скорее всего, пять фаз выделены для питания GPU, шестая фаза зарезервирована для памяти. Подсистемы питания должно быть достаточно для теплового пакета 180 Вт, есть и некоторый запас для разгона. У первых альтернативных дизайнов PCB подсистема питания наверняка будет более мощной. Также можно видеть площадки пайки для компонентов, которые у эталонного дизайна отсутствуют.

Сзади видеокарты можно видеть и другие компоненты, которые тоже участвуют в работе подсистемы питания. Раньше здесь присутствовал контроллер механизма Boost, но NVIDIA, похоже, смогла его интегрировать в чип. В любом случае, здесь остались компоненты, влияющие на работу механизма Boost, чтобы видеокарта всегда достигала максимальной производительности.

Вернемся к задней стороне PCB, где мы уже отметили большое количество резисторов SMD. Но сразу же за GPU можно заметить и несколько конденсаторов, которые закрываются теплопроводящей прокладкой на задней пластине. При сборке кулера и задней пластины обратно следует убедиться, что все прокладки находятся на своих местах.

На данный момент информации о видеокарте GeForce GTX 1070 немного, хотя она была представлена вместе с GeForce GTX 1080 и базируется на том же GPU. Но NVIDIA немного урезала GPU, также используется и память предыдущего стандарта GDDR5.

| Обзор технических спецификаций GeForce GTX 1070 | |||

|---|---|---|---|

| Модель | NVIDIA GeForce GTX 1070 | AMD Radeon R9 Fury | NVIDIA GeForce GTX 970 |

| Цена | $449 | от 35,9 тыс. рублей от 425 евро |

от 21 тыс. рублей от 280 евро |

| Сайт производителя | NVIDIA | AMD | NVIDIA |

| Техническая информация | |||

| GPU | GP104 | Fiji XT | GM204 |

| Техпроцесс | 16 нм | 28 нм | 28 нм |

| Число транзисторов | 7,2 млрд. | 8,9 млрд. | 5,2 млрд. |

| Тактовая частота GPU (базовая) | 1.506 МГц | - | 1.050 МГц |

| Тактовая частота GPU (Boost) | 1.683 МГц | 1.000 МГц | 1.178 МГц |

| Частота памяти | 2.000 МГц | 500 МГц | 1.750 МГц |

| Тип памяти | GDDR5 | HBM | GDDR5 |

| Объём памяти | 8 GB | 4 GB | 4 GB |

| Ширина шины памяти | 256 бит | 4.096 бит | 224 + 32 бит |

| Пропускная способность памяти | 256 Гбайт/с | 512,0 Гбайт/с | 224 Гбайт/с |

| Версия DirectX | 12 | 12 | 12 |

| Потоковые процессоры | 1.920 | 3.584 | 1.664 |

| Текстурные блоки | 120 | 224 | 104 |

| Конвейеры растровых операций (ROP) | 64 | 64 | 64 |

| Тепловой пакет | 150 Вт | 275 Вт | 145 Вт |

| SLI/CrossFire | SLI | CrossFire | SLI |

NVIDIA на презентации GeForce GTX 1080 указала только вычислительную мощность 6,5 TFLOPS для видеокарты GeForce GTX 1070 и наличие 8 Гбайт видеопамяти GDDR5. Из данной производительности можно сделать вывод о частоте 1,587 МГц при наличии 2.048 потоковых процессоров. Но пока не совсем понятно, какую именно конфигурацию GPU GP104 NVIDIA выберет для GeForce GTX 1070.

Обновление:

Между тем появились некоторые технические подробности о видеокарте GeForce GTX 1070. Она будет базироваться на GPU GP104-200 с 1.920 потоковыми процессорами. Также GPU будет содержать 120 текстурных блоков и 64 конвейера растровых операций (ROP) – последнее указывает на ширину интерфейса памяти 256 бит. Насчет базовой частоты информации нет, но частота Boost составил 1.600 МГц. В таком случае видеокарта будет обеспечивать вычислительную производительность 6,5 TFLOPS. 8 Гбайт памяти GDDR5 будут работать на 2.000 МГц, что даст пропускную способность 256 Гбайт/с. Тепловой пакет составит 150 Вт.

Кроме вычислительной производительности и цены пока известно мало подробностей. NVIDIA рекомендует цену $449 за Founders Edition и $379 за модели GeForce GTX 1070 с альтернативными системами охлаждения. Видеокарта будет доступна с 10 июня, ближе к этой дате мы намереваемся узнать все подробности.

Мы существенно обновили программное обеспечение в виде игр и тестов, но аппаратное обеспечение осталось, по большей части, прежним. Чтобы наша тестовая система была максимально приближена к практическим условиям, мы проводили тесты в закрытом корпусе. Операционная система Windows 10 была установлена на SSD, но для игр мы использовали жесткий диск. На результаты тестов это не влияет.

| Компоненты | |

|---|---|

| Процессор | Intel Core i7-3960X 3,3 ГГц, разгон до 3,9 ГГц |

| Система охлаждения | Corsair H110i GT СВО с замкнутным контуром |

| Материнская плата | ASUS P9X97 Deluxe |

| Оперативная память | G.Skill |

| SSD: | OCZ Arc 100 240 GB |

| Блок питания | Seasonic Platinum Series 1.000 Вт |

| Операционная система | Windows 10 64 Bit |

| Корпус | Fractal Design Define R5 |

Наша тестовая система содержит компоненты Intel, ASUS, Fractal Design, Corsair, G.Skill, OCZ и Seasonic. Мы выражаем благодарность всем производителям, предоставившим нам комплектующие!

Мы использовали следующие версии драйверов:

- Все видеокарты NVIDIA: GeForce 368.14

- Все видеокарты AMD: Radeon Software Crimson Edition 16.5.2

Мы использовали следующие игры и тесты:

- Futuremark 3DMark

- Luxmark 3.0

- GPUPI 2.2

- ComputeBenchCL

- ComputeMark

- The Witcher 3: Wild Hunt

- Battlefield: Hardline

- Grand Theft Auto V

- Far Cry 4

- Total War: Attila

- Metro. Last Light Redux

- Tomb Raider

- DiRt Rally

- Middle-Earth: Shadow of Mordor

- Ashes of Singularity

Всю более подробную информацию о методике тестирования видеокарт вы можете найти в соответствующей статье "Методика тестирования видеокарт Hardwareluxx".

Перейдём к оценке уровня шума, энергопотребления и температуры.

уровень шума

Бездействие

Первый луч надежды GeForce GTX 1080 подала по уровню шума в режиме бездействия. С результатом 39,2 дБ(А) первая видеокарта Pascal работала даже тише, чем та же GeForce GTX 980, лучше оказываются только модели GeForce GTX 980 Ti и Radeon R9 Nano с альтернативными системами охлаждения. Впрочем, у многих видеокарт с альтернативными кулерами имеется другое преимущество – они полностью выключают вентиляторы в режиме бездействия. Данная тенденция сегодня распространилась даже на high-end видеокарты. Честно говоря, весьма интересно узнать, осмелятся ли AMD и NVIDIA на подобный шаг с эталонными видеокартами и Founders Edition.

уровень шума

Нагрузка

Вторая диаграмма показывает уровень шума GeForce GTX 1080 под нагрузкой, NVIDIA справилась со своим обещанием улучшить кулер. 42,6 дБ(А) – отличный показатель, будет интересно посмотреть на результаты фирменных кулеров производителей видеокарт.

Энергопотребление (вся система)

Бездействие

По энергопотреблению в режиме бездействия GeForce GTX 1080 не смогла существенно продвинуться вперед. Даже high-end видеокарты в режиме бездействия потребляют очень мало энергии, GPU снижает частоту до 140 МГц, по памяти мы получаем снижение до 100 МГц, также уменьшаются и напряжения. Только полное выключение видеокарты позволит сэкономить еще несколько ватт.

Энергопотребление (вся система)

Нагрузка

Под нагрузкой мы наблюдаем последствия перехода на эффективную архитектуру NVIDIA и 16-нм техпроцесс FinFET. Полная система с видеокартой потребляла 376,9 Вт, GeForce GTX 1080 заняла позицию между Radeon R9 Nano/GeForce GTX 780 и GeForce GTX Titan/GeForce GTX 780 Ti. По сравнению с видеокартой GeForce GTX 980 Ti экономия составила порядка 50 Вт, будет интересно соотнести подобный выигрыш с приростом производительности, о чем мы поговорим ниже.

Энергопотребление (вся система)

Бездействие с 2 мониторами

В конфигурации с несколькими мониторами GeForce GTX 1080 показала себя с лучшей стороны, энергопотребление возросло ненамного. В прошлом многие видеокарты работали в таком режиме на полной частоте 3D. Но GeForce GTX 1080 сбрасывала частоты через некоторое время.

Температура

Бездействие

Перейдем к результатам измерений температуры. В режиме бездействия температура составила 43 °C, здесь нет ничего интересного. Радиальный вентилятор на низкой скорости вращения обладает достаточным запасом производительности, чтобы удержать температуру GPU на низком уровне.

Температура

Нагрузка

Под нагрузкой GeForce GTX 1080 через некоторое время выходит на целевую температуру 84 °C или чуть ниже. Видеокарта не стала исключением в череде эталонных моделей. Спасением здесь можно назвать СВО с замкнутым контуром, как поступила AMD в случае Radeon R9 Fury X. Впрочем, пока GeForce GTX 1080 обеспечивает обещанную производительность, близость к целевой температуре нас не смущает.

Futuremark 3DMark

Тест 3DMark от Futuremark – один из наиболее популярных синтетических тестов, он позволяет удобно сравнивать разные системы или отдельные компоненты. Отдельные режимы (Preset) позволяют оценить различные аспекты работы системы – вплоть до разрешения UltraHD/4K. Тест изначально разрабатывался под DirectX 11, но сегодня 3DMark также позволяет оценить оптимизацию под DirectX 12, анализируя число вызовов Draw calls.

Futuremark 3DMark

Fire Strike

Futuremark 3DMark

Fire Strike Extreme

Futuremark 3DMark

Fire Strike Ultra

Futuremark 3DMark

API-Overhead DX12

Luxmark 3.0

Luxmark 3.0 – тест рендеринга, который опирается на интерфейс OpenCL и широкую аппаратную базу видеокарт. Luxmark разрабатывался в качестве теста определения производительности LuxRender. Для расчета сцены используется LuxRender 2.x API. Результат выдается в семплах в секунду.

Luxmark 3.0

Sala

GPUPI 2.2

В тесте GPUPI вычисляется число пи через разные интерфейсы. Программы, такие как SuperPi, уже давно используются для оценки вычислительной производительности "железа", возможен расчет через процессоры и видеокарты. Как видно по названию GPUPI, данный тест опирается для расчета на GPU. Мы использовали OpenCL API и вычисляли число пи до 500 млн. или 1 млрд. знаков. GPUPI позволяет удобно ценить 64-битную производительность "железа".

GPUPI 2.0

500M

GPUPI 2.0

1000M

ComputeBenchCL

ComputeBenchCL – тест OpenCL и RenderScript, позволяющий оценить вычислительную производительность CPU и GPU. Кроме того, он доступен на планшетах и смартфонах, что позволяет сравнивать системы друг с другом. ComputeBenchCL опирается на разные тестовые сценарии, закрывая широкий спектр приложений. В том числе распознавание лиц, симуляцию жидкостей и другие расчеты физики, монтаж видео и т.д.

CompuBenchCL

Face Detection

CompuBenchCL

Ocean Surface Simulation

CompuBenchCL

TV-L1 Optical Flow

CompuBenchCL

Particle Simulation 64K

CompuBenchCL

Video Composition

ComputeMark

ComputeMark – тест вычислительных шейдеров (Compute Shader) DirectX 11. Он фокусируется на производительности GPU, которые проходят через разные тестовые сценарии. Среди них – симуляция газов/огня, поведение сотен объектов под действием гравитации и математические расчеты.

ComputeMark

Общий результат

ComputeMark

Fluid 2D

ComputeMark

Fluid 3D

ComputeMark

Mandel Skalar

ComputeMark

Mandel Vektor

ComputeMark

Ray Tracing

The Witcher 3: Wild Hunt

Ролевая игра Ведьмак 3: Дикая охота базируется на книгах и игровом мире известного фантаста Анджея Сапковски. Протагонист Геральт из Ривии открывает средневековый фантастический мир и выполняет разнообразные квесты. Игровой движок был разработан студией CD Projekt Red самостоятельно, в игре используется версия 3. Ролевая игра опирается на открытый мир и устанавливает новые стандарты компьютерной графики.

The Witcher 3

1.920 x 1.080 1xAA 1xAF

The Witcher 3

1.920 x 1.080 MSAA

The Witcher 3

2.560 x 1.440 1xAA 1xAF

The Witcher 3

2.560 x 1.440 MSAA

The Witcher 3

3.840 x 2.160 1xAA 1xAF

The Witcher 3

3.840 x 2.160 MSAA

Battlefield: Hardline

Battlefield: Hardline – классический шутер от первого лица в линейке Battlefield, однако он отличается действием в городской среде, а вместо военных теперь полиция. Игра Battlefield: Hardline была не так хорошо встречена фанатами серии, но благодаря движку Frostbite графика в игре великолепная, поэтому мы используем ее для наших тестов.

Battlefield Hardline

1.920 x 1.080 1xAA 1xAF

Battlefield Hardline

1.920 x 1.080 4xMSAA 16xAF

Battlefield Hardline

2.560 x 1.440 1xAA 1xAF

Battlefield Hardline

2.560 x 1.440 4xMSAA 16xAF

Battlefield Hardline

3.840 x 2.160 1xAA 1xAF

Battlefield Hardline

3.840 x 2.160 4xMSAA 16xAF

Grand Theft Auto 5

Игра Grand Theft Auto 5 или GTA 5 – одно из знаковых событий года. Действие GTA 5 происходит в выдуманном мире Лос-Сантоса, который напоминает Лос-Анджелес. Мир игры полностью открытый, геймер может исследовать его по своему усмотрению. Из-за реалистичного представления игрового мира GTA 5 серьезно нагружает даже современные видеокарты, поэтому мы добавили игру в наши тесты. GTA 5 опирается на движок RAGE.

Grand Theft Auto 5

1.920 x 1.080 1xAA 1xAF

Grand Theft Auto 5

1.920 x 1.080 4xMSAA 16xAF

Grand Theft Auto 5

2.560 x 1.440 1xAA 1xAF

Grand Theft Auto 5

2.560 x 1.440 4xMSAA 16xAF

Grand Theft Auto 5

3.840 x 2.160 1xAA 1xAF

Grand Theft Auto 5

3.840 x 2.160 4xMSAA 16xAF

Far Cry 4

Far Cry 4 – шутер от первого лица в открытом игровом мире, действие происходит в горах Непала, но сюжет игры выдуманный. Игра опирается на модифицированную версию движка Dunia Engine 2, дополненную движком физики Havok. Far Cry 4 смешивает реальный и выдуманный мир, что придает игре свой шарм. Конечно, открытый мир приводит к серьезным требованиям по аппаратному и программному обеспечению.

FarCry 4

1.920 x 1.080 1xAA 1xAF

FarCry 4

1.920 x 1.080 4xMSAA 16xAF

FarCry 4

2.560 x 1.440 1xAA 1xAF

FarCry 4

2.560 x 1.440 4xMSAA 16xAF

FarCry 4

3.840 x 2.160 4xMSAA 16xAF

Total War: Attila

Total War: Attila – девятая часть популярного стратегического игрового семейства, в ней присутствуют одно- и многопользовательский режимы. Для симуляции игрового мира и игровых персонажей, число которых на поле боя может измеряться тысячами, используется движок Warscape, специально разработанный для подобных игр. Разработчики попытались не только максимально реалистично вывести каждого персонажа, но и расширить это представление на сотни или даже тысячи солдат в игре. Все это накладывает серьезные требования на видеокарту.

Total War: ATTILA

1.920 x 1.080 1xAA 1xAF

Total War: ATTILA

1.920 x 1.080 8xMLAA 16xAF

Total War: ATTILA

2.560 x 1.440 1xAA 1xAF

Total War: ATTILA

2.560 x 1.440 8xMLAA 16xAF

Total War: ATTILA

3.840 x 2.160 1xAA 1xAF

Total War: ATTILA

3.840 x 2.160 8xMLAA 16xAF

Metro: Last Light Redux