NVIDIA выбрала весьма необычный подход к представлению видеокарт GeForce RTX поколения Ampere. Несколько дней назад новые видеокарты были представлены на стриме, затем были опубликованы основные технические спецификации. Позднее NVIDIA предоставила технические подробности, которыми теперь мы можем поделиться с читателями.

NVIDIA выбрала весьма необычный подход к представлению видеокарт GeForce RTX поколения Ampere. Несколько дней назад новые видеокарты были представлены на стриме, затем были опубликованы основные технические спецификации. Позднее NVIDIA предоставила технические подробности, которыми теперь мы можем поделиться с читателями.

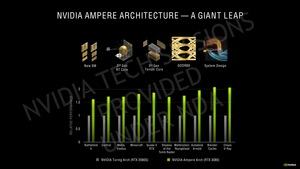

Список изменений при переходе с архитектуры Turing на Ampere довольно длинный. Начнем с GA102 GPU, который используется на видеокартах GeForce RTX 3080 и GeForce RTX 3090. В статье мы рассмотрим структуру GPU и потоковых процессоров. Кроме того, мы обсудим новые функции ядер Tensor и RT, интерфейс памяти и многое другое.

Дата публикации теста остается секретом. GeForce RTX 3080 будет доступна с 17 сентября, GeForce RTX 3090 последует 24 сентября. Так что тесты будут опубликованы не позже этих дат.

Подписывайтесь на группы Hardwareluxx ВКонтакте и Facebook, а также на наш канал в Telegram (@hardwareluxxrussia).

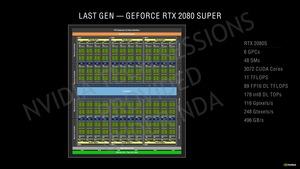

Ниже приведено сравнение основных технических спецификаций:

| GeForce RTX 3090 | GeForce RTX 3080 | GeForce RTX 3070 | |

| GPU | Ampere | Ampere | Ampere |

| Число транзисторов | 28 млрд. | 28 млрд. | 17,4 млрд. |

| Техпроцесс | 8 нм | 8 нм | 8 нм |

| Площадь кристалла | 628,4 мм² |

628,4 мм² |

392,5 мм² |

| FP32 ALUs | 10.496 | 8.704 | 5.888 |

| INT32 ALUs | 5.248 | 4.352 | 2.944 |

| SMs | 82 | 68 | 46 |

| Ядра Tensor | 328 | 272 | 184 |

| Ядра RT | 82 | 68 | 46 |

| Базовая частота | 1.400 МГц | 1.440 МГц | 1.500 МГц |

| Частота Boost | 1.700 МГц | 1.710 МГц | 1.730 МГц |

| Емкость памяти | 24 GB | 10 GB | 8 GB |

| Тип памяти | GDDR6X 19,5 Гбит/с |

GDDR6X 19 Гбит/с |

GDDR6 14 Гбит/с |

| Ширина шины памяти | 384 бит | 320 бит | 256 бит |

| Пропускная способность памяти | 936 Гбайт/с |

760 Гбайт/с | 448 Гбайт/с |

| TDP | 350 Вт | 320 Вт | 220 Вт |

| Цена | 136.990 ₽ | 63.490 ₽ | 45.490 ₽ |

| Дата выхода | 24 сентября | 17 сентября | Октябрь |

Новые GPU Ampere производятся по 8-нм техпроцессу на заводах Samsung. Они содержат 28 млрд. транзисторов, чипы существенно крупнее и сложнее предшественников Turing. NVIDIA упоминает 5.888 потоковых процессоров у GeForce RTX 3070, но более 10.000 в случае GeForce RTX 3090, о чем мы поговорим на следующей странице.

Также NVIDIA оставляет довольно большой зазор (10 против 24 GB) между GeForce RTX 3080 и GeForce RTX 3090, да и разница в цене между данными видеокартами превышает 70 тыс. рублей.

Ниже мы рассмотрим подробности архитектуры Ampere, новый дизайн кулера, а также новые аппаратные и программные функции.

Начнем с основного элемента любой видеокарты GeForce RTX, а именно GPU. Он опирается на архитектуру Ampere, которая отличается от версии для дата-центров в GA100 GPU.

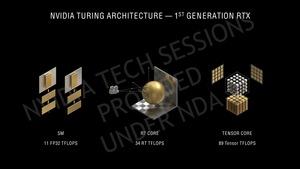

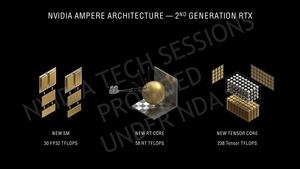

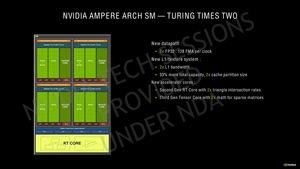

Streaming Multiprocessor (SM) в архитектуре Ampere лишился вычислительных блоков FP64, которые в составе GA100 GPU весьма важны для высокопроизводительных вычислений HPC, чего нельзя сказать о потребительском сегменте. Зато число вычислительных блоков FP32 было удвоено. Вместо 64 блоков FP32 на SM теперь доступны 128, а также 64 блока INT32. Параллельно поддерживается выполнение двух путей данных. Первый путь состоит из 16 блоков FP32. Так что здесь можно выполнять 16 вычислений FP32 за такт. Второй путь состоит из 16 блоков FP32 и INT32. Каждая четверть SM может выполнять либо 32 операции FP32, либо 16 операций FP32 и 16 INT32 за такт. Для SM целиком это означает 128 операций FP32 или 64 операции FP32 и 64 INT32 за такт.

Чтобы удвоенные блоки FP32 успевали получать данные, NVIDIA увеличила кэш L1 с 96 до 128 кбайт. И скорость работы с кэшем L1 вновь была удвоена. NVIDIA уже сделала подобный шаг при переходе с Pascal на Turing. Регистры не изменились, по-прежнему 16.384 записи по 32 бита каждая. То же самое касается и числа блоков Load/Store.

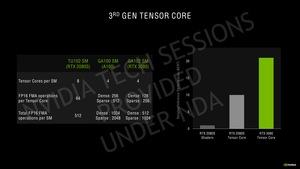

Что касается специальных аппаратных блоков, а именно ядер Tensor и RT, то здесь тоже произошли изменения. Теперь ядер Tensor всего четыре на SM (в случае Turing их было восемь). Но третье поколение ядер Tensor работает быстрее и эффективнее. То же верно и ядер RT, теперь каждый SM содержит только одно ядро RT.

Удвоение вычислительных блоков FP32 - одна из причин, почему the GA10x GPU содержат 28 млрд. транзисторов. У TU102 GPU их число составляло 18,6 млрд. Число транзисторов GA104 GPU - 17,4 млрд. GA102 GPU используется в видеокартах GeForce RTX 3090 и GeForce RTX 3080. А GA104 GPU - в видеокартах GeForce RTX 3070.

Теперь мы знаем и площадь чипов. GA102 GPU занимает 628,4 мм², the GA104 GPU - 392,5 мм². Таким образом, при 8-нм производстве и 28 млрд. транзисторах плотность на GA102 GPU составляет 44,6 млн. транзисторов на квадратный миллиметр (44 MT/мм²). В случае GA104 GPU данный уровень составляет 44,3 MT/мм².

| GA100 | GA102 | GA104 | TU102 | |

| Техпроцесс | 7 нм (TSMC) | 8 нм (Samsung) | 8 нм (Samsung) | 12 нм (TSMC) |

| Количество транзисторов | 54 млрд. | 28 млрд. | 17,4 млрд. | 18,6 млрд. |

| Площадь кристалла | 826 мм² | 628,4 мм² | 392,5 мм² | 754 мм² |

| Плотность транзисторов | 65,37 MT/мм² | 44,56 MT/мм² | 44,33 MT/мм² | 24,67 MT/мм² |

GA100 GPU производится по 7-нм техпроцессу на заводах TSMC с плотностью транзисторов 65,37 MT/мм², что на 47% больше. По сравнению с поколением Turing, чьи GPU производились TSMC по 12-нм техпроцессу, чипы Ampere меньше по площади, а также имеют большую плотность транзисторов. Конечно, 8-нм техпроцесс Samsung не может состязаться с передовыми техпроцессами, но ему это и не требуется.

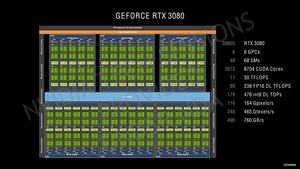

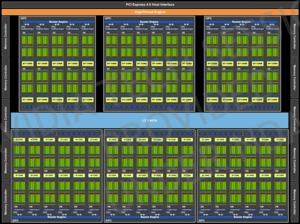

Структура GA102 GPU

GA102 GPU содержит шесть кластеров GPC (Graphics Processing Clusters) и пять или шесть кластеров TPC (Texture Processing Clusters) в каждом GPC. В свою очередь, каждый кластер TPC содержит два потоковых мультипроцессора SM (Streaming Multiprocessor). GeForce RTX 3080 GA102 GPU имеет 34 TPC x 2 SM, что дает 8.704 ядра CUDA или потоковых процессоров, поскольку каждый SM содержит 128 ядер CUDA. GA102 GPU в видеокарте GeForce RTX 3090 содержит уже 82 SM, что приводит к 10.496 потоковым процессорам.

Каждый SM имеет четыре ядра Tensor и одно ядро RT. Ниже мы рассмотрим данные функциональные блоки, которые подверглись обновлению. На иллюстрации выше показан GA102 GPU в видеокарте GeForce RTX 3080. Поэтому мы видим меньше TPC и "всего" 68 SM, а также десять контроллеров памяти по 32 бита каждый. Шина памяти 320-битная, к ней подключены 10 Гбайт GDDR6X.

В чипе GeForce RTX 3090 активны уже 12 контроллеров памяти, ширина шины памяти составляет 384 бита. GA102 GPU здесь содержит уже 82 SM и большее число TPC (либо полностью оснащенные TPC).

В зависимости от уровня расширения чипа меняется и размер кэша L2. В случае GeForce RTX 3080 он составляет 5.120 кбайт, у GeForce RTX 3070 - 4.096 кбайт. Для сравнения, у TU102 GPU кэш был 6.144 кбайт.

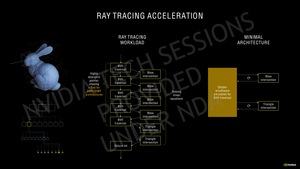

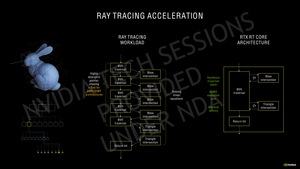

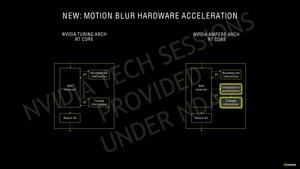

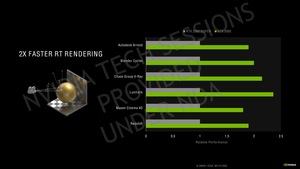

Второе поколение ядер RT

Второе поколение ядер RT способно выполнять в два раза больше расчетов пересечений, чем первое. Поскольку NVIDIA не изменила число ядер RT на SM, теоретическое масштабирование производительности RT двукратное. Конечно, если у видеокарты будет больше SM, то и производительность будет выше.

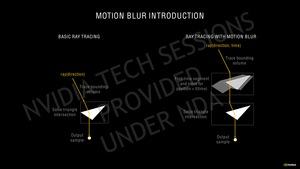

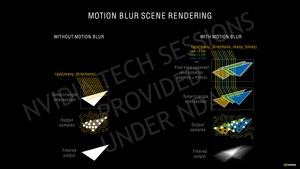

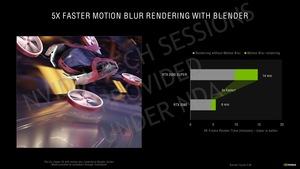

Проблема с расчетом пересечений при трассировке лучей возникает в случае движущихся объектов, а также с наложенным эффектом размыванием движения Motion Blur. В случае Turing GPU или их ядер RT здесь могло возникнуть "узкое место" по производительности трассировки лучей. Второе поколение ядер RT имеет параллельные блоки, которые отвечают за интерполяцию с эффектом Motion Blur. Пересечения рассчитываются упреждающе на основе алгоритмов, в результате трассировка лучей выполняется только там, где нужно.

Третье поколение ядер Tensor

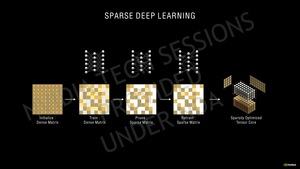

Как и предполагалось, NVIDIA продолжила усиливать ядра Tensor третьего поколения. Кроме вычислений INT16 и FP16 они теперь могут выполнять вычисления FP32 и FP64. Что важно, прежде всего, для сегмента HPC, где требуются вычисления с высокой точностью. В случае же GeForce GPU в приоритете остаются вычисления с меньшей точностью.

Ядра Tensor архитектуры Turing могут выполнять 64 операции FP16 Fused Multiply-Add (FMA) на ядро Tensor. В случае Ampere и полностью заполненных матриц (Dense) мы получаем 128 операций на GA102 GPU и даже 256 на GA100 GPU. В случае разреженных матриц (Sparse) производительность составляет 256 FP16 FMA для GA102 GPU и 512 для GA100 GPU. Ядра Tensor архитектуры Turing не поддерживают разреженные матрицы.

Что увеличивает вычислительную производительность ядер Tensor не менее чем в два раза. Сильнее всего здесь должна выиграть производительность DLSS, но теоретически получат прирост и приложения искусственного интеллекта.

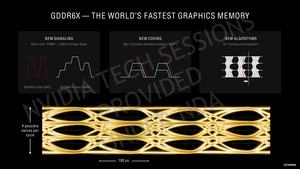

GDDR6X

Учитывая большое число потоковых процессоров, высокая пропускная способность памяти имеет первостепенное значение. Иерархия кэшей с каждым поколением ускоряется, то же самое требуется и от памяти. GDDR6 обеспечила бы увеличение пропускной способности только через рост тактовых частот. Либо можно расширить шину памяти. Та же HBM предлагает очень широкий интерфейс памяти, но она слишком сложная и дорогая в производстве. Поэтому для игровых видеокарт не подходит.

NVIDIA объединила усилия с Micron, в итоге была разработана GDDR6X. Память GDDR6X работает на тех же частотах, что и GDDR6, напряжение сравнимое.

У предыдущей памяти GDDR6 использовалась модуляция Non-Return-to-Zero (NRZ). Значения "0" и "1" соответствовали низкому и высокому напряжению. В случае GDDR6X используется уж амплитудно-импульсная модуляция PAM4, несущая разделяется на четыре уровня напряжения с каждым тактовым импульсом. Шаг между уровнями составляет 250 мВ. PAM4 все чаще используется в современных стандартах передачи. PCI Express 5.0 и DDR6 тоже будут опираться на PAM4.

NVIDIA и Micron реализовали ряд хитростей, чтобы гарантировать высокие скорости передачи при выставленных тактовых частотах. Max Transition Avoidance Coding (MTA) гарантирует, что сигнал меняется только до двух уровней напряжения. Если идет переход с самого низкого до самого высокого уровня, то различимость сигнала теряется. С помощью MTA NVIDIA кодирует сигнал нужным образом.

Наконец, NVIDIA дает некоторый динамический допуск, поскольку небольшие отличия по производству PCB и памяти могут привести к различиям по задержкам распространения сигнала. Поэтому алгоритмы дополнительно корректируют передачу сигнала.

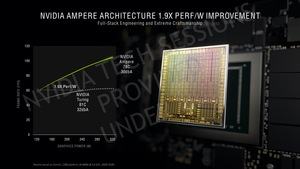

Эффективность

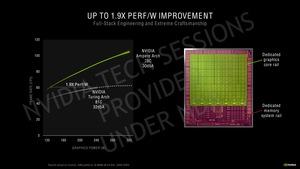

8-нм производство Samsung повлияло на эффективность GPU Ampere. NVIDIA внесла и другие изменения. Несколько странными кажутся заявления NVIDIA о том, что новые видеокарты GeForce RTX в x1,9 раза эффективнее предшественников Turing. Здесь стоит взглянуть на диаграмму, чтобы понять, что именно подразумевает NVIDIA под ростом эффективности.

NVIDIA выбрала частоту кадров 60 fps, и в случае видеокарты Turing энергопотребление составило 240 Вт. При этом видеокарте Ampere для этих же 60 fps понадобится всего около 130 Вт. 240 к 130 Вт и дает прирост эффективности в 1,9 раза.

Но NVIDIA все же следует сравнивать производительность при одном уровне энергопотребления. Если вновь взять базу 240 Вт для 60 fps в случае Turing, то у Ampere мы получим на этом же уровне энергопотребления около 90 fps. И увеличение эффективности составляет уже 50%, а не 1,9 раза, как считает NVIDIA.

NVIDIA просто сравнила Turing за пределами идеального окна эффективности с Ampere, где мы находимся в рамках данного окна. При 240 Вт видеокарта на Turing GPU работает далеко не с идеальным сочетанием напряжение/частота, а 240-Вт Ampere GPU все еще находится в диапазоне с хорошей эффективностью.

Новые видеокарты GeForce RTX показывают намного более высокий уровень производительности, но NVIDIA все же перешла на GPU с 28 млрд. транзисторов, а также увеличила TDP GeForce RTX 3090 до 350 Вт, в то время как у GeForce RTX 3080 мы все еще получаем до 320 Вт. Все это следует принимать во внимание при рассмотрении эффективности новых видеокарт. Интересно, что NVIDIA разделила линии напряжений GPU. Одна отвечает за потоковые процессоры, вторая - за подсистему памяти. Две линии контролируются раздельно, что увеличивает эффективность.

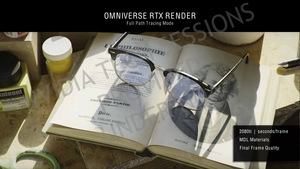

Следующий шаг к гибридному конвейеру рендеринга

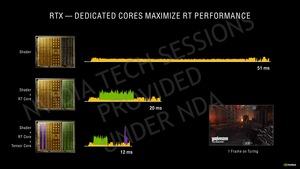

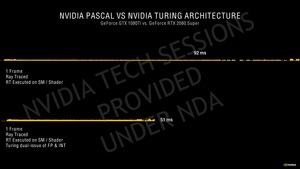

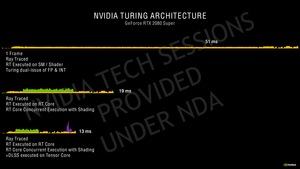

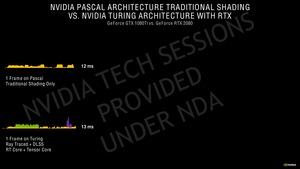

С архитектурой Turing и возможностью трассировки лучей через ядра RT и масштабирования разрешения через DLSS и ядра Tensor NVIDIA впервые заговорила о гибридном конвейере рендеринга (Hybrid Rendering Pipeline). То есть помимо классического рендеринга через потоковые процессоры добавляется трассировка лучей и DLSS.

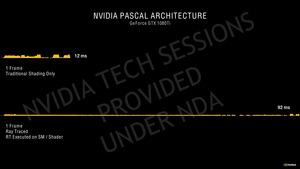

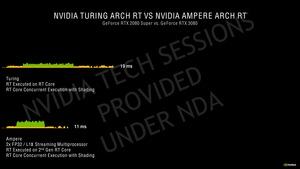

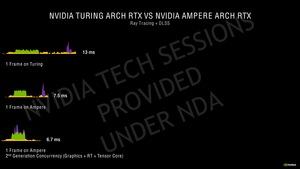

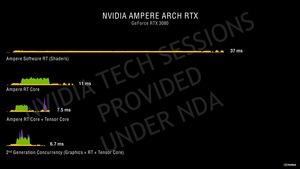

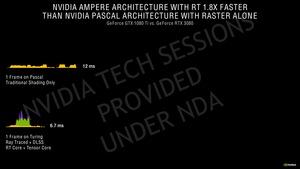

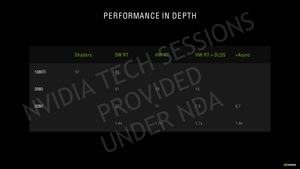

На GPU Turing кадр в игре Wolfenstein Youngblood просчитывается 51 мс. В данном случае трассировка лучей выполняется на потоковых процессорах. Если перенести ее на ядра RT, то время просчета кадра снижается до 19 мс. Если добавить масштабирование DLSS, то время можно снизить до 13 мс.

Для Ampere GPU с более высокой производительностью время рендеринга снижается с 13 мс до 7,5 мс. Основная причина - в приросте производительности потоковых процессоров. Но вычисления трассировки лучей и DLSS тоже выполняются быстрее, что приводит к снижению времени рендеринга. Для Ampere NVIDIA использует другой трюк, вычисления DLSS выполняются перед финальным рендерингом. Свою роль здесь играет временная обратная отдача (Temporal Feedback), благодаря которой учитываются результаты рендеринга предыдущих кадров. Собственно, этот шаг и позволил DLSS 2.0 увеличить качество картинки. С новыми чипами Ampere такой подход позволяет уменьшить время рендеринга кадра.

RTX IO

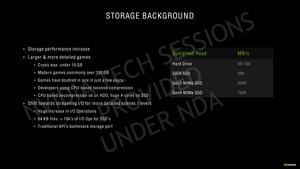

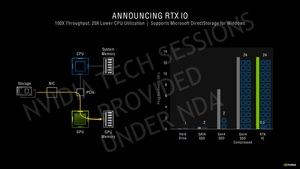

NVIDIA RTX IO работает с грядущим Microsoft DirectStorage API, который будет поддерживаться в играх с 2021 года. Здесь подразумевается архитектура хранения данных нового поколения, ориентированная на игровые ПК с NVMe SSD. DirectStorage API и RTX IO - оптимизированные и высокопараллельные API, разработанные специально для игр, которые значительно снижают избыточную нагрузку ввода/вывода.

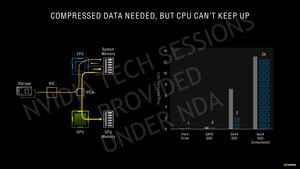

Потребность в более скоростном интерфейсе ввода/вывода связана с тем, что игры занимают все больше места, игровые данные становятся более объемными и сложными.

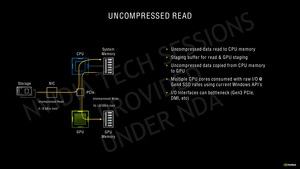

В классических системах игровые данные считываются с SSD/HDD и передаются процессору через SATA или PCI Express. Скоростные PCIe 4.0 SSD могут обеспечивать пропускную способность до 7 Гбайт/с. Процессор располагает данные в оперативной памяти, откуда они затем передаются процессором через интерфейс PCI Express на GPU. Последний сохраняет данные в видеопамяти. В результате мы имеет промежуточный этап с лишней нагрузкой на процессор, да и выше 7 Гбайт/с не подняться.

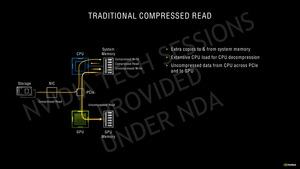

Но есть возможность передавать процессору данные с накопителя в сжатом виде. Затем процессор их распаковывает в оперативной памяти, и они передаются в распакованном виде через PCI Express в память GPU. Хотя здесь можно получить уже до 14 Гбайт/с, ядра CPU будут заняты распаковкой данных.

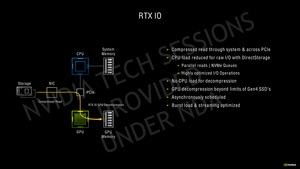

RTX IO или DirectStorage позволяет передавать данные с быстрого SSD через интерфейс PCI Express напрямую GPU, который будет размещать их в видеопамяти. Этап процессора и оперативной памяти системы здесь уже отсутствует. Здесь тоже можно достигнуть до 14 Гбайт/с (с учетом расчетного коэффициента сжатия 2:1), но без нагрузки на процессор.

Причем распаковка данных на GPU не влияет на остальную производительность. Опасения насчет предела PCIe 4.0 современных SSD напрасны. Если игра оптимизирована под DirectStorage API, то с SSD считываются только необходимые данные. Что, кстати, уменьшит занятость видеопамяти.

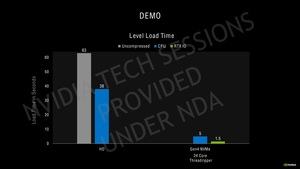

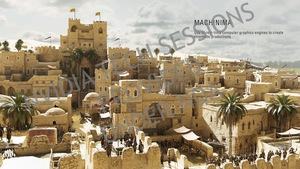

NVIDIA также привела сведения производительности, используя собственную техническую демо Marbles. Демо считывает несжатые данные с жесткого диска более 60 с. В случае сжатых данных и распаковки их на CPU время снижается до 38 с. Если используется NVMe SSD, то время загрузки уменьшается всего до 5 с, но данные распаковываются на процессоре, загружая ядра. В случае RTX IO время загрузки составит всего 1,6 с.

DirectStorage API будет использоваться приставкой Microsoft Xbox Series X, в случае PlayStation 5 реализована схожая концепция. Через RTX IO скорость передачи данных с SSD в видеопамять составит до 14 Гбайт/с. Для сравнения, Sony PlayStation 5 дает 8-9 Гбайт/с, а Microsoft Xbox Series X - 4,8 Гбайт/с. Интересно посмотреть, будет ли AMD поддерживать DirectStorage с архитектурой Big Navi.

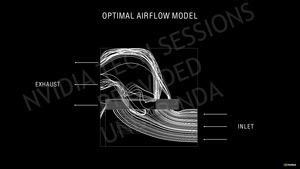

Новые видеокарты выделяют до 350 Вт тепла, поэтому NVIDIA пришлось продумывать новую систему охлаждения. Сначала позвольте рассмотреть типичный корпус, где свежий воздух поступает спереди, а горячий выбрасывается сзади или сверху.

Видеокарта с кулером-турбиной хорошо вписывается в подобную концепцию, поскольку она получает воздух внутри корпуса, после чего почти полностью выбрасывает его через слотовую заглушку. Но при использовании обычных осевых вентиляторов все уже обстоит иначе. Большая часть горячего воздуха остается внутри корпуса, а крупная PCB с металлической задней пластиной практически блокирует вертикальный воздушный поток. В итоге воздух в той или иной степени скапливается внутри корпуса.

Для новых видеокарт NVIDIA выбрала концепцию охлаждения, слухи о которой ходили довольно давно. Задний вентилятор видеокарты продувает воздух сквозь ребра, выбрасывая его над видеокартой. Второй вентилятор проталкивает часть воздуха в направлении слотовой заглушки и выбрасывает его наружу.

Чтобы PCB не блокировала воздушный поток заднего вентилятора, ее пришлось сделать намного короче. В результате мы получаем укороченную PCB с треугольным вырезом. На иллюстрации показана PCB GeForce RTX 2080 Super слева, можно видеть довольно много свободного пространства между чипами памяти и корпусировкой GPU, между GPU и слотовой заглушкой, справа от подсистемы питания.

Расположить VRM, чипы памяти и GPU близко друг к другу - непростая техническая задача, особенно с учетом охлаждения. NVIDIA даже пришлось перейти на более компактный 12-контактный разъем питания и уменьшенный NV-Link (здесь на GeForce RTX 3080 PCB он отсутствует).

Подобная плотная упаковка привела к проблемам охлаждения. С областью GPU, чипов памяти и VRM контактирует базовая пластина с испарительной камерой. Она поглощает тепло от компонентов и по четырем тепловым трубкам переносит его в заднюю часть видеокарты. Здесь как раз в дело вступает вытяжной вентилятор, который выдувает горячий воздух вверх.

Теплый воздух вытяжного вентилятора затем поступает в область кулера процессора. Башенный кулер CPU затем будет направлять воздух наружу через заднюю панель корпуса. Если используется водяное охлаждение CPU с теплообменником на задней панели, то здесь воздух будет вытягиваться соответствующим вентилятором. Наконец, третий вариант, когда горячий корпус выбрасывается наружу через крышку корпуса - например, если там установлен радиатор СВО.

Если верить NVIDIA, существенно нагрева других компонентов при этом нет. Что верно для процессора, оперативной памяти и теплообменников компьютера. В большинстве других дизайнов охлаждения тепло все равно бы оставалось в пределах корпуса компьютера, его пришлось бы выводить. Как считает NVIDIA, теперь для тепла предусмотрен более правильный путь. И другие компоненты будут лучше справляться с его выводом.

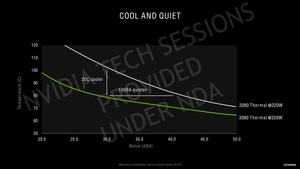

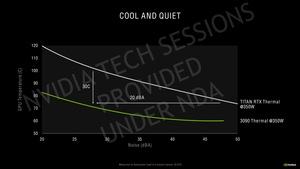

Новый дизайн охлаждения GeForce RTX 3080 при тепловом пакете 320 Вт привел к снижению температуры на 20 °C и уровня шума на 10 дБ(A) по сравнению с GeForce RTX 2080 на 320 Вт.

GeForce RTX 3090 с тепловым пакетом 350 Вт работает на 30 °C холоднее и на 20 дБ(A) тише по сравнению с Titan RTX с тем же TDP 350 Вт. Следует помнить, что GeForce RTX 2080 рассчитана на TGP 225 Вт, и 320 Вт представляют серьезную проблему для системы охлаждения видеокарты. Она еле справляется с 320 Вт, что не удивляет. То же самое касается Titan RTX, пусть даже она рассчитана на 280 Вт, и расстояние до планки 350 Вт меньше. В любом случае, кулер, рассчитанный на 350 Вт, работает лучше, чем вариант на 280 Вт с перегрузкой.

В целом, нам следует провести собственные тесты, чтобы прояснить картину. Снижение уровня шума на 10 дБ(А) означает, что видеокарта работает в три раза тише. Весьма серьезное улучшение, пусть даже старые видеокарты, взятые для сравнения, работают с превышением теплового пакета. GeForce RTX 2080 и GeForce RTX 2080 Ti в вариантах Founders Editions в наших тестах работали близко к предельной температуре 83°C, а именно 77 и 79°C. Впрочем, NVIDIA специально настроила контроллер вентиляторов так, чтобы уровень шума был минимальным, пусть даже температура при этом будет сравнительно высокой.

NVIDIA опубликовала видеоролик работы технологии Reflex, на котором хорошо видна производительность GeForce RTX 3080. Видеокарта работает на 1.920 МГц с тепловым пакетом GPU 310 Вт при температуре 76 °C.

В будущем тесте мы внимательно рассмотрим вопрос охлаждения, оценим влияние видеокарты на температуры процессора. Конечно, мы рассмотрим и то, как сказывается комплектный переходник питания на 12-контактное гнездо.

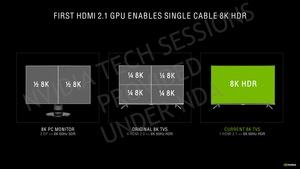

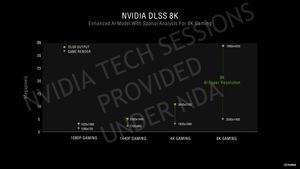

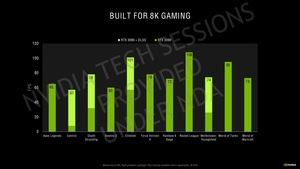

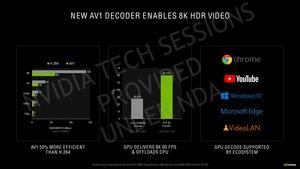

С новой линейкой GeForce RTX 30 представлены новые функции, касающиеся вывода на дисплей. Видеокарты GeForce RTX 3090 должно быть достаточно для плавного геймплея 8K. NVIDIA подразумевает здесь новейшие хиты AAA с трассировкой лучей, но с поддержкой DLSS 2.1.

Если верить NVIDIA, GeForce RTX 3090 - первая видеокарта, позволяющая комфортно играть в 8K. Соответствующие интерфейсы тоже имеются. Например, HDMI 2.1 может теоретически обеспечивать даже разрешение 10K на 120 Гц, поэтому для 8K пропускной способности по одному кабелю вполне достаточно. Также у видеокарт есть DisplayPort 1.4a.

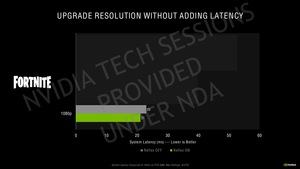

Тему DLSS мы поднимали уже несколько раз. С новой DLSS 2.0 NVIDIA уже сделала важный шаг вперед, качество картинки во многих случаях получается выше, чем при родном разрешении. Конечно, не все бывает всегда гладко, но DLSS - весьма эффективное решение увеличения производительности системы без компромиссов по качеству картинки.

Напомним, что Deep Learning Super Sampling (DLSS) масштабирует рендеринг из меньшего разрешения в большее, используя алгоритм на основе искусственного интеллекта. Для игр 4K на примере выше показан рендеринг в 1080p и масштабирование в 4K. Так что "настоящие" 2.073.600 пикселей (1.920 x 1.080 пикселей) масштабируются в 8.294.400 пикселей (3.840 x 2.160 пикселей), то есть в четыре раза.

Для вывода 8K NVIDIA использует внутренний рендеринг 1400P. Новый профиль DLSS под названием AI Super Resolution как раз и обеспечивает вывод в 8K. 3.584.000 пикселей (2.560 x 1.400 пикселей) превращаются в 33.177.600 пикселей (7.680 x 4.320 пикселей) - увеличение в девять раз. Соответствующий профиль DLSS используют свою модель ИИ. Для расчетов используется дополнительное поле Field of View (FOV), которое должно увеличить детализацию.

NVIDIA взяла в качестве примера Watch Dogs: Legion и показала, что 8K DLSS дает больший уровень детализации, чем родной рендеринг с меньшим числом пикселей (1080p) и большим числом пикселей (4K).

NVIDIA продемонстрировала и результаты производительности GeForce RTX 3090 в разрешении 8K с активной DLSS и без. Впрочем, пройдет еще какое-то время, прежде чем геймеры обзаведутся соответствующими дисплеями и телевизорами. Сегодня игры 8K - больше техническая демонстрация, нежели практический сценарий.

Приятно, что сегодня можно играть в 8K, но практической пользы от этого пока нет.

DLSS 2.0/2.1

Скоро многие игры обзаведутся поддержкой DLSS 2.1. Но игры, которые будут выходить в ближайшие недели и месяцы, будут поддерживать, по крайней мере, DLSS 2.0.

NVIDIA взяла в качестве примера Fortnite, рассказав на примере игры преимущества и недостатки DLSS 2.0. Fortnite должна в ближайшем будущем получить обновление с поддержкой трассировки лучей и DLSS.

На скриншоте показан рендеринг Fortnite в родном разрешении 4K (слева), а справа - DLSS 4K. Оба скриншота были получены на видеокарте GeForce RTX 3080 с настройками графики Epic. В родном разрешении частота кадров составляет всего 28 FPS, но в DLSS 4K она достигает 73 FPS, причем качество графики даже выше. Например, в тени пирса можно видеть больше деталей, чем в родном разрешении. Это верно и для других областей кадра. NVIDIA здесь еще раз подчеркивает превосходство DLSS по качеству графики. Кроме того, и частота кадров существенно выше.

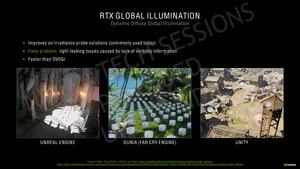

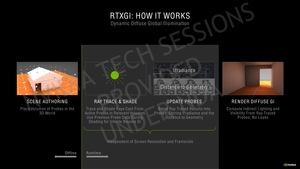

RTXGI

Еще с эффектами RTX NVIDIA представила симуляцию глобального освещения сцены (Global Illumination, GI), то есть расчет освещения целиком. Metro: Exodus на данный момент является лучшим примером реализации глобального освещения. Конечно, красивые отражения и зеркальные поверхности в некоторых других играх привлекают внимание, но общая атмосфера в игре лучше всего передается через глобальное освещение методом трассировки лучей.

По этой причине NVIDIA сфокусировалась на расчете GI. Через RTXGI разработчики игр могут задействовать аппаратное ускорение. Впрочем, здесь придется сделать шаг назад. Расчеты GI пока не динамические. То есть разработчик по-прежнему выставляет так называемые пробы в 3D-окружении, которые показывают, сколько света должно быть в том или ином месте. Динамическое изменение освещения (например, открывание двери, через которую свет начинает пробиваться в темное помещение) подобные пробы определить не могут.

Но существуют методики обхода подобных проблем - по крайней мере, частично. VXGI (Voxel Global Illumination) является одной из подобных техник, а SVOGI (Voxel-Based Global Illumination) представляет собой ее дальнейшее развитие. Но и они не могут вывести динамику восхода солнца, например.

С технологией RTXGI NVIDIA пытается найти компромисс между слишком высокими аппаратными требованиями и приемлемым реализмом. Трассировка лучей применяется к свету и теням, пробы получают некоторую динамику, чтобы реагировать на изменения освещения.

Для освещения сцены обычно требуется от 250.000 до 400.000 семплов на кадр. GeForce RTX 3080 должна справиться с подобными расчетами за 0,5 мс. GeForce RTX 2080 требуется уже 1 мс, но по отношению к времени вывода всего кадра это сравнительно немного. Для поддержания плавного fps задержка не должна превышать 2 мс.

NVIDIA ориентируется на уровень 1 мс при работе RTXGI в Unreal Engine. GeForce RTX 1080 Ti может просчитывать 150.000 семплов/кадр. GeForce RTX 2060 Super - в два раза больше. GeForce RTX 2080 Ti обеспечивает уже 500.000 семплов на кадр, а GeForce RTX 3080 - почти 800.000.

NVIDIA еще раз подчеркивает, что RTXGI - не трассировка лучей в классическом смысле, которая требовала бы мощного RTX GPU. Даже слабые GPU могут выполнять соответствующие вычисления, что повышает качество картинки.

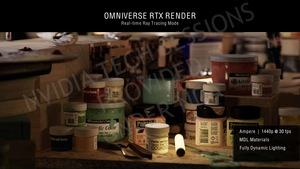

NVIDIA показала реализацию RTXGI в Unreal Engine 4 с помощью технического демо.

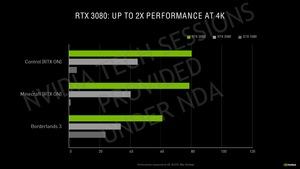

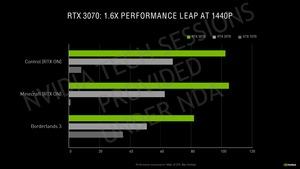

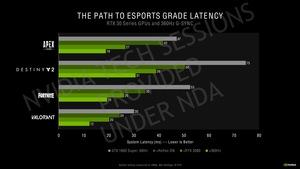

Конечно, NVIDIA опубликовала некоторые результаты тестов GeForce RTX 3080 и GeForce RTX 3090. Сегодня мы не можем представить свои тесты, поэтому позвольте присмотреться к результатам NVIDIA.

Сразу же отметим, что NVIDIA не стала приводить сравнения с AMD. Это не удивляет, поскольку разработчики GPU предпочитают концентрироваться на собственных продуктах. AMD сегодня нечего противопоставить семейству RTX 30, остается лишь ждать выхода Big Navi.

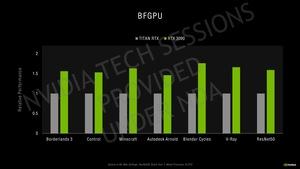

Благодаря удвоению производительности FP32, улучшению ядер RT и Tensor, более быстрой памяти и оптимизированной системе охлаждения, NVIDIA заявляет о приросте производительности в 1,5-2 раза выше по сравнению с GeForce RTX 2080 Super. В играх NVIDIA ожидает прирост производительности от +50 до 75%. В некоторых приложениях, которые смогут задействовать удвоение FP32, прирост может составить и +100%.

NVIDIA также время от времени приводит для сравнения и видеокарты старого поколения Pascal. Они не поддерживают аппаратное ускорение трассировки лучей, поэтому GeForce GTX 1070 и 1080 вряд ли можно считать достойными конкурентами. Однако в играх без трассировки лучей (например, Borderlands) видеокарты GeForce RTX 3070/3080 показывают ощутимый прирост.

По сравнению с GeForce GTX 2080 новая видеокарта GeForce GTX 3080 дает прирост от +50% до +100%, что указывалось уже несколько раз. Видеокарта GeForce GTX 3070 должна быть на +60% быстрее GeForce GTX 2070.

Для GeForce RTX 3090 NVIDIA также приводит результаты производительности, но сравнивает уже с Titan RTX. В играх прирост составляет около +50%, в некоторых приложениях чуть больше.

Кстати, NVIDIA - не первый производитель, называющий столь мощный GPU как BFGPU (Big Fucking GPU). Раджа Кодури из Intel показал Xe-HP GPU в корпусировке BFP (Big Fabulous Package), и вскоре после презентации NVIDIA он выложил приведенный выше твит.

NVIDIA показала демо геймплея Doom Eternal в 4K с настройками Nightmare на GeForce RTX 3080. Чтобы можно было оценить производительность, был добавлен соответствующий показатель движка id-Tech 5. NVIDIA также провела прямое сравнение GeForce RTX 3080 и GeForce RTX 2080 Ti. При прямом сравнении GeForce RTX 3080 работает примерно на 50% быстрее. Конечно, все зависит от сложности сцены. Остальные аппаратные компоненты неизвестны. Видеокарта GeForce RTX 2080 Ti работала с драйвером GeForce 451.67, а GeForce RTX 3080 - с драйвером GeForce 455.77.

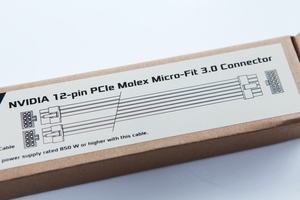

Еще весной появились первые слухи о том, что NVIDIA изменит интерфейс питания. Тогда уже упоминался 12-контактный интерфейс. И высказывалось мнение, что покупателям новых видеокарт придется приобретать и новые БП.

NVIDIA оправдала использование нового вертикального разъема ограничениями по занимаемому пространству. Действительно, новый 12-контактный разъем имеет габариты 20,4 x 6,86 x 9,25 мм. У 8-контактного гнезда они составляют 18 x 10 x 10,5 мм. И два 8-контактных гнезда заняли бы почти в два раза больше места, чем 12-контактный разъем.

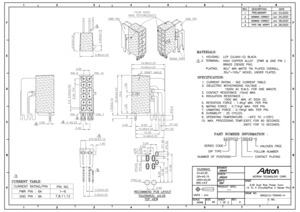

Один из производителей подобных разъемов - Astron Technology. Вполне возможно, что на некоторых видеокартах NVIDIA будут устанавливать разъемы этого производителя. На приведенном чертеже можно разобраться в размерах, а также в расстоянии между контактами. Производитель гарантирует не меньше 12 циклов подключения/отключения.

На PCB 12-контактное гнездо подключается не 12 контактами, а всего шестью. По паре контактов отведены под 12 В, землю и Sense. По центру внизу показала раскладка контактов на PCB, ее же мы получили и на GeForce RTX 3080 PCB (ниже).

NVIDIA устанавливает 12-контактный разъем на свои видеокарты Founders Editions. Но вместе с видеокартами прилагается переходник, к которому подключаются два 6+2-контактных штекера. На страницах видеокарт NVIDIA приводит минимальные требования по питанию 2x 8-конт. или 1x 8-конт. Но они относятся к совместимости с блоком питания. Видеокарты используют 12-контактный интерфейс питания, блок питания должен обеспечивать достаточную мощность и количество штекеров для переходника.

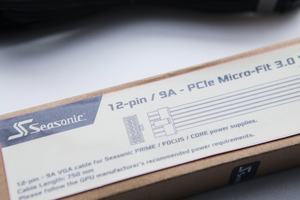

Некоторые производители блоков питания разработали кабели для модульных БП, которые подключаются напрямую к гнездам на блоке питания с одной стороны, а с другой стороны выдают 12-контактный штекер. Мы получили такой переходник от Seasonic. Но FSP, Corsair и многие другие производители БП тоже выпустят соответствующие кабели, которые можно будет приобрести.

Конечно, всегда лучше использовать специальный кабель для модульного БП от производителя, чем переходник NVIDIA. Переходник на 2x 6+2-контактных штекера - это еще один кабель в корпусе. Кроме того, на разъемах происходит потеря мощности.

Еще несколько фактов о кабелях, которые будут выпускать производители БП. Они не будут сертифицироваться или тестироваться NVIDIA. Но производителям БП рекомендуется использовать список AVL (Approved Vendor List), предоставленный NVIDIA. В нем приведены производители штекеров, продукцию которых следует использовать. Даже небольшие допуски могут привести к поломке интерфейса.

Seasonic для своего кабеля использует штекер производителя из AVL. Кабели 18AWG могут выдерживать ток до 9 А. Так что здесь Seasonic явно ориентирована на будущее. Вероятно, компания предполагает, что 350 Вт для GeForce RTX 3090 - это не предел. По кабелю Seasonic может подавать до 600 Вт мощности. Поскольку тепловой пакет будущих видеокарт мы не знаем, производители ориентируются на уровень выше 350 Вт.

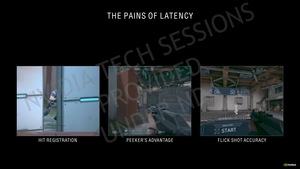

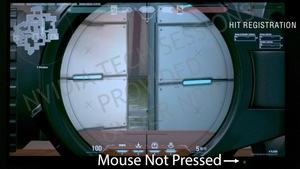

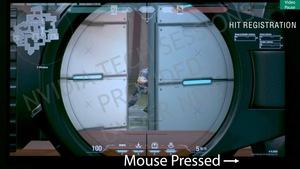

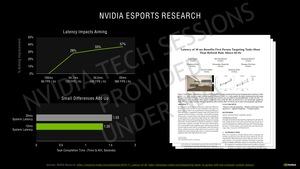

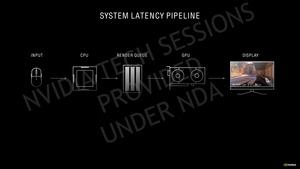

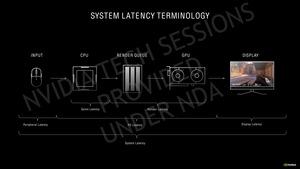

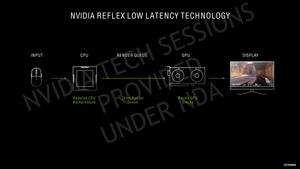

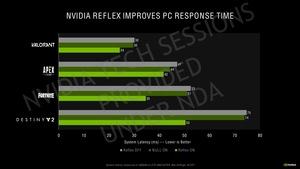

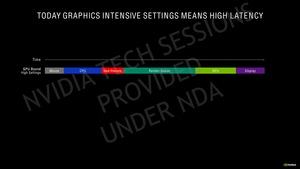

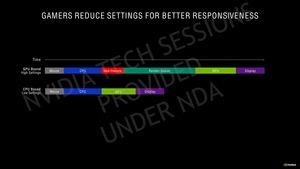

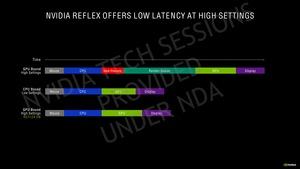

Мы не можем вынести окончательный вердикт по линейке RTX 30 на данный момент. К старту новой серии NVIDIA приготовила несколько видеороликов, которые смотрятся действительно впечатляюще. Мы уже отметили снижение системных задержек ввода между движением мыши и реакцией картинки на мониторах благодаря NVIDIA Reflex.

В статье мы не смогли детально разобрать все аспекты новых видеокарт, поскольку готовили ее в спешке. NVIDIA нацеливает новые видеокарты, в том числе, и на творческих профессионалов. Трассировка лучей будет играть все более значимую роль. И чем быстрее будут видеокарты, тем эта роль будет более приоритетной. DLSS тоже весьма активно развивается.

NVIDIA представила Machina - технология, которая выводит графику в реальном времени для кинематографии. Например, в сериале Мандалорец многие сцены были выведены на экранах, перед которыми находились актеры. Что можно назвать компромиссом между полностью виртуальными мирами и реальными сценами.

Для стримеров NVIDIA тоже предлагает полную экосистему. С помощью RTX Voice можно убрать из потока аудио лишние шумы, а также добавить виртуальное звуковое окружение. Эффективные способы кодирования (AV1) тоже вносят свой вклад.

Первая оценка

Конечно, сегодня осталось меньше "белых пятен" по техническому оснащению видеокарт. Мы знаем дизайн GA102 GPU и инновации, связанные с потоковыми процессорами или SM, третьим поколением ядер Tensor и вторым поколением ядер RT. Мы рассмотрели память GDDR6X и улучшения Hybrid Rendering Pipeline.

К сожалению, мы пока не можем поделиться результатами собственных тестов, а также значениями уровня шума, температуры и энергопотребления. Первой в нашу тестовую лабораторию доберется GeForce RTX 3080. Затем последует GeForce RTX 3090. На данный момент мы не будем комментировать результаты по энергопотреблению, температуре и уровню шума, опубликованные NVIDIA. Также NVIDIA не очень корректно подошла к оценке эффективности Ampere, видеокарты смотрятся очень хорошо, но методику мы не считаем верной.

Отметим, что с новыми видеокартами мы перейдем на новую тестовую систему. Мы будем использовать процессор Intel Core i9-10900K и материнскую плату MSI Z490 Tomahawk. Также произойдут изменения по выбору игр и приложений. Поэтому результаты наших тестов будут полностью новыми.

Подписывайтесь на группы Hardwareluxx ВКонтакте и Facebook, а также на наш канал в Telegram (@hardwareluxxrussia).