На пленарном докладе GPU Technology Conference NVIDIA представила новейшую архитектуру GPU под названием Volta. Также был объявлен первый вычислительный ускоритель Tesla V100, но архитектура Volta будет использоваться и во многих других продуктах. После пленарного доклада были проведены дополнительные семинары, на которых архитектуру Volta разобрали более детально. Мы как раз опубликовали подробный обзор.

На пленарном докладе GPU Technology Conference NVIDIA представила новейшую архитектуру GPU под названием Volta. Также был объявлен первый вычислительный ускоритель Tesla V100, но архитектура Volta будет использоваться и во многих других продуктах. После пленарного доклада были проведены дополнительные семинары, на которых архитектуру Volta разобрали более детально. Мы как раз опубликовали подробный обзор.

Сейчас же мы хотели бы поговорить об аппаратном обеспечении на архитектуре Volta. Пока что оно ограничено вычислительными ускорителями Tesla, ориентированными на использование в дата-центрах. NVIDIA пока не представила видеокарт GeForce, но упомянула, что GPU GV100 отлично справляется с рендерингом. Первые видеокарты GeForce на Volta вряд ли будут использовать версию GPU GV100. Скорее всего, они будут базироваться на урезанных чипах, что мы уже видели с предыдущей архитектурой Pascal. Те же ядра Tensor ориентированы на сферу глубокого обучения, поэтому на видеокартах GeForce они будут бесполезны.

Но на пленарном докладе NVIDIA упомянула теоретическую возможность того, что GPU GV100 могут использоваться и на игровых видеокартах, показав демонстрацию Square Enix.

NVIDIA Tesla V100

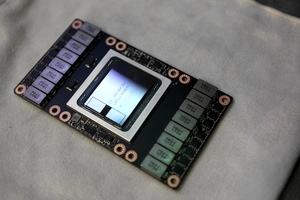

Но начнем с наиболее важного аппаратного компонента, объявленного на GPU Technology Conference: вычислительного ускорителя Tesla V100. Он будет представлен в трех разных версиях. Первая – на обычном модуле MXM2 для установки в серверы с NVLink. Из новшеств можно отметить поддержку NVLink 2.0 с более высокой пропускной способностью и большим числом каналов. Также есть вариант карты PCI Express для тренировки сетей глубокого обучения. Наконец, карта расширения Tesla V100 с тепловым пакетом 150 Вт в формате FHHL ориентирована на обработку запросов в сети глубокого обучения (inferencing).

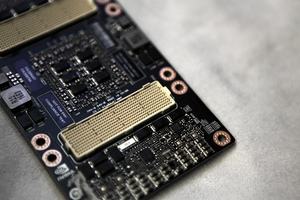

Все ускорители Tesla V100 имеют одинаковые технические спецификации, поскольку базируются на одном и том же GPU GV100. На площади чипа 815 мм² располагаются 21 млрд. транзисторов. Сам кристалл производится на заводах TSMC по 12-нм техпроцессу. В полной версии GPU GV100 содержит 5.376 потоковых процессоров, но на трех ускорителях будет использоваться версия с активными 5.120 потоковыми процессорами. Также на всех трех GPU доступны 640 ядер Tensor и 16 Гбайт памяти High Bandwidth Memory второго поколения.

Теперь поговорим об отличиях. Ускорители Tesla V100 в трех вариантах серьезно отличаются по энергопотреблению. У Tesla V100 на модуле MXM2 максимальное энергопотребление составляет 300 Вт. У варианта PCI Express – 250 Вт из-за спецификаций стандарта, поэтому тактовые частоты GPU будут несколько ниже. Но память будет по-прежнему работать на 878 МГц, что дает пропускную способность 900 Гбайт/с. В случае Tesla P100 все было несколько иначе, поскольку NVIDIA замедлила частоту памяти по сравнению с версией MXM2. Но в случае карты расширения PCI Express на Tesla V100 память не замедлена. Поэтому вычислительная производительность будет меньше модуля MXM2 только из-за меньших тактовых частот GPU.

Третий вариант Tesla V100 в чем-то напоминает AMD Radeon R9 Nano. Там AMD использовала GPU Fiji с памятью HBM, но частоты выставила на оптимальном уровне, обеспечивающем баланс между производительностью и энергопотреблением. Размер и эффективность системы охлаждения гармонировали с энергопотреблением. Но производительность Radeon R9 Nano все равно была довольно близка к Radeon R9 Fury X, поскольку использовался такой же дизайн GPU.

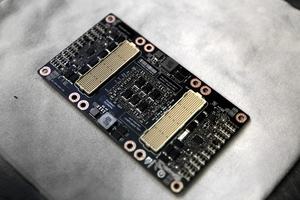

Данные ускорители Tesla V100 ориентированы на обработку запросов (inferencing) в сетях глубокого обучения. NVIDIA предлагает третий вариант ускорителей в формате Full Hight Half-Length (FHHL), энергопотребление не превышает 150 Вт. При данном уровне энергопотребления производительность, как обещает NVIDIA, составляет около 80% от "старшей" карты Tesla V100.

Поставки Tesla V100 в формате MXM2 намечены на третий квартал 2017 года. Сначала модулями будет оснащен суперкомпьютер Summit Министерства энергетики США. А с четвертого квартала 2017 OEM-клиенты NVIDIA получат в свое распоряжение карты расширения Tesla V100.

NVIDIA DGX-1 с ускорителями Tesla V100

В прошлом году NVIDIA представила готовый сервер, который теперь может оснащаться восемью Tesla V100. Название DGX-1 сохранено, разве что добавлено "with Tesla V100".

В случае сервера NVIDIA DGX-1 с Tesla V100 используются восемь новых ускорителей. Вычислительная производительность составляет 960 Tensor TFLOPS. Интересно сравнить производительность TFLOPS для 32- и 64-битных вычислений. Мы получим 60 TFLOPS с двойной точностью (64 бит) и 120 TFLOPS с одинарной точностью (32 бит). Сервер DGX-1 с предыдущим поколением Tesla P100 обеспечивал 170 Tensor TFLOPS, 42,4 TFLOPs с двойной точностью и 84,8 TFLOPS с одинарной. Сервер NVIDIA DGX-1 с Tesla V100 получил прирост производительности с тензорами в 5,6 раз, а с числами FP64 и FP32 – в 1,4 раза. Впрочем, здесь важнее как раз Tensor TFLOPS.

Сервер DGX-1 оснащен двумя 20-ядерными процессорами Intel Xeon E5-2698 v4 на 2,2 ГГц, 512 Гбайт памяти DDR4 LRDIMM на 2.133 МГц, 4x 1,92 TB SSD в массиве RAID 0, двумя контроллерами 10 GbE, поддерживает до четырех 4 IB EDR. Питание обеспечивают несколько блоков общей мощностью 3.200 Вт.

Сервер NVIDIA DGX-1 можно заказать напрямую у NVIDIA по цене 149 тыс. долларов США. Поскольку поставки планируются только в третьем квартале, покупатель пока что получит сервер DGX-1 с ускорителями Tesla P100, которые затем можно будет бесплатно заменить на новые Tesla V100.

NVIDIA DGX Station

Если у вас нет серверных комнат, или вы не желаете тратиться на DGX-1, NVIDIA теперь предлагает DGX Station. До сих пор если вам требовалось недорогое решение для глубокого обучения, приходилось обращаться к линейке GeForce. Но теперь есть и альтернатива в виде DGX Station.

В случае DGX Station используются четыре ускорителя Tesla V100 в виде карт расширения PCI Express. Но соединены между собой они через NVLink. Вся система охлаждается с помощью СВО. Кроме четырех карт Tesla V100 в станцию установлен Intel Xeon E5-2698 v4 на 2,2 ГГц. Добавьте к этому 256 Гбайт LRDIMM DDR4, 3x 1,92 TB SSD в массиве RAID 0 для хранения данных, еще один 1,92 TB SSD для операционной системы, два контроллера 10 Gb LAN и возможность подключать до трех мониторов через DisplayPort.

DGX Station тоже можно заказать напрямую у NVIDIA. Цена составляет $69.000, поставки начнутся в третьем квартале 2017.

NVIDIA HGX-1 на Tesla V100

Третий вариант серверного решения от NVIDIA поддерживает работу в облаке и предназначен для удаленного доступа. NVIDIA HGX-1 представляет собой версию DGX-1 с водяным охлаждением для использования в облаке HPC.

Однако систем HGX-1 не будут доступны конечным пользователям. NVIDIA будет отгружать их только крупным партнерам, таким как Amazon, Facebook, Microsoft и другим.

С помощью HGX-1 NVIDIA обеспечивает производительное и удобное решение для доступа к глубокому обучению через облако. NVIDIA GPU Cloud теперь сможет работать на самом производительном "железе". Здесь NVIDIA поддерживает широкий ассортимент продуктов, от NVIDIA Titan Xp или GeForce GTX 1080 Ti до Tesla V100.