В рамках конференции Supercomputing 2020 AMD представила новое поколение GPU-ускорителей для дата-центров. AMD Instinct MI100 - первый GPU-ускоритель, который базируется на архитектуре CDNA. AMD решила разделить архитектуру GPU на две ветки: RDNA для видеокарт Radeon и CDNA для ускорителей Instinct.

В рамках конференции Supercomputing 2020 AMD представила новое поколение GPU-ускорителей для дата-центров. AMD Instinct MI100 - первый GPU-ускоритель, который базируется на архитектуре CDNA. AMD решила разделить архитектуру GPU на две ветки: RDNA для видеокарт Radeon и CDNA для ускорителей Instinct.

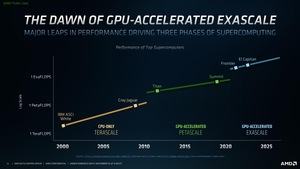

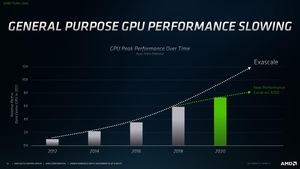

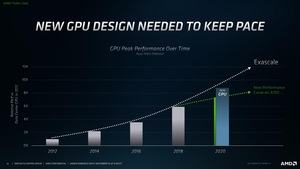

Сначала AMD указала, что процессоры EPYC станут отличной платформой, которую можно дополнять GPU. AMD тоже видит при разработке GPU-ускорителей ограничения по возможностям масштабирования, ссылаясь здесь на NVIDIA A100. В частности, производительность FP64 на данный момент не дотягивает до требований экзаскейла.

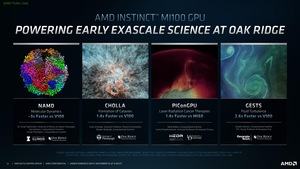

Представленный сегодня ускоритель Instinct MI100 как раз возвращает AMD на правильный путь развития, который обеспечивает масштабирование. AMD считает Instinct MI100 самым быстрым HPC GPU на сегодня. Отметим, что на конференции был анонсирован вариант PCI Express. Пока неизвестно, выпустит ли AMD вариант OAM с более высокой вычислительной производительностью.

GPU в составе Instinct MI100 содержит 120 блоков Compute Unit и 7.680 потоковых процессоров. Для сравнения: Radeon RX 6900 XT на Big Navi GPU и архитектуре RDNA 2 содержит 80 блоков Compute Units. AMD, по всей видимости, продолжает использовать 64 потоковых процессоров на CU, но по функциональным блокам имеются отличия, ориентированные на ускорения вычислений FP64, FP32, FP16, INT32, INT16 и любых других. Кроме того, GPU ускорителя Instinct MI100 лишен конвейера рендеринга. Так что даже простой кадр он вывести не сможет.

С ускорителем Instinct MI100 AMD сфокусировалась на высокой производительности с высокой точностью вычислений, то есть FP64 и FP32, что важно для сегмента HPC. Конечно, A100 GPU тоже способен справиться с подобными вычислениями, но NVIDIA видит его как ускоритель общего назначения для HPC и сегментов AI/ML. Ниже приведено сравнение спецификаций.

| AMD Instinct MI100 | NVIDIA A100 PCIe | |

| GPU | - | A100 |

| Техпроцесс | - | 7 нм |

| Число транзисторов | - | 54 млрд. |

| Площадь кристалла | - | 826 мм² |

| Блоки FP64 | 7.680 | 3.456 |

| Блоки FP32 | 15.360 | 6.912 |

| Производительность FP64 | 11,5 TFLOPS | 9,7 TFLOPS |

| Пиковая производительность FP64 | 11,5 TFLOPS | 19,5 TFLOPS (Tensor Cores) |

| Производительность FP32 | 23,1 TFLOPS | 19,5 TFLOPS |

| Пиковая производительность FP32 | 23,1 TFLOPS | 156 TFLOPS |

| Производительность FP16 | 184,6 TFLOPS | 312 / 624 TOPS |

| Производительность BFLOAT16 | 92,3 TFLOPS | 312 / 624 TOPS |

| Память | HBM2 | HBM2 |

| Емкость памяти | 32 GB | 40 GB |

| Ширина шины памяти | 4.096 бит | 5.120 бит |

| Пропускная способность памяти | 1,23 Тбайт/с | 1,536 Тбайт/с |

| TDP | 300 Вт | 250 Вт |

| PCIe | 4.0 | 4.0 |

| Интерконнект | Infinity Fabric 3x 267 Гбайт/с | NVLink 600 Гбайт/с |

При оценке числа вычислительных блоков и производительности следует учитывать несколько факторов. Влияние оказывает архитектура, и по чистому количеству блоков сложно судить о производительности. Кроме того, NVIDIA использует ядра Tensor для увеличения вычислительной производительности. В данном случае нам важны показатели FP64 и FP32. AMD Instinct MI100 обеспечивает 11,5 TFLOPS против 9,7 TFLOPS у A100. Вычислительная производительность FP32 находится примерно в такой же пропорции 23,1 против 19,5 TFLOPS.

Instinct MI100 оснащен 32 Гбайт HBM2 с пропускной способностью памяти 1,23 Тбайт/с против 40 Гбайт у A100 с 1,536 Тбайт/с. Так что у NVIDIA здесь есть преимущество по скорости памяти. Instinct MI100 заявлен с тепловым пакетом 300 Вт, у A100 PCIe он составляет 250 Вт. Для подключения используется стандарт PCI Express 4.0.

Ускоритель Instinct MI100 представляет собой обычную двухслотовую карту расширения PCI Express. Охлаждение выполняется пассивно воздушным потоком сервера. В задней части видеокарты можно видеть два разъема дополнительного питания. Есть и большое отверстие для прохождения воздушного потока. Кожух кулера изготовлен из черного текстурированного алюминия.

В одну структуру можно объединять до четырех карт. У каждого GPU есть три интерфейса Infinity fabric на 267 Гбайт каждый. Как можно видеть на фотографиях, мостики прикручиваются к картам. Без задней пластины видно, что AMD на самом деле предусмотрела три разъема питания на PCB, хотя установила только два. Неизвестно, выйдет ли вариант с тремя разъемами.

Конечно, AMD позиционирует ускорители Instinct MI100 на серверы с процессорами EPYC, поскольку они обеспечивают поддержку PCI Express 4.0, которой пока нет в случае платформ Intel. Здесь придется дожидаться моделей Ice Lake, которые выйдут в первом квартале 2021.

OEM и ODM представят первые системы с ускорителями Instinct MI100 в конце года. Цена ускорителей неизвестна.

Информации о GPU немного

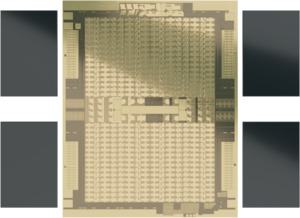

Пока что насчет GPU сведения очень скудные. AMD опубликовала whitepaper, но документ не такой глубокий, как в случае архитектур RDNA и GeForce от AMD и NVIDIA. Мы знаем число блоков Compute Units (120), число потоковых процессоров (7.680) и вычислительную производительность. AMD не дает подробностей о размере чипа и числе транзисторов. Кристалл производится по 7-нм техпроцессу. У нас есть фото кристалла GPU, но опубликовать его мы не можем, чтобы не выдать источник. Судя по нему, площадь чипа составляет порядка 730 мм².

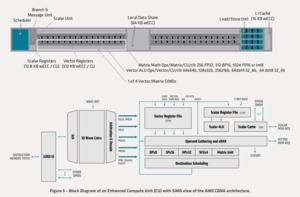

Вероятно, наиболее важной особенностью Compute Units в архитектуре CDNA является то, что они больше не состоят из классических потоковых процессоров. AMD здесь использует так называемую Matrix Core Technology, которая ориентирована на серверный сегмент.

Между двумя областями по 4 MB кэша L2 каждая (Instinct MI50 на основе Vega 20 GPU имел лишь 4 Мбайт в сумме), расположены четыре Asynchronous Compute Engines (ACE), которые отвечают за распределение вычислительных задач по отдельным вычислительным блокам. Последние опираются на Matrix Core Engine, позволяющий работать с данными разных форматов. Кэш L2 состоит из 32 слайсов по 256 кбайт каждый. С каждого слайса можно передавать 128 байт за такт на Compute Unit, что соответствует суммарной пропускной способности 6 Тбайт/с.

На уровне выше расположена подсистема памяти шириной 4.096 бит с пропускной способностью 1,23 Тбайт/с HBM2. Ускоритель Instinct MI100 оснащен 32 Гбайт памяти.

Все компоненты, отвечающие за рендеринг, были из GPU убраны. В том числе функции растеризации, тесселяции, графические кэши, движок дисплея и т.д. Оставлены были лишь фиксированные аппаратные блоки для кодирования и декодирования HEVC, H.264 и VP9.

Сами по себе CU унаследованы от предыдущей архитектуры GCN. Инструкции wavefront по ширине могут занимать до 64 рабочих блоков. Каждый CU оснащен Scalar Register File, Scalar Execution Unit и Scalar Data Cache для обработки инструкций, которые распределяются по 64 рабочим блокам. Кроме того, есть крупный Vector Register File, четыре блока Vector Execution Units, оптимизированных под FP32, и Vector Data Cache. Ширина векторного конвейера составляет 16 инструкций, поэтому 64 рабочих блока могут обрабатывать четыре векторных инструкции за такт.

Matrix Core Engines - гибкий процессор, который может выполнять новый тип инструкций wavefront, которые сгруппированы вместе подобно Matrix Fused Multiply-Add или MFMA. Данные инструкции могут работать с 4-битными целыми числами (INT4), 8-битными целыми числами (INT8), 16-битными числами с плавающей запятой половинной точности (FP16), 16-битными BFloat16 (bf16) и 32-битными числами с плавающей запятой одинарной точности (FP32).

| Instinct MI100 | Instinct MI50 | |

| Matrix FP16 | 184,6 TFLOPS | 26,5 TFLOPS |

| Matrix Bfloat16 | 92,3 TFLOPS | - |

| Matrix FP32 | 46,1 TFLOPS | 13,3 TFLOPS |

| Vector FP32 | 23,1 TFLOPS | 13,3 TFLOPS |

| Vector FP64 | 11,5 TFLOPS | 6,6 TFLOPS |

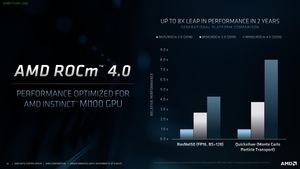

По сравнению с Instinct MI50, AMD существенно увеличила вычислительную производительность, особенно по форматам FP32 и FP16, хотя и по более высокой точности виден заметный прирост, пусть и не в такой степени. Впрочем, следует быть внимательным при сравнении производительности и учитывать специальные блоки, особенно в случае NVIDIA.

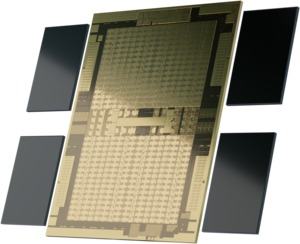

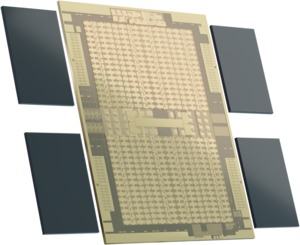

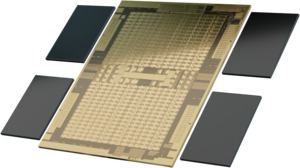

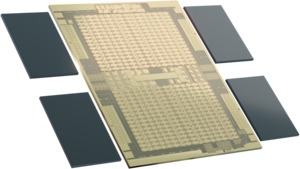

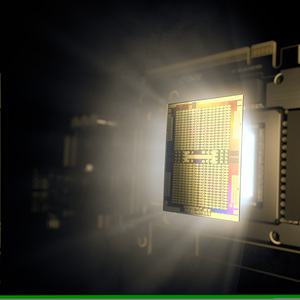

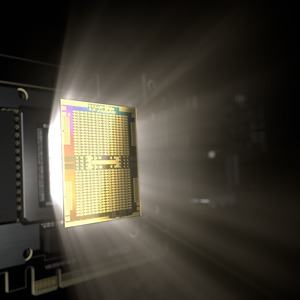

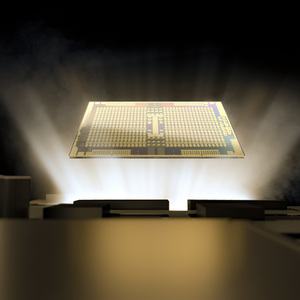

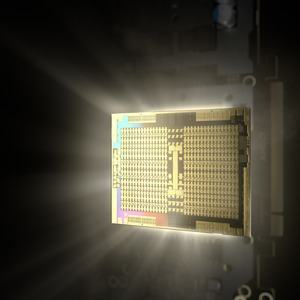

AMD показала рендеринги MI100 GPU. Как можно видеть, кристалл состоит из двух частей, что похоже на Navi и Big Navi GPU. В верхней и нижней половинах можно разглядеть 3.840 потоковых процессоров по равномерной структуре. По центру расположены компоненты Uncore, а также движки Asynchronous Compute Engines (ACE), распределяющие вычислительные задачи по CU. Четыре прямоугольных структуры по краям - физические интерфейсы PHY к четырем чипам памяти HBM2, которые нарисованы по соседству.

Подписывайтесь на группы Hardwareluxx ВКонтакте и Facebook, а также на наш канал в Telegram (@hardwareluxxrussia).