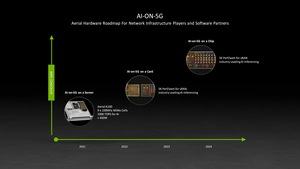

NVIDIA на конференциях ISC High Performance и Mobile World Congress, которая стартует сегодня в виртуальной форме, сделала ряд интересных анонсов. В частности, NVIDIA на MWC сфокусировалась на AI-on-5G. Многие компании, вовлеченные в инфраструктуру 5G, планируют усилить вычислительную производительность узлов на периферии. И для них NVIDIA как раз представляет Aerial A100, компактный сервер на основе host-процессора, ускорителя A100 GPU и BlueField DPU. Энергопотребление системы составляет порядка 450 Вт.

NVIDIA на конференциях ISC High Performance и Mobile World Congress, которая стартует сегодня в виртуальной форме, сделала ряд интересных анонсов. В частности, NVIDIA на MWC сфокусировалась на AI-on-5G. Многие компании, вовлеченные в инфраструктуру 5G, планируют усилить вычислительную производительность узлов на периферии. И для них NVIDIA как раз представляет Aerial A100, компактный сервер на основе host-процессора, ускорителя A100 GPU и BlueField DPU. Энергопотребление системы составляет порядка 450 Вт.

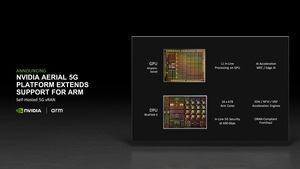

В будущем NVIDIA планирует перевести подобные системы на BlueField DPU нового поколения, которые будут работать вместе с GPU-ускорителем. Ядра ARM в будущих DPU от NVIDIA позволят отказаться от host-процессора. Так что NVIDIA сможет дать еще более тесную интеграцию аппаратных компонентов.

NVIDIA расширяет линейку своих продуктов, представляя вариант ускорителя A100 GPU с подключением PCI Express и удвоенным объемом памяти. Ранее объем составлял 40 Гбайт, теперь он 80 Гбайт. Впрочем, вариант SXM4 c 80 Гбайт памяти тоже существует довольно давно. Использование памяти HBM2E позволило не только увеличить емкость, но и пропускную способность. У 40-Гбайт варианта она составляет 1.555 Гбайт/с, у 80-Гбайт - 2.039 Гбайт/с. Тепловой пакет ускорителя PCIe заявлен 250 Вт, модели SXM4 могут работать с уровнем до 400 Вт.

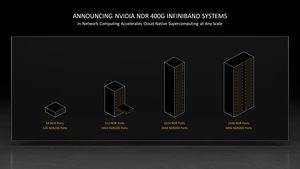

Наконец, NVIDIA в своей презентации подчеркнула, что скоростные сетевые подключения становятся все более важными. Через покупку Mellanox NVIDIA получила соответствующую компетенцию. Для масштабирования сетевой инфраструктуры компания предлагает скоростные сетевые коммутаторы с числом портов NDR до 64 (400 Гбит/с InfiniBand) высотой 2U. В случае стойки, полностью заполненной подобными коммутаторами, NVIDIA указывает 1.024 порта NDR 400G. Две стойки дадут уже 2.048 портов.

Также NVIDIA упомянула поддержку GPUDirect Storage. Технология прямого доступ к памяти была анонсирована в середине 2019 года. Вместо обращения через host-процессор, данные передаются из сети напрямую в память GPU-ускорителя. На уровне обычных ПК схожая функция реализована как DirectStorage, там обеспечивается прямой доступ GPU к накопителю NVMe.

В рамках ISC High Performance 2021 ожидается объявление многочисленных суперкомпьютеров в top20, которые будут опираться на GPU-ускорители NVIDIA. Но вместо классической вычислительной производительности FP64 многим приложениям нужна меньшая точность, поэтому системы ориентированы под пиковую производительность INT16 или даже INT8. NVIDIA как раз предлагает GPU-ускорители A100, которые могут работать с любыми точностями вычислений от FP64 до INT8. Производитель электромобилей Tesla, например, построил несколько кластеров, и новый третий кластер наверняка попадет в список суперкомпьютеров top 10.

Подписывайтесь на группы Hardwareluxx ВКонтакте и Facebook, а также на наш канал в Telegram (@hardwareluxxrussia).