Кроме первых процессоров EPYC с кэшем 3D V-cache, AMD сегодня представила Instinct MI200, новое поколение дискретного GPU-ускорителя для дата-центров. Как раз год назад был анонсирован Instinct MI100 на архитектуре CDNA. В отличие от игровой RDNA (Radeon DNA), архитектура CDNA (Compute DNA) специально ориентирована на дата-центры, то есть уже не является ответвлением игровой архитектуры с некоторыми изменениями.

Кроме первых процессоров EPYC с кэшем 3D V-cache, AMD сегодня представила Instinct MI200, новое поколение дискретного GPU-ускорителя для дата-центров. Как раз год назад был анонсирован Instinct MI100 на архитектуре CDNA. В отличие от игровой RDNA (Radeon DNA), архитектура CDNA (Compute DNA) специально ориентирована на дата-центры, то есть уже не является ответвлением игровой архитектуры с некоторыми изменениями.

С архитектурой CDNA-2, но также с новой корпусировкой Instinct MI200 AMD переходит на новый этап развития GPU-ускорителей. Если говорить точнее, планируется не одна модель, а целая серия ускорителей с разным дизайном.

Топовая модель будет содержать до 58 млрд. транзисторов, которые распределены по двум 6-нм кристаллам. Здесь можно отметить до 220 блоков Compute Units (CU) в сумме, до 880 матричных ядер и до 128 Гбайт памяти HBM2E с пропускной способностью 3,2 Тбайт/с.

Подчеркивая свои амбиции в сегменте HPC, AMD впервые выпускает ускорители Instinct MI200 в виде модуля OCP Accelerator Module (OAM) помимо варианта PCI Express. Позже будет выпущен и Instinct MI210 в варианте PCI Express.

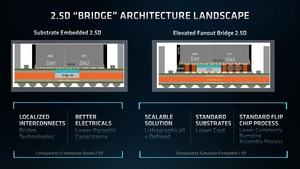

С технической точки зрения весьма интересна корпусировка с мостом 2.5D Elevated Fanout Bridge (EFB). AMD также подчеркивает сочетание двух кристаллов в топовой модели, что для GPU встречается впервые. Хотя AMD использует подход чиплетов для своих процессоров уже несколько лет.

Подписывайтесь на группы Hardwareluxx ВКонтакте и Facebook, а также на наш канал в Telegram (@hardwareluxxrussia).

Но перейдем к техническим спецификациям ускорителей Instinct MI200:

| Instinct MI100 | Instinct MI250 | Instinct MI250X | A100 80GB SXM | |

| Архитектура | CDNA | CDNA 2 | CDNA 2 | Ampere |

| Техпроцесс | 7 нм | 6 нм | 6 нм | 7 нм |

| Число транзисторов | - | 58 млрд. | 58 млрд. | 54 млрд. |

| Площадь кристалла | - | - | - | 826 мм² |

| Блоки FP64 | 7.680 | 13.312 | 14.080 | 3.456 |

| Блоки FP32 | 15.360 | 13.312 | 14.080 | 6.912 |

| Ядра Matrix / Tensor | - | 832 | 880 | 432 |

| Производительность FP64 (TFLOPS) | 11,5 | 45,3 | 47,9 | 9,7 |

| Пиковая производительность FP64 (TFLOPS) | 11,5 | 90,5 | 95,7 | 19,5 |

| Производительность FP32 (TFLOPS) | 23,1 | 45,3 | 47,9 | 19,5 |

| Пиковая производительность FP32 (TFLOPS) | 23,1 | 90,5 | 95,7 | 156 |

| Производительность FP16 (TFLOPS) | 184,6 | 362,1 | 383 | 312 / 624 |

| Производительность BFLOAT16 (TFLOPS) | 92,3 | 362,1 | 383 | 312 / 624 |

| Память | HBM2 | HBM2E | HBM2E | HBM2 |

| Емкость памяти | 32 GB | 128 GB | 128 GB | 80 GB |

| Ширина шины памяти | 4.096 бит | 8.192 бит | 8.192 бит | 5.120 бит |

| Пропускная способность памяти | 1,23 Тбайт/с | 3,2 Тбайт/с | 3,2 Тбайт/с | 2 Тбайт/с |

| TDP | 300 Вт | 500 / 560 Вт | 500 / 560 Вт | 400 / 500 Вт |

| PCIe | 4.0 | 4.0 | 4.0 | 4.0 |

| Интерконнект | Infinity Fabric 3x 267 Гбайт/с |

Infinity Fabric 6 каналов | Infinity Fabric 8 каналов | NVLink 600 Гбайт/с |

Instinct MI250 и MI250X используют полные версии двух GPU, так называемых кристаллов Graphics Compute Dies (GCD) с 29 млрд. транзисторов каждый. Instinct MI250 содержит 104 активных блоков CU (compute units) на кристалл (208 в сумме), у Instinct MI250X их число составляет 110 CU (220 в сумме). Тактовые частоты GPU составляют до 1.700 МГц.

В архитектуре CDNA-2 каждый CU содержит четыре матричных ядра и 64 ядра шейдеров (4x 16-wide SIMD). Каждый кристалл Graphics Compute Die (GCP) теоретически содержит 112 блоков CU, но активны из них, максимум 110 на Instinct MI250X.

Сами CU унаследованы из архитектуры GCN. Инструкции wavefront по ширине могут занимать до 64 рабочих блоков. Регистры и весь конвейер оптимизированы для скалярных, векторных и матричных вычислений. Для матричных вычислений есть отдельный путь, который лучше справляется с разреженными матрицами и повторным использованием данных.

Архитектура CDNA-2 ориентирована на вычисления с высокой точностью. Векторный конвейер новых ускорителей Instinct, как можно видеть в таблице, с равной производительностью справляется с вычислениями FP32 и FP64.

Есть и многие другие оптимизации, которые видны по скорости обработки разных форматов данных.

| MI100 FLOPS/такт/CU | MI250X FLOPS/такт/CU | MI100 Пик (TF)OPS) | MI250X Пик (TF)OPS) | |

| Матричные FP64 | 64 | 256 | 11,5 | 95,7 |

| Векторные FP64 | 64 | 128 | 11,5 | 47,9 |

| Матричные FP32 | 256 | 256 | 46,1 | 95,7 |

| Packed FP32 | 128 | 256 | 23,1 | 95,7 |

| Векторные FP32 | 128 | 128 | 23,1 | 47,9 |

| Матричные FP16 | 1.024 | 1.024 | 194,6 | 383 |

| Матричные BF16 | 512 | 1.024 | 92,3 | 383 |

| Матричные INT8 | 1.024 | 1.024 | 92,3 | 383 |

В частности, весьма интересна вычислительная производительность FP64, которая очень важна для сегмента HPC. И здесь AMD показывает более чем восьмикратный прирост по сравнению с предшественником. По другим форматам данных прирост производительности составляет 2-4 раза. По сравнению с конкурентами, прирост FP64 четырехкратный, хотя NVIDIA может выполнять вычисления FP32, FP16 и форматов с меньшей точностью через ядра Tensor, компенсируя отставание.

Причина такого роста производительности кроется в матричных ядрах архитектуры CDNA-2. Они предназначены для умножения блоков 16x16x4 и 4x4x4. По умножению матричных инструкций FP64 производительность в два раза выше, чем для векторных инструкций, что и привело к упомянутому росту производительности ускорителей Instinct. Кроме того, матричные блоки помогают и в вычислениях BF16.

В архитектуре CDNA-2 поддерживается новый формат Packed FP32. Здесь две векторные инструкции с операндом FP32 для FMA, FASS и FMUL упаковываются вместе. Формат Packed FP32 обеспечивает двукратный прирост производительности векторных вычислений FP32.

Однако у высокой вычислительной производительности есть и недостатки. Например, Instinct MI250 и MI250X работают с TDP 500 Вт при воздушном охлаждении. В случае водяного охлаждения возможен уровень до 560 Вт. Впрочем, NVIDIA указывает максимальный TDP 500 Вт для A100 Tensor GPU.

Дизайн чиплетов теперь и для GPU-ускорителей

С ускорителями Instinct MI200 AMD тоже переходит на дизайн чиплетов, сочетая два кристалла GCP в одной корпусировке. Кроме того, кристаллы GCP (Graphics Compute Dies) производятся по 6-нм техпроцессу на мощностях TSMC, до сих пор GPU производились по 7- или 8-нм технологии на заводах TSMC и Samsung.

AMD использовала специальный мост 2.5D Elevated Fanout Bridge (EFB), разработанный вместе с TSMC.

До сих пор для подключения HBM чаще всего использовался кремниевый мост, интегрированный в подложку. Данный метод имеет свои преимущества, но есть и недостатки, связанные с масштабируемостью и ценой.

Мост Elevated Fanout Bridge (EFB) опирается на стандартную подложку чипа, которую можно дешево и быстро производить. Между кристаллом и подложкой используются шариковые контакты, то же самое касается и EFB. Мост EFB расположен между медными контактами кристаллов и подложкой, тоже с шариковыми контактами.

К преимуществам Elevated Fanout Bridge, помимо простой кремниевой подложки, можно отнести большую гибкость по литографии, а также классическую установку чипов в корпусировку flip-chip.

Через Elevated Fanout Bridge сначала будут подключаться восемь кристаллов HBM2E ускорителей Instinct MI250 и MI250X. Восемь кристаллов каждый соединяются по 1.024-битному интерфейсу, в итоге ширина составляет 8.192 бита. HBM2E на 1.600 МГц обеспечит пропускную способность памяти 3,276 Тбайт/с.

Сложно сказать, отвечает ли EFB за соединение двух кристаллов GCP. Конечно, здесь очень важна скорость. Используемый интерфейс Infinity Fabric обеспечивает двунаправленную передачу данных на 400 Гбайт/с между GCD.

Также имеются и внешние интерфейсы Infinity Fabric, через которые можно подключать дополнительные GPU. Каждый GPU содержит восемь каналов, что дает 800 Гбайт/с в сумме. Поддерживается и когерентный host-интерфейс, представляющий собой Infinity Fabric с 16 каналами между ускорителями Instinct и новыми процессорами EPYC, но может использоваться и простое подключение PCI Express с 16 линиями.

Скоро должны выйти первые системы на AMD Instinct MI250 и MI205X. Вариант PCI Express появится чуть позже.