Нынешняя популярность GPT-4 и искусственного интеллекта пришлась как нельзя кстати для компаний, выпускающих соответствующее программное и аппаратное обеспечение. Например, NVIDIA – один из производителей «железа» для систем с использованием Больших языковых моделей (Large Language Model, LLM).

Нынешняя популярность GPT-4 и искусственного интеллекта пришлась как нельзя кстати для компаний, выпускающих соответствующее программное и аппаратное обеспечение. Например, NVIDIA – один из производителей «железа» для систем с использованием Больших языковых моделей (Large Language Model, LLM).

По большей части подобные системы работают на ускорителях A100 – по крайней мере, это верно для GPT-4 в контексте OpenAI и Microsoft. Но системы постепенно переходят на более мощные ускорители H100, которые в ближайшие месяцы станут более доступными, они появятся и в виде облачных инстанций.

NVIDIA решила воспользоваться возможностью, чтобы представить еще один вариант ускорителя GH100 под названием H100 NVL. Он представляет собой гибрид вариантов SXM5 и PCI Express ускорителя H100. NVIDIA для карты PCI Express выбрала меньшую степень расширения GH100 GPU, но даже вариант SXM5 не был оснащен полными 18.432 вычислительными блоками FP32 и полными 96 Гбайт HBM3, которые теоретически возможны. Впрочем, в случае того же GA100 GPU NVIDIA смогла использовать только пять тайлов HBM2 из шести, что связано с долей выхода годных кристаллов и корпусировкой в целом.

С новым H100 NVL подход несколько меняется. GPU используется в той же конфигурации, что и в случае варианта SXM5, но NVIDIA, наконец, смогла задействовать все шесть тайлов HBM3, чтобы дать более высокую пропускную способность памяти. Однако придется довольствоваться 94 Гбайт вместо 96 Гбайт, что NVIDIA объясняет «оптимизациями производства». Что именно здесь скрывается – неизвестно. Как мы предполагаем, NVIDIA не смогла настроить Snoop Filter на обработку всех 96 Гбайт адресного пространства.

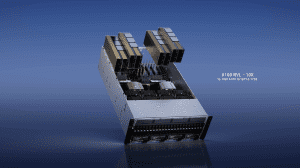

H100 NVL состоит из двух PCB, каждая содержит корпусировку с GH100 GPU. Ускоритель подключается к host-системе через PCI Express 5.0. OEM и системные интеграторы могут установить до четырех подобных двойных ускорителей в свои серверы. GPU соединяются друг с другом через NVLink с пропускной способностью до 600 Гбайт/с.

| | GH100 (полный) | H100 NVL | H100 SXM5 | H100 PCIe |

| GPCs | 8 | 2x 8 | 8 | 7 oder 8 |

| TPCs | 72 | 2x 66 | 66 | 57 |

| Число SM | 144 | 2x 132 | 132 | 114 |

| Блоки FP32 | 18.432 | 2x 16.896 | 16.896 | 14.592 |

| Кэш L2 | 60 MB | 2x 50 MB | 50 MB | 50 MB |

| Ядра Tensor | 576 | 2x 528 | 528 | 456 |

| Память | 96 GB HBM3/HBM2E | 2x 94 GB HBM3 | 80 GB HBM3 | 80 GB HBM2E |

| Пропускная способность | - | 2x 3,94 Тбайт/с | 3,35 Тбайт/с | 2 Тбайт/с |

| Интерконнект | - | NVLink 600 Гбайт/с | NVLink 900 Гбайт/с | NVLink 600 Гбайт/с |

| Интерфейс | - | PCIe 5.0 x16 | PCIe 5.0 x16 | PCIe 5.0 x16 |

| TDP | - | 2x до 400 Вт | до 700 Вт | до 350 Вт |

Вычислительная производительность соответствует двум H100 в варианте SXM5. Более крупная емкость памяти должна быть полезна в вычислениях ИИ. NVIDIA не дает информацию о ценах. Вариант H100 с интерфейсом PCI Express мы еще не обнаружили в продаже. Предшественник A100 стоит почти €17.000. На рынке ускорители H100 NVL будут доступны не раньше второй половины года.

Бум искусственного интеллекта наверняка скажется на следующих квартальных результатах NVIDIA. Будем надеяться, компания сможет компенсировать падение продаж GeForce GPU.

Подписывайтесь на группу Hardwareluxx ВКонтакте и на наш канал в Telegram (@hardwareluxxrussia).