В минувшую пятницу NVIDIA представила новую технологию G-Sync, которая призвана решить проблемы разрывания картинки, подёргиваний и большого времени отклика, многие годы досаждавшие геймерам. Конечно, NVIDIA за прошедшие годы серьёзно оптимизировала производительность, качество графики, а также постаралась максимально улучшить восприятие геймплея, но упомянутые проблемы так и не удавалось полностью решить. Чтобы понять, каким образом NVIDIA удалось справиться с проблемами разрывания и подёргивания картинки, следует сначала поговорить о причинах их возникновения.

В минувшую пятницу NVIDIA представила новую технологию G-Sync, которая призвана решить проблемы разрывания картинки, подёргиваний и большого времени отклика, многие годы досаждавшие геймерам. Конечно, NVIDIA за прошедшие годы серьёзно оптимизировала производительность, качество графики, а также постаралась максимально улучшить восприятие геймплея, но упомянутые проблемы так и не удавалось полностью решить. Чтобы понять, каким образом NVIDIA удалось справиться с проблемами разрывания и подёргивания картинки, следует сначала поговорить о причинах их возникновения.

Из древних времён в наши дни перешла частота обновления мониторов, то есть число кадров в секунду, которое может выводить монитор: 60, 120 или 144 Гц. Видеокарта выполняет рендеринг кадров с постоянно меняющейся частотой, которую неплохо было бы синхронизировать с частотой монитора. Если выставить на видеокарте частоту обновления 60 Гц (VSync), то видеокарта будет в оптимальном случае выводить кадры на монитор с частотой 60 Гц, картинка будет идеальной. Но на практике так случается редко, поскольку каждая сцена в игре накладывает свои требования на вычисления на видеокарте, поэтому и производительность меняется.

Если видеокарта подаёт на монитор больше кадров в секунду, чем он может выводить, то появляется эффект разрывания картинки. На монитор уже подаётся новый кадр, хотя он ещё не завершил вывод текущего кадра. В результате получается картинка с горизонтальным смещением. Верхняя картинка старая, ниже уже выводится новая. Кадр кажется как бы разорванным.

Разрывание можно предотвратить с помощью VSync. Если активировать вертикальную синхронизацию VSync, то обновление кадров на мониторе будет производиться только тогда, когда он готов принимать следующий кадр. Только после передачи всего кадра происходит переключение на следующий. При включении VSync выводятся только полные кадры. Но производительность видеокарты при этом снижается до уровня обновления картинки монитора, игра начинает "подтормаживать".

Так что многие геймеры предпочитают отключать VSync, чтобы получить максимально быстрое время отклика в играх. Приходится смириться с разрыванием картинки, либо включить VSync и получить задержки и подёргивания. Следует понимать, что с проблемой разрывания, задержек и подёргиваний программно полностью справиться невозможно, нужны аппаратные решения.

Монитор синхронизируется с видеокартой

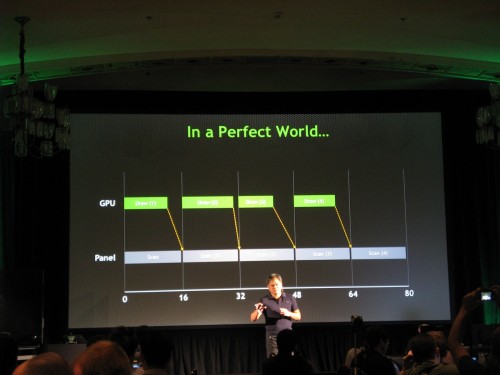

Именно это и сделала NVIDIA с новой технологией G-Sync. Решение проблемы на самом деле довольно простое: частота обновления на мониторе может гибко меняться. То есть частота обновления монитора синхронизируется с частотой на видеокарте. Уже не видеокарта зависит от монитора, а наоборот. Если видеокарта не успевает выдавать кадры с высокой частотой, то и частота обновления монитора будет автоматически понижена до такого же уровня, чтобы на экран выводились только полные кадры, без разрывания картинки и подтормаживания. Время отклика в игре не будет при этом ухудшаться.

В Монреале калифорнийская компания показала работу G-Sync в действии - было проведено сравнение с обычным монитором, с активной или выключенной VSync. Разница между двумя системами была ощутимой - эффект от G-Sync был заметен не только в демонстрациях NVIDIA, но и в игре Tomb Raider. Технология G-Sync, по нашему мнению, существенно улучшает качество геймплея. Но работу G-Sync следует наблюдать только вживую, поскольку фотоаппараты и видеокамеры имеют свою частоту обновления, поэтому не могут передать эффект G-Sync на видео.

Успех G-Sync целиком зависит от того, сколько производителей мониторов будут использовать новые модули NVIDIA, сможет ли калифорнийская компания привлечь на свою сторону производителей. Такие компании, как ASUS, BenQ, Philips и Viewsonic, уже объявили выпуск своих устройств в первом квартале 2014 года, но для поддержки вам придётся обзавестись видеокартой NVIDIA поколения "Kepler", начиная с GeForce GTX 650 Ti Boost. Некоторые мониторы можно будет модернизировать с помощью комплекта обновления, продающегося отдельно.