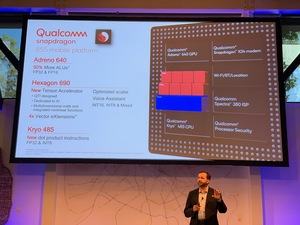

В своих SoC Qualcomm уже довольно давно использует аппаратные блоки для ускорения инференса, что позволяет оптимизировать такие задачи, как улучшение фотографий, распознавание речи и другие. Но сейчас Qualcomm встает еще на ступеньку выше. На мероприятии AI Day в Сан-Франциско был объявлен дискретный ускоритель инференса.

В своих SoC Qualcomm уже довольно давно использует аппаратные блоки для ускорения инференса, что позволяет оптимизировать такие задачи, как улучшение фотографий, распознавание речи и другие. Но сейчас Qualcomm встает еще на ступеньку выше. На мероприятии AI Day в Сан-Франциско был объявлен дискретный ускоритель инференса.

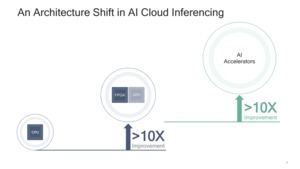

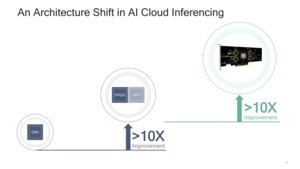

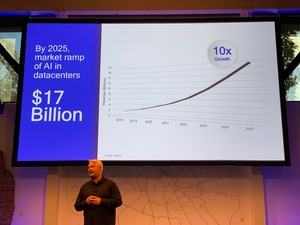

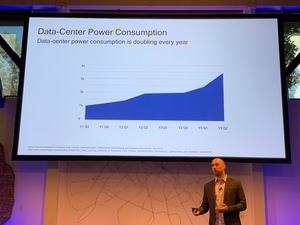

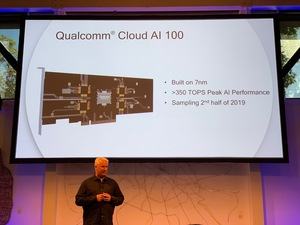

Qualcomm оценивает этот рынок на $17 млрд. к 2025 году, поэтому компания планирует представить собственные аппаратные решения. Здесь Qualcomm опирается на свою компетенцию по разработке SoC. Также вносит свой вклад и программная поддержка. В результате чиповый гигант планирует представить линейку Cloud AI-100 в 2020 году.

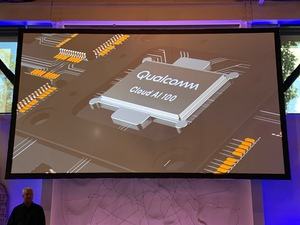

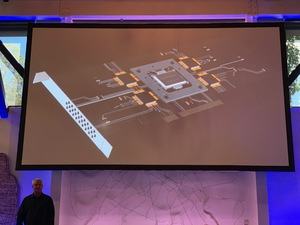

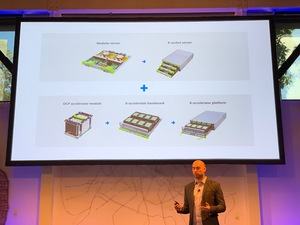

Первые образцы Cloud-AI-100 появятся уже в этом году. Они будут представлять собой карту расширения для дата-центров. Планируются разные варианты по производительности, дизайну и тепловому пакету. ASICs (Application Specific Integrated Circuit) в ускорителях будут производиться по 7-нм техпроцессу. Скорее всего, по 7-нм техпроцессу HPC на мощностях TSMC. Дополнительные технические подробности пока неизвестны. Не совсем понятно, планирует ли Qualcomm использовать только один чип, или мы получим разные варианты расширения.

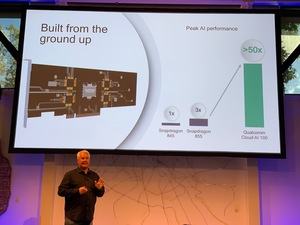

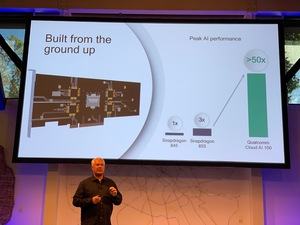

Дизайн ускорителей Cloud AI-100 был разработан "с нуля". Конечно, Snapdragon SoC поддерживают определенное ускорение задач искусственного интеллекта, но вряд ли их можно хорошо масштабировать. Поэтому Qualcomm выбрала новый подход к архитектуре.

Интересно, что Qualcomm решила продвигаться именно в задаче инференса, то есть обработки запросов в сеть глубокого обучения. Что сразу же говорит о специализации ускорителей. То есть тренировка сетей глубокого обучения на Cloud AI-100 не планируется. Здесь можно провести параллель больше с Google Tensor Processing Units (TPU), чем с ускорителями NVIDIA GPU. Последние различаются по ориентации: архитектура Volta является гибридом для тренировки и инференса (Tesla V100), а архитектура Turing нацелена только на инференс (Tesla T4).

Qualcomm раскрыла предварительные сведения о производительности. Ускорители Cloud AI-100 будут работать примерно в 17 раз быстрее Snapdragon 855. А Snapdragon 820, который послужил основой для тестов, дает только 1/50 часть производительности. К сожалению, подробностей пока нет. В ближайшие 12 месяцев Qualcomm наверняка раскроет дополнительные детали.

Qualcomm против NVIDIA и Intel

Конкуренция на рынке ускорителей тренировки и инференса сетей глубокого обучения продолжает увеличиваться. На данный момент здесь доминирует NVIDIA, но Google весьма успешно использует собственные TPU в дата-центрах, да и NEC выпускает векторные ускорители SX Aurora TSUBASA. AMD продвигает свои ускорители Radeon Instinct, но рыночная доля всех конкурентов NVIDIA пока очень мала из-за отсутствия программной поддержки. Все же NVIDIA более десяти лет развивала программную экосистему CUDA, которую сегодня используют более 90% разработчиков. AMD в данном отношении так и не достигла успеха с ROCm, рынок у компании очень мал.

Так что перед Qualcomm и Intel стоит весьма серьезная задача создания программной экосистемы, которая позволит разработчикам и партнерам выполнять свою работу без дополнительных трудностей. Обе компании весьма успешно разрабатывают аппаратную часть, и программная поддержка Intel будет как раз опираться на широкую аппаратную базу. А Qualcomm в данном отношении придется тяжелее.