Сейчас в США проходит конференция Hotchips. На ней производители объявляют различные инновации в сфере разработки чипов, в том числе AMD, Intel, NVIDIA и многие другие. Так что в ближайшие дни нас ждут интересные новости и презентации.

Сейчас в США проходит конференция Hotchips. На ней производители объявляют различные инновации в сфере разработки чипов, в том числе AMD, Intel, NVIDIA и многие другие. Так что в ближайшие дни нас ждут интересные новости и презентации.

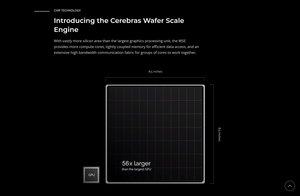

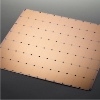

Внимание на конференции Hotchips привлек к себе стартап Cerebras с весьма амбициозными планами. Чип Cerebras представляет собой огромный чиплет. Сейчас пластина (wafer) в процессе полупроводникового производства разрезается на отдельные кристаллы, которые затем могут комбинироваться в многочиповой системе. Однако Cerebras использует дизайн Wafer Scale Engine (WSE), в котором пластина не разрезается на чипы - они образуют единый вычислительный блок, гигантский чип на пластине.

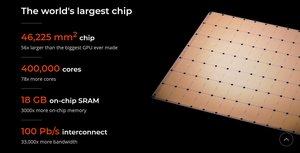

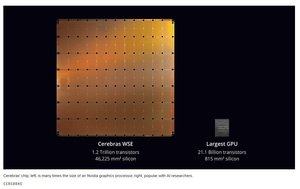

Подобный чип способен побить все мировые рекорды полупроводникового производства. Так, площадь чипа составляет 46.225 мм². Для сравнения, у NVIDIA GV100 GPU мы получаем 815 мм², а у самого крупного процессора Intel Xeon - около 700 мм². Новые процессоры EPYC (Rome) содержат девять чиплетов (8x CCD + 1x IOD), суммарная площадь составляет почти 1.000 мм², но в данном случае речь не идет о монолитном чипе. В случае 46.225 мм² и дизайна WSE мы получаем чип, чьи размеры ограничены 300-мм пластиной.

Также Cerebras указывает 1,2 трлн. транзисторов на чипе. У самого крупного GPU, вновь NVIDIA GV100, работают только 21,1 млрд. транзисторов. В случае же EPYC мы получаем около 33 млрд. транзисторов. Так что чип WSE на пару порядков больше и сложнее.

В дизайне WSE планируется выпустить ускоритель вычислений искусственного интеллекта. Речь идет не об обычном процессоре, способном выполнять стандартные вычисления, как, например, CPU EPYC или Xeon. Поэтому число ядер оценить сложно, для WSE их число заявлено 400.000. Для сравнения, у NVIDIA GV100 GPU мы получаем 5.376 потоковых процессоров.

Из других функций Cerebras указывает 18 Гбайт памяти SRAM на чипе, что тоже очень много. Интерконнект между ядрами, памятью и другими компонентами будет работать с суммарной пропускной способностью 100 Пбайт/с. Интерконнект реализован в виде полносвязной топологии (2D Mesh) и назван Swarm (рой), что подчеркивает принцип работы.

Экстенсивное решение проблемы

Cerebras Wafer Scale Engine - типичное экстенсивное решение проблемы, когда недостаток вычислительной мощности решается ее увеличением. Действительно, тренировка сетей глубокого обучения и инференс требуют как можно более высокой вычислительной производительности и скоростного подключения памяти. Неслучайно крупные сети сегодня группируются вместе, а память переносится все ближе и ближе к вычислительным блокам в виде HBM.

Также многие производители работают над специализированными чипами, которые позволяют выполнять определенные вычисления с высокой скоростью. Почти все компании, работающие в сегменте дата-центров, работают над подобными решениями. Но стартап Cerebras, конечно, выбрал наиболее экстремальный подход.

Когда мы увидим подобное решение на практике, и увидим ли вообще? Ответ на эти вопросы зависит от нескольких факторов. Вне всякого сомнения, Cerebras придется преодолеть немало технических проблем. Непосредственно кроме производства вопросы вызывают питание и охлаждение подобного чипа.

Кроме технических аспектов разработки подобного чипа, Cerebras придется решать вопрос программного обеспечения. Поскольку "железо" имеет смысл только тогда, когда его умеют использовать приложения.