Во время проведения конференции ISC 21 разработчик MLCommons представил результаты MLPerf Training 1.0. С последней версией условия участия были облегчены, что позволит большему числу компаний представлять результаты.

Во время проведения конференции ISC 21 разработчик MLCommons представил результаты MLPerf Training 1.0. С последней версией условия участия были облегчены, что позволит большему числу компаний представлять результаты.

Кроме того, ранее используемые бенчмарки перевода GNMT и Transformer были исключены из оценки. Но добавилось приложение-диктор (text-to-speech) RNNT. Также в пакет было добавлено приложение 3D-UNet, распознающее опухоли на медицинских сканах. Два новых бенчмарка можно назвать весьма полезной добавкой к существующему набору (ImageNet - ResNet, COCO SSD, COCO Mask R-CNN, BERT, DLRM и Minigo), если верить MLCommons и партнерам.

Кроме того, MLCommons получила больше участников своего бенчмарка Training, теперь добавились Gigabyte, Graphcore, Habana Labs, Lenovo, Nettrix, PCL & PKU и Supermicro. В результате число результатов увеличилось с 138 для Training 0.7 до более 650, что позволяет более эффективно их сравнивать.

Участники проводят тесты своих систем на процессорах AMD EPYC (Rome и Milan) и Intel Cooper Lake Xeon. Конечно, применяются ускорители. Ранее почти исключительно использовались ускорители NVIDIA A100 - иногда в виде модулей SXM, иногда вариантов PCIe с разными конфигурациями TDP. Системы оснащались от 2 до 1.728 процессоров. Что касается аппаратных ускорителей от той же NVIDIA, то участвовали системы, содержащие до 4.096 карт A100. Google представила результаты 1.728 процессоров EPYC и 3.456 TPUs.

Для Google и NVIDIA демонстрация масштабирования программного и аппаратного обеспечения принципиально важна, поскольку они желают привлечь внимание гиперскейлеров к своим решениям. А Google еще и показывает преимущество собственных разработок. Если тренировка (в зависимости от модели) с двумя процессорами и четырьмя GPU-ускорителями выполняется от нескольких минут до часа, та же самая модель ML выполняется на системе большего масштаба за 30 секунд или даже быстрее. Но модели ML становятся все сложнее, иногда они содержат до 4 трлн. параметров, поэтому на тренировку могут уйти дни и недели. Здесь важны системы большого масштаба, содержащие несколько тысяч процессоров и ускорителей, поскольку они могут уменьшить время вычислений в два раза, например.

Последние результаты MLPerf Training 1.0 можно найти здесь.

Google представила TPUv4

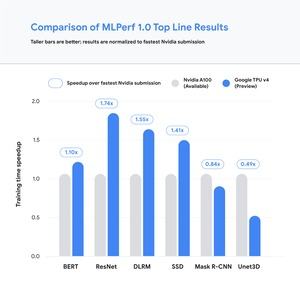

Google на данный момент валидирует ускорители TPUv4 собственной разработки. Последнее поколение Tensor Processing Units разработано специально для инференса, но в системе они использовались для тренировки. NVIDIA здесь остается лидером индустрии, поэтому большинство производителей сравнивают свои результаты с ускорителями A100.

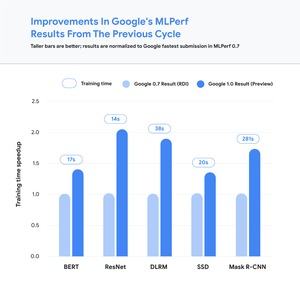

Google говорит о своем превосходстве над NVIDIA в четырех тестах пакета MLPerf из шести. Но Google также гордится улучшениями результатов по сравнению с MLPerf Training 0.7, где участвовали TPUv3.

Google намерена как можно быстрее предоставить клиентам TPUv4 Pods. TPUv4 Pod использует 4.096 специальных ASICs и дает пиковую производительность 1,1 ExaFLOPS в приложениях ML.

Graphcore атакует NVIDIA

Одним из новых производителей, конкурирующих по тренировке сетей глубокого обучения с известными компаниями, является Graphcore. Летом 2020 британский разработчик представил Colossus Mk2 GC200 IPU. IPU (Intelligence Processing Unit) производится по 7-нм техпроцессу на заводах TSMC. Чип состоит 59,4 млрд. транзисторов на площади 823 мм², что примерно сравнимо с NVIDIA GA100. Процессор содержит 1.472 так называемых ядер IPU, которые могут обрабатывать 8.832 вычислительных потоков. Также отметим наличие 900 Мбайт SRAM.

IPUs оптимизированы под вычисления данных в собственном формате. Graphcore называет его AI float, и для эффективности вычислений разрядность данных не превышает 16 бит. Вычислительные блоки также поддерживают FP32, FP16.32 (16 бит умножение, 32 бит сложение) и FP16.16 (16 бит умножение и сложение). Подобно вычислительным блокам NVIDIA GA100 GPU, ядра IPU поддерживают разреженные матрицы (sparsity/sparse matrix). Если матрица состоит из очень большого числа нулей, то для более эффективного вычисления и хранения таких матриц применяются специальные технологии.

Благодаря результатам MLPerf Graphcore планирует подвинуть именитые бренды по соотношению цена/производительность. IPU-POD16 с 16 Colossus Mk2 GC200s примерно на 60% обгоняет DGX Station A100 по соотношению цена/производительность. Цена последней составляет $299.000, но IPU-POD16 стоит "всего" $149.995. В тесте BERT прирост составляет всего 30%.

Следующим шагом Graphcore планирует масштабировать системы до 64 Colossus Mk2 GC200s и выше. Конфигурации с несколькими тысячами GC200s смогут дать высокий уровень производительности с низкой точностью, на уровне Google и NVIDIA.

Подписывайтесь на группы Hardwareluxx ВКонтакте и Facebook, а также на наш канал в Telegram (@hardwareluxxrussia).