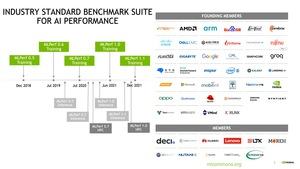

Мы уже несколько раз сообщали подробности бенчмарков MLCommons, поскольку данная компания желает закрепиться как разработчик независимых тестов в разных категориях, в том числе для сравнения ускорителей искусственного интеллекта/машинного обучения разных производителей.

Мы уже несколько раз сообщали подробности бенчмарков MLCommons, поскольку данная компания желает закрепиться как разработчик независимых тестов в разных категориях, в том числе для сравнения ускорителей искусственного интеллекта/машинного обучения разных производителей.

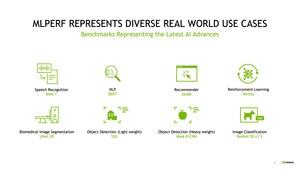

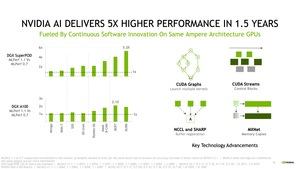

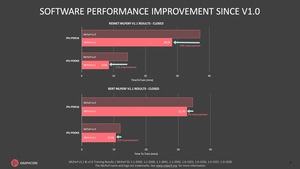

Вчера были опубликованы результаты MLPerf Training v1.1 – бенчмарка тренировки сетей глубокого обучения. Несколько недель назад были представлены обновленные данные бенчмарков HPC и инференса. В принципе, идею создания максимально независимых бенчмарков для тестов специализированных ускорителей можно только приветствовать. И на это вряд ли влияет тот факт, что производители вносят свои результаты самостоятельно, поскольку конкуренты могут выполнить аудит. Но, как нам кажется, в спецификациях MLCommons следует запретить выполнять дополнительные оптимизации, поскольку прямое сравнение становится проблематичным.

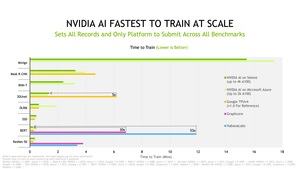

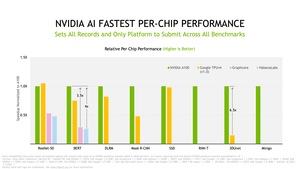

В частности, критику вызывают новые значения MLPerf Training v1.1. Если раньше результатов разных систем было больше, а совместимость шире, то сегодня мы наблюдаем обратную тенденцию. Сегодня основную роль по внесению данных тренировки играют NVIDIA, Graphcore и Habana Labs (Intel), но NVIDIA все равно вносит максимум. Google вносила данные для версии 1.0, но теперь отказалась от дальнейшего участия (по крайней мере, в разделе Open Section). И неизвестно, вернется ли поисковый гигант. По крайней мере, Azure и HPE решили впервые внести свои данные.

С доминированием NVIDIA и уменьшением базы вносимых данных сравнивать разные ускорители становится намного сложнее. В любом случае, результаты следует рассматривать в деталях, поскольку каждый производитель интерпретирует их по-разному. Например, NVIDIA любит сравнивать результаты "Closed Section" (детерминированные сценарии обработки данных) и "Open Section" (производитель может вносить оптимизации), хотя прямое сравнение здесь неуместно.

Результаты MLPerf Training v1.1 уже доступны.

Подписывайтесь на группы Hardwareluxx ВКонтакте и Facebook, а также на наш канал в Telegram (@hardwareluxxrussia).

Некоторые комментарии

Хотелось бы прокомментировать результаты. 19 результатов были внесены Microsoft Azure, NVIDIA предоставила 20 результатов. Dell внесла 12, Inspur – 7, Lenovo – 3, Baudi, Fujitsu, HPE и Supermicro по 2. Все они использовали GPU-ускорители NVIDIA A100.

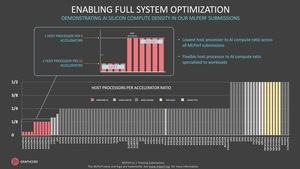

Habana Labs внесла шесть результатов на ускорителях Gaudi, а Graphcore – семь на Graphcore IPU GC200. В итоге 13 результатов сравниваются с 69, которые были получены на GPU-ускорителях A100 от NVIDIA. Конечно, это демонстрирует доминирование NVIDIA в данном сегменте. Но все же хотелось бы получить более сбалансированные наборы данных.

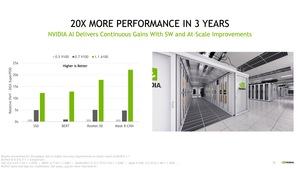

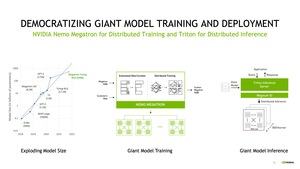

NVIDIA вносит результаты своего суперкомпьютера Selene, который состоит из 1.080 AMD EPYC 7742 и 4.320 A100 Tensor GPU. Microsoft использует 512 EPYC 7V12 и 2.048 A100 Tensor GPU. Для обеих систем верно следующее: из-за высокой вычислительной производительности и масштабирования, некоторые модели можно тренировать с рекордной скоростью. И когда в приоритете время тренировки до перехода к следующей модели, то NVIDIA оказывается в лидерах. Цена подобных систем – уже другой вопрос. NVIDIA Megatron-Turing NLG (Natural Language Generation) имеет 530 млрд. параметров, на проход тренировки уходят несколько недель. И для сокращения этого времени вычислительные системы как раз делают все крупнее и крупнее.

Суперкомпьютер Selene от NVIDIA содержит 540 DGX A100, каждый стоит порядка $300 тысяч. Поэтому серверы обойдутся в $160 млн. без учета инфраструктуры подобной системы.

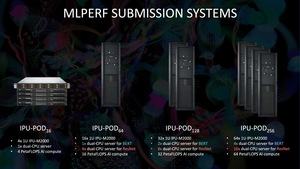

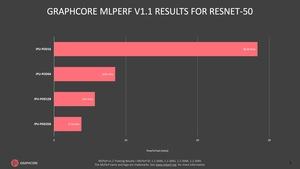

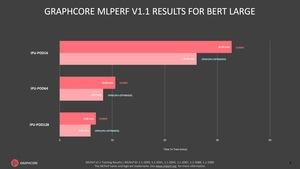

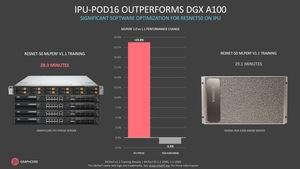

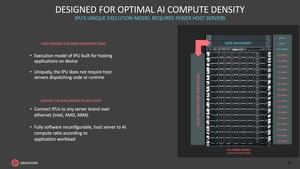

Производители, подобные Graphcore, выпускают альтернативные решения. И стоят они примерно в два раза дешевле. IPU Pad с 16 ускорителями стоит порядка $150 тысяч. Конечно, на рекордную производительность рассчитывать не стоит, но благодаря оптимизациям можно получить вполне достойные результаты.

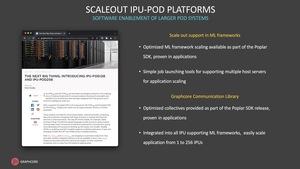

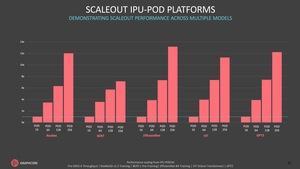

В новой версии тестов Graphcore представила результаты для 128 и 256 IPU Pods, ранее они приводились только для 64 IPU Pods. Так что Graphcore серьезно подходит к масштабированию своих систем, что позволяет получить сравнительно хорошие результаты. Причем сама Graphcore интерпретирует результаты как свою явную победу по соотношению цена/производительность. NVIDIA парирует тем, что "время тренировки", то есть время подготовки сети глубокого обучения, сказывается на затратах более существенно.

В итоге все сводится к тому, насколько приведенные результаты соответствуют практическому опыту. Станут ли компании и институты, которые планируют закупить подобные системы, руководствоваться приведенными бенчмарками? В принципе, тесты MLCommons можно рассматривать как независимую основу для сравнения. Но для этого ассортимент аппаратных конфигураций должен быть шире.

Посмотрим, как будет развиваться ситуация в будущем. Сохранят ли бенчмарки MLCommons свою актуальность?