MLCommons опубликовала свежие результаты производительности тренировки сетей глубокого обучения. Тесты MLPerf Training v2.0 призваны стать базой для сравнения подобных систем. В тестах участвуют такие компании, как Dell, HPE, Google, Inspur, Intel, Lenovo, NVIDIA, Gigabyte, Supermicro, Graphcore и многие другие, но при этом требуется соблюдать требования, также есть возможность оценить результаты конкурентов. В данном отношении тесты полностью прозрачные.

MLCommons опубликовала свежие результаты производительности тренировки сетей глубокого обучения. Тесты MLPerf Training v2.0 призваны стать базой для сравнения подобных систем. В тестах участвуют такие компании, как Dell, HPE, Google, Inspur, Intel, Lenovo, NVIDIA, Gigabyte, Supermicro, Graphcore и многие другие, но при этом требуется соблюдать требования, также есть возможность оценить результаты конкурентов. В данном отношении тесты полностью прозрачные.

Однако MLCommons пока не смогла расширить список участвующих компаний в тестах MLPerf по тренировке, инференсу, HPC, пограничным вычислениям и т.д. Например, в результатах отсутствует крупный производитель AMD, хотя AMD в данном сегменте является весьма сильным конкурентом. Конечно, все больше производителей отсылают свои результаты тестов тренировки, но все же не помешало еще большее разнообразие участников и баланс между разными тестами.

Но перейдем к результатам:

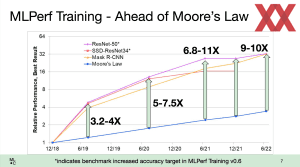

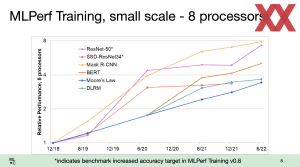

Один из трендов последних итераций тестов кроется в укрупнении систем. Для тренировки сетей глубокого обучения и искусственного интеллекта используются сотни процессоров и тысячи GPU-ускорителей. В частности, Google, Microsoft и NVIDIA проводят тесты на все более крупных системах. Соответственно, наблюдается экстремальный рост производительности таких систем, здесь можно говорить о четырехкратном увеличении за последние четыре года.

Но производительность растет быстрее предсказаний закона Мура не только по причине увеличения кластеров и числа CPU/GPU. Очень важную роль играет оптимизация программного обеспечения, она обеспечивает прирост производительности вплоть до двухзначного числа процентов, если не больше.

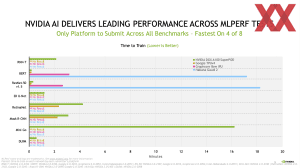

NVIDIA остается крупнейшим игроком в тестах MLPerf. Компания предоставляет больше всего результатов с масштабированием от небольших систем до суперкомпьютеров с более чем 4.000 ускорителями A100. Однако до сих пор нет результатов Hopper или H100.

NVIDIA не просто предоставляет больше всего результатов, но и дает стабильно высокую производительность и результаты для всех тестов. Однако доминирования уже нет, поскольку компания уже не на первом месте в четырех тестах из восьми. Google с новыми инстанциями TPUv4 смогла заметно потеснить NVIDIA. Но NVIDIA по-прежнему остается лидером в закрытой группе тестов, где все параметры предопределены.

Кроме Google, новые аппаратные компоненты, а именно BOW IPU, представила Graphcore. Ускоритель был анонсирован в марте, он базируется на прежней аппаратной базе, но работает с частотами до 40% выше, поэтому и быстрее TSMC WoW.

Тесты MLPerf подтверждают результаты, показанные в марте. BOW IPU POD действительно быстрее предшественников в диапазоне до 30% и даже чуть выше, но здесь следует учитывать оптимизацию программного обеспечения, поскольку она влияет на результаты новых систем в последних тестах.

Graphcore заявляет, что поставляет более производительные системы, чем NVIDIA DGX-A100, по такой же цене. Что видно и по результатам тестов, но многие компании не фокусируются на TCO при покупке новых систем, им важнее время расчетов. Системы NVIDIA можно сильнее масштабировать, поэтому они могут дать более высокую производительность через масштабирование. Впрочем, подобный анализ зависит от стратегий каждой компании, которые сами решают, что им важнее.

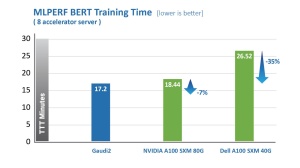

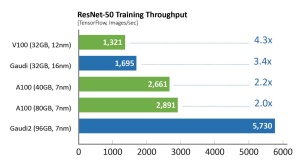

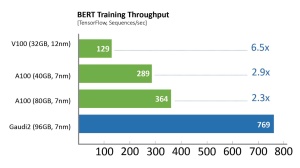

Помимо Graphcore и Google, HabanaLabs (теперь Intel) тоже внесла свои результаты на новых аппаратных компонентах, а именно на втором поколении чипа Gaudi. Однако использовалась система лишь с двумя процессорами и восемью ускорителями Gaudi 2. Спрогнозировать производительность систем на 64 или 128 ускорителей Gaudi 2 нелегко, масштабирование с таким количеством чипов не идеальное, поэтому сложно оценить, как здесь скажутся новые чипы.

Но с восемью ускорителями Gaudi 2 система показывает себя удивительно хорошо по сравнению с NVIDIA A100. Здесь важно как время тренировки сети глубокого обучения, так и пропускная способность. Диаграммы выше построены на значениях тестов MLPerf.

В закрытой категории тест MosaicML показывает, что оптимизация компиляторов и API под определенное приложение значит весьма немало. В некоторых случаях подобная оптимизация может привести к кратному приросту производительности с прежними аппаратными компонентами. Graphcore видит здесь один из аргументов того, что следует оценивать не только аппаратное обеспечение, но сценарий в целом. Поэтому Graphcore и Aleph Alpha работают над предварительной подготовкой данных для тренировки и другими оптимизациями.

Все заинтересованные читатели могут ознакомиться с результатами тестов тренировки на MLCommons.com.

Подписывайтесь на группу Hardwareluxx ВКонтакте и на наш канал в Telegram (@hardwareluxxrussia).