Появились новые результаты независимого серверного бенчмарка MLPerf Inference 2.1. Данный тест позволяет оценивать серверные системы в разных областях применения. Конечно, крупные компании проводят собственные тесты, но все же для внешних презентаций они смотрятся не так хорошо, как независимые бенчмарки.

Появились новые результаты независимого серверного бенчмарка MLPerf Inference 2.1. Данный тест позволяет оценивать серверные системы в разных областях применения. Конечно, крупные компании проводят собственные тесты, но все же для внешних презентаций они смотрятся не так хорошо, как независимые бенчмарки.

Для тестирования инференса в бенчмарке MLPerf Inference 2.1 были пересмотрены различные сценарии дата-центров и периферийных (edge) вычислений. Суть в том, чтобы тестируемые сценарии были максимально приближены к практике. Действительно, без ряда сценариев уже сложно представить повседневную жизнь. Например, когда вы обращаетесь к голосовому помощнику или приложению с просьбой распознать отрывок музыкальной композиции. Здесь выполняется распознавание речи в текст, анализ текста, распознавание и анализ музыки, поиск в базе данных соответствующей мелодии и, наконец, рекомендация музыки и возможное голосовое сообщение помощника. В подобный вроде бы простой сценарии вовлечены многочисленные шаги, которые выполняются на системах искусственного интеллекта в дата-центрах.

Но перейдем к результатам. Как обычно в случае MLCommons они доступны в виде таблицы. NVIDIA поработала над графическим представлением части результатов, что позволяет лучше их оценить благодаря наглядности.

До сих пор NVIDIA подчеркивала свою ведущую роль с ускорителями A100. Но всегда есть так называемые пограничные случаи, в которых результаты сравнимы с конкурентами. С другой стороны, масштабирование нескольких тысяч ускорителей в системе позволило NVIDIA демонстрировать рекордную производительностью. Эффективность особой роли здесь не играет, главное – уменьшение времени расчетов, чтобы как можно быстрее получать результаты и переходить к новым вычислениям.

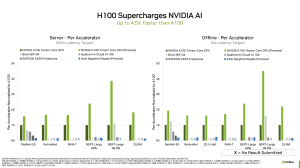

В нынешней серии бенчмарков NVIDIA впервые добавила результаты новых ускорителей H100 на архитектуре Hopper. По сравнению с A100, они быстрее в 1,5-4,5 раза. Так что в данном случае мы видим преимущества нового «железа», в предыдущие итерации бенчмарка прирост был связан с более эффективной подготовкой данных или оптимизацией программного обеспечения.

Также появились результаты китайского стартапа Biren, который недавно в рамках конференции Hotchips представил свой ускоритель BR104. Напомним, что BR104 представляет собой PCIe-ускоритель с TDP 300 Вт. И весьма интересно сравнить его производительность с ускорителями NVIDIA A100 и H100, которые потребляют 500 Вт и больше. Biren дает вполне убедительные результаты ResNet-50 и BERT-Large 99.9%. Ускорители на китайском рынке специализируются на распознавании изображений и текста, поэтому причина понятна.

Южнокорейский телекоммуникационный гигант sk.telekom тоже добавил результаты своих ускорителей SAPEON, а именно X220. Они представляют собой карты PCIe с низким энергопотреблением 75 Вт, поэтому результаты сравнительно хороши. Конечно, тесты были проведены лишь в некоторых сценариях, на которые сфокусирована разработка компании.

Intel представила предварительные результаты Sapphire Rapids. Будут ли ускорители Ponte Vecchio протестированы в MLPerf – неизвестно. Пока что результатов нет.

Приятно, что в результатах появились новые компании и ускорители, но NVIDIA продолжает доминировать. Поэтому некоторые результаты довольно однообразны. В любом случае, рынок не стоит на месте, появляются новые игроки, которые хорошо показывают себя в ряде сценариев.

Помимо маркетингового потенциала, у NVIDIA есть возможность покрывать почти все сценарии инференса. От экономичных пограничных систем до кластеров дата-центров. Благодаря разделению на виртуальные инстанции (MIG) мощные GPU-ускорители могут выполнять несколько приложений одновременно, причем не зависящих друг от друга. NVIDIA широко позиционирует свои решения и готова предложить их практически для любого сценария. Небольшие производители, с другой стороны, концентрируются на определенных сферах.

В итоге результаты бенчмарков MLPerf Inference 2.1 позволяют оценить производительность разных систем. Хорошо видна оптимизация решений, поэтому сравнивать их производительность на какой-то общей базе нелегко.

Подписывайтесь на группу Hardwareluxx ВКонтакте и на наш канал в Telegram (@hardwareluxxrussia).