ML Commons представила новые результаты тестов MLPerf Training. С переходом на версию 3.0 были добавлены новые тесты LLM. Тесты Tiny, которые важны для сегмента пограничных вычислений (Edge) и экономичного инференса, были обновлены.

ML Commons представила новые результаты тестов MLPerf Training. С переходом на версию 3.0 были добавлены новые тесты LLM. Тесты Tiny, которые важны для сегмента пограничных вычислений (Edge) и экономичного инференса, были обновлены.

Результаты тестов доступны для оценки напрямую на ML Commons (MLPerf Training 3.0 и MLPerf Tiny 1.1).

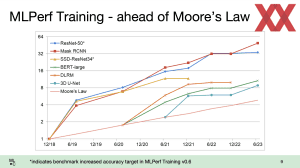

Но нам больше интересны подробности, которые можно извлечь из результатов тестов и системной информации. Например, ML Commons показывает прирост производительности в отдельных тестах, что позволяет сделать выводы о хорошей масштабируемости на системах разных производителей, причем рост получился даже быстрее закона Мура. С другой стороны, есть сравнительно плоские кривые результатов, где рост уже не такой заметный.

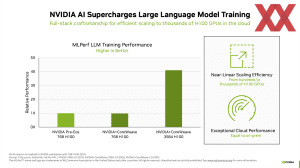

Интересны новые результаты тренировки, которые включают новые тесты LLM (большой языковой модели). В том числе массив C4 от HuggingFace объемом 305 Гбайт, содержащий около 174 млрд. жетонов. Но в тесте тренировалась не вся сеть, а только лишь часть. Причем системе, содержащей 3.584 ускорителей NVIDIA H100, потребовалось одиннадцать минут. Если исходить из объема 0,4% от полной сети GPT-3, система с 3.584 ускорителями NVIDIA H100 справится с тренировкой полной сети за 2.750 часов или 115 дней. Что позволяет представить затраты, которые компании, подобные OpenAI, несут при тренировке сетей LLM. А GPT-4 будет еще более сложной.

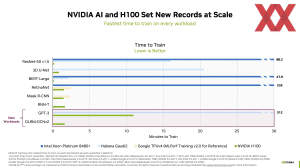

Именно этот параметр NVIDIA и подчеркивает: время тренировки. На тренировку уходят несколько недель или даже месяцев, а исследователи хотят получить готовую сеть как можно быстрее. Чем быстрее будет выполняться тренировка, тем быстрее можно вносить оптимизации и дополнительно тренировать сеть.

Конечно, с использованием от нескольких сотен до 4.096 ускорителей H100 NVIDIA дает существенное преимущество хотя бы по масштабированию, даже если не учитывать производительность отдельных ускорителей. Отметим, что здесь NVIDIA работает вместе с CoreWeave, и последние результаты ML Commons были получены с их помощью.

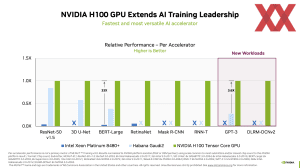

Intel тоже показывает определенный прогресс с ускорителями Gaudi 2. Однако результаты, которые до сих пор вносила Intel, базировались, максимум, на восьми Gaudi 2. К счастью, теперь появились результаты на 384 ускорителях, и масштабирование получается весьма хорошим.

Подписывайтесь на группу Hardwareluxx ВКонтакте и на наш канал в Telegram (@hardwareluxxrussia).