Несколько недель назад компания MosaicML привлекла внимание тем, что выпустила натренированную модель MPT-7B в виде открытого исходного кода, чтобы ускорить исследования больших языковых моделей LLM. MosaicML специализируется на оптимизации экосистем под искусственный интеллект, поскольку оптимизация софта может дать существенный выигрыш по времени тренировки, здесь называются цифры порядка 30%. Поэтому путем привлечения внимания к MPT-7B компания MosaicML рекламирует и свои услуги.

Несколько недель назад компания MosaicML привлекла внимание тем, что выпустила натренированную модель MPT-7B в виде открытого исходного кода, чтобы ускорить исследования больших языковых моделей LLM. MosaicML специализируется на оптимизации экосистем под искусственный интеллект, поскольку оптимизация софта может дать существенный выигрыш по времени тренировки, здесь называются цифры порядка 30%. Поэтому путем привлечения внимания к MPT-7B компания MosaicML рекламирует и свои услуги.

Выход PyTorch 2.0 и ROCm 5.4 позволил сравнить разные варианты аппаратных компонентов и программного стека от AMD и NVIDIA. Пока что от хайпа ИИ очень сильно выигрывает NVIDIA – у компании есть хорошие и быстрые ускорители, а также программная экосистема, которая строилась годами.

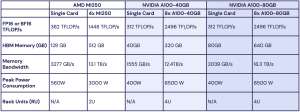

PyTorch 2.0 и ROCm 5.4 позволяют запустить тренировку на ускорителях Instinct от AMD без единой правки кода. Тренировка модели MPT-1B LLM выполнялась на четырех ускорителях Instinct MI250, на восьми A100 с 40 и 80 Гбайт каждый. Никаких «вылетов» или проблем со стабильностью не было. Результаты тестов были нормализованы для одного GPU.

Похоже, AMD почти сравнялась с конкурентом по производительности, поскольку системы на ускорителях Instinct MI250 показали около 80% производительности по сравнению с системами с таким же количеством A100 с 40 Гбайт памяти и около 73%, если сравнивать с A100 c 80 Гбайт.

Можно заметить отличия по дизайну аппаратных компонентов. Если ускоритель MI250 обеспечивает внутреннюю пропускную способность 3,3 Тбайт/с при емкости 128 Гбайт, то у A100 она составляет всего 2 Тбайт/с при емкости HBM всего 40 или 80 Гбайт. Но если учитывать уже восемь ускорителей в вычислительном узле NVIDIA, то суммарная емкость памяти будет выше (80 Гбайт на один A100), суммарная пропускная способность памяти тоже. По эффективности обе системы почти не отличаются.

У NVIDIA есть другое преимущество: компания доказала, что GPU-ускорители хорошо масштабируются и работают совместно тысячами штук. В случае AMD GPU это еще предстоит доказать. MosaicML сравнивает производительность на широко распространенных ускорителях, хотя уже вышли преемники Было бы интересно взглянуть на дуэль AMD Instinct MI300X и NVIDIA H100. NVIDIA уже отгружает ускорители H100 тысячами, но пройдет еще несколько месяцев, прежде чем будут доступны варианты MI300.

Но ускорители MI300X должны вновь выиграть по емкости памяти (192 против 80 Гбайт HBM3), а также по пропускной способности (5,2 против 3,3 Тбайт/с). Но, опять же, NVIDIA уже показала пример совместной работы тысяч ускорителей H100. А для AMD такого пока нет.

Подписывайтесь на группу Hardwareluxx ВКонтакте и на наш канал в Telegram (@hardwareluxxrussia).