Сегодня была представлена LLM Llama 2, прошедшая тренировку, что упростит доступ небольшим разработчикам и компаниям к подобным моделям. Все же на тренировку подобных моделей уходят многие миллионы долларов США, в зависимости от размера. Причем иногда счет идет на сотни миллионов.

Сегодня была представлена LLM Llama 2, прошедшая тренировку, что упростит доступ небольшим разработчикам и компаниям к подобным моделям. Все же на тренировку подобных моделей уходят многие миллионы долларов США, в зависимости от размера. Причем иногда счет идет на сотни миллионов.

Пока в выигрыше NVIDIA, ускорители H100 разлетаются, как горячие пирожки: они уходят и гиперскейларам, и небольшим компаниям, работающим с LLM. Системы на предшествующем поколении A100 тоже вполне эффективны, здесь NVIDIA довольно хорошо подготовила почву для нынешнего доминирования.

Современные ускорители H100 считаются лучшим решением, но будущие LLM станут еще сложнее, для тренировки потребуется намного большая вычислительная мощность. Причем речь идет не только о тренировке моделей, но и запросах в подобные сети (инференсе) – например, голосовая модель помощника чата. Google и Microsoft планируют добавить подобные модели в свой поиск, при этом расходы они понесут весьма существенные. Наши коллеги SemiAnalysis посчитали, что стандартный запрос Google обходится в $0,0106. Если же Google добавит Chat GPT, то запрос подорожает до $0,0142. Каждый день Google обрабатывает несколько миллиардов запросов, поэтому дополнительные издержки весьма существенны. Чтобы Google смогла обслуживать все голосовые запросы через Chat GPT, потребуется порядка 500.000 ускорителей A100, которые сами по себе стоят денег, но также потребуют операционных затрат из-за потребляемого электричества и места в дата-центре. Другие источники говорят уже о двух миллионах ускорителей. В любом случае, затраты будут миллиардными.

Чтобы уменьшить затраты, потребуются специализированные ускорители для тренировки LLM, подобно многим другим сферам. Они как раз описываются в исследовании (PDF), над которым работали Вашингтонский и Сиднейский университеты.

В документе описан теоретический дизайн на основе чиплетов для специализированных ускорителей, которые содержат множество блоков умножения-сложения MAC и буферов накопления помимо SRAM (в качестве буфера и локальной памяти). В одной корпусировке расположены множество чиплетов, в одном вычислительном узле – несколько подобных ускорителей, в одной стойке – несколько узлов. Кристаллы соединены интерконнектом chip-2-chip для быстрого обмена данными, что для LLM очень важно.

DRAM или HBM не используется, поскольку они слишком медленные или дорогие. SRAM проще производить и интегрировать, хотя память занимает весьма значительную площадь в расчете на мегабайт. Однако высокая пропускная способность все компенсирует.

Исследовали посчитали, насколько меньшими будут задержки и затраты на каждый запрос для моделей GPT-3 и PaLM 540B. Два этих параметра принципиально важны для LLM. Сравнивалась система из 32 так называемых облачных серверов на чиплетах, 32 системы DGX на ускорителях A100 и 64 ускорителя TPUv4 от Google:

| Модель | GPT-3 | GPT-3 | PaLM 540B | PaLM 540B |

| | 32 Chiplet Cloud Server | 32 DGX A100 | 30 Chiplet Cloud Server | 64 TPUv4 |

| Задержка | 1,9 мс | 620 мс | 4,8 мс | 93,8 мс |

| Токены/с | 33.791 | 4.608 | 26.667 | 5.461 |

| TCO/1K токенов * | 0,018 c | 1,698 c | 0,031 c | 0,478 c |

* для анализа TCO использовались центы доллара США

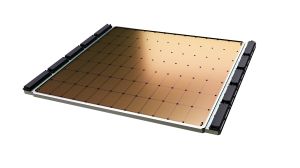

В принципе, аппаратное обеспечение, которое рекомендуют исследователи, довольно близко к Cerebras и Wafer Scale Engine – или Tesla с чипом D1. Здесь все вычислительные блоки расположены на подложке и соединены напрямую. В зависимости от задачи, подобные сложные системы работают быстрее массива раздельных чипов.

Но у концепции есть недостаток: она адаптирована только под определенные модели LLM, в данном случае трансформер. Если придется менять архитектуру LLM, то и аппаратное обеспечение придется использовать другое. Исследователи оценивают срок службы суперкомпьютера LLM в 18 месяцев, что очень немного. Поэтому он должен окупить затраты за очень короткое время.

Сегодня разработчики фокусируются на ускорителях с максимальной вычислительной производительностью арифметических блоков, но также и на максимальных объемах памяти с самым быстрым подключением. NVIDIA здесь по-прежнему в лидерах, но и AMD потихоньку догоняет – тем более скоро выходят ускорители Instinct MI300A и Instinct MI300X.

Подписывайтесь на группу Hardwareluxx ВКонтакте и на наш канал в Telegram (@hardwareluxxrussia).