На пленарном докладе Google I/O 2016 горячими темами стали облачная платформа Android N, а также Android Wear 2.0 или Daydream. Но на презентации прозвучало еще кое-что интересное. Недавняя победа AlphaGo над человеческими противниками тоже добавила амбиций Google по поводу машинного обучения.

На пленарном докладе Google I/O 2016 горячими темами стали облачная платформа Android N, а также Android Wear 2.0 или Daydream. Но на презентации прозвучало еще кое-что интересное. Недавняя победа AlphaGo над человеческими противниками тоже добавила амбиций Google по поводу машинного обучения.

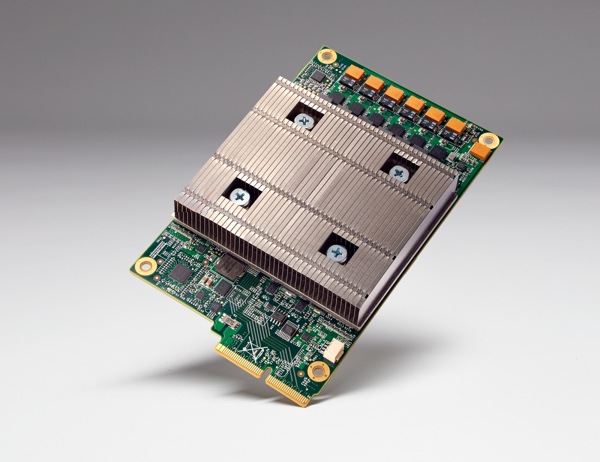

Вчера Google публично рассказала о разработке Tensor Processing Unit (TPU), ранее остававшейся секретом. Перед нами специализированная ASIC (Application Specific Integrated Circuit), разработанная для машинного обучения под названием TensorFlow. Над ранее секретным проектом Google работала уже несколько лет, само аппаратное обеспечение уже больше года работает в дата-центрах компании. Вычислительная производительность или эффективность (соотношение вычислительной производительности и энергопотребления) на порядки выше, чем при использовании любого другого аппаратного обеспечения. Судя по объявленной информации, Google смогла обойти других разработчиков «железа» на семь лет. Другими словами, на три поколения закона Мура.

TPU специально ориентирован на тренировку и работу сетей глубокого обучения (Deep Learning). Здесь требуется намного меньшая точность, чем в обычных вычислительных системах. Достаточно точности FP16, с учетом этого и разрабатывались TPU от Google. Плата с Tensor Processing Unit по размеру не превышает 2,5-дюймовый SSD.

Если верить Google, TPU является отличным примером того, насколько быстро можно разработать подобное аппаратное обеспечение. От симуляции первых чипов, тестирования, получения первых кристаллов до применения в дата-центрах прошло всего 22 месяца. Google нацеливает TPU на различные сферы использования. В том числе RankBrain, то есть сеть, которая оценивает результаты Google Street View и Navigation. Конечно, называются сети глубокого обучения, в том числе и AlphaGo тренировалась на данных TPU.

Аппаратное и программное обеспечение подобных сетей глубокого обучения (или машинного обучения) становится все более актуальным. В будущем значимость еще сильнее возрастет. Это понимает и NVIDIA, которая уже несколько лет работает в данном направлении, на GPU Technology Conference 2015 была объявлена разработка соответствующего аппаратного обеспечения. В этом году представлены вычислительные ускорители Tesla P100, тоже весьма мощное «железо» для сетей Deep Leaning. GPU GP100 базируются на архитектуре Pascal, как и чипы для видеокарт GeForce 1080 GTX и GTX 1070 они изготавливаются по 16-нм техпроцессу. 15,3 млрд. транзисторов и память HBM2 подняли вычислительную производительность на новый уровень. Но NVIDIA нацеливает свое аппаратное обеспечение и архитектуру не только на сети глубокого обучения, что отличает их от специализированных TPU Google.