Вчера вечером Intel представила четвертое поколение Xeon с кодовым названием Sapphire Rapids. Анонс был еще в мае 2019, процессоры планировалось выпустить в 2021, но из-за задержек пришлось отложить до 2023. Причем сегодня доступны не все модели, они будут постепенно выходить на рынок в ближайшие недели и месяцы. Основой стали ядра Golden Cove, которые производятся по техпроцессу Intel 7 и содержат множество улучшений. В статье мы все их рассмотрим.

Вчера вечером Intel представила четвертое поколение Xeon с кодовым названием Sapphire Rapids. Анонс был еще в мае 2019, процессоры планировалось выпустить в 2021, но из-за задержек пришлось отложить до 2023. Причем сегодня доступны не все модели, они будут постепенно выходить на рынок в ближайшие недели и месяцы. Основой стали ядра Golden Cove, которые производятся по техпроцессу Intel 7 и содержат множество улучшений. В статье мы все их рассмотрим.

Sapphire Rapids нельзя назвать удачным примером анонса нового поколения CPU Intel. Процессор несколько раз откладывался, также были сообщения о низкой доле выхода годных кристаллов по техпроцессу Intel 7, что не улучшало имидж чипового гиганта. Вместе с тем AMD продолжила наращивать свое давление, выпуская технически превосходящие и инновационные CPU. Intel пришлось задействовать всю свою маркетинговую мощь, чтобы не потерять свои позиции, причем мы имеем в виду не только рыночную долю.

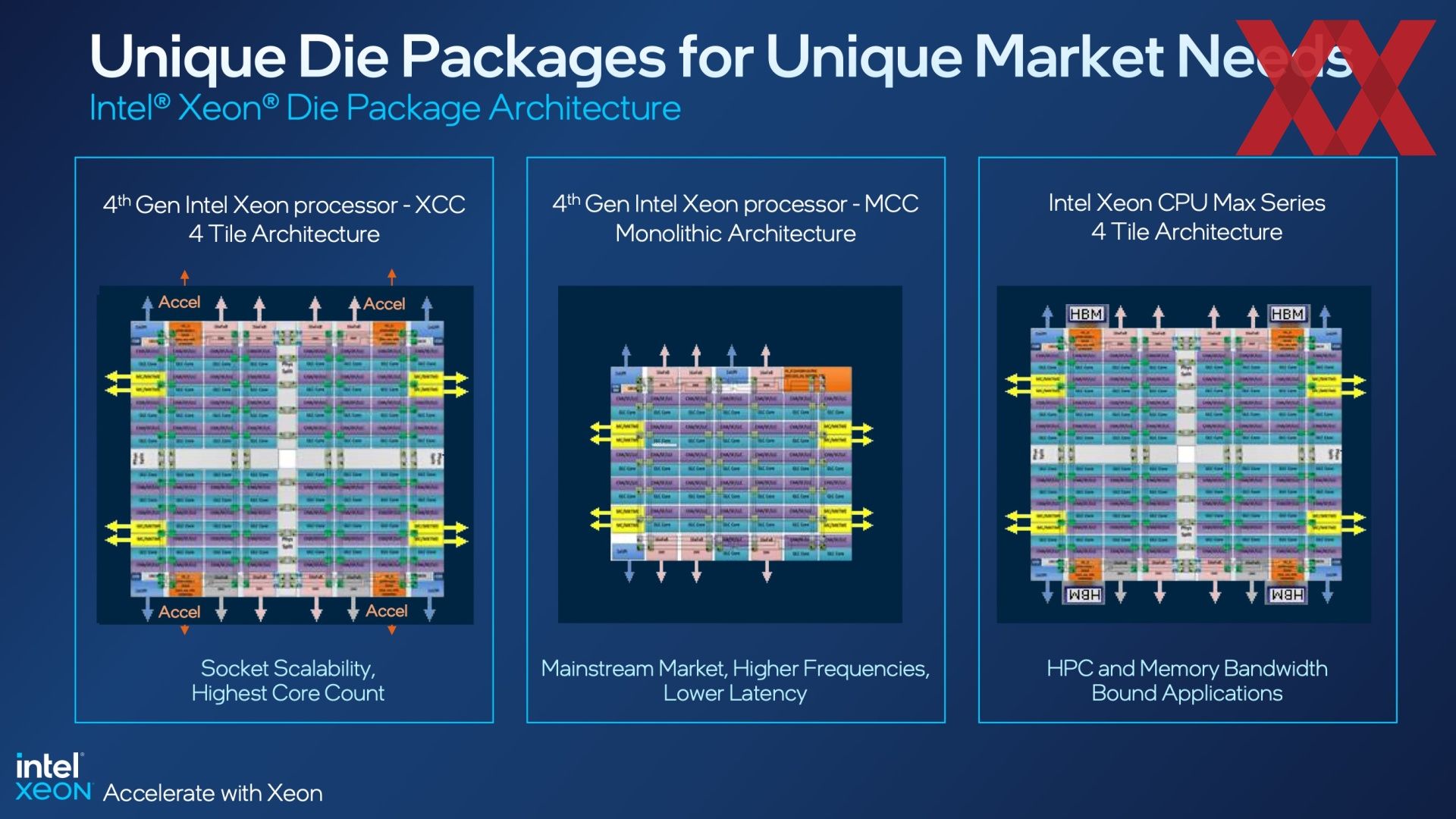

Четвертое поколение Xeon Scalable можно разделить на три группы продуктов: стандартные Xeon, содержащие до 56 ядер, мультисокетные варианты для систем до 8S и до 60 ядер на сокет, а также процессоры с памятью HBM2E.

Кроме до 60 ядер на сокет и специальных моделей с памятью HBM2E, поколение Sapphire Rapids также предлагает поддержку до 80 линий PCI Express 5.0 и восьми каналов памяти DDR5-4800 с одним модулем и DDR5-4400 с двумя модулями на канал. Также добавилось большое число разных ускорителей, которые располагаются в ядрах или на корпусировке.

Процессоры Sapphire Rapids поддерживают CXL 1.1. Процессор может работать с четырьмя устройствами CXL, но не всех типов. Intel указывает Type 1 (CXL.io и CXL.cache) для SmartNIC и Type 2 (CXL.io, CXL.cache и CXL.mem) для GPU, ASIC и FPGA.

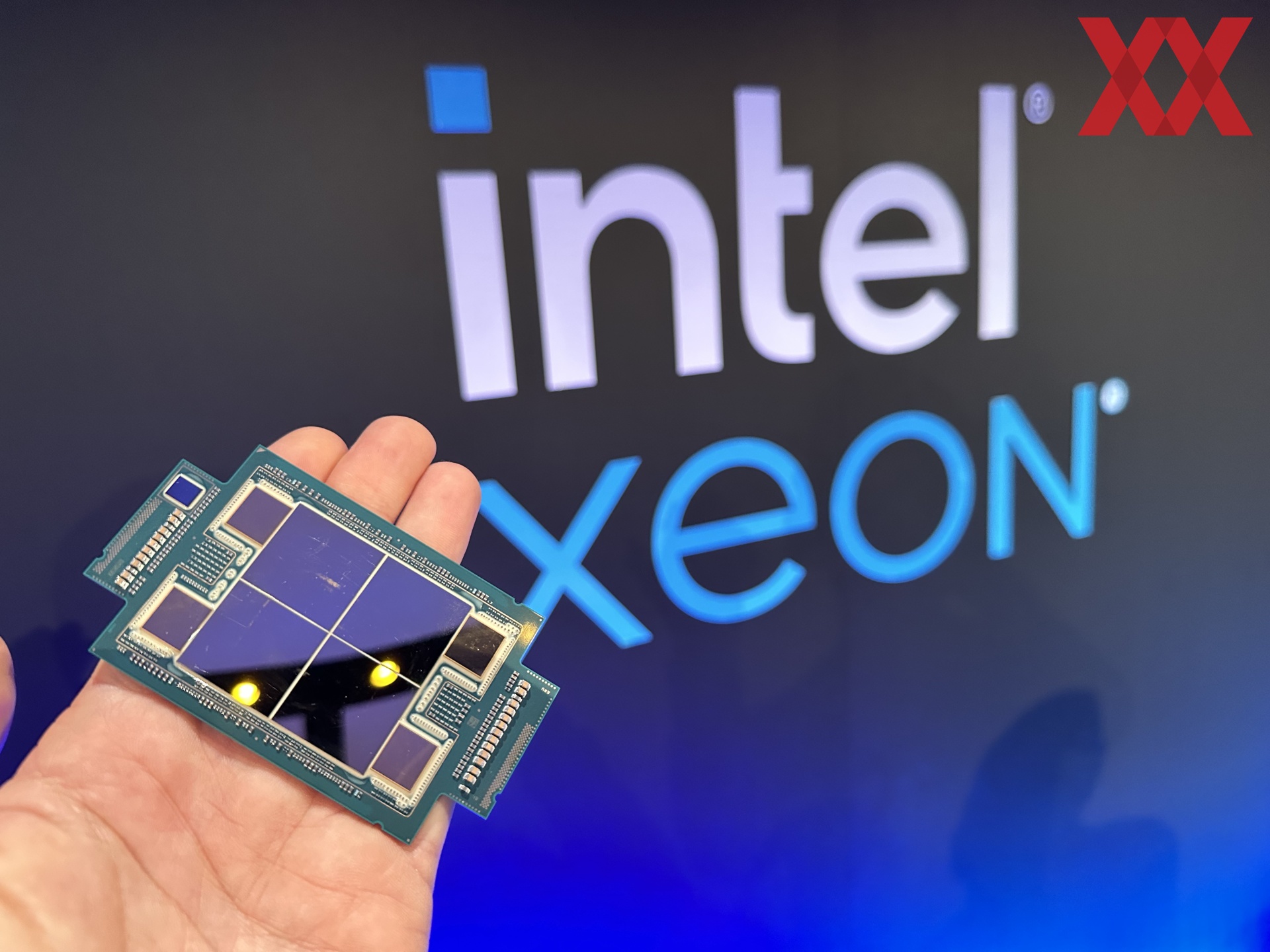

Sapphire Rapids: четыре кристалла (+ 4x HBM2E) в одной корпусировке

Кристаллы Sapphire Rapids производятся по техпроцессу Intel 7, то есть 10-нм технологии. Между тем Intel внесла множество улучшений в 10-нм техпроцесс, что позволило сделать его вполне конкурентоспособным по доле выхода годных кристаллов. Для маленьких настольных чипов это верно уже давно, но у крупных кристаллов (в данном случае около 400 мм²) доля выхода была всегда ниже.

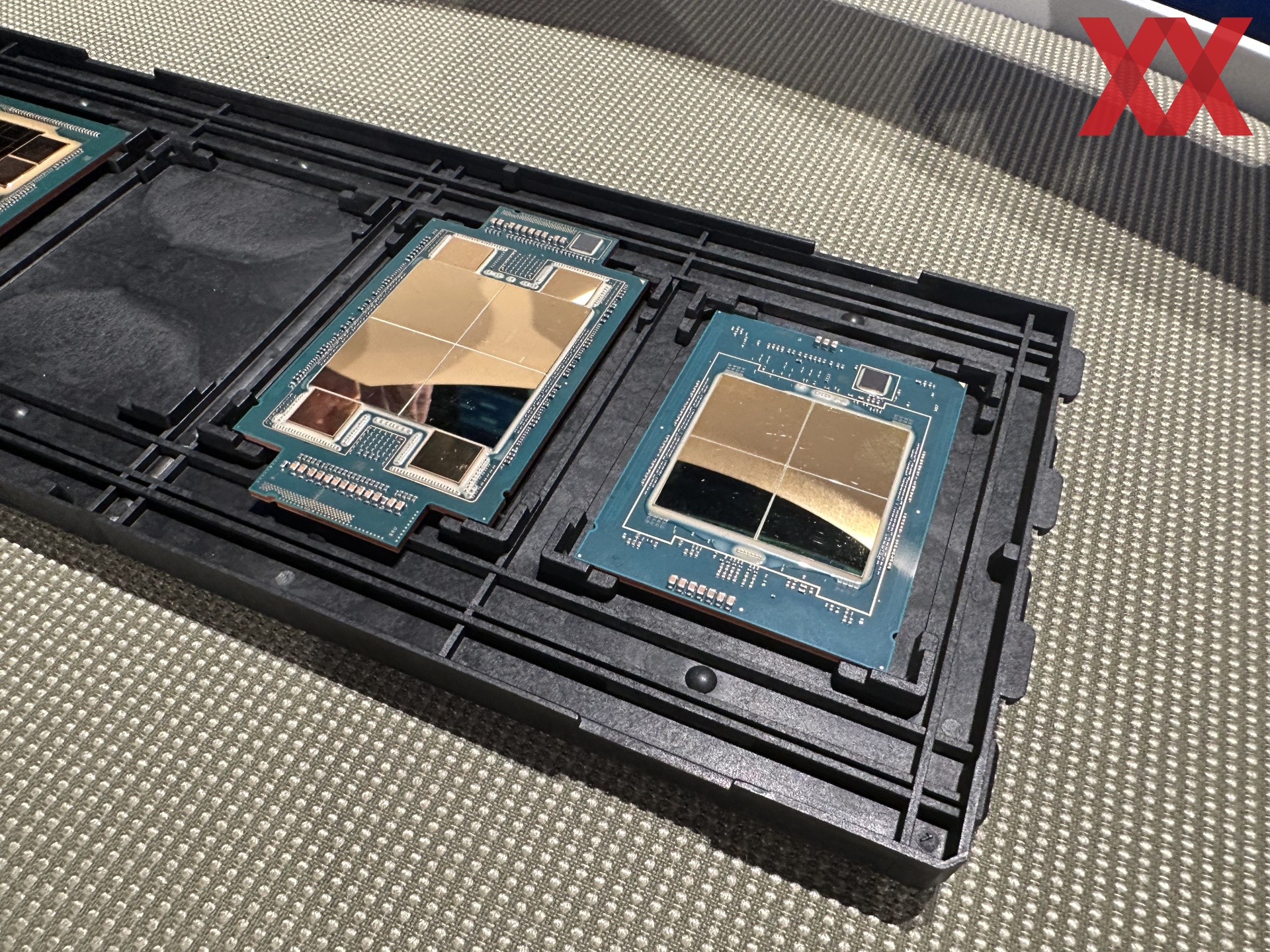

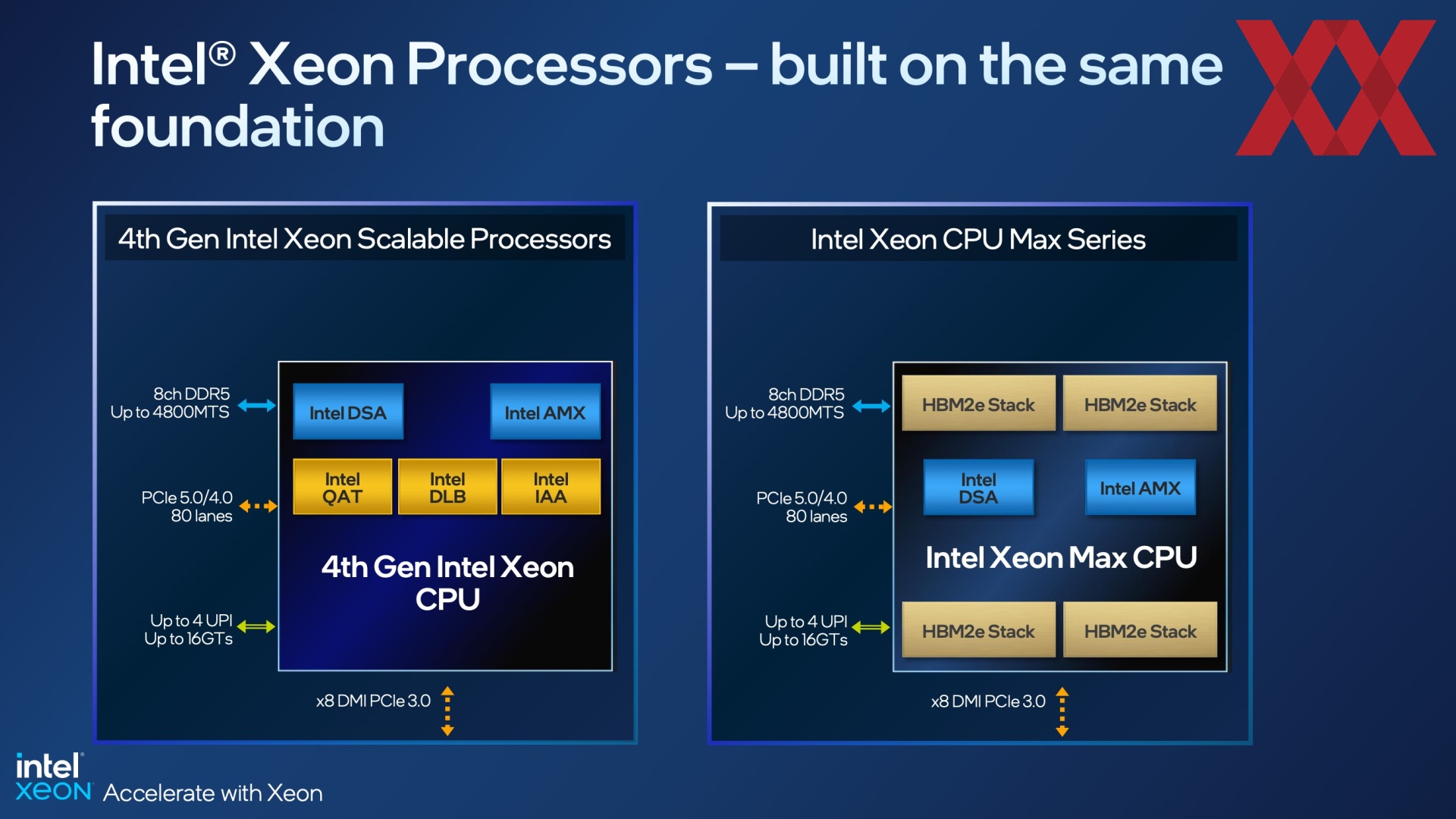

IIntel разделяет по категориям не чипы, а корпусировки, которые устанавливаются в сокет LGA4677. Корпусировка XCC (Extreme Core Count) содержит четыре тайла. Здесь Intel может предложить больше ядер, подсистема ввода/вывода тоже мощнее, процессоры хорошо подходят для многосокетных систем. Также есть корпусировка MCC (Medium Core Count). Здесь Intel использует один монолитный кристалл, что позволяет добиться более высоких тактовых частот и меньших задержек. Процессоры Xeon Max с памятью HBM2E базируются на корпусировке XCC и полностью совместимы с другими CPU по сокету.

На конвейере выпускаются четыре вида кристаллов, которые затем устанавливаются в разных корпусировках. Для варианта XCC Intel требуется два вида кристаллов, которые располагаются матрицей 2x2 в корпусировке. Четыре тайла соединяются между собой десятью мостами EMIB (Embedded Multi-die Interconnect Bridge). Поэтому соединение между тайлами асимметричное.

Если добавить четыре кристалла HBM, то получается 14 мостов EMIB, по одному дополнительному на стек HBM. При этом требуется уже другая раскладка кристалла, поэтому здесь используется третий вид кристалла Sapphire Rapids или XCC.

Четвертый вид кристалла – MCC, что связано и с числом ядер на нем, и с раскладкой.

| Ядра | UPIs | PCIe | Каналы памяти | Площадь кристалла | Мостики EMIB | |

| XCC Package | 60 | 4 | 5x 16 линий | 8x DDR5 | 4x 400 мм² | 10 |

| MCC Package | 32 | 3 | 5x 16 линий | 8x DDR5 | ? | Нет |

| XCC HBM Package | 56 | 4 | 5x 16 линий | 8x DDR5 + 4x HBM2e | 4x 400 мм² | 14 |

Корпусировка XCC предлагает до 60 ядер и до четырех каналов UPI для связи нескольких сокетов. В общей сложности доступны 80 линий PCI Express 5.0. В корпусировке MCC максимальное число ядер ограничено 32, но сам кристалл намного крупнее, чем отдельные тайлы в составе XCC. Здесь на корпусировке доступны три канала UPI и тоже 80 линий PCI Express 5.0. Ограничений по интерфейсу памяти тоже нет, восемь каналов память поддерживаются и в случае MCC.

Если верить Intel, энергопотребление MDFIO составляет 0,5 pJ/B. Интерконнект Fabric IO может адаптироваться к нагрузке через динамические частоты и Dynamic Voltage Frequency Scaling (DVFS), диапазон указан от 800 МГц до 2,5 ГГц. В результате суммарная пропускная способность интерконнекта составляет до 10 Тбайт/с (20 пересечений по 500 Гбайт/с каждое). Круговая задержка для MDFIO/EMIB составляет 10 нс.

Чтобы лучше различать два вида кристаллов XCC для стандартных процессоров Xeon Scalable четвертого поколения, чипов MCC и XCC HBM, мы добавили еще одну таблицу.

| Ядра | Структура | MCs | ACs | |

| XCC | 15 | 6x4 Mesh | 1 | 1x XCC AC |

| MCC | 32 | 9x7 Mesh | 4 | 1x MCC AC |

| XCC HBM | 56 | 6x4 Mesh | 1 + 1 | 1x XCC AC |

Ядра организованы в массиве 6x4 или 9x7. На кристалле XCC установлен только один контроллер памяти на два канала. В корпусировке с четырьмя тайлами получается восемь каналов DDR5. В случае же MCC Intel пришлось устанавливать четыре контроллера памяти, каждый на два канала. Также на каждом кристалле есть комплекс ускорителей Accelerator Complex (AC). XCC AC состоит из блоков QAT, DLB, DSA и IAA в количестве одной штуки. Их мы рассмотрим позднее. В случае MCC AC установлены по два блока QAT и DLB, по одному DSA и IAA.

Хотя кристаллы Sapphire Rapids сравнительно небольшие – 400 мм², Intel все же пошла на различные меры, чтобы компенсировать возможные дефекты, поскольку предыдущий опыт компании с 10-нм техпроцессом был не очень успешным. Причем задействуются не просто методы восстановления и обхода дефектов ключевых областей (производительных ядер), кэшей, блоков uncore и I/O.

На кристалле сделано довольно много резервных цепей и блоков, которые будут задействованы в случае дефекта. Для тех же MDFIO есть возможность восстановления отдельных контактов еще до сборки корпусировки.

Неиспользованные блоки PCIe в «южной» области чипа позволяют восстановить некоторые блоки I/O через переназначение. Если верить Intel, 74% площади чипа подлежит восстановлению в случае возникновения дефектов. Процессор, состоящий из четырех кристаллов, не так легко тестировать вне собранной корпусировки, чтобы проверить все функции и интерфейсы. Но Intel нашла способы проводить тесты напрямую с интерфейсами EMIB, например, а также используя контакты GPIO и JTAG.

Основа x86: ядра Golden Cove

Intel довольно широко использует ядра Golden Cove. Они являются основой производительных ядер Alder Lake, но с меньшим объемом кэша L2 и L3 на ядро. В случае Golden Cove был увеличен кэш микроопераций и пропускная способность (ширина - 6 Wide Allocation). Отметим улучшения в области предсказаний и более крупные TLB, что тоже сказывается на пропускной способности выполнения инструкций.

Фронтальная часть конвейера содержит 12 исполнительных портов. По сравнению с Sunny Cove здесь есть дополнительный целочисленный порт, который не ориентирован на какие-либо специальные задачи, в отличие от остальных портов, а предназначен для стандартных наборов инструкций. Векторные блоки поддерживают инструкции AVX 512 и ускоряют матричные вычисления через AMX в дополнение к вычислениям FP16. Но для AMX требуется программная поддержка, но при этом Intel обещает в идеальных условиях ускорение до восьми раз.

По сравнению с предшественником производительность IPC должна увеличиться на 15%. Также в набор AVX-512 добавлены новые инструкции, подобные vRAN, весьма интересные для мобильных и пограничных сценариев. Также отметим глубоко интегрированные функции безопасности, такие как CET, SGX и TDX.

До восьми процессоров в сервере

Процессоры EPYC ограничены, максимум, двумя CPU в системе 2S, Intel же продолжает предлагать с процессорами Sapphire Rapids поддержку 4S и 8S. Конечно, следует помнить, что AMD может предложить до 96 ядер на сокет с современным поколением Genoa, а Intel ограничена 60. А с Bergamo AMD предложит даже 128 ядер в ближайшем будущем. То есть даже по двум сокетам AMD все равно может дать 192 или 256 ядер, соответственно.

Intel для своих систем Sapphire Rapids на 4S и 8S указывает высокую плотность вычислений. Здесь поддерживается до 480 ядер и до 32 Тбайт памяти.

Также есть ориентированная на производительность топология 8S-4L, когда часть линий I/O убрана, зато процессоры обмениваются данными друг с другом как можно быстрее.

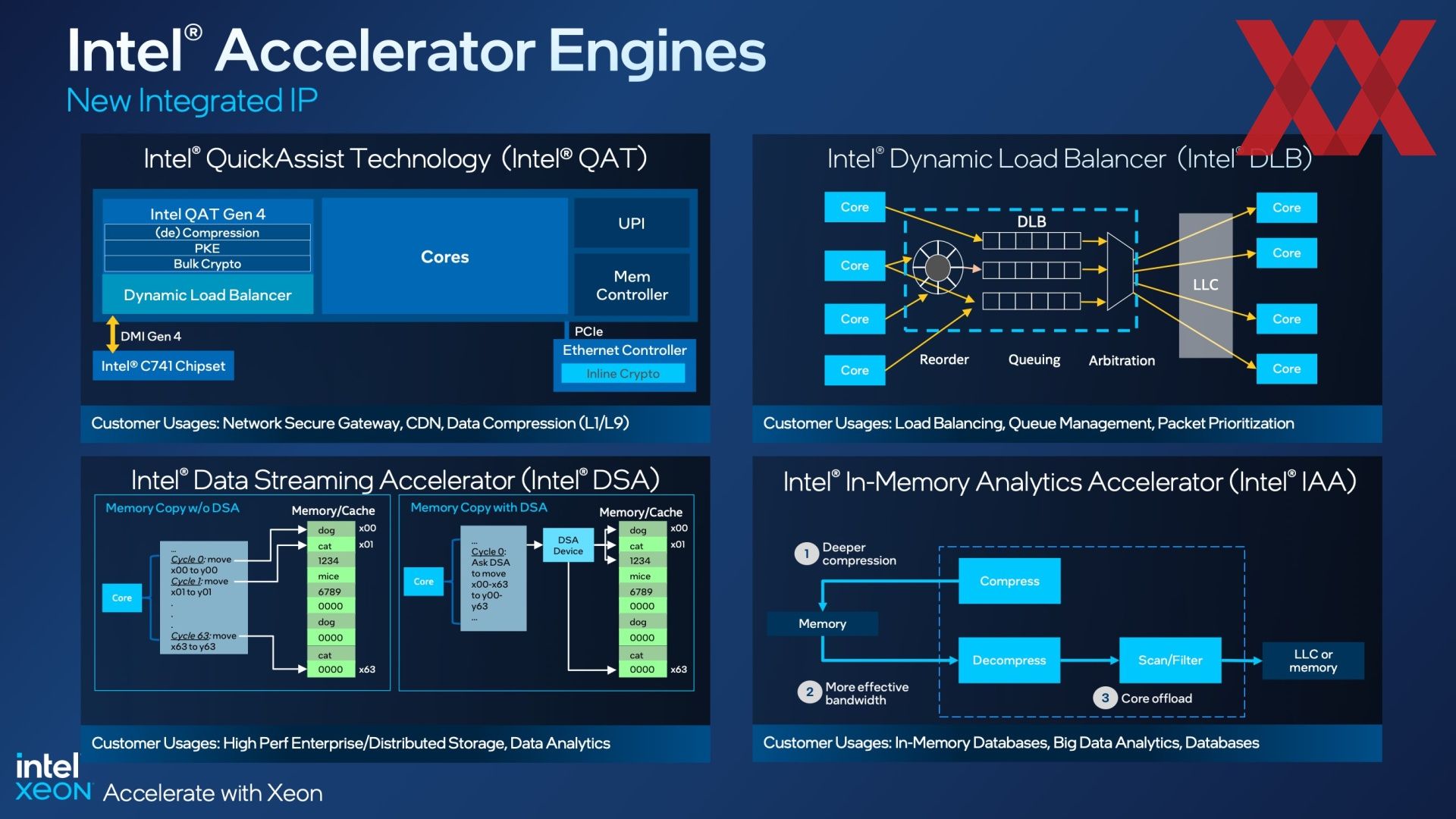

Множество ускорителей снимают нагрузку с ядер

Одним из фокусов четвертого поколения Xeon Scalable стали ускорители, которые либо полностью новые, либо перешли с чипсета на область Uncore процессора. Ниже мы привели список доступных ускорителей:

- QAT (QuickAssist Technology): ускоритель входит в состав ядра и обеспечивает шифрование и сжатие потоков данных. Два типичных сценария QAT – Network Secure Gateways и Content Delivery Networks.

- DLB (Dynamic Load Balancer): DLB обеспечивает более эффективную балансировку нагрузки и равномерное использование ядер в менее требовательных сценариях. Как в случае QoS, некоторые пакеты в конвейере обрабатываются в приоритете.

- DSA (Data Streaming Accelerator): для доступа к памяти больше не требуется обращение к ядрам, что снимает часть нагрузки. Ускоритель будет полезен для сценариев анализа данных и распределенных сервисов хранения данных.

- IAA (In-Memory Advanced Analytics Accelerator): при чтении или записи данных в память распаковка или сжатие выполняются в IAA, после чего данные передаются в LLC. Здесь типичными сценариями можно назвать базы данных, хранящиеся полностью в памяти (In-Memory), анализ данных и базы данных в целом.

Также отметим матричные расширения Advanced Matrix Extensions (AMX). Intel установила ускоритель AMX в каждое ядро процессора.

В таблице процессоров Sapphire Rapids (SKU), которую мы приведем позднее, можно видеть, какие ускорители установлены в тот или иной процессор, а также в каком количестве. Собственно, здесь будет полезен сервис Intel On-Demand. Он позволяет активировать в некоторых SKU функциональные блоки по запросу клиента.

У процессора на ядрах XCC максимальное число ускорителей следующее:

- 4x DSA

- 4x QAT

- 4x DLB

- 4x IAA

В случае кристаллов MCC ускорителей уже меньше:

- 1x DSA

- 2x QAT

- 2x DLB

- 1x IAA

Добавлять отключенные ускорители можно будет через поддержку OEM или SI. Intel предоставляет только интерфейс сервиса On-Demand. Например, если вендор поставит сервер с несколькими отключенными ускорителями, их можно будет активировать позднее при необходимости.

Конечно, сервис On-demand в таком виде оставляет не очень хорошее послевкусие. Аппаратное обеспечение присутствует в полном виде, но некоторые функции искусственно выключены. Активировать их можно будет позднее за доплату. Конечно, это не первая попытка Intel выйти на рынок с подобным сервисом. Насколько она окажется успешной – неизвестно.

Расширения AMX и AVX являются частью ядер CPU, но ускорители вынесены наружу. Хотя они находятся не в чипсете, а в составе кристалла SoC. Ускорители в данном случае подключаются как внешние блоки (подобно устройствам расширения PCIe или CXL), после чего они доступны для программного обеспечения. Комплекс ускорителей на кристаллах XCC и MCC подключен к mesh-сети.

Линейка Xeon Max для HPC с поддержкой HBM2e

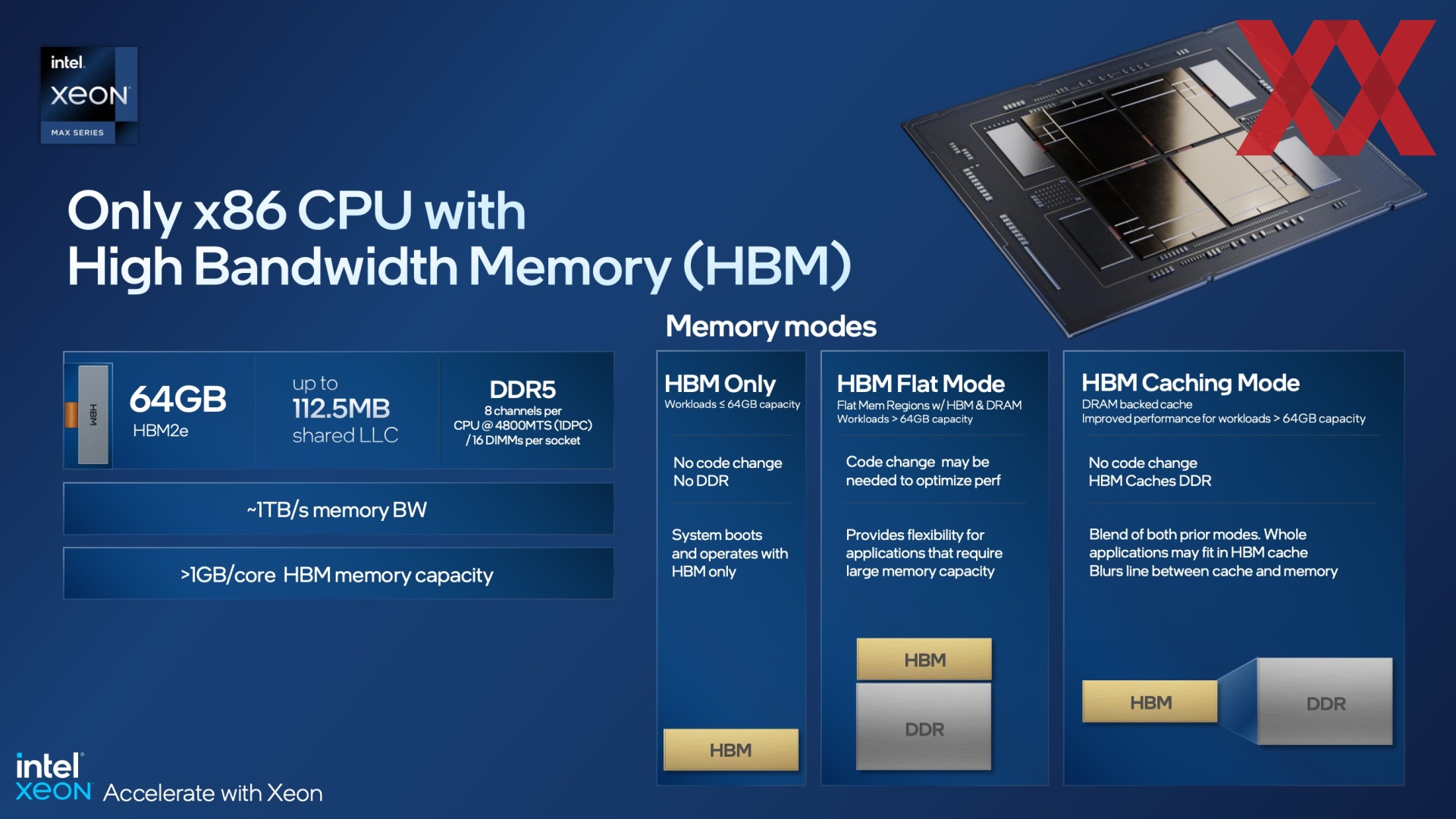

Пять процессоров из нескольких десятков объявленных SKU предназначены для сегмента высокопроизводительных вычислений HPC. У них есть общая функция: память HBM2e, встроенная в корпусировку. Процессор для HPC предлагает до 56 ядер, что меньше максимума 60 ядер в полной конфигурации. Впрочем, 60 ядер Intel пока планирует только в одной модели – Xeon Platinum 8490H.

Процессоры Xeon могут работать с дополнительной памятью в трех режимах. В режиме "HBM only" сервер загружается только с памятью HBM2e, дополнительная память DDR5 не используется. Причем приложения и ОС не знают, какая память задействована, HBM2e или DDR5. Со стороны программного обеспечения этого не видно. Режим "HBM only" позволяет разрабатывать компактные и быстрые серверы без DDR DIMM вообще.

В режиме "HBM Flat Mode" память HBM2e становится дополнительным уровнем в иерархии кэша. Если данные превышают доступный объем 64 Гбайт, то они переходят в оперативную память. Здесь следует оптимизировать код таким образом, чтобы объемы данных больше 64 Гбайт не приводили к снижению производительности из-за миграции в DDR5.

Режим "HBM Caching Mode" использует HBM2e в качестве кэша оперативной памяти. Он является своего рода гибридным для двух упомянутых выше режимов. Какой-либо доработки программного обеспечения не требуется.

Все процессоры Xeon в линейке Max оснащаются 64 Мбайт HBM2e. Пропускная способность памяти для четырех стеков превышает 1 Тбайт/с, поскольку для одного стека она выше 256 Гбайт/с. С восемью каналами DDR4 пропускная способность была ограничена 204 Гбайт/с, поэтому память HBM2e дает ощутимый прирост.

AMD предлагает процессоры EPYC с дополнительным кэшем 3D V-cache (Milan-X). Но Intel видит себя в намного более выгодном положении с процессорами Sapphire Rapids по соотношению производительности на ватт, причем как с памятью DDR5, так и в режиме "HBM only". Здесь учитывались такие тесты, как HPL, HPCG и Stream Triad, результаты сравнивались с предшественником Ice Lake-SP.

Процессоры Xeon Max CPU позволяет заменить крупный сервер с четырьмя сокетами, 64 RAM DIMM и энергопотреблением 1.640 Вт моделью с двумя процессорами Xeon с памятью HBM2e, при этом не надо не тратиться на DDR5, а энергопотребление составит всего 700 Вт.

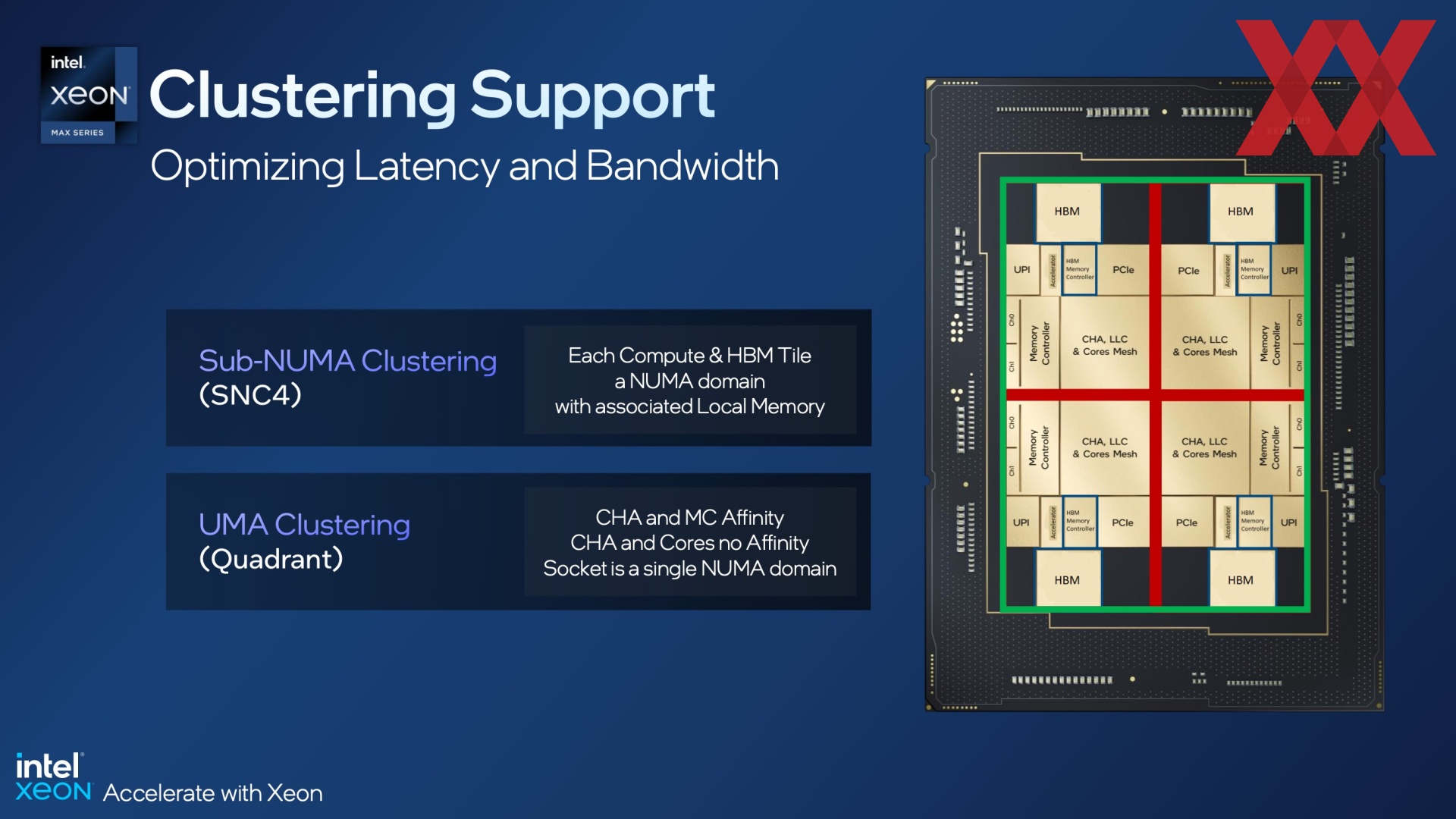

Для серверных процессоров, состоящих из нескольких кристаллов, очень важны задержки и пропускные способности между чиплетами. С помощью кластеризации отдельные узлы можно отделить друг от друга, чтобы доступ к памяти не выполнялся через другие чиплеты, поскольку это увеличивает задержки.

Intel добавила к Sapphire Rapids поддержку кластеризации Sub-NUMA, известную как SNC4. Здесь четыре чиплета со своей памятью HBM и соответствующими контроллерами рассматриваются как отдельные узлы. И для некоторых приложений такое решение имеет смысл.

Но Intel также дает возможность использовать все чиплеты CPU вместе с подключенной памятью HBM как один узел NUMA с кластеризацией UMA. Агенты кэширования и контроллеры памяти оптимизированы таким образом, чтобы свести на нет недостатки по задержкам.

Аппаратное и программное обеспечение в гармонии

Безопасность в приоритете

В облачных окружениях и серверах проблема безопасности всегда находится в приоритете. Ни один клиент не хочет, чтобы к данным, которые обрабатываются на одном сервере, получили доступ другие клиенты. Отдельные VM можно изолировать через TDX (Trust Domain Extensions).

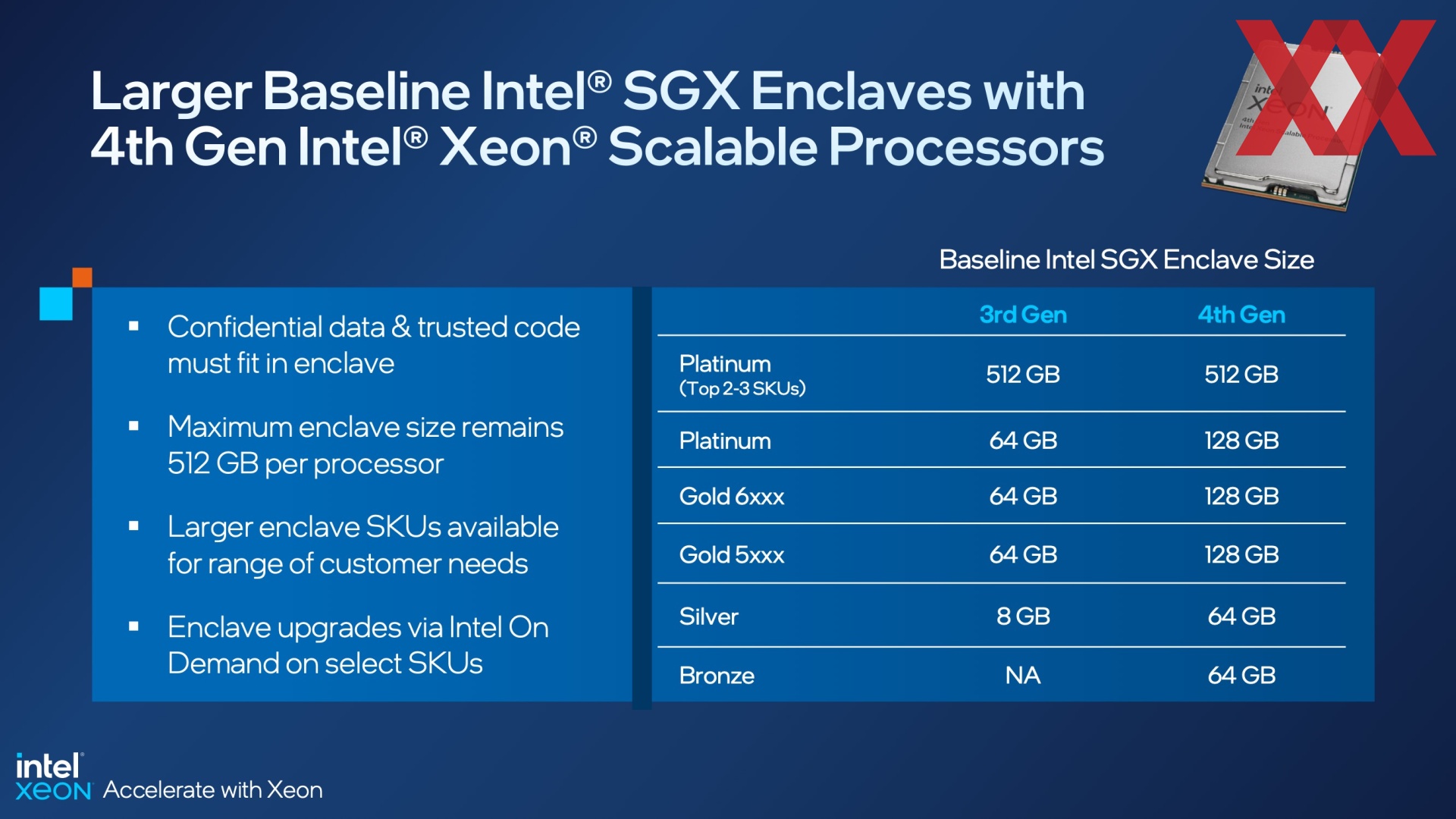

SGX (Software Guard Extensions) – следующий шаг. Данные хранятся в области Secure Enclave, хотя здесь уже были опубликованы уязвимости, через которые можно провести атаки. С четвертым поколением Xeon Scalable емкость Secure Enclave была увеличена на процессорах линейки, но 512 Гбайт все равно остаются максимумом. Рост емкости Secure Enclave лучше всего заметен по младшим и средним процессорам. Кроме того, через сервис on-demand можно увеличить емкость Secure Enclave до максимума 512 Гбайт.

OneAPI – все под одной крышей

OneAPI – решение с полным стеком от Intel, которое объединяет несколько архитектур, платформ и экосистем. Планируется выпустить несколько инструментариев (Base Toolkit, HPC Toolkit, AI Analytics Toolkit, Rendering Toolkit, IoT Toolkit) для соответствующих приложений, но в финале OneAPI станет основой для всех разработок – здесь можно провести аналогии с NVIDIA CUDA.

В таком случае пользователь может не думать о том, на каком «железе» он запускает приложения, поскольку OneAPI гарантирует эффективную и быструю работу на доступных ресурсах. Среди поддерживаемых программных библиотек можно упомянуть PyTorch и TensorFlow, например.

Есть и уровни трансляции. С их помощью можно выполнять код, предназначенный для CUDA, при этом избыточные вычисления при переводе на OneAPI через SYCL должны быть невелики.

Обзор всех процессоров

В общей сложности представлено 52 модели четвертого поколения Xeon Scalable. Как обычно, они разделены на категории Platinum (8000 series), Gold (5000 и 6000 series), Silver (4000 series) и Bronze (3000 series). Также представлены процессоры HPC с памятью HBM2e, которые располагаются вне упомянутых линеек.

Внутри линек Intel разделила процессоры на модели, оптимизированные под определенные сценарии:

- Облако: P-, V-, M-Serie

- Сети: N-Serie

- Хранение данных: S-Serie

- 1 сокет: U-Serie

- Long-Life Use: T-Serie

- IMDB, Analytics, оптимизация VM: H-Serie

- Водяное охлаждение: Q-Serie

В таблице выше приведены все SKU, официально представленные Intel. Максимальное число ядер составляет 60, но его можно получить только у одной модели (Xeon Platinum 8490H). В других линейках максимальное число ядер обычно ограничивается 52 или 56. Что тоже указывает на долю выхода годных кристаллов, поскольку в распоряжении компании довольно мало кристаллов с полными 15 ядрами, которые можно упаковать в количестве четырех штук в одну корпусировку. TDP процессоров с 52 или большим числом ядер составляет между 300 и 350 Вт.

Что касается тактовых частот, то здесь привычные компромиссы: чем больше ядер насчитывается в данном классе TDP, тем меньше частота All-Core Turbo и базовая. Intel у некоторых процессоров выставила довольно высокие частоты Boost для одиночных ядер. Многие процессоры поддерживают технологию Intel Speed Select Technology (Intel SST) и такие функции, как Intel SST Base Frequency (SST-BF), Intel SST Core Power (SST-CP) и Intel SST Turbo Frequency (SST-TF). Здесь отбираются лучшие ядра, которые могут работать на высоких тактовых частотах.

Также Intel предлагает с процессорами Sapphire Rapids режим Optimized Power Mode, который снижает энергопотребление на 20%, но придется жертвовать лишь 5% производительности.

У «младших» моделей доступны всего восемь ядер. TDP составляет от 125 до 150 Вт, в зависимости от серии. Intel также частично уходит с DDR5-4800 на DDR5-4400 с данными процессорами, что также верно с двумя модулями на канал 2DPC.

Intel приводит результаты тестов

Как обычно бывает в случае подобных анонсов, Intel представила тесты практически во всех мыслимых сценариях. За прошедшие месяцы таких слайдов накопилось немало, Intel демонстрирует преимущество над конкурентами в определенных приложениях. Например, раньше Intel публиковала результаты тестов процессоров с HBM2e.

Но Intel обычно сравнивает результаты с собственными процессорами предыдущих поколений или в некоторых случаях с Broadwell, чтобы показать клиентам преимущества от апгрейда. Хотя кое-где проводятся сравнения и с Milan-X, показывающие выигрыш от существенно более емкой памяти HBM2e.

Intel видит себя впереди с большим отрывом по использованию ускорителей. Здесь в фокусе приложения AI/ML, базы данных и сетевые приложения, где часть задач можно перенести на ускорители.

На данный момент мы не можем представить собственные тесты, но наши коллеги ServeTheHome и Phoronix приготовили подробные обзоры и бенчмарки.

Подписывайтесь на группу Hardwareluxx ВКонтакте и на наш канал в Telegram (@hardwareluxxrussia).