На конференции Google I/O поисковый гигант не только объявил первые складные смартфоны Pixel, новые модели среднего класса и планшет, но также рассказал о собственных системах искусственного интеллекта, которые используются для поискового движка.

На конференции Google I/O поисковый гигант не только объявил первые складные смартфоны Pixel, новые модели среднего класса и планшет, но также рассказал о собственных системах искусственного интеллекта, которые используются для поискового движка.

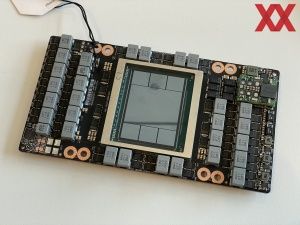

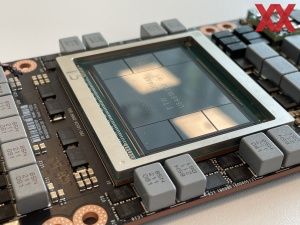

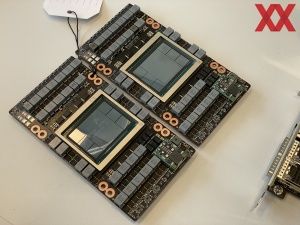

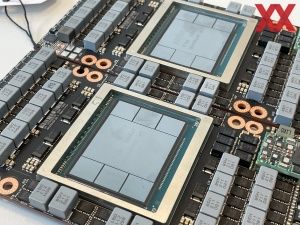

Речь идет о Compute Engine A3, который представляет собой не просто обычный суперкомпьютер, расположенный в одном из многих дата-центров Google. На самом деле A3 распределен по нескольким дата-центрам. Суперкомпьютер состоит из множества систем DGX-H100, которые используют процессор Xeon (Sapphire Rapids) и восемь H100 GPU в каждой. Также системы оснащены 2 Тбайт памяти DDR5-4800. Если сложить все инстанции A3, то в составе Compute Engine A3 работают 26.000 GPU. У самого быстрого нынешнего суперкомпьютера Frontier используются 37.000 Radeon Instinct MI250X GPU. Facebook использует для расчетов искусственного интеллекта суперкомпьютер с 16.000 A100 GPU, предшественниками H100.

Google открывает доступ к инстанциям A3 и своим клиентам. Компании не требуется постоянная производительность 26.000 GPU, поэтому разделение на множество дата-центров имеет смысл. У предшественника A2 использовались NVIDIA A100 GPU.

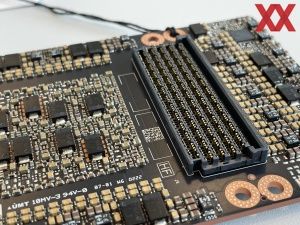

В системе DGX восемь H100 GPU подключены через интерконнект с пропускной способностью 3,6 Тбайт/с, к сети они подключены интерфейсом 200 Гбит/с. Здесь используются собственные Google IPU (Infrastructure Processing Unit), которые снимают с host-системы задачу управления сетевым трафиком.

Суперкомпьютер A3 обеспечивает производительность 26 ExaFLOPS с низкой точностью (для вычислений ИИ). Что позволяет назвать его одной из самых быстрых систем ИИ в мире.

Но даже при столь огромной вычислительной мощности, на тренировку больших языковых моделей (Large Language Model или LLM) могут уйти дни и недели. Недавно MosaicML представила модель MPT-7B в виде открытого исходного кода. Тренировка выполнялась на системе DGX с восемью H100 GPU на протяжении 21 дня. На тренировку Facebook LLaMA (Large Language Model Meta AI) тоже ушел 21 день при стоимости $2,2 млн.

На тренировку модели OpenAI GPT-4 уйдут многие месяцы, а стоимость тренировки составит сотни миллионов долларов США.

Подписывайтесь на группу Hardwareluxx ВКонтакте и на наш канал в Telegram (@hardwareluxxrussia).