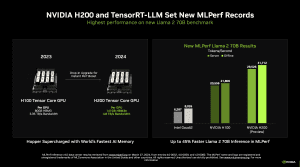

MLCommons – консорциум различных производителей, целью которого является предоставление независимых и сопоставимых бенчмарков для оборудования центров обработки данных. Сегодня он опубликовал результаты теста Inference 4.0. В нем дебютировал ускоритель NVIDIA H200, который также основан на архитектуре Hopper и имеет ту же ступень расширения, что и ускоритель NVIDIA H200, но использует 141 ГБ HBM3E вместо 80 ГБ HBM2.

MLCommons – консорциум различных производителей, целью которого является предоставление независимых и сопоставимых бенчмарков для оборудования центров обработки данных. Сегодня он опубликовал результаты теста Inference 4.0. В нем дебютировал ускоритель NVIDIA H200, который также основан на архитектуре Hopper и имеет ту же ступень расширения, что и ускоритель NVIDIA H200, но использует 141 ГБ HBM3E вместо 80 ГБ HBM2.

HBM3E будет использоваться во всех будущих ускорителях ИИ. NVIDIA уже анонсировала свой GPU Blackwell с HBM3E, а AMD, как говорят, планирует перевести свои ускорители Instinct MI300A/X на HBM3E. Высокая пропускная способность более быстрой памяти особенно заметна при инференсе и тренировке больших языковых моделей (LLM). Поскольку в настоящее время почти все в центрах обработки данных сосредоточено на генеративном ИИ и LLM, неудивительно, что производители аппаратного обеспечения концентрируют на них все свое внимание.

В рамках результатов Inference 4.0 мы получили первое независимое сравнение между NVIDIA H100, новым H200 и ускорителем Intel Gaudi 2. В данном бенчмарке приложений для ЦОД акцент смещен на инференс. Используются модели, которые прошли полную тренировку, выполняется только инференс. В настоящее время NVIDIA предполагает, что 40% выпускаемого аппаратного обеспечения будет использоваться для инференса, и эта доля продолжит увеличиваться. Собственно, в этом одна из причин, почему NVIDIA разработала Blackwell GPU с учетом инференса.

Мы выбрали несколько результатов инференса для модели Llama 2 с 70 миллиардами параметров, первый раз в оффлайн режиме, второй – в онлайн. Мы выбрали системы с восемью ускорителями каждая, но разными профилями производительности.

Llama 2 c 70 млрд. параметров

Server

Llama 2 c 70 млрд. параметров

Offline

Ускорители в бенчмарках выполняли типичную нагрузку при ответе на запросы LLM. Производительность измерялась в токенах в секунду, то есть сколько мельчайших единиц LLM в секунду может обработать система.

Ускорители H200 как минимум в четыре раза быстрее, чем ускорители Gaudi 2 от Intel. Прирост от перехода с H100 на H200 при мощности 700 Вт составляет 30%. При использовании специального охлаждения Custom Cooling Solution (CTS) ускорители H200 достигают прироста в 45% по сравнению с H100. Однако следует отметить, что решение CTS мощностью 1.000 Вт потребляет на 43% больше, но при этом быстрее всего на 15%. В этой конфигурации ускорители H200 работают далеко за пределами идеального рабочего окна эффективности.

Системы DGX и MGX с ускорителями H100 могут быть модернизированы до ускорителей H200. Грядущие ускорители B100 также совместимы с ними. NVIDIA уже начала поставлять первые ускорители H200 провайдерам облачных услуг и OEM-производителям. Таким образом, ускорители уже близки к выходу на рынок.

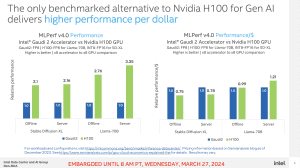

Intel наравне только по TCO

В результатах вычислений нет и следа ускорителей Instinct MI300A/X. Intel по-прежнему представлена ускорителями Gaudi 2, но их производительность оставляет желать лучшего.

С другой стороны, по соотношению цена/производительность ускорители все еще впереди. Intel может набрать очки за счет того, что ускорители Gaudi 2 доступны и сравнительно дешевы, в то время как купить ускорители H100 и, вероятно, H200 в настоящее время все еще несколько затруднительно.

Если вы хотите более подробно ознакомиться с цифрами или результатами MLPerf, то рекомендуем обратиться к сайту консорциума.

Подписывайтесь на группу Hardwareluxx ВКонтакте и на наш канал в Telegram (@hardwareluxxrussia).