Последние месяцы NVIDIA можно назвать очень успешной компанией. Бум ИИ помогает получать миллиардные прибыли, спрос на ускорители все еще не иссяк, GPT-3 – это только начало. Текст, аудио, видео, 3D, физика, медицина - во всех этих областях сегодня существуют собственные подходы генеративного ИИ, которые объединяются в мультимодальные ИИ для совместной работы над решениями и предоставлении услуг.

Последние месяцы NVIDIA можно назвать очень успешной компанией. Бум ИИ помогает получать миллиардные прибыли, спрос на ускорители все еще не иссяк, GPT-3 – это только начало. Текст, аудио, видео, 3D, физика, медицина - во всех этих областях сегодня существуют собственные подходы генеративного ИИ, которые объединяются в мультимодальные ИИ для совместной работы над решениями и предоставлении услуг.

Такие модели, как Gemini от Google, NLLB от Meta, Mistral от Maxtral или GPT-4 от OpenAI, представляют собой так называемые смеси экспертов (Mixtures of Experts, MoEs), спектр функций которых постоянно расширяется. Огромные массивы данных для тренировки, все более длинные и подробные запросы, более высокие требования к выдаче в реальном времени ставят все более сложные задачи перед аппаратным обеспечением, которые NVIDIA пока решает с помощью архитектуры Hopper.

На GTC в Сан-Хосе генеральный директор Дженсен Хуан (Jensen Huang) представил архитектуру Blackwell и одноименные ускорители. Как утверждает NVIDIA, созданные ускорители B100, B200 и GB200 способны свершить настоящую революцию в этой области. И с дальнейшим развитием полупроводниковых технологий тренд должен сохраниться.

Архитектура Blackwell названа в честь Дэвида Блэквелла, математика и статистика, специализировавшегося на теории вероятности, теории игр, статистике и динамическом программировании.

Графический процессор Blackwell состоит из двух чипов, которые производятся по техпроцессу 4NP (модификация техпроцесса N4P) на мощностях TSMC. По словам NVIDIA, чипы производятся на пределе техпроцесса по площади (Reticle Limit), то есть около 800 мм² или чуть больше. GPU GH100 имеет площадь 814 мм², а для производства с EUV предел составляет около 858 мм². Поскольку NVIDIA уперлась в площадь кристалла, она пошла по пути создания чиплетов. Очевидно, что меньший техпроцесс, чем 4N, пока недоступен.

Два чипа соединены интерфейсом Chip-2-Chip (C2C), пропускная способность которого достигает 10 ТБ/с. Для сравнения: Instinct MI300 от AMD достигает 17 ТБ/с по всей корпусировке, но здесь подразумеваются 8 XCD с подключением 2,1 ТБ/с каждый. Интерконнект UltraFusion от Apple для чипов Ultra достигает 2,5 ТБ/с. NVIDIA же соединяет два чипа со скоростью 10 ТБ/с. Здесь NVIDIA использует технологию CoWoS-L от TSMC, которая, по словам TSMC, теоретически позволяет соединить до шести таких огромных кристаллов вместе. Если верить NVIDIA, вариант GPU Blackwell с одним чипом в настоящее время не планируется, хотя каждый из этих чипов будет полностью функциональным и сам по себе.

Два кристалла Blackwell GPU должны работать как один большой чип площадью 1.600 мм². Количество транзисторов составляет 208 миллиардов – 104 млрд. на чип, то есть 24 млрд. больше, чем у Hopper. К обоим кристаллам подключены четыре микросхемы памяти HBM3E по 24 ГБ каждая, таким образом, ускоритель B100 предлагает 192 ГБ памяти HBM3E. Пропускная способность памяти составляет 8 ТБ/с.

| B100 | B200 | H100 | Instinct MI300X | |

| Техпроцесс | 4 нм | 4 нм | 4 нм | 5 / 6 нм |

| Количество транзисторов | 208 млрд. | 208 млрд. | 80 млрд. | 153 млрд. |

| Производительность FP64 | 30 TFLOPS (Tensor Core) | 40 TFLOPS (Tensor Core) | 67 TFLOPs | 81,7 TFLOPs |

| FP32/Производительность TF32 | 1,8 PFLOPS (Tensor Core) | 2,2 PFLOPS (Tensor Core) | 134 TFLOPs | 163,4 TFLOPs |

| Производительность FP16 | 3,5 PFLOPS (Tensor Core) | 4,5 PFLOPS (Tensor Core) | 1,979 PFLOPs | 1,3 PFLOPs |

| Производительность FP8 | 7 PFLOPS (Tensor Core) | 9 PFLOPS (Tensor Core) | 3.958 PFLOPs | 2.61 PFLOPs |

| Производительность FP4 | 14 PFLOPS (Tensor Core) | 18 PFLOPS (Tensor Core) | - | - |

| Память | 192 GB HBM3E 8 Тбайт/с |

288 GB HBM3E 8 Тбайт/с |

80 GB HBM3 3,35 Тбайт/с |

192 GB HBM3 5,3 Тбайт/с |

| Интерконнект | NVLink 1,8 Тбайт/с |

NVLink 1,8 Тбайт/с |

NVLink 900 Гбайт/с |

Infinity Links 512 Гбайт/с |

| PCI Express | 6.0 | 6.0 | 5.0 | 5.0 |

| TDP | 700 | 1.000 Вт | 700 Вт | 750 Вт |

Здесь стоит упомянуть, что во второй половине 2023 года NVIDIA добавила поколение H200 или GH200 к ускорителям H100. Они увеличили емкость памяти HBM3E до 141 ГБ по сравнению с 80 или 96 ГБ. Пропускная способность памяти ускорителя H200 увеличилась до 4,8 ТБ/с. Вычислительная мощность в этом раунде обновлений не изменилась. Теперь снова представлены два варианта Blackwell – B100 и B200. B200 будет использовать другую конфигурацию памяти, но официальной информации пока нет. Предположительно, NVIDIA будет устанавливать память 12-Hi HBM3E с большим объемом. Это даст ускорителю B200 288 ГБ. Существует также комбинация Grace CPU под названием GB200 NVL72. К ней мы перейдем позже.

Что касается вычислительной производительности, то пока NVIDIA для архитектуры Backwell указывает только вычислительную производительность с ядрами Tensor. Производители также предпочитают приводить цифры с разреженными матрицами (Sparcity). Поэтому сравнивать вычислительную производительность уже не так просто. Однако цифры для FP8 и FP16 должны примерно отражать баланс производительности.

По крайней мере, мы можем достаточно хорошо сравнить производительность между решениями NVIDIA.

| Точность | Blackwell GPU | H100 SXM |

| FP4 Tensor Core | 20 PFLOPS | - |

| FP8/FP6 Tensor Core | 10 PFLOPS | 3.958 PFLOPS |

| INT8 Tensor Core | 10.000 TOPS | 3.958 TOPS |

| FP16/BF16 Tensor Core | 5 PFLOPS | 1.979 TFLOPS |

| TF32 Tensor Core | 2,5 PFLOPS | 989 TFLOPS |

| FP64 Tensor Core | 45 TFLOPS | 67 TFLOPS |

В вычислениях с меньшей точностью GPU Blackwell обладает в 2,5 раза большей вычислительной производительностью. Что касается FP64 с использованием тензорных ядер, теоретическая вычислительная производительность снизилась с 67 до 45 TFLOPS. К сожалению, NVIDIA пока не предоставила никакой информации о вычислительной производительности FP64 на потоковых процессорах и их количестве. Многие вопросы об архитектуре Blackwell пока остаются без ответа.

С объемом памяти 192 ГБ NVIDIA теперь может наверстать упущенное и догнать AMD с серией Instinct MI300. Однако пропускная способность памяти гораздо выше - 8 ТБ/с. Объем и скорость памяти играют особенно важную роль в приложениях ИИ. Графический процессор Blackwell взаимодействует с внешним миром через быстрое соединение NVLink со скоростью 1,8 ТБ/с.

NVIDIA указывает TDP для Blackwell на уровне от 700 до 1.200 Вт. Варианты с воздушным охлаждением B100 и B200 достигнут 700 и 1.000 Вт соответственно. 1.200 Вт, конечно, можно будет отвести только с помощью водяного охлаждения. Графический процессор Blackwell оснащен контроллером PCI Express, который уже поддерживает стандарт 6.0.

NVIDIA наверняка расскажет больше об архитектуре Blackwell на GTC или опубликует документацию. Второе поколение движка Transformer Engine призвано значительно увеличить пропускную способность с точностью до 4 бит. Transformer Engine в архитектуре Ada Lovelace и Hopper поддерживает 8-битные числа с плавающей запятой (FP8). FP4 позволяет удвоить пропускную способность по сравнению с FP8, если можно обойтись без точности FP8.

| GB200 NVL722 | HGX B200 | HGX B100 | |

| Количество GPU в системе | 72 | 8 | 8 |

| FP4 (Tensor Core) | 1,4 EFLOPS | 144 PFLOPS | 112 PFLOPS |

| FP8/FP6/INT8 | 720 PFLOPS | 72 PFLOPS | 56 PFLOPS |

| Общая емкость HBM | 30 TB | до 1,5 TB | до 1,5 TB |

| Агрегированная пропускная способность памяти | 600 Тбайт/с | до 64 Тбайт/с | до 64 Тбайт/с |

| Агрегированная пропускная способность NVLink | 130 Тбайт/с | 14,4 Тбайт/с | 14,4 Тбайт/с |

| Ядра CPU | 2.592 | - | - |

NVIDIA предлагает системы HGX-B200 с различиями в конфигурации памяти. Однако NVIDIA также отмечает отличия по энергопотреблению, что может объяснить разницу в вычислительной производительности. Ускоритель B100 потребляет 700 Вт каждый, а система HGX-B100 дает производительность 112 PFLOPS для FP4. Ускоритель B200 может быть настроен на мощность до 1.000 Вт (+40 % по сравнению с 700 Вт у B100), тогда вычислительная производительность будет примерно на 30% выше. Однако ускорители B100 могут встраиваться в существующие серверы в виде модулей SXM5, чего нельзя сказать насчет B200.

Grace плюс Backwell: GB200 NVL72

NVIDIA уже показывала H100 NVL на выставке Computex в прошлом году: два ускорителя H100 на одной печатной плате, каждый с 94 ГБ HBM3. Они были соединены на плате через NVLink.

GB200 NVL72 – стоечное решение NVIDIA, в котором объединены 36 ускорителей GB200. Но дизайн GB200 претерпел изменения. Если ускоритель GH200 состоял из одного CPU Grace и одного GPU Hopper, то ускоритель GB200 теперь состоит из одного CPU Grace и двух GPU Blackwell. GPU теперь расположены не на одной плате с CPU Grace, а на отдельном модуле.

| GB200 | GH200 (2024) | |

| Производительность FP64 (GPU) | 90 PFLOPS (Tensor Core Dense) | 34 TFLOPS |

| Производительность FP32 (GPU) | 2,5 / 5 PFLOPS (Tensor Core) | 67 TFLOPS |

| Производительность FP8 (GPU) | 10 / 20 PFLOPS (Tensor Core) | 3,958 TFLOPS |

| Производительность INT8 (GPU) | 10 / 20 PFLOPS (Tensor Core) | 3,958 TOPS |

| Память CPU | 480 GB (LPDDR5X) 512 Гбайт/с |

480 GB (LPDDR5X) 512 Гбайт/с |

| Память GPU | 384 GB HBM3E |

141 GB HBM3E |

| Пропускная способность памяти (GPU) | 2x 8 Тбайт/с | 4,9 Тбайт/с |

| CPU-GPU (C2C) | 900 Гбайт/с | 900 Гбайт/с |

| TDP | 1.200 Вт | От 450 до 1.000 Вт |

Ускоритель GB200 состоит из Grace CPU и двух GPU Blackwell. Процессор Grace CPU идентичен GH100/GH200. NVIDIA указывает общий объем памяти GB200 как 864 ГБ - 2x 192 ГБ HBM3E для двух ускорителей Blackwell и 480 ГБ LPDDR5X, которые подключены к CPU Grace. Благодаря NVLink C2C связь между CPU Grace и GPU Blackwell осуществляется с двунаправленной пропускной способностью 900 ГБ/с. Внешне каждый ускоритель GB200 подключен через NVLink с помощью двух соединений 1,8 ТБ/с.

Таким образом, в одной стойке GB200 NVL72 работает 36 ускорителей GB200. Ускорители размещаются в серверах высотой 1U и используют водяное охлаждение. Также имеется модуль с двумя коммутаторами NVLink, который обеспечивает максимально быстрое подключение всех ускорителей друг к другу. О коммутаторах и сетевых опциях мы подготовили отдельную новость.

На стойке GB200-NVL72 планируется обучать LLM с числом параметров до 27 триллионов. Для текущих LLM речь идет о нескольких миллиардах параметров. Поэтому NVIDIA готовит инфраструктуру для будущих LLM.

Оборудование GB200-NVL72 будет поставляться таким облачным провайдерам, как AWS, Google Cloud, Microsoft Azure и Oracle Cloud. AWS также планирует создать суперкомпьютер искусственного интеллекта под названием Ceiba, который будет основан на системах GB200-NVL72 и будет состоять из более чем 20.000 графических процессоров Blackwell. Вычислительная производительность ИИ, как утверждается, составит более 400 EFLOPs, что сделает систему одним из самых быстрых ИИ-суперкомпьютеров.

Прогнозы производительности

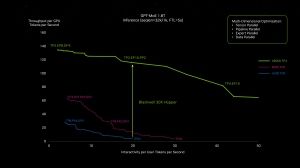

Во время пленарного доклада Дженсен Хуан назвал некоторые цифры производительности, в том числе для Grace Blackwell Superchip (GB200). Он указал рост производительности в 4-30 раз. Эти данные все еще в основном основаны на экстраполяции или прогнозах, так как GPU Blackwell пока работают только в лабораториях. И если работают, то наверняка не на полной производительности.

В первом бенчмарке NVIDIA сравнивает систему HGX-H100 с восемью ускорителями H100 с 18 GB200 Grace Blackwell Superchip для проведения инференса 1,8T GPT MoE. На второй диаграмме показана соответствующая тренировка – первый раз на 32.768 ускорителях H100 в качестве эталонного значения, а затем в четыре раза быстрее на 456 GB200 NVL72.

B100, B200 и GB200 должны обеспечить значительно большую производительность при том же энергопотреблении или, при целевых характеристиках производительности, значительно меньшее энергопотребление и меньшее количество необходимых аппаратных ресурсов.

Подписывайтесь на группу Hardwareluxx ВКонтакте и на наш канал в Telegram (@hardwareluxxrussia).