В начале апреля Intel официально представила поколение Cascade Lake процессоров Xeon. Они устанавливаются на платформу Purley с сокетом LGA3647, которая уже используется для процессоров Skylake SP/AP. Однако в архитектуре CPU произошли некоторые изменения, в том числе и касающиеся поддержки памяти, в результате чего Cascade Lake Xeon смотрятся намного лучше. В нашу тестовую лабораторию поступили два Xeon Platinum 8280, которые мы сравним с прямыми предшественниками в разных сценариях.

В начале апреля Intel официально представила поколение Cascade Lake процессоров Xeon. Они устанавливаются на платформу Purley с сокетом LGA3647, которая уже используется для процессоров Skylake SP/AP. Однако в архитектуре CPU произошли некоторые изменения, в том числе и касающиеся поддержки памяти, в результате чего Cascade Lake Xeon смотрятся намного лучше. В нашу тестовую лабораторию поступили два Xeon Platinum 8280, которые мы сравним с прямыми предшественниками в разных сценариях.

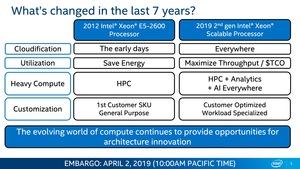

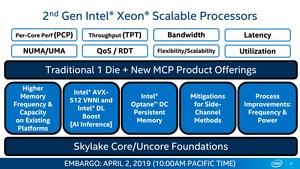

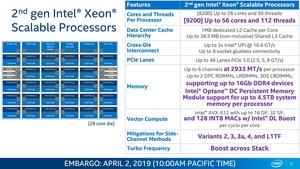

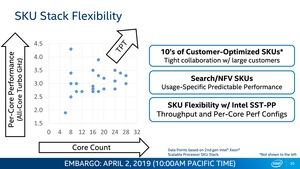

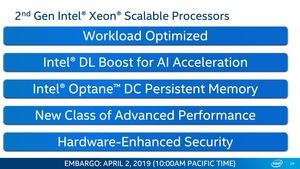

Со вторым поколением процессоров Xeon Scalable Intel изменила направление развития линейки Xeon. Если процессоры Skylake-SP были ориентированы на классическую вычислительную производительность, а для особых сценариев предусматривались ускорители Xeon Phi или дополнительные чипы FPGA, то архитектура Cascade Lake приводит к тому, что подобные специальные решения уже не нужны. Cascade Lake Xeon выпущены в весьма широком ассортименте, есть и специальные варианты для различных сценариев, причем все это - на единой платформе.

Новые процессоры

Мы привели список новых процессоров в нашем подобном обзоре Xeon Scalable второго поколения.

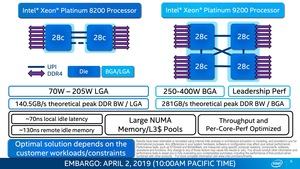

С процессорами Cascade Lake Intel внесла изменения в архитектуру и техпроцесс по сравнению со Skylake, но оба поколения аппаратно довольно близки. Intel производит процессоры Cascade Lake SP на кристаллах трех размеров. Кристаллы LCC (Low Core Count) со степпингом R1 содержат до восьми ядер. Для более мощных CPU Intel использует кристаллы HCC (High Core Count) со степпингом L1 - до 18 ядер. Наконец, для CPU с числом ядер до 28 Intel использует степпинг B1 кристалла XCC (Extreme Core Count)..

Все кристаллы по-прежнему производятся по 14-нм технологии. К сожалению, Intel не дает информации о числе транзисторов или размере кристалла. Но по расчетам кристалл LCC имеет площадь 322 мм², HCC - 484 мм², а XCC - 698 мм². Но вряд ли изменения по сравнению с поколением Skylake SP по числу транзисторов и площади велики, поскольку интеграция VNNI и аппаратное исправление уязвимостей не приводит к существенному увеличению числа транзисторов.

По сравнению с процессорами Skylake, для некоторых CPU Intel обещает прирост производительности в 1,6 раза. Если внимательно рассмотреть некоторые модели и сравнить с предшествующими CPU, то Intel не только немного увеличила тактовые частоты, но и в ряде случаев добавила ядра. Например, если у Intel Xeon 6130 использовалось только 16 ядер, Xeon 6230N получил 20. То же самое можно видеть и для некоторых других CPU. Благодаря улучшенному техпроцессу Intel удалось увеличить тактовые частоты на 200-300 МГц.

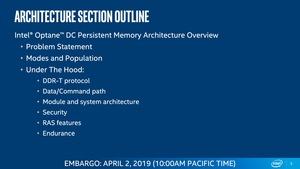

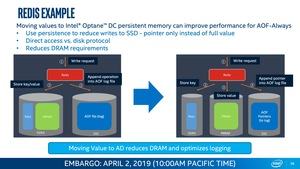

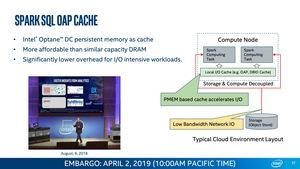

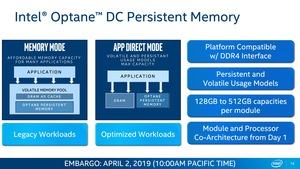

Optane DC Persistent Memory

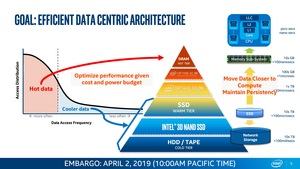

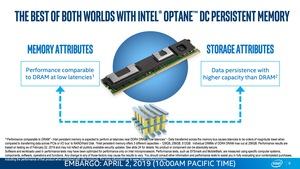

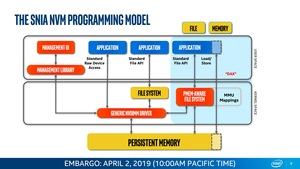

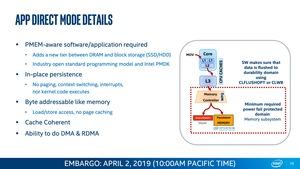

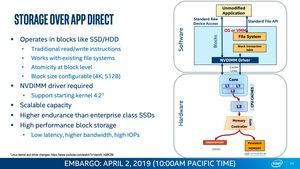

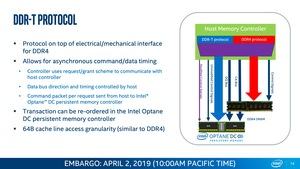

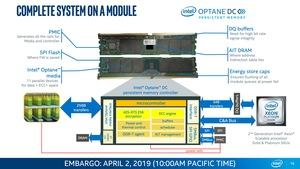

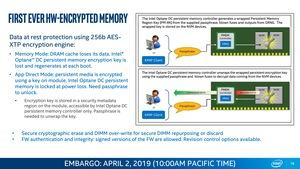

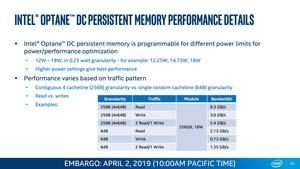

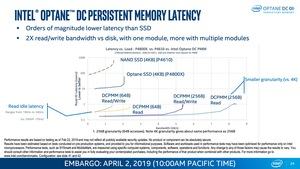

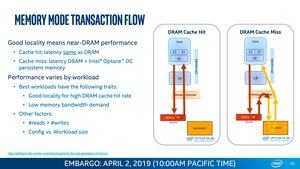

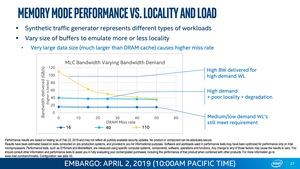

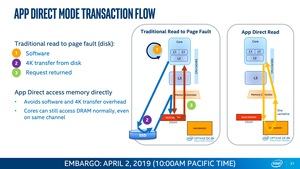

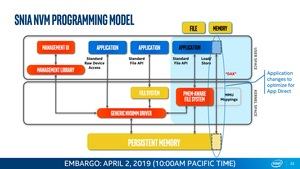

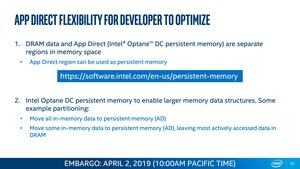

Важной особенностью новых Xeon на архитектуре Cascade Lake является поддержка Optane DC Persistent Memory. Уже несколько месяцев Intel активно подчеркивала, что память Optane DC Persistent Memory будет играть ключевую роль с новыми процессорами Cascade Lake Xeon.

Платформа Purley изначально создавалась с поддержкой новой памяти. Вероятно, Intel планировала представить Optane DC Persistent Memory еще с Skylake Xeon, но решила все же ограничить поддержку только в целях разработки. Многие серверы и материнские платы содержат определенное количество слотов DIMM для установки модулей Optane DC Persistent Memory.

Если вам интересны технические подробности, работа и структура Optane DC Persistent Memory, мы рекомендуем обратиться к нашему обзору процессоров Xeon Scalable второго поколения. Там мы рассмотрели конфигурацию и режимы работы Optane DC Persistent Memory. Поскольку на момент тестов новые модули Optane мы не получили, то ограничимся работой с классической памятью.

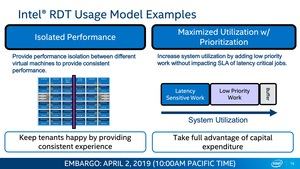

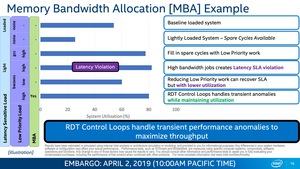

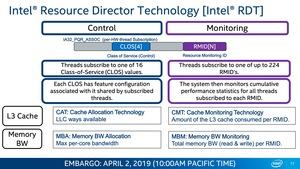

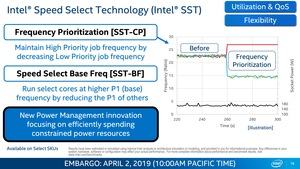

Resource Director и Speed Select

Технологии Resource Director и Speed Select позволяют процессорам Cascade Lake лучше адаптироваться к нагрузкам. В случае Resource Director Technology (RDT) управление осуществляется программными средствами. RDT позволяет Intel более эффективно распоряжаться доступными ресурсами. Администратор может выбирать между выделением ресурсов исключительно для указанной нагрузки и гибким распределением. Технология выполняет мониторинг кэшей и пропускной способности памяти, позволяя гибко их распределять.

Цель заключается в более высокой степени использования процессоров, чтобы повысить эффективность серверов. Вместе с тем на администратора переносится часть ответственности за грамотное распределение ресурсов. Конечно, RDT не следует использовать для нагрузок, которым нужна максимальная производительность.

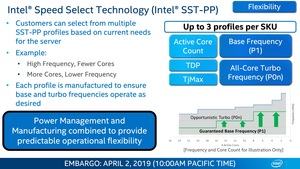

Speed Select Technology (SST) тоже опирается на схожий подход. Она позволяет выставлять на выбранных ядрах более высокие тактовые частоты. На других ядрах частоты, напротив, снижаются. Для начала Intel будет поддерживать три профиля на трех моделях Xeon (процессоры Y).

Кроме того, существуют нагрузки, которые должны выполняться с определенной тактовой частотой, чтобы давать расчетную производительность. В случае Speed Select Technology данная проблема тоже решается, поскольку ресурсы CPU полностью контролируются.

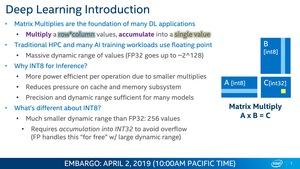

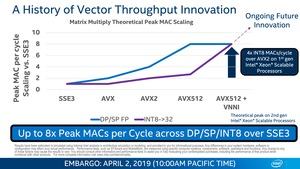

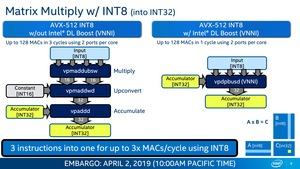

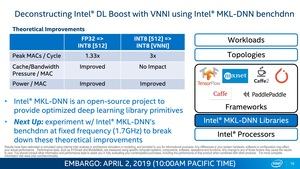

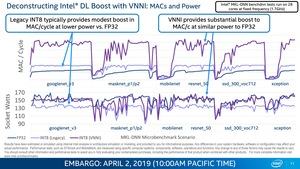

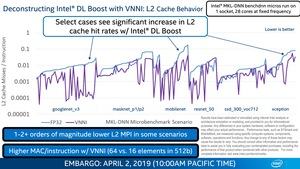

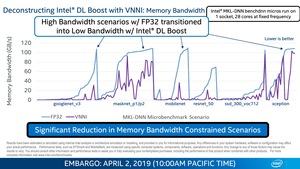

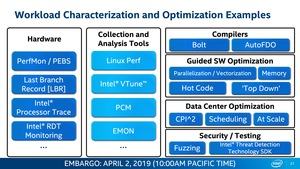

VNNI и DL Boost

Intel добавила поддержку новых наборов инструкций. В контексте инструкций AVX-512 важной спецификой новых процессоров Xeon являются Vector Neural Network Instructions (VNNI). Вычислительная производительность AVX-512 с одинарной и двойной точностью между поколениями Skylake и Cascade Lake остается идентичной. Но поскольку теперь возможен расчет 4x INT MAC/такт по сравнению с AVX2 в процессорах Skylake-SP, новые CPU Cascade Lake теоретически получают четырехкратный прирост вычислительной производительности в данных вычислениях. Intel говорит, что на практике можно рассчитывать на трехкратное увеличение.

Поддержка VNNI в процессорах Xeon Scalable позволяет более гибко использовать их при тренировке сетей глубокого обучения и в инференсе. Впрочем, для инференса, то есть для запросов в сеть глубокого обучения, все же лучше подходят специализированные процессоры. Intel как раз предлагает здесь Agilex FPGAs.

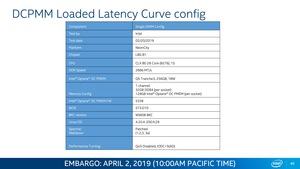

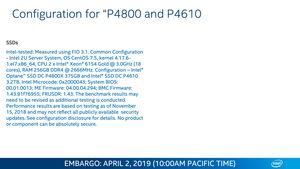

Для тестов новых процессоров Xeon Platinum нам потребовалась обновленная конфигурация. Ниже мы ее как раз более детально рассмотрим.

Центральным компонентом каждой системы является процессор. В нашем распоряжении были два Xeon Platinum 8280, которые мы сравним с предшественниками Xeon Platinum 8180 на архитектуре Skylake.

Оба процессора оснащены 28 ядрами и могут выполнять 56 потоков одновременно. Поскольку оба варианта используют сокет LGA3647 и работают на платформе Purley, мы смогли протестировать 8280 и 8180 на одной и той же материнской плате с одинаковой памятью. Впрочем, в случае Xeon Platinum 8180 память работает на частоте 2.666 МГц, а с процессором Xeon Platinum 8280 она составляет 2.933 МГц.

Между двумя процессорами имеется разница по тактовым частотам. Базовая частота Xeon Platinum 8180 составляет 2,5 ГГц, у 8280 - 2,7 ГГц. Прирост тактовой частоты стал возможен благодаря улучшениям техпроцесса. Частота Boost увеличилась с 3,8 до 4,0 ГГц. Также 200-МГц прирост частоты обеспечивается и при нагрузке AVX. Напомним, что когда процессоры Intel нагружаются приложениями с набором инструкций AVX, AVX2 или AVX-512, они не могут сохранять тактовые частоты Turbo на том же уровне, что и без AVX из-за более высоких аппаратных требований. Intel как раз недавно опубликовала документ, где разъясняются тактовые частоты Xeon Scalable второго поколения. Разница по частотам Turbo с инструкциями AVX и без таковых составляет 600-800 МГц, в некоторых случаях даже 900 МГц. Базовая частота с инструкциями AVX, AVX2 или AVX-512 тоже снижается.

| Модель | Xeon Platinum 8180 | Xeon Platinum 8280 |

| Цена | 10.009 USD | 10.009 USD |

| Технические спецификации | ||

|---|---|---|

| Ядра | 28 | 28 |

| Потоки | 56 | 56 |

| Базовая частота | 2,5 ГГц | 2,7 ГГц |

| Частота Boost | 3,8 ГГц | 4,0 ГГц |

| Кэш L3 | 38,5 MB | 39 MB |

| TDP | 205 Вт | 205 Вт |

| Оперативная память | 786 GB DDR4-2666 | 1 TB DDR4-2933 |

| Optane DC Persistent Memory | ✗ | ✓ |

| Линии PCI Express 3.0 | 48 | 48 |

| Блоки AVX-512 FMA | 2 | 2 |

| Speed Select Technology | ✗ | ✗ |

| Resource Director Technology | ✗ | ✓ |

| DL-Boost / VNNI | ✗ | ✓ |

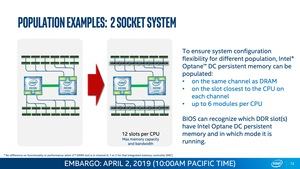

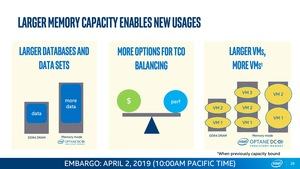

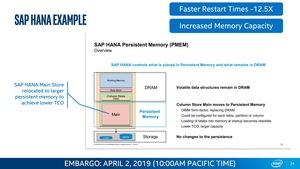

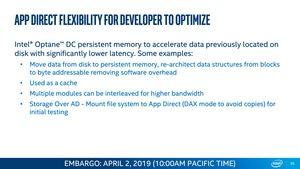

Тепловой пакет (Thermal Design Power) двух поколений не изменился - 205 Вт. Связь между двумя сокетами обеспечивается тремя каналами UPI. Если Xeon Platinum 8180 поддерживает 768 Гбайт памяти DDR4-2666 с ECC, то Xeon Platinum 8280 может работать уже с 1 Тбайт DDR4-2933, тоже с ECC. Последний CPU также поддерживает память Optane DC Persistent Memory. Intel предлагает некоторые CPU с расширенной поддержкой памяти - как на основе Skylake, так и Cascade Lake. Вместо 12 x 128 Гбайт DDR4, то есть 1.536 Гбайт, процессор Cascade Lake Xeon может работать с 6x 128 Гбайт DDR4 (или даже 6x 256 Гбайт DDR4) + 6x 512 Гбайт Optane DC Persistent Memory, что дает 3,84 Тбайт (4,5 Тбайт) на сокет.

Xeon Platinum 8180 и 8280 стоят порядка €11.000 (от 798.000 ₽ в России).

Supermicro X11DAi-N

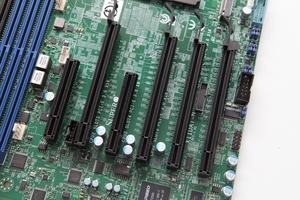

Конечно, для двух процессоров Xeon требуется соответствующая материнская плата с двумя сокетами. Мы выбрали Supermicro X11DAi-N. Она поддерживает процессоры Xeon Scalable второго поколения, на материнскую плату можно установить два CPU с тепловым пакетом 205 Вт каждый.

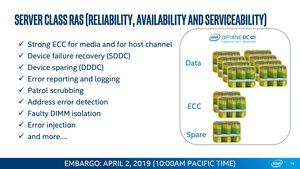

Над каждым сокетом и под ним можно видеть по одному слоту DIMM, в которые устанавливаются планки Optane DC Persistent Memory. Возможно, мы сможем протестировать их в будущем. Платформа для Optane DC Persistent Memory у нас готова, но сами планки пока получить не удалось. В зависимости от используемой памяти, поддерживается коррекция однобитовых ошибок и определение двухбитовых.

Что касается слотов PCI Express, материнская плата предлагает 4x PCI Express 3.0 x16 и 2x PCI-Express 3.0 x8. Каждый процессор обеспечивает 48 линий PCI Express, которые распределяются по слотам. При установке карт расширения важно обращать внимание на то, к какому процессору подключен тот или иной слот.

Supermicro X11DAi-N использует чипсет C261 от Intel. Он обеспечивает десять портов SATA и два Gigabit Ethernet. Контроллера 10 GbE на плате нет. Два порта SATADOM выкрашены оранжевым, их легко узнать. К ним можно подключать накопители без дополнительного питания. Справа можно видеть два порта NVMe Oculink, которые все находят все более широкое применение в серверной сфере.

На плате присутствует слот M.2 для модулей 2260, 2280 и 22110, он подключен к CPU1 четырьмя линиями. Supermicro X11DAi-N - не просто серверная плата, а гибрид между северным решением и моделью для рабочих станций, что отлично нам подходит.

Благодаря поддержке Intelligent Platform Management Interface (IPMI) системой на Supermicro X11DAi-N можно управлять удаленно. Администратор может отслеживать аппаратную конфигурацию и прошивки, а также выполнять необходимые операции через браузер, причем даже в выключенном состоянии сервера и без операционной системы.

Цена Supermicro X11DAi-N составляет от 42.600 ₽ в России или от €550 в Европе.

SK Hynix HMA84GR7CJR4N

Мы использовали оперативную память от SK Hynix. А именно регистровые DDR4 SDRAM DIMM с модельным номером HMA84GR7CJR4N. Планки памяти работают от напряжения 1,2 В, скорость передачи обеспечивается до PC4-2933 (Xeon Platinum 8280) и PC4-2666 (Xeon Platinum 8180). Имеется и поддержка ECC.

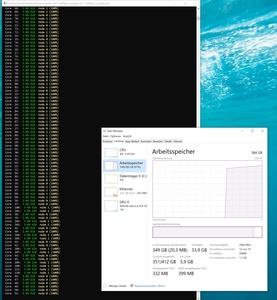

Мы установили по шесть DIMM на сокет, чтобы задействовать 6-канальный режим работы памяти процессоров. Емкость модулей составляет 32 Гбайт каждый, что дает 192 Гбайт на сокет и 384 Гбайт на всю систему.

Цена данных планок составляет €300 за штуку (21.700 ₽), что дает порядка €3.600 (260.400 ₽) за все планки памяти.

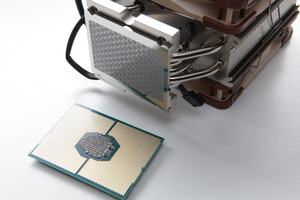

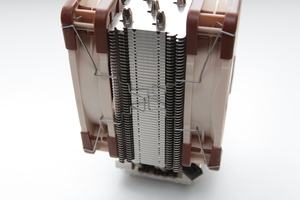

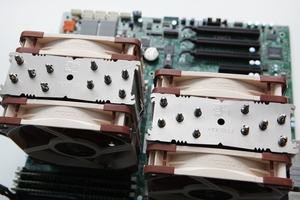

Noctua NH-U12S DX-3647

Конечно, два процессора необходимо охлаждать. Поскольку мы отказались от классического серверного окружения с полупассивным охлаждением в стойке, то пришлось использовать более традиционные кулеры Noctua NH-U12S DX-3647. Конечно, можно было выбрать и более крупный NH-U14S DX-3647, но с ним возникали вопросы насчет совместимости с планками памяти и компонентами материнской платы.

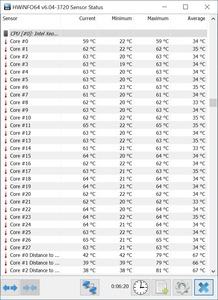

Noctua NH-U12S DX-3647 можно устанавливать в крепления Square и Narrow ILM. Основание кулера полностью накрывает распределитель тепла процессора. За отведение тепла на радиатор отвечают пять тепловых трубок, воздушный поток обеспечивают два вентилятора NF-A12x25 120 mm.

Даже под полной нагрузкой процессоры нагревались до уровня около 60 °C при работе вентиляторов на 2.000 об/мин. Процессоры рассчитаны на температуру до 84 °C, и в серверных окружениях с высокой плотностью компонентов они действительно нагреваются выше 60 °C.

Кулеры Noctua NH-U12S DX-3647 можно приобрести от 7.300 ₽ или €100.

Не самый простой монтаж

Устанавливать процессор в столь крупный сокет нелегко. Впрочем, при должных навыках проблем не возникнет. Если у обычных процессоров Ryzen снизу упаковки расположены чувствительные ножки, то в случае TR4 и сокетов процессоров Intel они перешли на сам сокет. Поэтому лишний раз сокет лучше не задевать. Что должны как раз предотвратить защитные заглушки.

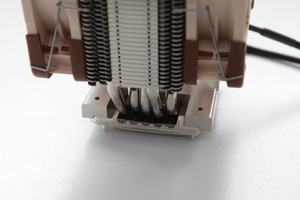

Но для LGA3647 есть еще некоторые моменты, которые стоит учитывать. Рычага с креплением Independent Loading Mechanism (ILM) здесь не используется. Конечно, Intel продолжает говорить об ILM для LGA3647, но механизм отличается от обычных розничных материнских плат. Noctua использовала монтажную рамку, в которую вставляется процессор, после чего он оказывается прикрепленным к кулеру. Затем кулер вместе с процессором устанавливается на сокет.

Вставлять процессор в сокет довольно просто. Контакт 1 промаркирован треугольником, он должен совпадать с соответствующим треугольником сокета. Также на упаковке CPU и сокете имеются вырезы и выступы, поэтому процессор в неправильной ориентации вставить не получится.

Два штырька нужны для выравнивания кулера с распределителем тепла процессора. После установки кулера необходимо затягивать четыре винта в определенной последовательности. Потребуется динамометрическая отвертка T30 с выставляемым крутящим моментом, который должен быть в точности 1,4 Н·м. При снятии кулера следует соблюдать порядок откручивания винтов.

На процессор должно оказываться правильное давление, поскольку только в таком случае все 3.746 контакта будут работать надежно. Если не повезет, то могут возникать различные проблемы. В случае плохого контакта "земли" последствия вряд ли будут, но другие проблемные контакты могут привести к отказу загрузки или некорректной работе каналов памяти. Подобные проблемы могут встречаться у всех больших сокетов LGA, в том числе AMD TR4 и SP3 для процессоров Ryzen Threadripper и EPYC. Такие же проблемы иногда возникали и с нашей сборкой на двух процессорах Xeon Platinum. В таких случаях мы вновь откручивали винты, снимали процессор с кулером, после чего устанавливали их обратно. Затем, как правило, процессор и память распознавались правильно.

Из остального аппаратного обеспечения отметим накопитель Intel Optane SSD 905P с подключением через адаптер PCI Express U.2 и 10-Тбайт Seagate Barracuda на порту SATA.

Начнем с тестов сценариев рабочей станции, хотя данное определение сегодня несколько расплывчато. Затем мы перейдем к серверным тестам, которые пересекаются с тестами для рабочих станций.

Для наших тестов сценариев рабочей станции мы взяли некоторые результаты ранее проведенных тестов Core i9-9980XE и Xeon W-3175X. Но, кроме двухсокетной системы на Xeon Platinum 8180 и Xeon Platinum 8280, мы пока не тестировали другие серверные процессоры.

Cinebench R20

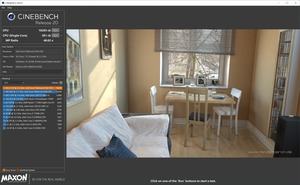

Многопоточный

Тест Cinebench R20 хорошо масштабируется от числа ядер. Что отлично видно по Core i9-990XE и Xeon W-3175X. Для двухсокетной системы на двух Xeon Platinum 8180 и 8280 прирост производительности оказался намного ниже, несмотря на удвоение числа ядер. Из-за более высоких тактовых частот два Xeon Platinum 8280 получают дополнительный прирост производительности порядка 4%.

Cinebench R20

Однопоточный

В случае однопоточной нагрузки все решает высокая частота Boost при активных одном или двух ядрах, и здесь Xeon Platinum 8280 и 8180 похвастаться нечем. У Xeon W-3175X и Core i9-9980XE тактовые частоты оказываются существенно выше, поэтому и в Cinebench мы получаем более высокие результаты.

Компиляция

Mozilla Firefox

К сожалению, мы не можем перенести результаты компиляции из теста Xeon W-3175X, поскольку мы еще раз обновили методику. В будущем компиляция Mozilla Firefox станет нашим стандартным тестом.

Два Xeon Platinum 8280 справились с задачей за десять минут с небольшим, двум Xeon Platinum 8180 потребовалось на минуту больше. В случае AMD Ryzen Threadripper 2990WX на компиляцию уходит около 15 минут.

Corona Benchmark

Трассировка лучей

По сравнению с Cinebench R20, тест Corona масштабируется намного лучше. В нем выполняется трассировка лучей на подготовленной сцене, два Xeon Platinum 8280 оказываются существенно быстрее Xeon W-3175X. Удвоение ядер позволило снизить время рендеринга примерно на треть. Между Xeon Platinum 8180 и 8280 разница минимальная.

V-Ray Benchmark

Рендеринг

Тест V-Ray от Chaos Group масштабируется уже не так хорошо, мы получили прирост всего 25%, несмотря на удвоение ядер. Небольшая разница по тактовым частотам между процессорами Skylake и Cascade Lake уже не отражается на времени рендеринга.

DigiCortex

симуляция синапсов

Симуляция DigiCortex относится к научным приложениям. Данный движок фокусируется на симуляции биохимических реакций, которые присущи нейронам и синапсам. DigiCortex на процессорах Intel использует наборы инструкций AVX2 и AVX512.

Как можно видеть, большее число ядер не всегда приводят к максимальному результату. Здесь лучше подходит десяток быстрых ядер. Впрочем, два Xeon Platinum 8280 все же заметно обходят предшественников Xeon Platinum 8180 из-за обогащенного набора инструкций AVX512.

Y-Cruncher

число Пи 500 млн. знаков

56 ядер и 112 потоков в тесте Y-Cruncher помогли быстрее рассчитать число Пи с точностью 500 млн. знаков после запятой. Время вычисления снизилось на 25% после удвоения числа ядер. Между Skylake и Cascade Lake отличия по производительности невелики.

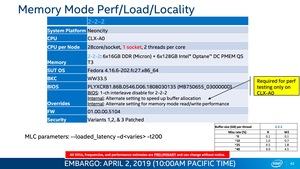

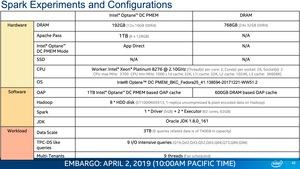

После сценариев для рабочих станций мы переходим к тестам, более ориентированным на серверы. Для выполнения тестов нам пришлось выполнить дополнительную работу, чтобы подготовить тестовое окружение. В частности, мы скачали базу Open Images Dataset V5 от Google, занимающую около 500 Гбайт пространства, на которой мы будем тестировать приложения глубокого обучения.

Для расчета подавления шумов мы скачали сцену Moana Island от Walt Disney Animation Studios и провели тест Open Image Denoise. Здесь объем исходных данных составил 50 Гбайт. Для тестов баз данных мы воспользовались массивом на несколько терабайт. Сегодня с подобными объемами можно работать без особых проблем, но мы еще раз видим, насколько более существенные требования предъявляют серверные сценарии.

Кроме Windows 10 мы использовали и операционную систему Linux, а именно ClearLinux. Также нам пришлось установить различные библиотеки и пакеты, на которых мы подробнее остановимся ниже. Например, библиотека Intel Math Kernel Library является важным компонентом многих тестов.

На данный момент мы не можем оценить серверную производительность во всех аспектах, поскольку продолжаем дорабатывать методику тестов. Результаты тестов очень сильно зависят от оптимизации приложений. Например, в случае тех же баз данных существуют десятки параметров, которые можно оптимизировать. В серверной среде нет простого теста, который позволил бы выдать результат после клика мышью.

Вычисления с целыми числами

Linpack C++

Вычисления с плавающей запятой

Linpack C++

Начнем с чистой вычислительной производительности систем. Мы провели тесты Linpack и сравнили результаты. Небольшой прирост тактовых частот Xeon Platinum 8280 по сравнению с предшественником привел к небольшому приросту производительности. Впрочем, существенного увеличения скорости мы и не ожидали.

Тест памяти Stream

Copy

Тест памяти Stream

Triad

Перейдем к пропускной способности памяти. Обе системы работают с памятью по шести каналам. В случае Xeon Platinum 8180 память DDR4 работает на 2.666 МГц, у Xeon Platinum 8280 частота увеличена до 2.933 МГц, поэтому мы получаем разницу по пропускной способности памяти. Xeon Platinum 8280 дают на 15% более высокую пропускную способность памяти, но им все равно не удается обойти 8-канальный интерфейс нынешних AMD EPYC 7601, которые дают пропускную способность памяти примерно на треть больше.

PyTorch Landmark Points

PyTorch - время анализа

PyTorch - платформа глубокого обучения на открытом исходном коде. Мы выбрали пример обработки и анализа данных, используя базу с фотографиями нескольких лиц. Для каждого лица определяется 68 меток, которые позволяют его характеризовать. Мы оценивали среднее время анализа каждого лица из базы данных. Для анализа используются расчеты INT8, два Xeon Platinum 8280 выигрывают от ускорения DL Boost.

Инференс изображений < 7 мс

Open Images Dataset V5 - данные INT8

Инференс изображений

Open Images Dataset V5 - данные INT8

Следующее приложение тоже относится к глубокому обучению. Мы выбрали базу Open Images Dataset V5 размером 500 Гбайт, содержащую десятки тысяч изображений. На тренировку сети глубокого обучения по данной базе уходит несколько дней. В результате мы получаем сеть Residual Neural Network (ResNet) с 50 слоями, по которым классифицируются изображения. Чем больше слоев, тем более точно классифицируются изображения для последующей обработки запросов.

Однако непосредственно сам тест базируется на инференсе, то есть запросе данных в сеть глубокого обучения. Сначала мы оценили производительность в кадрах в секунду для массива данных INT8. Два Xeon Platinum 8280 примерно на 40%-50% обгоняют своих предшественников. Здесь важную роль тоже играет ускорение DL Boost.

Инференс изображений < 7 мс

Open Images Dataset V5 - FP32 через INT8

Инференс изображений

Open Images Dataset V5 - FP32 через INT8

Во втором тесте мы оценивали производительность при работе с более крупным массивом данных FP32. Точности FP32 здесь не требуется, поэтому приложение конвертирует данные в INT8. У двух Xeon Platinum 8180 нет ускорения INT8, поэтому им приходится обрабатывать данные FP32, скорость получается существенно ниже новых CPU. Речь идет о четырехкратном приросте производительности, что можно назвать весьма существенным шагом вперед.

OSPRay и Open Image Denoise

Трассировка лучей

Для трассировки лучей сцены Moana Island в Walt Disney Animation Studios требуется "классическая" вычислительная производительность. Собственно, в этом и кроется вычислительная проблема рендеринга. Сначала мы измеряли время, которое требуется для трассировки лучей.

Разрешение кадра составляло 2.048 x 858 пикселей, трассировка лучей выполнялась с 64 семплами на пиксель (SPP). Двум Xeon Platinum потребовалось для этого более четырех минут, новые Xeon Platinum 8280 справились чуть быстрее.

Для примера: если удвоить разрешение и увеличить SPP до 256, то на расчет кадра уходит уже несколько часов.

OSPRay и Open Image Denoise

Подавление шумов

Следующим шагом мы применили фильтр Open Image Denoiser, который убирает шумы, появившиеся из-за отсутствующих семплов. Чем меньше семплов рассчитывается на пиксель, тем больше получается шумов. Фильтр Open Image Denoiser убирает шумы и заменяет их информацией, полученной через сеть глубокого обучения.

Ускорение DL Boost на процессорах Xeon Platinum 8280 отлично показывает себя на этапе подавления шумов, поскольку на всю задачу уходит 11,6 с, хотя двум Xeon Platinum 8180 требуется почти в десять раз больше времени.

OSPRay и Open Image Denoise

Трассировка лучей и подавление шумов

Преимущество по расчетам подавления шумов отражается и на общем времени, которое уходит на расчет кадра. В нашем случае мы подразумеваем кадр с низким разрешением и небольшим количеством семплов. Результат можно экстраполировать на настоящее кинопроизводство - расчеты будут занимать намного больше времени, и ускорение подавления шумов даст более ощутимую экономию.

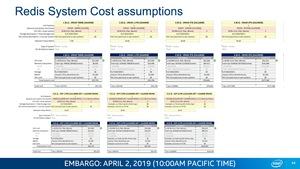

Производительность баз данных Hadoop

метод k-средних

Производительность баз данных Hadoop

Sort

Производительность баз данных Hadoop

Terasort

Наконец, мы провели несколько тестов баз данных. Мы использовали несколько алгоритмов сортировки. В случае метода k-средних (k-means) множество элементов векторного пространства разбивается на известное число кластеров k. Sort означает простую сортировку. В случае Terasort мы сортировали 1 Тбайт данных.

Мы фиксировали время, которое требовалось на выполнение алгоритма сортировки. В случае используемой базы данных она не умещалась в оперативную память, ограниченную 384 Гбайт. Между Skylake и Cascade Lake Xeon разница невелика, она обусловлена только приростом тактовых частот Xeon Platinum 8280.

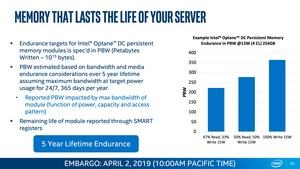

Новые Cascade Lake Xeon могут дать более существенный прирост, если все сортируемые данные находятся в оперативной памяти или Optane DC Persistent Memory. Здесь отличным сценарием станут приложения с несколькими терабайтами данных, которые можно хранить в массиве из памяти и Optane DC Persistent Memory с минимальными затратами на память.

После тестов производительности интересно взглянуть и на другие измерения. В частности, нас интересовало энергопотребление подобной системы.

энергопотребление

только CPU

Мы измерили энергопотребление двух процессоров, используя токоизмерительные клещи на двух 8-контактных штекерах. То же самое было выполнено для систем с Core i9-9980XE и Xeon W-3175X. 250 Вт TDP (PL1), заявленные Intel, не относятся к максимальной нагрузке. Мы получили 300 Вт для каждого процессора под полной нагрузкой приложения AVX512 - оба потребляли более 600 Вт.

Два кулера Noctua NH-U12S DX-3647 хорошо справлялись с охлаждением процессоров, мы получили температуры около 60 °C под полной нагрузкой. Каждый из двух вентиляторов работал на 2.000 об/мин.

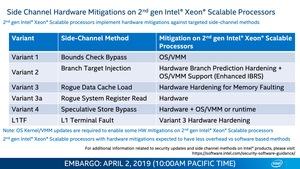

Уязвимости

Учитывая нынешнюю ситуацию, стоит сказать пару слов об уязвимостях. В Cascade Lake внесены дальнейшие улучшения в данном отношении, опирающиеся на аппаратные и программные исправления.

- Вариант 1. Защита осуществляется средствами ОС и VMM (Virtual Machine Monitor)

- Вариант 2. Hardware Branch Prediction Hardening (предотвращение будущих атак по данному методу) + средствами ОС и VMM

- Вариант 3. Hardware Hardening

- Вариант 3a. Hardware

- Вариант 4. Hardware + ОС/VMM

- L1TF. Уже закрыта благодаря Hardware Hardening в варианте 3

За последние дни горячо обсуждается тема новых уязвимостей, связанных с Microarchitectural Data Sampling (MDS).

С помощью MDS Tool можно проверить наличие аппаратных/программных уязвимостей безопасности. В том числе аппаратное исправление уязвимостей Meltdown и Microarchitectural Data Sampling.

Появление других уязвимостей, похожих на Spectre и Meltdown, было лишь вопросом времени. Возникает вопрос: когда Intel сможет избавиться от подобных проблем? Похоже, что здесь виноваты фундаментальные принципы разработки архитектур. Будем надеяться, что инженеры смогут лучше защищать процессоры в будущем. Особенно это касается серверного сегмента, где данная тема для Intel стоит весьма остро.

Intel пытается понизить значимость выявленных уязвимостей. В случае Microarchitectural Data Sampling рекомендации касаются отключения Hyper-Threading в сферах, где требуется обеспечить необходимую защиту - в результате клиентам Intel приходится идти на определенные жертвы. Что вряд ли обрадует крупных клиентов, не говоря уже об утрате доверия.

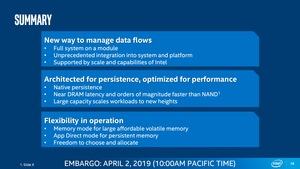

Процессоры Xeon Scalable второго поколения с технической точки зрения не дают существенных инноваций. Они производятся по оптимизированному 14-нм техпроцессу, содержат до 28 ядер и работают на чуть более высоких тактовых частотах (конечно, новая линейка процессоров Xeon Platinum 9000 занимает здесь особое положение). Что видно по результатам тестов, не опирающихся на новые команды, обеспечивающие аппаратное ускорение. Классические вычисления FP32 выполняются на одинаковом уровне как на процессорах с AVX512, так и без этого набора команд. В результате ждать существенных улучшений по энергопотреблению или эффективности с процессорами Cascade Lake не приходится.

Но процессоры Xeon Scalable второго поколения на архитектуре Cascade Lake получают заметный прирост производительности в других областях, что подтверждается тестами. Intel увеличила частоту поддерживаемой памяти, и пусть увеличение с DDR4-2666 до DDR-2933 не кажется значительным, дополнительные гигабайты в секунду будут как нельзя кстати в приложениях, зависящих от пропускной способности памяти.

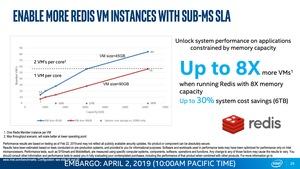

К сожалению, один аспект поддержки памяти нам не удалось протестировать, а именно новые планки Optane DC Persistent Memory. С помощью данной памяти можно существенно увеличить емкость общей памяти сервера, а также снизить затраты в расчете на гигабайт. Но все же в каждом сценарии следует оценивать, насколько значимую пользу может принести Optane DC Persistent Memory. Поддержка новой памяти весьма актуальна при работе множества VM на сервере. Здесь процессоры Xeon Scalable второго поколения выходят вперед благодаря поддержке большего объема памяти.

Интересная ситуация складывается и с поддержкой ускорения DL Boost. Здесь преимущества Cascade Lake Xeon проступают наиболее четко. Прирост производительности двух Xeon Platinum 8280 по сравнению с предшественниками составляет от 1,5 до 10 раз. Причем Intel продолжает вносить улучшения в данной сфере, и правильная оптимизация может творить чудеса.

С процессорами Xeon поколения Cascade Lake Intel удалось совместить две сущности: общие вычисления и ускорение глубокого обучения. Вычислительная производительность в классических расчетах находится в стагнации, но процессоры Xeon Scalable второго поколения дают значимый прирост в приложениях, где поддерживается ускорение DL Boost. Для профессиональной среды ускорение подобных вычислений - значимое преимущество, особенно если получится выполнить задачу за половину времени, четверть или даже быстрее.

Время - деньги. Этот лозунг хорошо знаком клиентам облачных вычислительных платформ и их провайдерам. А также и тем, кто эксплуатирует собственные дата-центры.

С новым поколением процессоров Xeon под кодовым названием Cooper Lake Intel пойдет еще на шаг дальше. Кроме DL Boost, процессоры в "родном" режиме будут поддерживать новый формат данных BFloat16 и вновь получат существенный прирост в приложениях глубокого обучения. Также Cooper Lake Xeon будут устанавливаться в новый сокет и обеспечат больше ядер. Что позволит Intel продвинуться и в сфере классических вычислений.